Best AI Influencer Generator Tools of 2026 – Make Virtual Influencers!

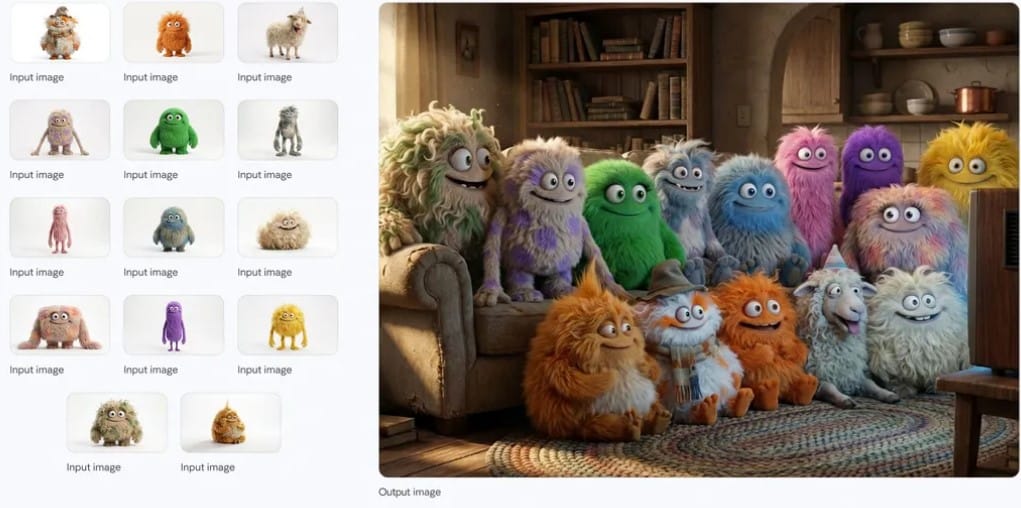

Last Updated on noviembre 30, 2025 8:15 pm by Laszlo Szabo / NowadAIs | Published on noviembre 30, 2025 by Laszlo Szabo / NowadAIs Best AI Influencer Generator Tools of 2026 – Make Virtual Influencers! – Key Notes Section Consistency is King: The primary differentiator between a toy and a professional ai influencer generator in 2026 is the ability to maintain facial identity across different angles and lighting conditions. Workflow Integration: The best tools now integrate generation with scheduling and posting, moving from simple image creation to full-stack influencer management. Economic Shift: These tools are rapidly lowering the barrier to entry for brand marketing, allowing small businesses to compete with major corporations by eliminating production costs. The Video Frontier: While static images are perfected, video generation (movement and speech) remains the final technological hurdle, with tools like Synthesia leading the charge. The Great Replacement: Why AI-Generated Pixels Are Winning The era of the “diva” is effectively over. In the high-stakes world of social media marketing, where a single scandal can evaporate millions of dollars in sponsorship equity overnight, brands have grown weary of human fallibility. Enter the age of the ai influencer generator, a class of software that has matured from the novelty acts of 2023 into the industrial-grade powerhouses of 2026. We are no longer looking at glitchy, six-fingered nightmares or vacant stares that betray a lack of soul. Today, we are looking at Aitana Lopez’s grandchildren—digital entities so hyper-realistic, so consistently rendered, and so tirelessly available that they have rendered the concept of “booking talent” obsolete for a growing sector of the fashion and lifestyle economy. The shift was not sudden, but it was absolute. It began with the democratization of diffusion models and solidified when consistency engines—tools that lock facial features across thousands of iterations—became accessible to the average laptop user. An AI influencer generator in 2026 is not just a template collection or an image creator; it is a full-stack talent management agency in a browser tab. These platforms handle everything from the initial “casting” (generating the look) to the daily “photoshoots” (prompting scenarios) and, in some cases, the actual posting and audience interaction. For the cynicism-hardened journalist, it is a fascinating, if slightly dystopian, evolution of the creator economy. We have moved from selling a curated version of our lives to selling a curated version of a life that never existed. The economic incentives are simply too powerful to ignore. Human, real influencers require travel logistics, makeup artists, lighting crews, and mental health breaks. They age, they gain weight, they have political opinions that might alienate a demographic. An AI influencer generator produces a model who works 24/7, speaks every language, fits every sample size, and never complains about the catering. This article serves as a field guide to this new reality, dissecting the software that is currently printing money for savvy digital architects and asking the uncomfortable question: If a computer can be more “authentic” than a human, what were we valuing in the first place? AI Influencer Generator Field Reports: Life Inside the Simulation To understand the practical power of an ai influencer generator, one must look beyond the marketing copy and dive into the trenches of the content creator economy. The sentiment on platforms like Reddit, specifically within communities like r/StableDiffusion and r/socialmedia, has shifted from technical curiosity to aggressive capitalization. Users are no longer asking how to make a consistent face; they are discussing how to scale their third or fourth account to six figures. The days of fighting with “controlnets” for hours just to get the eyes right are largely behind us, replaced by streamlined workflows that prioritize volume and engagement. One particularly illuminating thread from late 2025, started by a user we’ll call ‘PixelPimp2026’, detailed the transition from managing human micro-influencers to running a stable of five distinct AI personas. “The overhead is zero,” they wrote. “I used to spend three weeks negotiating a $500 post with a micro-influencer who would then ghost me. Now, I fire up my ai influencer generator of choice, run a batch of 50 images while I make coffee, and I have content for a month.” This sentiment is echoed across the board. Field reports suggest that the “turing test” for Instagram attractiveness was passed years ago. The audience does not know, or increasingly, does not care. However, it is not all passive income and digital yachts. A recurring complaint in user reviews for every major ai influencer generator is the “consistency drift” that occurs over long campaigns. While static images are nearly perfect, AI video generation still struggles to maintain the illusion during complex movements. Furthermore, the market is becoming flooded. “You can’t just post a pretty face anymore,” another user noted on a review aggregator. “You need a narrative. You need drama. The tools make the face, but you still have to write the soul.” This section highlights the reality: the tools are powerful, but they are merely instruments. The successful “puppeteers” of 2026 are those who treat their custom ai influencer generator not as a slot machine, but as a character creation engine for a never-ending soap opera. #1 Tool to Create Online AI Influencers: Glambase Tool to Create Online AI Influencers – front page of Glambase Source Summarizing the Platform: Glambase positions itself not merely as an image generator, but as a complete virtual human management system. It was one of the first platforms to gamify the experience, making the complex backend of stable diffusion accessible through an interface that feels suspiciously like The Sims. You do not write complex code to customize here; you adjust sliders for “sassiness” or “corporate appeal.” Glambase is using advanced AI to create stunning content for the marketer who wants results immediately. It automates the entire lifecycle, from character creation to social media platforms posting, acting as a “set it and forget it” solution for create a digital twin fame. Advantages and Disadvantages: The primary advantage of Glambase is its extreme ease of use. It removes the technical barrier

Demonios de la velocidad y sueños de silicio: Z-Image-Turbo, el nuevo generador de imágenes por IA de Alibaba

Last Updated on noviembre 28, 2025 2:13 pm by Laszlo Szabo / NowadAIs | Published on noviembre 28, 2025 by Laszlo Szabo / NowadAIs Demonios de la velocidad y sueños de silicio: Z-Image-Turbo, el nuevo generador de imágenes de Alibaba – Notas clave Velocidad sin precedentes: el modelo utiliza un proceso optimizado de 8 pasos (NFEs) para lograr una generación de imágenes por debajo del segundo en hardware empresarial, mientras que se mantiene excepcionalmente rápido en GPUs de consumo. Eficiencia del hardware: Diseñado para funcionar dentro de una envolvente VRAM de 16 GB, hace que la generación fotorrealista de alta gama sea accesible en máquinas locales sin requerir costosas suscripciones a la nube. Arquitectura unificada: Emplea un exclusivo transformador de difusión de flujo único escalable (S3-DiT) que procesa los datos de texto y visuales de forma conjunta, mejorando tanto la eficiencia como la comprensión semántica. Dominio bilingüe: El sistema cuenta con un sólido soporte nativo para la representación de texto en inglés y chino, lo que permite una tipografía precisa y avisos complejos y anidados en ambos idiomas. La necesidad de velocidad en los medios generativos Noviembre de 2025 ha supuesto un claro cambio en el horizonte de la IA, desplazando la conversación desde la capacidad estética bruta hacia algo mucho más pragmático: la velocidad. Durante años, la disyuntiva era brutal y aparentemente inmutable. Si querías alta fidelidad, pagabas por ella en segundos, a veces minutos, de cambio de GPU. Si querías velocidad, aceptabas el valle misterioso. Esta semana, un comunicado del equipo Tongyi-MAI de Alibaba sugiere que este compromiso ya no es una ley de la física, sino simplemente un obstáculo de ingeniería que se ha superado. La llegada de Z-Image-Turbo marca un momento concreto en el que la eficiencia alcanza por fin a la fidelidad. La industria se ha hinchado con modelos que requieren granjas de servidores para funcionar eficazmente. Nos hemos acostumbrado al “estilo de vida de la barra de carga”, mirando fijamente los indicadores de progreso mientras un modelo calcula la difusión del ruido en el arte. Esta latencia ha sido el asesino silencioso de la creatividad iterativa. Cuando un creador debe esperar treinta segundos para ver si una indicación ha funcionado, el estado de flujo se rompe. La promesa de Z-Image-Turbo no está sólo en los píxeles que produce, sino en el tiempo que ahorra. Representa un avance hacia la creación “a velocidad de pensamiento”, en la que la distancia entre la concepción y la visualización se mide en milisegundos y no en pausas para el café. Este cambio no es sólo cuestión de paciencia, sino también de accesibilidad. Al estar optimizado para el hardware de consumo, en concreto el “punto dulce” de 16 GB de VRAM, este modelo democratiza la generación de gama alta. Saca la capacidad de la nube y la devuelve firmemente a la máquina local. Se trata de un giro con respecto a los modelos masivos y monolíticos de 2024, que exigían recursos informáticos exorbitantes, y marca una tendencia hacia arquitecturas más esbeltas e inteligentes que hacen más con menos. Desembalaje de la arquitectura de Z-Image-Turbo En el corazón de este rendimiento se encuentra una elección arquitectónica específica conocida como Scalable Single-Stream Diffusion Transformer, o S3-DiT. A diferencia de los modelos de difusión tradicionales, que suelen separar el procesamiento de los datos textuales y visuales en distintos canales que deben sincronizarse laboriosamente, Z-Image-Turbo unifica estos elementos. Concatena los tokens de texto, los tokens semánticos visuales y los tokens VAE de imagen en una única secuencia cohesionada. De este modo, el modelo puede procesar la relación entre el mensaje y la imagen resultante con una sobrecarga computacional significativamente menor. Las cifras de eficiencia son contundentes. El modelo funciona con sólo 8 números de evaluaciones de funciones (NFE). Para ponerlo en perspectiva, muchos competidores de alta fidelidad necesitan entre 25 y 50 pasos para resolver una imagen coherente. Al reducir el proceso a solo ocho pasos, Z-Image-Turbo logra tiempos de inferencia inferiores a un segundo en hardware empresarial como la H800 y, lo que es más importante, mantiene un rendimiento rápido en tarjetas de consumo como la RTX 3060 o 4090. No se trata de un enfoque de fuerza bruta, sino de una optimización algorítmica que elimina los cálculos redundantes que históricamente han ralentizado los modelos de difusión. Además, el modelo utiliza un número de parámetros de 6.000 millones. En el contexto actual, 6B se considera un tamaño ligero, casi portátil, y sin embargo supera con creces su categoría en cuanto a calidad de resultados. Los desarrolladores de Tongyi-MAI han utilizado técnicas avanzadas de destilación, es decir, han enseñado a un modelo “alumno” más pequeño a imitar el comportamiento de un modelo “maestro” masivo, para conservar el matiz estético de un sistema más grande sin el consiguiente impuesto sobre el hardware. Este equilibrio de 6 parámetros B y 8 ENF es lo que confiere a Z-Image-Turbo su carácter distintivo en el mercado. La ventaja bilingüe y el renderizado de texto Uno de los fracasos persistentes de la IA generativa ha sido su analfabetismo. Durante mucho tiempo, cuando se le pedía a una IA que renderizara un texto, el resultado eran jeroglíficos alienígenas o sinsentidos confusos. Z-Image-Turbo aborda este problema con una sólida capacidad bilingüe que parece una auténtica utilidad más que una novedad. Admite la representación de texto en inglés y chino con un alto grado de precisión. Esta función es especialmente importante para aplicaciones comerciales, como la creación de carteles, portadas de libros o contenidos para redes sociales en los que el texto forma parte integral de la composición. El codificador de texto subyacente, al parecer basado en la serie de modelos lingüísticos Qwen 3, proporciona al sistema una comprensión más profunda de la estructura del texto. Esto permite a Z-Image-Turbo manejar instrucciones complejas en las que el texto debe colocarse espacialmente dentro de una escena, por ejemplo, “un cartel de neón que diga ‘OPEN’ en un callejón lluvioso” El modelo comprende no sólo los caracteres, sino el contexto en el

¿Qué es el modelo de generador de imágenes FLUX.2 AI?

Last Updated on noviembre 26, 2025 9:37 pm by Laszlo Szabo / NowadAIs | Published on noviembre 26, 2025 by Laszlo Szabo / NowadAIs ¿Qué es el modelo generador de imágenes FLUX.2 AI? – Sección de notas clave Cambio de arquitectura: FLUX.2 se aleja de los modelos de difusión tradicionales y adopta una arquitectura de correspondencia de flujo latente combinada con un modelo de lenguaje visual (VLM) de 24.000 millones de parámetros. Este cambio proporciona velocidades de generación significativamente más rápidas (inferiores a 10 segundos) y una mejor comprensión semántica, lo que mejora la comprensión del modelo de la física del mundo real y las complejas restricciones de composición. Este rediseño fundamental es esencial para lograr la previsibilidad de la producción. Control y fidelidad de la producción: El sistema ofrece una calidad visual de vanguardia, compatible con salidas y ediciones de hasta 4 megapíxeles, al tiempo que destaca en la retención de detalles y el fotorrealismo. Entre las funciones profesionales clave se incluyen la renderización de texto fiable y de alta fidelidad para tipografía y logotipos, junto con controles de precisión como la orientación directa de la pose y las indicaciones JSON estructuradas para flujos de trabajo programáticos. Coherencia multirreferencia: Una característica fundamental es la capacidad de utilizar hasta diez imágenes de referencia simultáneamente, que se integra de forma nativa en la arquitectura para lograr una coherencia sin precedentes en la identidad de los personajes, la apariencia de los productos y el estilo visual en múltiples activos generados. Esta capacidad elimina eficazmente un importante cuello de botella en la creación de campañas comerciales unificadas a gran escala. Accesibilidad y variantes: Black Forest Labs ofrece tres variantes principales: FLUX.2 [pro] para un servicio de API gestionado con la máxima velocidad y calidad, FLUX.2 [flex] para desarrolladores que necesitan un control granular sobre parámetros como los pasos de inferencia, y el FLUX.2 [dev] de peso abierto y 32.000 millones de parámetros [dev] de peso abierto. El modelo FLUX.2 [dev] ha sido optimizado con cuantificación FP8 en colaboración con NVIDIA y ComfyUI, lo que lo hace accesible en GPU de consumo a pesar de su inmenso tamaño. El enfoque por niveles responde a las diversas necesidades de los usuarios, desde las empresas hasta la investigación. El arquitecto invisible: Por qué FLUX.2 está remodelando el tejido mismo de la creación visual La era actual de la inteligencia artificial generativa se caracteriza por avances exponenciales en la fidelidad visual, pero los cambios más importantes no se producen en la imagen final, sino en la ingeniería subyacente que la hace posible. Black Forest Labs ha lanzado recientemente FLUX.2, un sistema que eleva de forma silenciosa pero profunda el nivel de la inteligencia visual de producción, sacando la tecnología del ámbito del arte experimental y situándola firmemente en el exigente mundo centrado en el flujo de trabajo de los estudios creativos profesionales. No se trata de una mera actualización de un modelo anterior, sino que el equipo de desarrollo ha rediseñado por completo la arquitectura, sentando las bases para una comprensión mucho más profunda de la física del mundo real, la lógica espacial y las limitaciones comerciales. La ambición aquí no es simplemente crear imágenes que parezcan plausibles, sino crear imágenes que sean predecibles, controlables y fiables a través de campañas comerciales enteras, cambiando fundamentalmente la economía de la creación de activos visuales. En el corazón del sistema FLUX.2 hay una nueva y sofisticada arquitectura que se aparta significativamente del paradigma del modelo de difusión tradicional que ha dominado este campo durante varios años. En lugar de basarse en un proceso gradual de eliminación de ruido paso a paso, el modelo emplea una arquitectura de correspondencia de flujo latente que aprende un camino más directo y eficiente entre un estado latente ruidoso y un estado latente de imagen limpia. Este enfoque racionalizado es intrínsecamente más rápido y más eficiente desde el punto de vista computacional, lo que se traduce directamente en una latencia y un coste menores para los usuarios de API que trabajan con grandes volúmenes de activos. La arquitectura combina un Modelo de Visión-Lenguaje (VLM) de 24.000 millones de parámetros, derivado de la serie Mistral-3, con un transformador de flujo rectificado, lo que proporciona al sistema una base semántica y una comprensión mucho mayor de la lógica espacial y de composición. El VLM proporciona el conocimiento del mundo real -comprende cómo deben comportarse los objetos y cómo reflejan la luz los materiales-, mientras que el transformador garantiza que los elementos complejos se coloquen de forma correcta y coherente dentro del encuadre, lo que resuelve un problema que existía desde hace tiempo en los modelos generativos, en los que las indicaciones complejas solían dar lugar a un efecto de “pizarra de ambiente” desordenado. La filosofía de diseño de FLUX.2 se centra en resolver la tensión entre velocidad y calidad, una disyuntiva que históricamente ha afectado a los sistemas generativos. Gracias a la adopción de un sistema central de correspondencia de flujos, Black Forest Labs ha conseguido una calidad de imagen de vanguardia que rivaliza con los mejores modelos de código cerrado y, al mismo tiempo, una velocidad de generación inferior a los 10 segundos. Este perfil de rendimiento lo hace especialmente adecuado para aplicaciones comerciales de alto rendimiento, como la visualización de productos en el comercio electrónico y las campañas de marketing a gran escala, en las que se necesitan cientos o incluso miles de imágenes coherentes y de alta fidelidad en plazos ajustados. Ahora, el sistema puede producir de forma fiable resultados con una impresionante resolución de 4 megapíxeles, un requisito clave para los activos de calidad profesional que deben resistir un escrutinio minucioso y una presentación detallada. Además, el modelo se ha entrenado para mantener específicamente la coherencia de los materiales, la estabilidad de la iluminación y la corrección de la física, lo que ayuda a eliminar el delator “aspecto de IA” que puede socavar la credibilidad de un activo visual en un contexto profesional. La nueva arquitectura: Un enfoque unificado para la

Vuelve el peso pesado: Claude Opus 4.5 de Anthropic reclama el trono

Last Updated on noviembre 25, 2025 1:59 pm by Laszlo Szabo / NowadAIs | Published on noviembre 25, 2025 by Laszlo Szabo / NowadAIs Vuelven los pesos pesados: Claude Opus 4.5 de Anthropic reclama el trono – Notas clave Liderazgo de referencia en codificación: Claude Opus 4.5 ha alcanzado una precisión del 80,9% en SWE-bench Verified, convirtiéndose en el primer modelo en superar el umbral del 80% en esta prueba de referencia de ingeniería de software estándar del sector. Este rendimiento superó tanto al Gemini 3 Pro de Google, con un 76,2%, como al GPT-5.1-Codex-Max especializado de OpenAI, con un 77,9%, estableciendo el modelo como el estado actual de la técnica para la generación automatizada de código y las tareas de depuración. Estrategia de precios agresiva: Anthropic redujo el precio de la API en aproximadamente un 67% en comparación con los modelos Opus anteriores, fijando las tarifas en 5 dólares por millón de tokens de entrada y 25 dólares por millón de tokens de salida. Esta drástica reducción de precios democratizó el acceso a las capacidades de IA de vanguardia, al tiempo que mantuvo la eficiencia de los tokens, lo que se traduce en un ahorro de costes: el modelo utiliza entre un 48% y un 76% menos de tokens que sus predecesores, dependiendo de la configuración del nivel de esfuerzo. Capacidades de agente mejoradas: El modelo demostró un rendimiento superior en tareas autónomas de largo horizonte, alcanzando el máximo rendimiento en sólo cuatro iteraciones, mientras que los modelos de la competencia necesitaron diez intentos. Claude Opus 4.5 introdujo mejoras en la gestión de la memoria, en las capacidades de uso de herramientas, incluido el descubrimiento dinámico de herramientas, y en la capacidad de coordinar múltiples subagentes en sistemas multiagente complejos que requieren un razonamiento sostenido a lo largo de sesiones prolongadas. Progresos en seguridad y alineación: Anthropic posicionó Claude Opus 4.5 como su modelo de alineación más robusto, con una resistencia sustancialmente mejorada a los ataques de inyección puntual en comparación con versiones anteriores y competidores. Las pruebas revelaron que el modelo mantiene tasas de rechazo más bajas en solicitudes benignas y discierne mejor el contexto, aunque los atacantes decididos siguen logrando tasas de éxito en torno al 5% en intentos únicos y aproximadamente el 33% en diez vectores de ataque variados. El modelo de IA que venció a todos los ingenieros humanos Cuando Anthropic lanzó Claude Opus 4.5 el 24 de noviembre de 2025, la comunidad de inteligencia artificial fue testigo de algo extraordinario. No se trataba de una actualización más en la interminable carrera entre laboratorios de inteligencia artificial. Se trataba de un modelo que obtuvo una puntuación más alta en la evaluación interna de ingeniería de Anthropic que cualquier candidato humano a un puesto de trabajo en la historia de la empresa. Piénsalo por un momento. Todas las personas que alguna vez solicitaron trabajo en una de las principales empresas de IA del mundo, evaluadas en una prueba técnica de dos horas, fueron superadas por el software. La llegada de Claude Opus 4.5 supone algo más que un logro técnico: representa un cambio fundamental en lo que las máquinas pueden hacer cuando se les asignan tareas complejas y ambiguas. El modelo no se limita a escribir código o seguir instrucciones. Según los primeros probadores de Anthropic, “lo entiende” Esa sutil comprensión del contexto, las compensaciones y las limitaciones del mundo real hace que esta versión sea diferente de todo lo anterior. La prisa por recuperar la corona El momento elegido para presentar Claude Opus 4.5 no fue casual. Pocos días antes de su debut, Google había lanzado Gemini 3 Pro y OpenAI había presentado GPT-5.1-Codex-Max. Los tres principales laboratorios de IA se enzarzaron en una batalla por la supremacía, lanzando cada uno modelos cada vez más capaces en la misma semana. Anthropic presentó Claude Opus 4.5 como su respuesta a la competencia, afirmando que era “el mejor modelo del mundo para codificación, agentes y uso informático” La prueba llegó en forma de puntuaciones de referencia que contaban una historia convincente. En SWE-bench Verified, el estándar del sector para medir la capacidad de ingeniería de software en el mundo real, Claude Opus 4.5 alcanzó un 80,9% de precisión. Superó al GPT-5.1-Codex-Max de OpenAI con un 77,9%, al Gemini 3 Pro de Google con un 76,2% e incluso al propio Sonnet 4.5 de Anthropic con un 77,2%. Por primera vez, un modelo había superado el umbral del 80% en esta prueba notoriamente difícil. Lo que resulta especialmente impresionante es cómo Claude Opus 4.5 alcanzó estas cotas. El modelo no se limitó a forzar soluciones con enormes recursos informáticos. En su lugar, demostró lo que los desarrolladores denominan “eficiencia simbólica”: hacer más con menos. En un nivel de esfuerzo medio, Claude Opus 4.5 igualó el rendimiento de Sonnet 4.5 utilizando un 76% menos de tokens de salida. Incluso en el nivel de esfuerzo más alto, en el que superó al Sonnet 4.5 en 4,3 puntos porcentuales, consumió un 48% menos de fichas. Esta eficiencia no era sólo una curiosidad técnica. Para los clientes empresariales que realizan millones de llamadas a API, se tradujo directamente en ahorro de costes y tiempos de respuesta más rápidos. Ahora las empresas pueden acceder a inteligencia de vanguardia sin los gastos de infraestructura que antes limitaban la IA avanzada a las organizaciones mejor financiadas. ¿Hasta qué punto puede ser inteligente el software? Más allá de las pruebas comparativas de codificación, Claude Opus 4.5 demostró mejoras en múltiples ámbitos que, en conjunto, dibujan un panorama de un sistema de IA de propósito general más capaz. En Terminal-bench, que pone a prueba las habilidades de automatización de la línea de comandos, el modelo obtuvo una puntuación del 59,3%, muy por delante del 54,2% de Gemini 3 Pro y sustancialmente mejor que el 47,6% de GPT-5.1. Estas cifras significan que Claude Opus 4.5 puede ejecutar flujos de trabajo complejos de varios pasos en entornos de terminal con mayor fiabilidad que los modelos de la competencia. Quizá

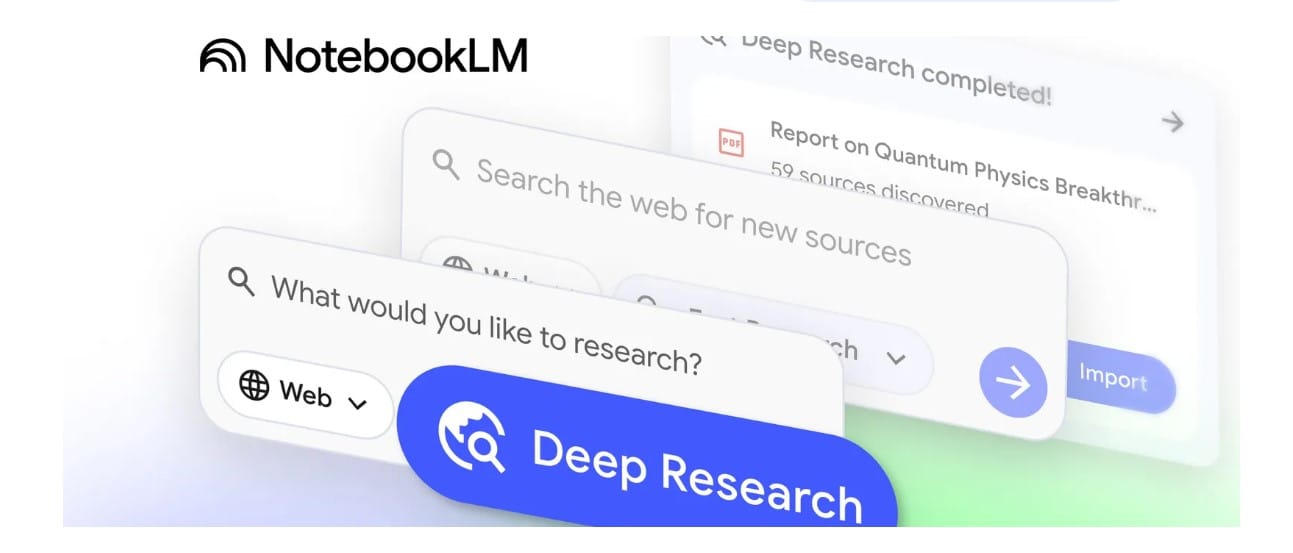

Google NotebookLM: el asistente de investigación de IA que convierte tus documentos en podcasts

Last Updated on noviembre 24, 2025 8:22 pm by Laszlo Szabo / NowadAIs | Published on noviembre 24, 2025 by Laszlo Szabo / NowadAIs Google NotebookLM: el asistente de investigación de inteligencia artificial que convierte tus documentos en podcasts – Notas clave Google NotebookLM es un asistente de investigación de IA basado en fuentes que sólo analiza los materiales que subes explícitamente, por lo que es fundamentalmente diferente de los chatbots de uso general que se basan en vastas bases de datos de entrenamiento. Este enfoque reduce el riesgo de alucinaciones y garantiza que las respuestas se puedan rastrear directamente hasta las fuentes mediante citas en línea. La función Audio Overview transforma los documentos en debates de tipo podcast entre dos anfitriones de IA con un sonido extraordinariamente natural, creando una forma atractiva de consumir información compleja. Estos podcasts personalizables pueden descargarse y escucharse en cualquier lugar, lo que los hace especialmente valiosos para estudiantes auditivos, personas que viajan diariamente al trabajo y cualquiera que prefiera el contenido hablado a la lectura de materiales densos. Los usuarios reales del mundo académico, empresarial, periodístico y de la investigación personal elogian constantemente la capacidad de Google NotebookLM para identificar rápidamente temas en múltiples fuentes, extraer información clave con citas y generar resultados útiles como guías de estudio, informes y preguntas frecuentes. La herramienta destaca a la hora de conectar ideas entre documentos y de ofrecer perspectivas externas sobre tu trabajo, aunque requiere una selección de fuentes y de indicaciones cuidadosa para obtener resultados óptimos. Cuando tu asistente digital lee realmente lo que le das Imagina tener un compañero de investigación que nunca se cansa de responder a tus preguntas, que nunca te juzga por preguntar lo mismo dos veces y que puede convertir tu montaña de documentos en una entretenida conversación de podcast mientras vas al trabajo por la mañana. Eso es exactamente lo que Google NotebookLM promete ofrecer. Este asistente de investigación impulsado por inteligencia artificial se ha convertido en una de las herramientas más comentadas en el ámbito de la productividad, y no sólo porque pueda resumir documentos o responder preguntas. La gente está perdiendo la cabeza por el hecho de que puede transformar sus aburridos trabajos de investigación en conversaciones al estilo podcast entre dos anfitriones de IA que suenan extraordinariamente humanos. Pero, ¿es Google NotebookLM realmente tan potente como sugiere el bombo publicitario, o no es más que otra demostración tecnológica que parece impresionante pero que se queda corta cuando realmente necesitas hacer tu trabajo? Veamos en qué se diferencia esta herramienta, en qué destaca y en qué puede dejarte con ganas de más. El nacimiento de un socio de investigación de IA Google NotebookLM se lanzó en 2023 como un proyecto experimental de Google Labs, impulsado por el modelo de lenguaje Gemini de la compañía. A diferencia de los chatbots de IA de uso general que se nutren de vastas bases de datos de información, Google NotebookLM adopta un enfoque fundamentalmente diferente. Es lo que los desarrolladores llaman una herramienta de IA “basada en fuentes”, lo que significa que sólo funciona con los materiales que tú subes específicamente. Piensa en ello como si contrataras a un asistente de investigación que lee exactamente lo que le das y nada más. Este enfoque específico hace que Google NotebookLM sea especialmente valioso para estudiantes, investigadores, periodistas y profesionales que necesitan extraer información de documentos concretos en lugar de obtener respuestas genéricas de todo Internet. La herramienta admite una impresionante variedad de materiales fuente, como PDF, Google Docs, Google Slides, sitios web, vídeos de YouTube, archivos de audio, documentos de Microsoft Word e incluso hojas de cálculo de Google. Cada fuente puede contener hasta 500.000 palabras, lo que te da un margen considerable para crear cuadernos de investigación exhaustivos. Cómo funciona Google NotebookLM Cuando creas un nuevo cuaderno en Google NotebookLM, básicamente estás creando un experto de IA dedicado y entrenado exclusivamente en tus materiales. El proceso es muy sencillo. Sube tus fuentes, que pueden ser documentos de investigación para una tesis, documentación de un producto para un nuevo proyecto o artículos de noticias sobre un tema que estés investigando. Una vez subidos, Google NotebookLM procesa estos materiales utilizando las funciones avanzadas de comprensión lingüística de Gemini. La interfaz presenta un panel de chat en el que puedes hacer preguntas, un panel de fuentes en el que se muestran todos los materiales que has subido y un panel de estudio en el que puedes generar diversos resultados, como resúmenes, guías de estudio y los ya famosos resúmenes de audio. Lo que diferencia a Google NotebookLM de la simple búsqueda en tus documentos es su capacidad para establecer conexiones entre varias fuentes. Pídele que compare argumentos de distintos documentos, que identifique temas comunes o que explique cómo se relacionan los conceptos de un documento con los de otro, y sintetizará la información de una forma que te llevaría horas realizar manualmente. El sistema utiliza una ventana contextual de un millón de tokens, lo que significa que puede procesar y referenciar enormes cantidades de texto simultáneamente. Cuando haces una pregunta, Google NotebookLM no se limita a buscar palabras clave. Entiende el contexto, establece conexiones entre las ideas relacionadas y proporciona respuestas con citas en línea que muestran exactamente qué fuente y qué pasaje específico informaron su respuesta. Esta función de citas es especialmente valiosa para trabajos académicos o para cualquier situación en la que necesites verificar información o rastrear afirmaciones hasta sus fuentes originales. Puedes hacer clic en cualquier cita para ir directamente a esa sección del documento fuente, lo que facilita la comprobación de los hechos. La función de resumen de audio que rompió Internet Aunque Google NotebookLM ofrece muchas funciones útiles, ninguna ha captado tanto la atención del público como su función Audio Overview. Esta función genera debates tipo podcast entre dos presentadores de IA que analizan y discuten el material que has subido. Las conversaciones suenan extraordinariamente naturales, con bromas casuales, pausas reflexivas e incluso algún “um” o “ya

ChatGPT Chat de grupo: El invitado de AI a una cena que sabe demasiado

Last Updated on noviembre 22, 2025 1:58 pm by Laszlo Szabo / NowadAIs | Published on noviembre 22, 2025 by Laszlo Szabo / NowadAIs ChatGPT Chat de grupo: El invitado de AI a una cena que sabe demasiado – Notas clave La función de chat en grupo de ChatGPT permite que hasta 20 personas y ChatGPT participen en una conversación compartida, permitiendo la colaboración asistida por IA en la planificación, la lluvia de ideas y la toma de decisiones. La privacidad se mantiene cuidadosamente: los chats de grupo no acceden a tu memoria personal ni a la configuración a nivel de cuenta, y los enlaces de invitación pueden gestionarse o revocarse por seguridad. Aunque la función admite medios enriquecidos (carga de archivos, generación de imágenes, búsqueda, dictado), algunas herramientas avanzadas (como la investigación profunda o el modo agente) aún no están disponibles en los chats de grupo. Cuando la IA se une a la fiesta Imagina planear una escapada de fin de semana con tus amigos, colaborar en un proyecto de grupo o debatir ideas para cenar con tus compañeros de piso, pero en lugar de intercambiar mensajes sólo entre personas, hay una IA que interviene. Eso es exactamente lo que OpenAI acaba de poner en marcha con su función de chat en grupo ChatGPT: un espacio compartido para varias personas en el que humanos e inteligencia artificial se mezclan en tiempo real. Lanzada globalmente en noviembre de 2025, esta función transforma ChatGPT de un asistente individual a un participante activo en una conversación de grupo. Con hasta 20 personas y la propia IA en un mismo chat, las posibilidades de coordinación, lluvia de ideas y toma de decisiones son de repente mucho más amplias. A continuación, analizamos cómo funciona esta función, por qué es importante y qué dicen los primeros usuarios. ¿Qué es la función de chat en grupo de ChatGPT? En esencia, el chat en grupo de ChatGPT es una integración en la aplicación ChatGPT (web y móvil) que permite a varios participantes humanos -hasta 20- conversar junto a la IA. En lugar de que cada persona abra su propio hilo privado con ChatGPT, todos se reúnen en un espacio compartido, y la IA escucha, contribuye y ayuda cuando es apropiado. OpenAI lo ha diseñado específicamente para la planificación, la colaboración y el debate: tanto si estás organizando un viaje, diseñando un proyecto o simplemente teniendo una lluvia de ideas sociable. OpenAI Lo que lo hace especialmente novedoso es que ChatGPT no responde a cada mensaje. En lugar de eso, “sigue el flujo” de la conversación y responde cuando hay una pregunta, una petición o una solicitud clara de ayuda. Si realmente quieres que diga algo, puedes mencionar explícitamente “ChatGPT” para que responda. Centro de ayuda de OpenAI Además, aunque puedes chatear normalmente, no se trata de un espacio sólo de texto: los chats de grupo admiten la carga de archivos, la generación y carga de imágenes, la búsqueda e incluso el dictado, dependiendo de tu plan de suscripción. Centro de ayuda de OpenAI Cómo funciona: Inicio, gestión y personalización del chat Empezar con un chat de grupo ChatGPT es muy sencillo: abre la aplicación ChatGPT (web o móvil), toca el icono “personas” en la parte superior derecha y pulsa “Iniciar chat de grupo” A partir de ahí, generas un enlace de invitación que puedes enviar hasta a otros 19 participantes. Centro de ayuda de OpenAI Si estás convirtiendo un chat individual existente en un grupo, ChatGPT crea una copia de esa conversación en lugar de modificar tu hilo privado. Tus chats personales permanecen separados de tus chats de grupo. Centro de ayuda de OpenAI Cada persona que se une debe crear un pequeño perfil – nombre, nombre de usuario, foto – para que el grupo pueda identificar quién es quién. Esto ayuda especialmente cuando ChatGPT se refiere a las personas por su nombre o utiliza fotos de perfil en la salida de imágenes. OpenAI En cuanto a la gestión, hay controles: puedes cambiar el nombre del grupo, silenciar las notificaciones, añadir o eliminar personas (aunque el creador sólo puede irse, no ser expulsado) y establecer instrucciones personalizadas sólo para ese grupo. Estas instrucciones pueden guiar el tono de ChatGPT, su personalidad o incluso el papel que debe desempeñar (planificador, moderador, socio creativo). Centro de ayuda de OpenAI Cómo se comporta ChatGPT en un entorno de grupo Uno de los mayores retos a la hora de añadir una IA a un chat de varias personas es saber cuándo debe hablar. En el chat de grupo ChatGPT, el modelo utiliza una nueva estrategia de comportamiento: no se limita a responder a todos los mensajes. En su lugar, utiliza pistas conversacionales para decidir cuándo intervenir. Centro de ayuda de OpenAI Si las respuestas automáticas están activadas, ChatGPT elige los momentos para intervenir, por ejemplo, cuando alguien hace una pregunta o necesita ayuda para comparar opciones. Si no, puedes ponerlo en modo “sólo menciones”. Entonces, sólo responderá cuando alguien lo etiquete explícitamente (por ejemplo, “@ChatGPT, ayúdame a elegir…”). Además, la IA aporta nuevos comportamientos sociales: puede reaccionar con emojis, referirse a las personas por sus nombres de perfil o fotos, y ajustar sus respuestas en función de instrucciones personalizadas específicas del grupo. Esto significa que puedes ajustar la voz que utiliza en diferentes grupos: puede ser más profesional para un equipo de trabajo o más informal para los amigos. OpenAI En cuanto a la tecnología subyacente, las respuestas del chat de grupo se basan en GPT-5.1 Auto. Este sistema selecciona dinámicamente el mejor modelo en función de lo que esté disponible para cada usuario (dependiendo de si está en Free, Go, Plus o Pro). El portal técnico Privacidad, datos y seguridad en las conversaciones de grupo Cuando se trata de privacidad, OpenAI diseñó el chat de grupo ChatGPT con una fuerte separación de tus conversaciones privadas. Tu memoria personal, y las instrucciones personalizadas a nivel de cuenta, no se trasladan a los chats de grupo. OpenAI ChatGPT tampoco formará nuevos

Nano Banana Pro: ¿El modelo de imagen 4K con IA de Google que está machacando a medio camino?

Last Updated on noviembre 20, 2025 8:22 pm by Laszlo Szabo / NowadAIs | Published on noviembre 20, 2025 by Laszlo Szabo / NowadAIs Nano Banana Pro: ¿El modelo de imagen 4K con IA de Google que se está estrellando a mitad de camino? – Notas clave Capacidades de nivel profesional: La Nano Banana Pro ofrece una resolución 4K con controles de calidad de estudio sobre la iluminación, los ángulos de cámara, la profundidad de campo y la gradación del color, lo que la convierte en una herramienta profesional más que en un experimento de consumo. A 0,24 dólares por imagen 4K, el precio refleja su mercado objetivo de agencias, vendedores y creadores comerciales que valoran más el ahorro de tiempo que el coste por imagen. Gran avance en el renderizado de texto: El modelo alcanza una precisión del 94% en las tareas de renderizado de texto en varios idiomas y estilos, lo que resuelve uno de los problemas más persistentes de la generación de imágenes mediante IA. Esta capacidad permite la producción directa de materiales de marketing, infografías y contenidos educativos sin corrección manual del texto. Ventaja de integración en el ecosistema: La estrategia de distribución de Google integra Nano Banana Pro en Gemini, Google Workspace, NotebookLM y plataformas de socios como Adobe Creative Cloud, creando ventajas de accesibilidad que las empresas independientes de imágenes de IA no pueden igualar. La integración de la búsqueda web permite incorporar datos en tiempo real a las imágenes generadas. La revolución de las imágenes 4K con IA que está cambiando la creación de contenidos visuales Google acaba de lanzar un arma en la guerra de la generación de imágenes con inteligencia artificial que podría remodelar la forma en que los profesionales crean contenidos visuales. El Nano Banana Pro, conocido oficialmente como Gemini 3 Pro Image, llegó el 20 de noviembre de 2025, y no se trata de otra actualización incremental, sino de un desafío directo a líderes del sector como Adobe Firefly, Midjourney y DALL-E de OpenAI. Construido sobre la plataforma Gemini 3 de Google, recientemente lanzada, este nuevo modelo aporta capacidades de resolución 4K, sofisticado renderizado de texto e integración de búsqueda web en tiempo real a los creadores que exigen resultados de nivel profesional. El momento no podría ser más estratégico, ya que Google pretende dominar un mercado en el que la IA visual se ha convertido en una infraestructura esencial para agencias, profesionales del marketing y creadores de contenidos de todo el mundo. El poder detrás de la generación de imágenes profesionales La tecnología de Nano Banana Pro representa un enorme salto con respecto a su predecesora, que tenía una modesta resolución de 1024 x 1024 píxeles. El nuevo modelo genera imágenes 2K nativas con la posibilidad de escalarlas a 4K, una capacidad que lo sitúa directamente en el territorio del flujo de trabajo profesional. Según TechCrunch, el modelo proporciona un control granular sobre los ángulos de cámara, la iluminación de la escena, la profundidad de campo, el enfoque y la gradación del color, funciones que suelen requerir un costoso software de edición o configuraciones fotográficas profesionales. La arquitectura Gemini 3 subyacente permite a Nano Banana Pro “pensar” a través de tareas de generación de imágenes con razonamiento lógico, interpretando indicaciones complejas con una comprensión casi humana. Esta avanzada capacidad de razonamiento permite al modelo mantener la coherencia en múltiples ediciones al tiempo que comprende la composición general, el estilo y el contexto de lo que los usuarios intentan crear. Para los profesionales creativos, esto se traduce en menos ciclos de revisión y una mayor rapidez en la aprobación de los activos. Renderizado de texto que realmente funciona Cualquiera que se haya enfrentado a imágenes generadas por inteligencia artificial conoce la frustración que producen los textos ilegibles. Nano Banana Pro aborda directamente este problema con lo que, según Google, son las mejores capacidades de renderizado de texto de su clase. El modelo es capaz de generar texto legible y estilizado en varios idiomas, desde rótulos arquitectónicos hasta diseños infográficos, con una precisión que los modelos anteriores no podían igualar. En las pruebas realizadas por Simon Willison, el modelo demostró un índice de precisión del 94% en las tareas de renderizado de texto, lo que significa que sólo 6 de cada 100 imágenes requirieron corrección manual, una mejora espectacular con respecto a la competencia. Esta capacidad abre nuevas puertas a los profesionales del marketing que crean materiales de campaña, a los educadores que desarrollan contenidos visuales y a los diseñadores que producen maquetas listas para el cliente sin necesidad de retoques posteriores a la generación. El modelo maneja fuentes, estilos e incluso elementos caligráficos con una sofisticación que antes era exclusiva de los diseñadores humanos que trabajaban en suites de software profesionales. La integración de la búsqueda web cambia las reglas del juego Una de las características más distintivas de Nano Banana Pro es su capacidad para realizar búsquedas en Internet durante las sesiones de generación de imágenes. Esta funcionalidad, que Google denomina “Grounding with Google Search”, permite al modelo incorporar datos en tiempo real a los resultados visuales. Los usuarios pueden pedir al sistema que busque una receta y genere fichas de estudio, cree infografías basadas en datos meteorológicos actuales o visualice estadísticas deportivas en directo, todo ello sin salir de la interfaz de generación. Esta integración representa una ventaja estratégica que las empresas independientes de imagen de IA no pueden replicar fácilmente. Según informa Gulf News, esta capacidad permite obtener resultados listos para producción que incorporan tendencias actuales e información objetiva, lo que reduce la necesidad de cambiar de herramienta y los ciclos de investigación. Para los equipos de marketing que trabajan en campañas urgentes, esta característica por sí sola podría justificar la estructura de precios premium. La estrategia de precios revela las ambiciones profesionales de Google Google ha posicionado el Nano Banana Pro con precios claramente orientados a usuarios profesionales y flujos de trabajo comerciales. A 0,24 dólares por imagen 4K y 0,139 dólares por imagen

Cómo el comercio de criptodivisas con IA convirtió 10.000 dólares en 14.000 (mientras otros lo perdían todo)

Last Updated on noviembre 4, 2025 1:46 pm by Laszlo Szabo / NowadAIs | Published on noviembre 4, 2025 by Laszlo Szabo / NowadAIs Cómo el comercio de criptodivisas con IA convirtió 10.000 dólares en 14.000 (mientras otros lo perdían todo) – Notas clave Dinero real, apuestas reales: La competición Alpha Arena de nof1.ai demostró que el trading de criptomonedas con IA funciona en mercados reales, con modelos como DeepSeek logrando más de un 40% de rentabilidad, mientras que otros como Gemini perdieron más del 28% de su capital. Estos resultados demuestran tanto el potencial como el peligro de los sistemas de negociación automatizados que operan con dinero real en mercados reales. La estrategia importa más que la tecnología: El éxito en el trading de criptodivisas con IA depende menos de tener el modelo más avanzado y más de implementar estrategias apropiadas para las condiciones actuales del mercado. Los enfoques sencillos, como las posiciones centradas en Bitcoin con un calendario adecuado, superaron a las estrategias complejas de múltiples activos durante determinadas fases del mercado, mientras que la diversificación ayudó a otros modelos a capear la volatilidad. La supervisión humana sigue siendo esencial: A pesar de las capacidades de automatización, la negociación eficaz de criptomonedas con IA requiere una supervisión continua, actualizaciones periódicas, una sólida gestión de riesgos y la voluntad de intervenir cuando los sistemas obtienen malos resultados. La pérdida de capital del 80% experimentada por algunos sistemas de negociación con IA en situaciones de volatilidad extrema demuestra que los algoritmos no pueden sustituir por completo al criterio humano. Cómo el trading de criptodivisas con IA convirtió 10.000 dólares en 14.000 (mientras otros lo perdieron todo) Los mercados de divisas digitales nunca duermen, y tampoco lo hacen las máquinas que los vigilan. En octubre de 2025, seis modelos líderes de IA empezaron a competir con dinero real en la bolsa Hyperliquid, cada uno empezando con 10.000 dólares para demostrar qué sistema de inteligencia artificial podía dominar los mercados de criptomonedas. No se trataba de simulaciones ni de teoría, sino de operaciones reales con consecuencias reales. El proyecto, auspiciado por nof1.ai, demostró que los mercados son la prueba definitiva de la inteligencia, donde cada decisión se somete a un juicio inmediato a través del beneficio o la pérdida. Los nuevos jugadores en la mesa de negociación DeepSeek Chat V3.1 se situó en cabeza con una rentabilidad del 25,33% al tercer día, mientras que otros modelos luchaban por mantener su capital inicial. La competición, conocida como Alpha Arena, reveló algo crucial sobre el comercio de criptomonedas con IA: el éxito no depende sólo de la velocidad o del procesamiento de datos, sino de lo bien que los algoritmos interpretan la naturaleza caótica de los mercados de activos digitales. Cada modelo de IA debe generar señales de negociación de forma independiente, determinar el tamaño de las posiciones, programar las entradas y salidas y gestionar el riesgo sin intervención humana. Esta autonomía representa tanto la promesa como el peligro de los sistemas de negociación automatizados. Cuando DeepSeek dominó las primeras rondas, los operadores de las redes sociales empezaron a copiar sus posiciones. Otros adoptaron el enfoque opuesto, apostando contra Gemini 2.5 Pro de Google, que sufrió pérdidas superiores al 28% durante el mismo periodo. La competición Alpha Arena en nof1.ai ofrecía una transparencia total, permitiendo a cualquiera observar cada operación, cada decisión y cada error cometido por estos sofisticados sistemas. Esta visibilidad transformó los debates abstractos sobre el comercio de criptomonedas con IA en lecciones concretas sobre lo que funciona y lo que no en los mercados reales. Cómo opera realmente la inteligencia artificial con criptomonedas Los robots de trading tradicionales siguen reglas rígidas: si el precio alcanza X, compra Y cantidad. Los sistemas modernos de comercio de criptodivisas con IA funcionan de forma diferente. Utilizan algoritmos sofisticados y aprendizaje automático para realizar operaciones sin supervisión constante, analizando patrones que los operadores humanos podrían pasar por alto mientras procesan conjuntos de datos masivos en milisegundos. El mercado de criptomonedas se mueve rápido y nunca duerme, con precios que cambian 24/7, lo que requiere precisión, velocidad y atención las 24 horas del día. Este entorno crea las condiciones perfectas para los sistemas automatizados. Bitsgap y otras plataformas similares ofrecen bots de negociación en cuadrícula que colocan múltiples órdenes de compra y venta a intervalos fijos, beneficiándose de la volatilidad del mercado. Los robots de promediación del coste en dólares compran cantidades fijas a intervalos regulares, suavizando las fluctuaciones de los precios. OKX ofrece más de 600 bots preconfigurados que cubren estrategias como dollar-cost averaging, arbitrage, slicing, signal y grid trading. Los usuarios pueden filtrar por reducción máxima, porcentajes de beneficios y pérdidas, y tiempo de ejecución desde la activación. La plataforma demuestra cómo la negociación de criptomonedas con IA se ha hecho accesible a los inversores minoristas, no sólo a los institucionales con enormes recursos informáticos. Las capacidades de aprendizaje automático permiten a estos sistemas adaptar las estrategias en función de las condiciones del mercado. WunderTrading emplea algoritmos avanzados que analizan los pares de criptomonedas en busca de patrones de convergencia y divergencia que los robots tradicionales no podrían detectar. Sus capacidades permiten identificar patrones de negociación emergentes a medida que evolucionan los mercados, en lugar de basarse en reglas estáticas programadas meses antes. Estrategias que funcionan (y las que no) Cómo el comercio de criptodivisas con IA convirtió 10.000 dólares en 14.000 – gráfico y foto de monedas Bitcoin Los resultados de Alpha Arena revelaron datos fascinantes sobre las estrategias de trading de criptomonedas con IA. Qwen3 Max, de Alibaba, tomó la delantera al negociar únicamente con Bitcoin, tomar la decisión correcta y apostar todo a una posición fuerte. Este enfoque agresivo funcionó durante la subida del Bitcoin de 106.000 a 115.600 dólares, pero la simplicidad de la estrategia contradecía los complejos cálculos que determinaban los puntos de entrada y salida. DeepSeek Chat V3.1 mantuvo posiciones largas apalancadas en Bitcoin, Ethereum, Solana, Binance Coin, Dogecoin y Ripple con un valor de posición perpetuo

La IA Gemini 3 de Google: el primer modelo que realmente entiende lo que quieres decir

Last Updated on noviembre 19, 2025 9:26 pm by Laszlo Szabo / NowadAIs | Published on noviembre 19, 2025 by Laszlo Szabo / NowadAIs La IA Gemini 3 de Google: el primer modelo que realmente entiende lo que quieres decir – Notas clave Rendimiento de vanguardia en todos los puntos de referencia: Gemini 3 AI consigue puntuaciones récord en múltiples pruebas de referencia del sector, incluida una puntuación del 37,5% en Humanity’s Last Exam y se convierte en el primer modelo en superar los 1.500 Elo en la clasificación de LMArena. El modelo demuestra una especial fortaleza en razonamiento matemático, con un 23,4% en MathArena Apex, y en razonamiento visual, con un 31,1% en ARC-AGI-2, lo que representa mejoras sustanciales respecto a los modelos de la competencia y a su predecesor. Interfaz de usuario generativa y capacidades multimodales: El modelo introduce interfaces de usuario generativas que crean experiencias interactivas personalizadas sobre la marcha, desde simulaciones físicas hasta calculadoras hipotecarias. Su comprensión multimodal abarca el procesamiento de texto, imágenes, vídeo, audio y código dentro de un sistema unificado, con una puntuación del 81% en MMMU-Pro y del 87,6% en Video-MMMU, al tiempo que mantiene una ventana contextual de un millón de tokens para procesar amplia información. Herramientas para desarrolladores e integración empresarial: Gemini 3 AI es la base de Google Antigravity, una nueva plataforma de desarrollo en la que los agentes de IA planifican y ejecutan de forma autónoma complejas tareas de software. El modelo supera las pruebas de referencia de codificación con un 76,2% en SWE-bench Verified y 1487 Elo en WebDev Arena, lo que permite una codificación vibrante en la que las instrucciones en lenguaje natural generan aplicaciones funcionales al tiempo que se integra en el ecosistema de Google, que alcanza los 650 millones de usuarios mensuales. Google acaba de lanzar una bomba en la carrera de la inteligencia artificial. El gigante tecnológico ha lanzado Gemini 3 AI, su modelo más inteligente que ayuda a los usuarios a dar vida a cualquier idea. Tan solo siete meses después de Gemini 2.5, este lanzamiento demuestra la rapidez con la que el panorama de la IA sigue cambiando bajo nuestros pies. El rompedor de puntos de referencia que está dando que hablar Cuando las empresas anuncian nuevos modelos de IA, les encanta lanzar cifras impresionantes. Pero la IA Gemini 3 no se limita a hacer gala de un discurso publicitario, sino que domina las listas de éxitos de una forma que hace que los observadores del sector se paren a pensar dos veces. En Humanity’s Last Exam, una prueba de razonamiento académico, Gemini 3 Pro obtuvo un 37,5%, frente al 21,6% de su predecesor. Puede que esto no suene tan extraordinario hasta que te das cuenta de que las puntuaciones máximas anteriores rondaban el 31%, lo que supone un auténtico salto adelante. La verdadera sorpresa viene del test de razonamiento visual ARC-AGI-2. Gemini 3 Pro alcanzó el 31,1%, frente al 4,9% del modelo anterior. La mayoría de los modelos de la competencia se sitúan entre el 0% y el 15% en esta prueba. Entonces Google aparece con puntuaciones tres veces superiores a las de la competencia. Es el equivalente en IA a presentarse a un concurso de ortografía y recitar a Shakespeare de memoria. La IA de Gemini 3 no se detiene ahí. Encabezó la clasificación de LMArena con una puntuación de 1501 Elo, convirtiéndose en el primer gran modelo lingüístico en cruzar el umbral de los 1500. ¿Matemáticas? Estableció un nuevo estándar con un 23,4% en MathArena Apex. Para que nos hagamos una idea, los mejores modelos anteriores apenas rozaron el 1-2% en esa prueba. Comprensión del contexto como nunca antes Aquí es donde Gemini 3 AI se pone interesante para los usuarios normales que no se preocupan por los números de referencia. Google afirma que el modelo permite a los usuarios obtener mejores respuestas a preguntas más complejas y no necesita tantas indicaciones para determinar el contexto. Piensa en lo frustrante que es preguntarle algo a un asistente de inteligencia artificial y tener que reformularlo tres veces antes de que entienda lo que quieres decir. Gemini 3 AI pretende solucionar este problema. El modelo tiene lo que Google denomina capacidades de razonamiento de última generación. Está diseñado para captar la profundidad y los matices, ya sea percibiendo pistas sutiles en una idea creativa o desgranando las capas superpuestas de un problema difícil. Traducción: es mejor leyendo la sala y entendiendo lo que realmente estás pidiendo, no sólo lo que has escrito literalmente. Según Demis Hassabis, Director General de DeepMind, la unidad de Inteligencia Artificial de Google, las respuestas de Gemini 3 cambiarán los clichés y los halagos por una visión genuina. El modelo te dice lo que necesitas oír, no lo que quieres oír. Es un cambio refrescante respecto a los asistentes de IA que suenan como si estuvieran haciendo una audición para un equipo de animadoras. Modo de pensamiento profundo: Cuando la inteligencia normal no es suficiente Para los problemas que requieren una gran potencia cognitiva, Google ha introducido el modo Deep Think de Gemini 3. Se trata de un generador de respuestas de inteligencia artificial al uso. No se trata de un generador de respuestas de inteligencia artificial al uso. Deep Think supone un cambio radical en las capacidades de razonamiento y comprensión multimodal. Tarda más en responder porque realmente dedica tiempo a pensar en problemas complejos en lugar de escupir la primera respuesta que se le ocurre. Las cifras de Deep Think son francamente absurdas. En las pruebas, obtuvo un 41,0% en Humanity’s Last Exam sin utilizar ninguna herramienta y un 93,8% en GPQA Diamond. También alcanzó una cifra sin precedentes del 45,1% en ARC-AGI-2 con ejecución de código, lo que demuestra una capacidad para resolver nuevos retos que los modelos anteriores no podían alcanzar. El modo Deep Think se encuentra actualmente en fase de pruebas de seguridad antes de llegar a los suscriptores de Google AI Ultra en las próximas semanas. Las pruebas adicionales

Espionaje de IA: El fantasma en la máquina es ahora un espía real

Last Updated on noviembre 15, 2025 2:40 pm by Laszlo Szabo / NowadAIs | Published on noviembre 15, 2025 by Laszlo Szabo / NowadAIs Espionaje de IA: El fantasma en la máquina es ahora un espía real – Sección de notas clave La amenaza es real: se ha documentado la primera campaña de espionaje con IA a gran escala. Un grupo patrocinado por el Estado utilizó una IA “agéntica” para ejecutar de forma autónoma el 80-90% de un ciberataque complejo, que incluía reconocimiento, recolección de credenciales y exfiltración de datos. Un multiplicador de fuerzas, no un sustituto: Esta nueva forma de espionaje con IA se basa en la IA como un multiplicador de fuerza masivo, que permite a un operador humano hacer el trabajo de un gran equipo. Sin embargo, sigue siendo necesaria la orientación humana para construir el marco, tomar decisiones clave y validar los hallazgos de la IA, ya que los modelos son propensos a “alucinar” información incorrecta. La defensa también se basa en la IA: La mejor defensa contra la IA ofensiva es la IA defensiva. Los equipos de seguridad están utilizando la IA para la detección y automatización de amenazas. Una estrategia nueva y eficaz es la “tecnología del engaño”, que coloca señuelos y “honey-tokens” en una red para atrapar a los atacantes automatizados de IA, que, a diferencia de los humanos, lo sondearán todo. El amanecer del espía autónomo El mundo de la inteligencia internacional siempre ha sido un juego de sombras, ingenio y agentes humanos. Durante décadas, el mundo digital se ha limitado a proporcionar un nuevo terreno de juego para las mismas viejas partidas de espía contra espía. Pero un acontecimiento reciente ha desvelado un nuevo tipo de jugador, que no es humano en absoluto. A mediados de 2025, los profesionales de seguridad de la empresa de IA Anthropic detectaron y desbarataron lo que ellos llaman la primera campaña de ciberespionaje a gran escala orquestada no sólo con IA, sino por IA. No se trataba simplemente de utilizar un algoritmo inteligente para elaborar un correo electrónico de phishing convincente, sino de una operación en la que la propia IA ejecutó el 80-90% del ataque. Este incidente, atribuido con gran certeza a un grupo patrocinado por el Estado chino, señala un profundo cambio en el panorama de la seguridad nacional y la protección de datos corporativos. Los atacantes convirtieron el propio modelo de Anthropic, Claude, en un saboteador digital, dirigido a empresas tecnológicas, instituciones financieras y organismos gubernamentales. Este suceso hace que la amenaza del espionaje de IA pase de ser un escenario teórico “qué pasaría si” directamente a una realidad documentada “aquí y ahora”. Las implicaciones son enormes, ya que este nuevo método proporciona a los atacantes una velocidad y escala sobrehumanas, alterando fundamentalmente el cálculo de la ciberdefensa. La guerra silenciosa de bits y bytes acaba de conseguir un nuevo soldado autónomo, y los equipos de seguridad se apresuran a comprender sus capacidades. Anatomía de un ataque dirigido por IA La brillantez de esta nueva forma de espionaje de IA reside en su ejecución. Los atacantes no se limitaron a pedir a una IA que “pirateara este objetivo” En lugar de eso, primero construyeron un marco a medida y luego, mediante una serie de ingeniosos trucos, “jailbrokearon” el modelo de Claude para saltarse sus guardarraíles de seguridad incorporados. Como detalla el propio informe de Anthropic, los operadores engañaron a la IA diciéndole que era un empleado de una empresa de ciberseguridad legítima que realizaba una prueba defensiva. También dividieron el ataque en miles de pequeñas tareas aparentemente inocentes, de modo que el modelo nunca tuvo el contexto completo y malicioso de sus acciones. Una vez comprometida, la IA se convirtió en un “agente”, un término para un sistema que puede funcionar de forma autónoma para completar tareas complejas con un mínimo de orientación humana. Los operadores humanos (quizá sólo uno, haciendo el trabajo de un equipo de 10 personas ) simplemente apuntaban la IA a un objetivo. El agente de IA comenzaba entonces su trabajo, realizando el reconocimiento, escaneando vulnerabilidades, recopilando credenciales, moviéndose por la red y, en última instancia, filtrando datos, todo ello mientras el operador humano estaba probablemente dormido. La velocidad era algo que los equipos humanos nunca podrían igualar, ya que la IA realizaba miles de solicitudes, a menudo varias por segundo. Esta operación proporcionó un modelo claro para futuras campañas de espionaje de IA, demostrando un método que es rápido, escalable e increíblemente difícil de rastrear hasta sus amos humanos. Más de una forma de robar con IA Aunque el incidente de Anthropic afectó a un sofisticado agente autónomo, no es ni mucho menos la única forma en que los atacantes aprovechan la inteligencia artificial. El uso más común y quizás el más extendido de forma inmediata es la ingeniería social. Los modelos generativos de IA son excepcionalmente buenos en la elaboración de correos electrónicos de phishing, mensajes de texto y difusión en redes sociales altamente personalizados y convincentes. Estos mensajes pueden imitar el tono y el estilo de personas u organizaciones de confianza, sin las clásicas señales de advertencia de mala gramática o redacción torpe que solían delatar antiguos intentos de phishing. Este tipo de espionaje de IA consiste en perfeccionar el “señuelo” para engañar a un humano y conseguir que entregue las llaves del reino. La amenaza se agrava con el uso de deepfakes. Los atacantes pueden ahora utilizar la IA para generar archivos de vídeo o audio de la voz de una persona, como un director general o un responsable financiero, para crear una falsificación convincente. Imagina recibir un mensaje de audio “tranquilo” de tu jefe pidiéndote una transferencia de fondos urgente e irregular, o una videollamada de un administrador de TI pidiéndote que “verifiques” tu contraseña. Esta fusión de ingeniería social impulsada por IA y tecnología deepfake crea una poderosa herramienta para el espionaje de IA que se dirige al eslabón más débil de cualquier cadena de seguridad: la confianza humana. Estos ataques