El amanecer de las matemáticas potenciadas por la IA: La IA de Gauss conquista el teorema fuerte de los números primos

Last Updated on septiembre 16, 2025 12:52 pm by Laszlo Szabo / NowadAIs | Published on septiembre 14, 2025 by Laszlo Szabo / NowadAIs El amanecer de las matemáticas potenciadas por la IA: La IA de Gauss conquista el teorema fuerte de los números primos – Sección de Notas Clave Velocidad sin precedentes: Gauss AI completó la formalización del Teorema del Número Primo Fuerte en sólo tres semanas, en comparación con los 18 meses de esfuerzos de expertos humanos, lo que demuestra el potencial de los sistemas de IA para acelerar drásticamente los procesos de investigación y formalización matemática. Modelo de colaboración entre humanos e IA: El éxito representa un enfoque híbrido en el que matemáticos humanos proporcionaron orientación estratégica y dirección conceptual, mientras que Gauss AI se encargó de la construcción detallada de pruebas formales, lo que sugiere un modelo de colaboración óptimo para la investigación matemática futura. Escala de la infraestructura técnica: La formalización requirió más de 25.000 líneas de código y 1.100 teoremas/definiciones, coordinados a través de miles de agentes de IA concurrentes que trabajaron hasta 12 horas cada uno, mostrando la escala computacional necesaria para aplicaciones matemáticas complejas de IA. Un gran avance matemático El mundo de las matemáticas fue testigo de un hito extraordinario cuando Math Inc. anunció que su agente de autoformalización, Gauss AI, completó con éxito la formalización del Teorema del Número Primo Fuerte en sólo tres semanas. Este logro contrasta fuertemente con los 18 meses que los mejores matemáticos humanos, incluidos Terence Tao y Alex Kontorovich, medallistas Fields, pasaron trabajando en el mismo proyecto antes de que su progreso se estancara. La culminación de este complejo reto matemático marca un momento crucial en la intersección de la inteligencia artificial y las matemáticas puras. El teorema del número primo fuerte representa uno de los problemas más difíciles de la formalización matemática, ya que requiere una comprensión intrincada del análisis complejo y la teoría de los números primos. Utilizando Gauss, hemos completado un reto planteado por el medallista Fields Terence Tao y Alex Kontorovich en enero de 2024 para formalizar el Teorema del Número Primo fuerte (PNT) en Lean. Este logro demuestra la notable capacidad de los sistemas de IA para abordar problemas que históricamente han requerido años de experiencia y colaboración humanas. Comprender el teorema del número primo fuerte El teorema de los números primos es uno de los resultados más fundamentales de la teoría de números, ya que describe cómo se distribuyen los números primos entre los números enteros. El teorema proporciona una fórmula asintótica precisa para la función de recuento de números primos π(x), que nos dice aproximadamente cuántos números primos existen por debajo de cualquier número dado x. Esta cuestión aparentemente sencilla sobre el recuento de números primos tiene profundas implicaciones para la criptografía, la informática y nuestra comprensión del universo matemático. El Teorema Fuerte de los Números Primos amplía este resultado básico con límites de error más precisos y perspectivas analíticas más profundas. Mientras que el teorema clásico de los números primos nos da una buena aproximación de la densidad de primos, la versión fuerte proporciona un control mucho más estricto de los términos de error, lo que permite a los matemáticos hacer afirmaciones más precisas sobre la distribución de primos. Esta mayor precisión requiere técnicas sofisticadas de análisis complejo, como la integración de contornos, los ceros de la función zeta de Riemann y métodos analíticos avanzados de teoría de números. La formalización de estos teoremas en lenguajes verificables por ordenador como Lean presenta capas adicionales de complejidad más allá de la propia demostración matemática. Cada paso debe justificarse explícitamente, cada definición debe enunciarse con precisión y cada conexión lógica debe establecerse claramente de manera que las máquinas puedan verificarla de forma independiente. Este proceso de autoformalización tiende un puente entre la intuición matemática humana y el razonamiento verificable por ordenador, creando un nuevo paradigma de investigación y validación matemática. Conozca al cerebro de Math Inc. Christian Szegedy, fundador de Math Inc, aporta una combinación única de experiencia en aprendizaje profundo y rigor matemático al campo de la autoformalización. Szegedy había escrito un artículo en 2019 proponiendo la autoformalización y fue inversor semilla en Morph, y su progreso le empujó a dejar xAI. Su transición de xAI a la fundación de Math Inc. representa un pivote estratégico hacia sistemas especializados de IA matemática que pueden manejar de forma autónoma tareas complejas de razonamiento formal. La formación de Szegedy abarca tanto las matemáticas teóricas como las aplicaciones prácticas del aprendizaje automático, lo que le sitúa en una posición única para afrontar los retos de la autoformalización matemática. Su trabajo anterior se centró en ejemplos adversariales en redes neuronales, paisajes de optimización y la intersección del aprendizaje profundo con el razonamiento formal. Esta experiencia interdisciplinar resulta esencial a la hora de desarrollar sistemas de IA que deben cumplir los requisitos lógicos precisos de la demostración matemática y, al mismo tiempo, aprovechar las capacidades de reconocimiento de patrones de las redes neuronales modernas. La fundación de Math Inc. refleja una tendencia más amplia hacia empresas especializadas en IA que se centran en dominios específicos en los que la inteligencia artificial puede alcanzar un rendimiento sobrehumano. En lugar de perseguir sistemas de IA de propósito general, Szegedy ha optado por concentrarse en el mundo matemáticamente preciso de la demostración formal de teoremas y la autoformalización. Este enfoque permite una optimización más profunda y un desarrollo más específico, lo que puede conducir a avances más significativos en las aplicaciones matemáticas de la IA. Arquitectura técnica de Gauss AI El amanecer de las matemáticas potenciadas por IA Gauss AI conquista el teorema del número primo fuerte – imagen en línea Gauss AI es un sofisticado sistema de autoformalización diseñado específicamente para traducir el razonamiento matemático humano en demostraciones formales verificables por máquinas. El sistema funciona analizando enunciados matemáticos en lenguaje natural y convirtiéndolos al lenguaje de pruebas formales Lean, un proceso que requiere un profundo conocimiento tanto del contenido matemático como de las estructuras

La edición de imágenes en Gemini ofrece resultados de nivel profesional sin necesidad de aprender complejos programas informáticos

Last Updated on agosto 30, 2025 1:30 pm by Laszlo Szabo / NowadAIs | Published on agosto 29, 2025 by Laszlo Szabo / NowadAIs La edición de imágenes en Gemini ofrece resultados de nivel profesional sin necesidad de aprender un software complejo – Sección de notas clave Gran avance en la consistencia de los personajes: la edición de imágenes en Gemini ahora mantiene la precisión de los rasgos faciales y la identidad a través de múltiples ediciones, resolviendo el antiguo problema de las herramientas de IA que distorsionaban la apariencia de las personas durante las modificaciones fotográficas. Edición conversacional multivuelta: El nuevo sistema permite la edición iterativa a través del lenguaje natural, permitiendo a los usuarios construir ediciones complejas paso a paso, preservando los cambios anteriores y manteniendo el contexto a lo largo de la conversación. Fusión avanzada de varias imágenes: Los usuarios pueden fusionar a la perfección varias fotografías en nuevas escenas cohesionadas con iluminación y composición realistas, yendo más allá del simple copiar y pegar para crear imágenes compuestas de apariencia natural. La revolución del “nano plátano” que está revolucionando la edición de imágenes con IA Google DeepMind ha presentado lo que muchos usuarios consideran el avance más impresionante en edición de imágenes con IA hasta la fecha. El modelo secreto que dominaba las clasificaciones de LMArena.ai bajo el misterioso nombre en clave “Nano Banana” se ha presentado oficialmente como Gemini 2.5 Flash Image. No se trata de una simple actualización incremental, sino que representa un cambio fundamental en la forma en que la IA gestiona la edición de imágenes, sobre todo a la hora de mantener la coherencia de los caracteres y permitir flujos de trabajo de edición conversacionales naturales. Gran avance en la coherencia de caracteres https://storage.googleapis.com/gweb-uniblog-publish-prod/original_videos/Character_consistency_TR7mVxk.mp4 El avance más significativo de Gemini en la edición de imágenes reside en su capacidad para mantener la identidad de los personajes en múltiples ediciones. Los anteriores editores de imágenes por IA sufrían lo que Google denomina el problema de “parecido pero no igual”, en el que las fotos editadas de personas perdían rasgos faciales sutiles que hacen que alguien sea reconocible. El nuevo modelo de Google está diseñado específicamente para que las fotos de amigos, familiares y mascotas se parezcan siempre a ellos mismos, tanto si estás probando un corte de pelo de los años 60 como si le pones un tutú a tu chihuahua. Este avance resuelve una de las limitaciones más frustrantes que impedían que la edición de imágenes con IA fuera práctica para las fotos personales. La tecnología funciona analizando y preservando los rasgos identificativos clave durante el proceso de edición. El modelo mantiene la apariencia de un personaje u objeto a través de múltiples indicaciones y ediciones, lo que permite a los usuarios colocar el mismo personaje en diferentes entornos conservando el sujeto. Esta capacidad se extiende más allá de los rostros humanos para incluir mascotas y otros sujetos, lo que la hace realmente útil para una amplia gama de aplicaciones creativas. Edición conversacional multivuelta La edición de imágenes en Google Gemini ahora admite verdaderos flujos de trabajo conversacionales gracias a las funciones de edición multivuelta. Los usuarios pueden participar en un proceso iterativo, realizando ajustes progresivos en las imágenes mediante comandos de lenguaje natural. Puedes seguir editando las imágenes que crea Gemini: coge una habitación vacía, pinta las paredes y, a continuación, añade una estantería, unos muebles o una mesa de centro, y Gemini te acompañará para modificar partes específicas conservando el resto. Este enfoque conversacional representa un cambio fundamental con respecto a los flujos de trabajo tradicionales de edición de imágenes. En lugar de empezar de nuevo con cada edición, Gemini 2.5 Flash Image Preview admite la edición multigiro mejorada, lo que permite responder al modelo con cambios tras recibir una imagen. El sistema recuerda el contexto de las ediciones anteriores y se basa en ellas, creando una experiencia de edición más natural y eficaz. Mezcla y composición avanzadas de fotografías El nuevo modelo introduce sofisticadas funciones de fusión de imágenes que van mucho más allá de las simples operaciones de copiar y pegar. Ahora los usuarios pueden cargar varias fotos y combinarlas a la perfección para crear nuevas escenas coherentes. Puedes fusionar fotos cargando varias y pidiendo al sistema que las combine, por ejemplo, para crear un retrato tuyo con tu perro en una cancha de baloncesto. Esta tecnología de fusión de múltiples imágenes demuestra una notable comprensión de la iluminación, la perspectiva y la composición. El modelo puede entender y fusionar varias imágenes de entrada, lo que permite a los usuarios colocar un objeto en una escena, cambiar el estilo de una habitación con una combinación de colores o una textura y fusionar imágenes con una sola indicación. Los resultados suelen parecer fotografías naturales en lugar de composiciones artificiales, lo que supone un avance significativo en la composición de imágenes con IA. Transferencia de estilos de diseño y aplicaciones creativas La edición de imágenes en Gemini incluye ahora potentes funciones de transferencia de estilos que permiten mezclar elementos visuales de forma creativa. Los usuarios pueden aplicar el estilo de una imagen a un objeto de otra, como tomar el color y la textura de los pétalos de una flor y aplicarlos a unas botas de lluvia, o diseñar un vestido utilizando el patrón de las alas de una mariposa. Esta función abre nuevas posibilidades a diseñadores y artistas que quieran experimentar con la estética visual. La función de transferencia de estilo va más allá de los simples cambios de color. La IA puede entender patrones visuales complejos, texturas y elementos artísticos, y aplicarlos contextualmente a diferentes objetos manteniendo proporciones e iluminación realistas. Esta capacidad hace que la edición de imágenes en Gemini sea especialmente valiosa para el diseño de moda, la visualización de productos y la exploración creativa. Panorama competitivo y rendimiento El impresionante rendimiento del modelo está respaldado por métricas objetivas. Durante las pruebas previas al lanzamiento en LMArena, “nano-banana” obtuvo más de 5 millones de votos de

La IA como complemento o como sustituto: La verdadera batalla por el futuro del trabajo

Last Updated on septiembre 9, 2025 12:09 pm by Laszlo Szabo / NowadAIs | Published on septiembre 9, 2025 by Laszlo Szabo / NowadAIs La IA como complemento o como sustituto: La verdadera batalla por el futuro del trabajo – Sección de notas clave El aumento de la IA apoya y amplía las funciones humanas en lugar de eliminarlas, fomentando la colaboración y nuevas oportunidades. La sustitución se produce cuando las tareas son repetitivas y se basan en reglas, lo que aumenta la eficiencia pero corre el riesgo de desplazar al trabajador, especialmente en los puestos de nivel inicial. Los lugares de trabajo con más éxito combinan el aumento y la sustitución de la IA, combinando la velocidad de la máquina con el juicio humano para obtener resultados óptimos. El sentido del debate Uno de los temas más candentes en los círculos tecnológicos hoy en día es “La IA como complemento o como sustituto” El debate se centra en si la inteligencia artificial debe servir de asistente a los humanos -amplificando nuestras capacidades- o si debe hacerse cargo de tareas enteras, posiblemente dejando de lado a las personas en el proceso. No es una teoría árida: se trata del futuro de nuestra forma de trabajar, aprender, crear y tomar decisiones. Hay mucho en juego, desde la productividad hasta la satisfacción laboral. En lugar de limitarse a automatizar las tareas rutinarias, la IA puede convertirse en un aliado que nos ayude a pensar en profundidad, detectar patrones más rápidamente y centrarnos en la resolución de problemas de alto nivel. Lo esencial: Definición de aumento y sustitución Cuando se habla de IA como aumento o sustitución, es importante aclarar los términos. la “sustitución” se refiere a situaciones en las que la IA se hace cargo por completo de una tarea o trabajo. Piense en ejemplos clásicos: un brazo robótico que dirige una cadena de montaje o chatbots que gestionan las solicitudes de asistencia de principio a fin. Por el contrario, “aumento” significa que la inteligencia artificial trabaja junto a los humanos, ampliando las capacidades en lugar de expulsar a las personas del bucle. Por ejemplo, una IA puede señalar transacciones sospechosas para que las revise un empleado de banca, o ayudar a un médico a detectar detalles sutiles en radiografías dejando la decisión final en manos del experto. Los inicios de la IA: la era de la automatización Al principio, gran parte de la energía de la IA se centró en la automatización, sustituyendo el trabajo repetitivo por algoritmos eficientes. La Automatización de Procesos Robóticos (RPA) se extendió por los sectores financiero, administrativo y minorista, agilizando la conciliación de facturas y la clasificación de datos y haciéndolas prácticamente libres de errores(Fuente). Sin embargo, lo que puede conseguir la automatización pura tiene un límite. Las tareas que requieren juicio, adaptación o empatía son difíciles para las máquinas. Aumento: El superpoder colaborativo de la IA La IA como aumento frente a sustitución pone de relieve cómo el aumento capacita a las personas en lugar de dejarlas atrás. Imaginemos a un consultor que resume miles de informes con GPT-4, o a un radiólogo que revisa las anomalías marcadas por la IA antes de hacer su diagnóstico. El profesional no es sustituido, sino respaldado por un socio siempre atento y basado en datos. La inteligencia aumentada también puede ayudar en tareas creativas, desde la composición musical hasta el diseño arquitectónico, sugiriendo combinaciones novedosas que nunca se encontrarían sólo con la intuición humana. Impacto en la industria: A quién beneficia y a quién debe preocupar La IA como aumento frente a sustitución es más importante en los sectores en los que el trabajo rutinario y basado en reglas es habitual. Los empleados que introducen datos, los cajeros de bancos y las cajeras de comercios corren un riesgo cada vez mayor de sustitución total, ya que el software puede procesar documentos, gestionar transacciones e inventarios con mayor rapidez y menor índice de error. Por otro lado, los empleos que combinan conocimientos técnicos con habilidades interpersonales -como profesores, enfermeros y consultores- tienen menos probabilidades de ser sustituidos. Estas funciones pueden beneficiarse del aumento de la IA, utilizando la tecnología para gestionar las cargas administrativas de modo que puedan dedicar más energía al trabajo centrado en el ser humano. Modelos de colaboración entre humanos e IA No existe un enfoque único para la IA como aumento o sustitución. Algunas empresas prefieren una división equitativa del trabajo, como los equipos de RR.HH. que aprovechan la IA para la selección pero siguen realizando las entrevistas ellos mismos. Otras utilizan sistemas “human-in-the-loop”, en los que la IA se encarga de la mayoría de las tareas, pero los humanos intervienen en los casos extremos y en las decisiones de alto riesgo. En los márgenes, algunas operaciones optan por una colaboración mínima, en la que los humanos establecen los parámetros y comprueban los resultados, mientras que la IA dirige el espectáculo de forma autónoma. Ejemplos reales: Aumento en acción Pensemos en la asistencia sanitaria, donde la IA “lee” las exploraciones médicas y señala posibles problemas, alertando al médico , que toma la decisión final. En ingeniería, las herramientas de diseño asistido por ordenador proponen modificaciones de los planos, pero es el arquitecto quien decide qué ideas seguir(Fuente). Los investigadores jurídicos utilizan plataformas basadas en IA para examinar enormes cantidades de documentos y sacar a la luz casos relevantes para que los abogados puedan centrarse en la estrategia. Sustitución: Eficiencia a un coste En cuanto a la IA como complemento o como sustituto, la automatización promete una eficiencia sin precedentes en determinados sectores. Las plantas de fabricación zumban con brazos robóticos que clasifican miles de widgets por hora. Los almacenes optimizan las rutas de sus robots de picking. Incluso los titulares de las noticias son redactados cada vez más por algoritmos cuando se necesitan resúmenes rápidos. Es difícil discutir el resultado bruto: menos errores, menos costes, resultados más estandarizados. Sin embargo, esto tiene el precio de reducir las oportunidades para puestos de nivel inicial o

Chroma Model Training Completo: Una nueva era en la generación de imágenes de IA de código abierto

Last Updated on agosto 24, 2025 7:06 pm by Laszlo Szabo / NowadAIs | Published on agosto 24, 2025 by Laszlo Szabo / NowadAIs Chroma Model Training Completo: Una nueva era en la generación de imágenes de IA de código abierto – Notas clave El modelo chroma representa un enorme logro computacional, que ha requerido más de 105.000 horas de entrenamiento en la GPU H100 y ha dado como resultado un sistema rentable de 8.900 millones de parámetros que supera a muchos modelos de mayor tamaño gracias a la optimización de la arquitectura y a una cuidadosa selección de los datos. La total libertad creativa distingue al modelo chroma de las alternativas comerciales, ya que proporciona capacidades de generación de contenidos sin censura bajo licencia Apache 2.0, al tiempo que mantiene la responsabilidad del usuario como piedra angular de la implantación ética de la IA. Múltiples variantes especializadas, incluidas las versiones Base, HD, Flash y Radiance, garantizan que el ecosistema del modelo ch roma satisfaga diversos requisitos técnicos, desde la creación rápida de prototipos hasta el trabajo de producción de alta resolución, con una excelente compatibilidad en diferentes configuraciones de hardware. La base de la innovación La comunidad de inteligencia artificial ha sido testigo de un importante hito con la finalización de la fase de entrenamiento del modelo croma. Tras un intenso periodo de desarrollo que ha requerido aproximadamente 105.000 horas de cálculo en la GPU H100, el proyecto Chroma ha publicado con éxito su conjunto completo de modelos, lo que supone un avance significativo en las capacidades de generación de texto a imagen de código abierto. El modelo Chroma representa un cambio fundamental en la forma de desarrollar y distribuir modelos de IA de código abierto. Construido sobre la arquitectura FLUX.1-schnell, este sistema de 8.900 millones de parámetros ha sufrido modificaciones sustanciales que lo distinguen de su predecesor. El equipo de desarrollo introdujo cambios arquitectónicos estratégicos, reduciendo el número de parámetros de los 12.000 millones originales y manteniendo al mismo tiempo la calidad del rendimiento mediante sofisticadas técnicas de optimización. El propio proceso de entrenamiento consumió ingentes recursos computacionales, utilizando las GPU H100 durante más de 105.000 horas. Teniendo en cuenta las tarifas de mercado actuales para el alquiler de GPU H100, que oscilan entre 2,40 y 3,50 dólares por hora en función del proveedor y el nivel de compromiso, esto representa una inversión aproximada de entre 250.000 y 367.500 dólares sólo en costes computacionales. Esta importante inversión subraya el compromiso de crear una alternativa de código abierto realmente capaz frente a los modelos propietarios. El modelo de croma se entrenó con un conjunto de datos cuidadosamente seleccionado de 5 millones de imágenes, seleccionadas de un grupo inicial de 20 millones de muestras. Este riguroso proceso de curación garantiza la diversidad en múltiples categorías de contenido, como anime, creaciones artísticas, fotografías y contenido especializado que a menudo ha sido filtrado por otros modelos. El tratamiento exhaustivo de los datos y las medidas de control de calidad aplicadas durante el desarrollo han dado como resultado un modelo que demuestra una comprensión superior de los conceptos visuales y los estilos artísticos. Excelencia arquitectónica e innovación técnica Las mejoras técnicas del modelo de croma van mucho más allá de la simple reducción de parámetros. El equipo de desarrollo implementó el enmascaramiento MMDIT, un sofisticado mecanismo de atención que resuelve los problemas que plantean las fichas de relleno innecesarias que podrían interferir en la calidad de generación de la imagen. Esta innovación representa una variación del enmascaramiento de la atención optimizada específicamente para los modelos de difusión, que evita el desvío de la atención y garantiza que el modelo se centre con precisión en los elementos relevantes de la imagen. Uno de los cambios arquitectónicos más significativos es la drástica reducción de la capa de modulación. El modelo FLUX original contenía una capa con 3.300 millones de parámetros que codificaban un único valor, que el equipo de Chroma sustituyó por una simple función. Esta optimización ahorró un espacio computacional considerable manteniendo la precisión, lo que demuestra el profundo conocimiento del equipo de los principios de eficiencia de las redes neuronales. El modelo Chroma también incorpora técnicas personalizadas de distribución temporal y transporte óptimo de minilotes para acelerar el entrenamiento y mejorar la estabilidad. Estas metodologías avanzadas garantizan que el modelo pueda generar imágenes coherentes y de alta calidad, manteniendo al mismo tiempo velocidades de procesamiento eficientes. La arquitectura de transformador de flujo rectificado permite al modelo manejar transformaciones complejas de texto a imagen con notable precisión. Las pruebas de rendimiento han revelado impresionantes mejoras de velocidad en comparación con versiones cuantizadas de modelos similares. En una RTX 3080, el modelo de croma puede generar imágenes mucho más rápido que las alternativas cuantificadas de GGUF, lo que supone una mejora de la velocidad de aproximadamente 2,5 veces en muchos escenarios. Este mayor rendimiento hace que el modelo sea más accesible para los usuarios con hardware de consumo, al tiempo que mantiene una calidad de salida profesional. Libertad creativa sin censura Una característica definitoria del modelo Ch roma es su enfoque sin censura de la generación de contenidos. A diferencia de muchos modelos comerciales que aplican filtros de contenido restrictivos, el objetivo de Chroma es ofrecer una libertad creativa total a los usuarios. Esta filosofía se basa en la creencia de que la responsabilidad debe recaer en el usuario en lugar de estar codificada en el propio modelo. La naturaleza no censurada del modelo Chroma aborda específicamente las limitaciones encontradas en otros sistemas, en particular en lo que respecta a la precisión anatómica y la representación artística. Muchos modelos comerciales han eliminado o restringido determinados conceptos anatómicos, lo que puede resultar problemático en casos de uso legítimo como la ilustración médica, los estudios de figuras y la expresión artística. Chroma reintroduce estas capacidades manteniendo los límites adecuados gracias a la responsabilidad del usuario y no a las limitaciones del sistema. Este enfoque ha demostrado ser especialmente valioso para artistas, diseñadores y creadores de contenidos

Desempleo debido a la IA: ¿siguen mereciendo la pena los títulos universitarios?

Last Updated on agosto 18, 2025 7:39 pm by Laszlo Szabo / NowadAIs | Published on agosto 18, 2025 by Laszlo Szabo / NowadAIs Desempleo debido a la IA: ¿siguen mereciendo la pena los títulos universitarios? – Notas clave El desempleo debido a la IA está aumentando más rápidamente entre los graduados jóvenes, expuestos a la tecnología, con la automatización reduciendo las oportunidades de trabajo de nivel de entrada en múltiples sectores. Mientras que las industrias impulsadas por la IA están creando nuevas carreras, la recualificación sigue siendo un reto importante, dejando a muchos trabajadores incapaces de hacer la transición lo suficientemente rápido. El impacto del desempleo debido a la IA se deja sentir de forma desigual en los distintos países y especialidades, lo que obliga a estudiantes, profesionales y responsables políticos a adaptar estrategias para una mano de obra cambiante. Los graduados y el cambiante panorama laboral La transformación digital que está arrasando las economías mundiales está haciendo tambalear viejos supuestos sobre la seguridad en el empleo, sobre todo para los titulados universitarios. Mientras que la educación superior se consideraba antes un billete hacia un empleo estable, el creciente efecto de la inteligencia artificial está haciendo que muchos se replanteen el valor y la garantía de futuro de sus diplomas, que tanto les ha costado conseguir. La IA avanza hacia el trabajo de cuello blanco Hasta hace poco, la mayoría de los profesionales creían que la automatización afectaría más a los trabajos rutinarios y manuales. Los cajeros, los trabajadores de las cadenas de montaje y los operadores de los centros de llamadas fueron los primeros en sentir los temblores. Hoy, la historia del desempleo debido a la IA está cambiando. Los empleos de cuello blanco en áreas como el análisis jurídico, la contabilidad, la traducción y la ingeniería de software se enfrentan ahora a riesgos sin precedentes. Las plataformas de IA generativa, como ChatGPT y sus primos corporativos, analizan contratos, redactan informes e incluso escriben código con una eficiencia que puede rivalizar o superar a los talentos recién graduados (Fuente: fortune.com). El cambio en los patrones de desempleo de los licenciados En 2025, el desempleo entre los estadounidenses de 22 a 27 años con estudios universitarios alcanzó su nivel más alto en cuatro años, llegando al 5,8% (Fuente: fortune.com). Si bien la ralentización de las economías desempeña un papel, la adopción de herramientas impulsadas por la IA para trabajos de nivel inicial está reduciendo rápidamente las oportunidades disponibles. Investigaciones recientes revelan que la tasa de desempleo de los trabajadores más jóvenes en campos expuestos a la tecnología aumentó 3 puntos porcentuales en tan solo unos meses (Fuente: goldmansachs.com). Las perspectivas de los licenciados en diseño gráfico, ingeniería industrial e incluso arquitectura se ven alteradas por la amplia adopción de la IA, según el análisis de J.P. Morgan (Fuente: jpmorgan.com). Cada vez más, los profesionales recién graduados y los licenciados con poca experiencia se encuentran en competencia no sólo con sus compañeros, sino también con algoritmos de aprendizaje automático y sofisticados flujos de trabajo automatizados. A medida que las herramientas de IA se abaratan y son más fáciles de integrar, los puestos de nivel básico se consolidan o eliminan. Sectores industriales más amenazados A nivel mundial, las funciones de apoyo administrativo y entrada de datos son las que corren mayor riesgo de desempleo debido a la IA, con unas tasas de contratación que se desplomarán un 45 % desde 2022 (Fuente: sqmagazine.co.uk). La logística, la fabricación e incluso el comercio minorista están experimentando rápidas reducciones de plantilla a medida que las plataformas de IA dominan procesos que antes requerían escuadrones de trabajadores humanos. En un caso denunciado, un director de logística vio cómo su departamento se reducía de 28 personas a solo cinco en seis meses debido a las actualizaciones del sistema. Los servicios financieros y jurídicos no son inmunes. Gracias a los avances en el procesamiento del lenguaje natural y la automatización, las empresas pueden delegar tareas monótonas y repetitivas, como la auditoría, la supervisión del cumplimiento normativo y el seguimiento de carteras, en sistemas de IA, lo que reduce aún más los puestos de trabajo humanos de nivel básico. Creación de empleo: ¿Realidad o fantasía? Es importante señalar que, a pesar de los titulares sobre el desempleo debido a la IA, no todas las previsiones son pesimistas. El Foro Económico Mundial prevé que 85 millones de puestos de trabajo desaparecerán a finales de 2025 debido a la automatización, especialmente a través de la IA, pero también espera que se creen 97 millones de nuevos puestos (Fuente: sqmagazine.co.uk). La mayoría de ellos en el sector tecnológico: marketing digital, ciberseguridad, desarrollo de software y formación en IA. En Estados Unidos, en 2024 se cubrieron 320.000 nuevos puestos de trabajo dependientes de la IA, muchos de ellos con salarios impresionantes. Sin embargo, este resquicio de esperanza no se distribuye de manera uniforme. Solo el 36% de los trabajadores desplazados en todo el mundo han podido cambiar a nuevas profesiones relacionadas con la IA, lo que revela la persistencia de obstáculos en la reconversión profesional, el reciclaje y el acceso a la educación digital. Los trabajadores de las industrias tradicionales y los de las regiones con menor infraestructura tecnológica se enfrentan a periodos de adaptación más largos y a menos oportunidades nuevas. Tendencias mundiales y déficit de cualificaciones Los efectos del desempleo debido a la IA son más graves en lugares con infraestructuras informáticas avanzadas: Japón, Corea del Sur, Alemania y Estados Unidos registran mayores tasas de desplazamiento que África o América Latina (Fuente : sqmagazine.co.uk). En China, un asombroso 77% de los puestos de trabajo pueden ser susceptibles de automatización. Europa espera perder o transformar fundamentalmente 12 millones de puestos de trabajo en tres años. Al mismo tiempo, el mercado laboral está experimentando un crecimiento explosivo de nuevas especialidades: formadores de Inteligencia Artificial, ingenieros rápidos, supervisores de contenidos digitales y expertos en cumplimiento normativo. Estos puestos no existían hace unos años, pero su demanda está aumentando rápidamente. El reto para

La crisis del ChatGPT-5: La crisis de capacidad de OpenAI y lo que significa para usted

Last Updated on agosto 13, 2025 7:57 pm by Laszlo Szabo / NowadAIs | Published on agosto 13, 2025 by Laszlo Szabo / NowadAIs La crisis del ChatGPT-5: Descifrando la crisis de capacidad de OpenAI y lo que significa para usted – Notas clave Crisis de capacidad confirmada: El anuncio de OpenAI da prioridad a los usuarios existentes y pone en pausa el acceso a nuevas API, lo que indica directamente una grave sobrecarga de la infraestructura debido a la demanda de GPT-5. Estancamiento de la innovación: La congelación de nuevas integraciones de API crea grandes obstáculos para las empresas que crean productos que dependen de la tecnología más avanzada de OpenAI. Ampliación del plazo: Se prevé que el alivio significativo (duplicación del cómputo) lleve ~5 meses, lo que significa que las limitaciones probablemente persistan hasta finales de 2025. Descifrando la crisis del ChatGPT-5 de OpenAI Así es como estamos priorizando la computación en los próximos meses a la luz del aumento de la demanda de GPT-5: 1. En primer lugar, nos aseguraremos de que los actuales usuarios de ChatGPT de pago obtengan más uso total que antes de GPT-5. 2. A continuación, priorizaremos la demanda de API hasta el.. – Sam Altman (@sama) 12 de agosto de 2025 Se suponía que el lanzamiento por parte de OpenAI de GPT-5, la última evolución del modelo de IA más utilizado del mundo, iba a ofrecer respuestas más inteligentes y capacidades más amplias. En lugar de eso, la crisis de ChatGPT-5 llegó en forma de agitación por la infraestructura pública, escasez de capacidad y usuarios frustrados. Detrás de los mensajes amistosos de Sam Altman en las redes sociales, la realidad resultó ser un sistema poco preparado que se esforzaba bajo una demanda inesperada, una campaña de relaciones públicas destinada a calmar a inversores y clientes, y nuevos quebraderos de cabeza para las nuevas empresas que habían construido sus sueños sobre la fiabilidad de OpenAI(thestack.technology). El rompecabezas de las prioridades La actualización de Altman parecía una lista de comprobación para mantener la paz en una crisis. En primer lugar, los usuarios de pago de ChatGPT obtuvieron por fin más uso total, una sutil admisión de que incluso los suscriptores premium habían encontrado los límites demasiado ajustados, especialmente cuando el debut de GPT-5 colapsó los servidores y dejó la plataforma casi inutilizable para muchos. La raíz de la crisis de ChatGPT-5 no tardó en quedar clara: lanzar un modelo masivamente mejorado no basta si la infraestructura subyacente se tambalea ante un aumento de la demanda. Los que dependían de la API no tuvieron mucho consuelo. Las nuevas cuentas de la API se congelaron y OpenAI declaró públicamente que, por el momento, sólo cumpliría los compromisos existentes. Esta interrupción de la escalada rápida afectó duramente a las nuevas empresas de IA, obligándolas a reconsiderar sus planes de productos o a buscar alternativas como Anthropic, Mistral o Cohere, empresas preparadas para recoger a los fundadores decepcionados que la crisis del ChatGPT-5 había dejado en la estacada(fortune.com). Usuarios gratuitos: Los últimos de la cola La afirmación de Altman de “aumentar la calidad del nivel gratuito” aparecía en su lista de prioridades sólo después de las afiliaciones de pago y el cumplimiento de los contratos API. En realidad, los usuarios gratuitos de ChatGPT se vieron relegados a un segundo plano y sólo vieron mejoras cuando todos los demás públicos quedaron satisfechos. Muchos interpretaron este movimiento como poco más que una fachada de relaciones públicas, sin una definición clara de lo que significaba “calidad” para los usuarios habituales. ¿Se trataba de un razonamiento más sólido? ¿Respuestas más rápidas? Nadie estaba seguro, y OpenAI no ofreció detalles para aclarar la promesa(datastudios.org). Falta de capacidad y cuellos de botella en la infraestructura El meollo de la crisis de ChatGPT-5 es la infraestructura. OpenAI subestimó la presión que ejercería GPT-5, lo que provocó cortes y un fuerte racionamiento de recursos. Durante las primeras 24 horas, el tráfico de la API se duplicó, con un aumento de la demanda de “modelos de razonamiento” entre los usuarios premium. El hecho de que Altman admitiera que la capacidad de cálculo sólo se duplicaría en unos cinco meses, es decir, a finales de 2025, supuso un mensaje aleccionador para todos los que apuestan por la innovación rápida en IA(thestack.technology). Los proyectos que se pongan en marcha a corto plazo pueden verse atrapados en atascos o verse obligados a desarrollar planes de reserva, y ahí es donde los modelos alternativos encuentran su ventaja competitiva. Este déficit de infraestructura no era puramente técnico. Representó un error de cálculo en la dinámica del mercado, un recordatorio de que predecir los picos de uso en lanzamientos innovadores sigue siendo un juego de adivinanzas. Aunque Altman se apresuró a prometer transparencia y a esbozar la toma de decisiones de OpenAI, los usuarios vieron un caso clásico de control de daños en lugar de una hoja de ruta de desarrollo audazworded.com. La Edad de Hielo de las API: las startups apuestan por otra cosa Para muchas startups, la crisis de ChatGPT-5 hizo que la plataforma pasara de ser “imprescindible” a “poco fiable”. Con las nuevas cuentas de API sin prioridad -y los desarrolladores esperando meses para acceder a ellas- hay un cambio palpable hacia competidores que pueden prometer una incorporación inmediata. La incapacidad de ampliar rápidamente los productos basados en IA merma la posición de OpenAI como socio de referencia para la innovación ágil. Este cuello de botella no sólo favorece a los rivales, sino que socava la confianza en la estabilidad y apertura de la hoja de ruta de OpenAI(ai-supremacy.com). Incluso entre los socios existentes hay tensiones. Los desarrolladores que ya han firmado contratos deben esperar que sus asignaciones sigan siendo suficientes para proyectos ambiciosos o, de lo contrario, enfrentarse a una nueva ronda de retrasos y soluciones. La crisis del ChatGPT-5 ha convertido la planificación de contingencias y la evaluación de riesgos en un elemento permanente del desarrollo de productos de IA. En los foros de desarrolladores circula el

El efecto de ChatGPT-5: un nuevo capítulo para la IA

Last Updated on agosto 11, 2025 12:42 pm by Laszlo Szabo / NowadAIs | Published on agosto 11, 2025 by Laszlo Szabo / NowadAIs El efecto de ChatGPT-5: un nuevo capítulo para la IA – Notas clave El efecto de ChatGPT-5 se mide en respuestas más inteligentes y rápidas, menos fabricaciones y una integración más profunda con las empresas y la sociedad. Sus caacterísticas innovadoras, como nuevas personalidades, codificación mejorada y tareas de agente, convierten a ChatGPT-5 en una fuerza central en el trabajo, el aprendizaje y la vida cotidiana. Aunque ha sido aclamado por su impacto positivo en la velocidad y la seguridad, el efecto de ChatGPT-5 suscita el debate en torno a la salud mental, la perturbación económica y los futuros puntos de referencia. ChatGPT-5: la nueva frontera La IA lleva mucho tiempo prometiendo mejoras para los negocios, la educación y la vida cotidiana, pero el efecto de ChatGPT-5 marca un poderoso salto en la forma en que estas expectativas dan forma a la realidad. Ya se trate de programar una nueva aplicación, preparar exámenes o navegar por Internet, el efecto de ChatGPT-5 se deja sentir en innumerables flujos de trabajo digitales, suscitando debates sobre su impacto futuro, su seguridad y lo que logrará la próxima oleada de máquinas inteligentes. ¿Qué diferencia a ChatGPT-5? Cuando OpenAI lanzó GPT-5, los titulares lo declararon más rápido, más inteligente y preparado para ofrecer orientación de nivel experto a cualquier persona con una conexión Wi-Fi. Uno de los principales efectos de ChatGPT-5 es su destreza en tareas académicas -matemáticas, codificación e incluso preguntas médicas-, superando los puntos de referencia con puntuaciones que rivalizan con las de auténticos expertos (Fuente: openai.com). Altman, consejero delegado de OpenAI, describió GPT-5 como el tipo de modelo que cabría esperar de un especialista con doctorado en lugar de un estudiante universitario(Fuente: bbc.com). Todos los usuarios de ChatGPT tienen ahora acceso incorporado a GPT-5 por defecto, lo que significa que ya no hay que alternar entre versiones para distintos tipos de preguntas. El efecto de ChatGPT-5 se percibe a través de un “sistema único de cambio automático” que combina los puntos fuertes anteriores en una experiencia cohesiva. Para las empresas, las funciones avanzadas de la API facilitan la toma de decisiones y la colaboración, y las principales empresas integran ChatGPT-5 para aumentar la precisión y la calidad de sus equipos (Fuente: openai.com). Un chatbot más inteligente y seguro Un efecto bien documentado de ChatGPT-5 es la disminución de las famosas “alucinaciones”, un término para cuando la IA inventa respuestas plausibles pero incorrectas. Las pruebas internas de OpenAI sugieren que ChatGPT-5 tiene un 45% menos de probabilidades de inventar hechos que GPT-4o, y alrededor de un 80% menos que los modelos anteriores cuando utiliza su modo “pensar” (fuentes: mashable.com fortune.com). Aunque las imperfecciones persisten, los usuarios -especialmente los que abordan temas delicados de salud mental o técnicos- pueden esperar consejos más transparentes cuando el chatbot no pueda responder a una pregunta. Las mejoras de seguridad no acaban ahí. El efecto de ChatGPT-5 también se deja sentir en su formación para el rechazo, que es más matizada que antes. Ahora, si una pregunta se topa con problemas de privacidad o con un territorio peligroso, ChatGPT-5 ofrece una negativa suave y sugiere formas más seguras de proceder (Fuente: openai.com). Este cambio es crucial para estudiantes, desarrolladores y cualquiera que confíe en la orientación de la IA para tareas del mundo real. Unificar las personalidades y el toque humano La experiencia del usuario es otro ámbito en el que se nota el efecto de ChatGPT-5. OpenAI ha introducido cuatro personalidades únicas para las respuestas de texto -Oyente, Empollón, Cínico y Robot- para que cualquiera que utilice ChatGPT pueda seleccionar el estilo que mejor se adapte a su estado de ánimo o proyecto (Fuente: theverge.com). Este ajuste hace que las interacciones del bot sean más atractivas y adecuadas al contexto, tanto si lo que buscas es ingenio seco como respuestas precisas. Más allá de las personalidades, el efecto de ChatGPT-5 se aprecia en cómo escribe: ensayos, discursos y poemas con mayor profundidad y ritmo literarios. Para los creadores digitales, los escritores académicos y los profesionales de la empresa, esto significa un acceso más fácil a textos pulidos y auténticos. El impacto empresarial y económico El efecto de ChatGPT-5 repercute en toda la mano de obra mundial. Empresas que van desde gigantes de las finanzas a nuevas empresas de software ya han acogido con satisfacción el modelo de automatización mejorada, investigación potente y comunicación racionalizada (Fuente: openai.com). Con 700 millones de usuarios semanales, ChatGPT-5 es fundamental para la forma en que se produce el trabajo del conocimiento, permitiendo a los profesionales centrarse en tareas de alto riesgo con mayor fiabilidad. Las organizaciones que utilizan la IA a menudo informan de aumentos de productividad, reducción de errores y resultados más rápidos. El efecto de ChatGPT-5 ha sido “un mejor trabajo navegando por la ambigüedad cuando el contexto importa”, según los comentarios de las empresas médicas y tecnológicas que lo probaron en sus inicios (Fuente: openai.com). Codificación, productividad y capacidades agenticas Un área en la que ChatGPT-5 brilla realmente es en su capacidad de codificación. Los informes destacan su velocidad y habilidad para crear aplicaciones, resolver complejos retos de programación e iterar rápidamente en función de los comentarios de los usuarios (Fuente: cnet.com). Tanto los desarrolladores como los aficionados se benefician de la codificación vibrante, ya que pueden crear sitios web, aplicaciones y juegos con una sola pulsación, lo que facilita la creación de prototipos y la iteración creativa. Las capacidades agenticas de GPT-5 también aumentan la productividad, ya que se integra con Gmail, Calendar y otras herramientas para automatizar la programación, los recordatorios y la mensajería, funciones que los usuarios de pago de ChatGPT pueden aprovechar para tareas personales y profesionales (Fuente: fortune.com). El factor humano: Salud mental y sociedad Más allá del trabajo y el ocio, el efecto de ChatGPT-5 se extiende a la vida personal. Algunos usuarios informan de “despertares espirituales” tras

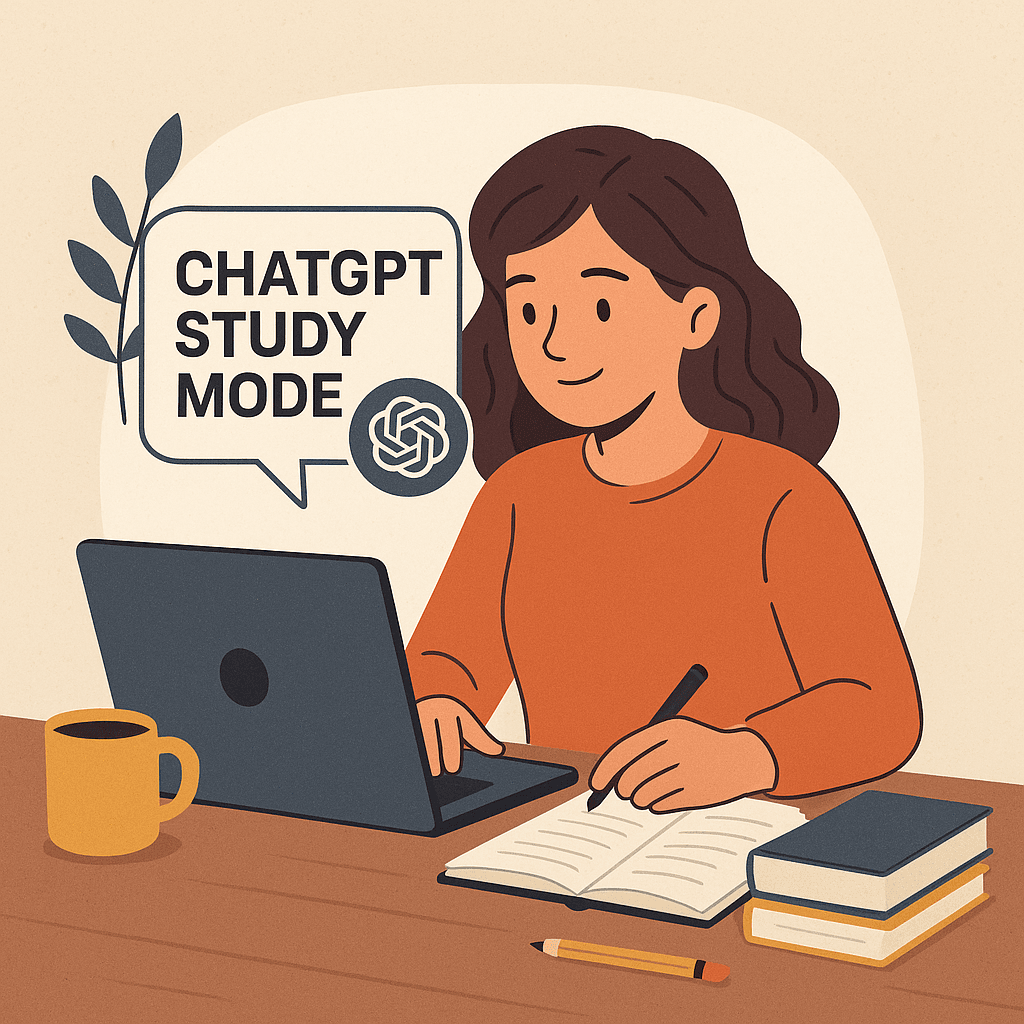

Qué es el modo de estudio ChatGPT y por qué es importante

Last Updated on agosto 9, 2025 12:25 pm by Laszlo Szabo / NowadAIs | Published on agosto 9, 2025 by Laszlo Szabo / NowadAIs Qué es el modo de estudio ChatGPT y por qué es importante – Notas clave El modo de estudio ChatGPT ofrece orientación paso a paso y apoyo personalizado, centrándose en un aprendizaje más profundo en lugar de proporcionar respuestas instantáneas. La herramienta adapta las sesiones en función de tus objetivos, tu nivel de habilidad y tu historial de estudio, haciendo que las sesiones sean interactivas y personalizadas. Construido utilizando principios de la ciencia del aprendizaje, el Modo de Estudio ChatGPT fomenta el pensamiento crítico y desarrolla gradualmente la experiencia a través de cuestionarios, retroalimentación abierta y andamiaje. Qué es el modo de estudio ChatGPT y por qué es importante El aprendizaje sin esfuerzo se ha convertido en un tema candente con la introducción del Modo de Estudio ChatGPT. Diseñado para apoyar el desarrollo genuino de habilidades, el Modo de Estudio ChatGPT te lleva más allá de la simple recuperación de respuestas. En lugar de limitarse a decirte lo que quieres saber, te guía a través de tus deberes, la preparación de exámenes y los conceptos complicados con una guía interactiva y comentarios alentadores. Tanto si eres un estudiante universitario luchando con el cálculo, un estudiante de secundaria preparándose para la biología, o simplemente curioso acerca de un nuevo tema, esta función está destinada a ayudarle a aprender más profundamente y reflexivamente. ¿Qué hace diferente al modo de estudio ChatGPT? La mayoría de los asistentes digitales proporcionan respuestas instantáneas, a menudo sin contexto ni enseñanza. El Modo Estudio de ChatGPT pretende cambiar este patrón. Cuando activas el Modo Estudio, ChatGPT inicia una conversación haciéndote preguntas sobre tus objetivos y tu nivel de habilidad. Se entera de en qué estás trabajando y adapta sus respuestas a tu situación particular. Te anima a razonar los problemas, aplicar tus propios conocimientos y recibir consejos personalizados. La experiencia se parece más a sentarse con un tutor personal que a navegar por una típica plataforma de preguntas y respuestas. Este estilo interactivo es el resultado de la colaboración entre ingenieros de IA, educadores y expertos en aprendizaje. El Modo Estudio se basa en instrucciones personalizadas elaboradas con la ayuda de profesores y científicos, todo ello con el objetivo de favorecer una verdadera comprensión en lugar de un nivel superficial (fuente: OpenAI Study Mode). Entre sus características se incluyen preguntas de estilo socrático, andamiaje, personalización basada en la memoria y comentarios procesables. ¿Cómo funciona el modo de estudio ChatGPT? Activar el Modo Estudio de ChatGPT es muy sencillo: busca la opción “Estudiar y aprender” en el menú de herramientas cuando utilices ChatGPT. En cuanto esté activada, la plataforma empezará a preguntarte por tu tarea, tu nivel, tu experiencia con el tema y cualquier objetivo inmediato, como la fecha de un examen o un concepto complicado. En lugar de volcar toda la información de una vez, el modo de estudio de ChatGPT te guía paso a paso. Puedes empezar con preguntas básicas sobre un concepto de biología y, a medida que demuestres lo que sabes, la sesión se irá profundizando gradualmente. Si te quedas atascado, el asistente te pedirá que pienses o te sugerirá pistas útiles sin darte inmediatamente la respuesta. Si subes materiales -como imágenes de libros de texto, archivos PDF o tus propios apuntes- ChatGPT los utiliza para adaptar su orientación (Fuente: OpenAI FAQ). El modo Memoria añade otro nivel. Cuando está activado, el asistente recuerda tu historial de estudio y adapta las sesiones futuras en función de lo que ya sabes. Si, por ejemplo, tienes problemas a menudo con las pruebas de geometría, seguirá reforzando los conceptos fundamentales hasta que te sientas más seguro. La pedagogía detrás de esta función La columna vertebral del modo de estudio ChatGPT se basa en la ciencia del aprendizaje. En lugar de dejar que los estudiantes eviten el aprendizaje por esfuerzo, gestiona la carga cognitiva con trozos pequeños y digeribles. El pensamiento crítico y la autorreflexión están integrados, fomentando la curiosidad y la participación(Fuente: Education Week). Cada sesión es personalizada, de modo que tanto si eres principiante como avanzado, tus objetivos de aprendizaje guían la conversación. Otro rasgo distintivo es el feedback personalizado. ChatGPT plantea preguntas abiertas para comprobar tu comprensión, lo que dificulta la absorción pasiva del material. Te empujan a explicarte con tus propias palabras, a desglosar temas difíciles e incluso a preguntarte sobre la marcha. Esta “fricción activa” fomenta la retención y la comprensión profunda. Ayuda con los deberes, preparación de exámenes y mucho más Uno de los usos más populares del modo de estudio ChatGPT es la ayuda con los deberes. En lugar de limitarse a darte la respuesta, te va guiando paso a paso. Digamos que estás trabajando en un problema de matemáticas: ChatGPT te pregunta qué fórmulas podrían aplicarse, qué sabes ya y dónde estás atascado. Si pides pistas, te las da, pero sólo te da la respuesta final si se la pides. La preparación de exámenes también se beneficia de este método. Al practicar repetidamente preguntas y conceptos, los alumnos se sienten preparados para los exámenes a su manera. El estilo conversacional facilita la identificación de los puntos débiles sin sentirse abrumado. Para los temas nuevos, el modo de estudio ChatGPT puede ser especialmente valioso. Tanto si se trata de comprender los bucles de retroalimentación positiva y negativa en biología como de lidiar con la teoría económica avanzada, el alumno es guiado gradualmente. ChatGPT establece conexiones entre las nuevas ideas y lo que has estudiado antes, haciendo que el viaje de aprendizaje sea más suave. Uso en la vida real y experiencia personal Los usuarios han ofrecido comentarios elogiosos sobre el Modo de Estudio ChatGPT en las redes sociales y foros en línea (fuente: Reddit). Muchos dicen que transforma el proceso de aprendizaje en algo más atractivo y menos intimidante. Una de las ventajas más citadas es que la plataforma está dispuesta a ajustar la dificultad. Si

La avanzada suite de video AI de Alibaba

El resumen: El Laboratorio Tongyi de Alibaba acaba de lanzar Wan2.1, un conjunto de potentes modelos de generación de video de código abierto que superan a los modelos SOTA de código abierto y cerrado como Sora en métricas clave, mientras generan videos a 2.5 veces la velocidad. Los detalles: Wan2.1-T2V-14B encabeza la tabla de líderes de VBench, destacándose en áreas como la dinámica de movimiento complejo, la simulación de física del mundo real y la generación de texto. Todos los modelos admiten texto a video, imagen a video y video a audio, y son los primeros con la capacidad de representar texto en inglés y chino. Las herramientas de edición de Wan incluyen inpainting y outpainting de video, referencia de múltiples imágenes y la capacidad de mantener estructuras y personajes existentes. La versión lanzada también incluye una versión ligera de 1.3B capaz de funcionar en hardware de consumo: puede generar un clip de 5 segundos en 480P en una RTX 4090 en 4 minutos. Por qué es importante: otro día, otro sorprendente lanzamiento de código abierto de China. Wan es una continuación de la calidad acelerada que hemos visto en lanzamientos recientes como el Veo 2 de Google, con signos evidentes de IA (movimiento entrecortado, artefactos, etc.) prácticamente eliminados. Entre Qwen y Wan, Alibaba está trayendo el calor del código abierto en 2025.

Lo último en tecnología AI Text-to-Video: Explicación de Step-Video-T2V

Last Updated on febrero 26, 2025 1:45 pm by Laszlo Szabo / NowadAIs | Published on febrero 26, 2025 by Laszlo Szabo / NowadAIs Sección de notas clave Compresión eficiente y alta fidelidad: Step-Video-T2V utiliza una compresión profunda Video-VAE para lograr una relación de compresión espacial de 16×16 y temporal de 8×, manteniendo al mismo tiempo salidas de vídeo claras y detalladas. Capacidad en dos idiomas: El modelo procesa texto tanto en inglés como en chino con dos codificadores de texto independientes, lo que aumenta su accesibilidad y utilidad global. Generación de vídeo mejorada: Mediante la integración de un DiT con atención plena 3D y una optimización de preferencia directa basada en vídeo, Step-Video-T2V produce secuencias de vídeo coherentes y fluidas con artefactos mínimos. Introducción Step-Video-T2V es un sofisticado modelo de conversión de texto a vídeo que ha captado el interés de desarrolladores e investigadores por igual. Este modelo cuenta con 30.000 millones de parámetros y es capaz de generar vídeos de hasta 204 fotogramas. Su diseño ofrece una mayor eficiencia tanto en el entrenamiento como en la inferencia, al tiempo que garantiza una reconstrucción de vídeo de alta calidad. Puede consultar más detalles en el repositorio de GitHub y en el informe técnico de arXiv. Arquitectura y funcionalidad del modelo https://www.nowadais.com/wp-content/uploads/2025/02/Latest-in-AI-Text-to-Video-Technology-Step-Video-T2V-Explained.mp4 En su núcleo, Step-Video-T2V emplea un autocodificador variacional de compresión profunda (Video-VAE) que logra una relación de compresión espacial de 16×16 y temporal de 8×. Este enfoque minimiza la carga computacional y mantiene una excelente calidad de vídeo en todos los fotogramas. Dos codificadores de texto bilingües procesan las indicaciones del usuario en inglés y chino, lo que aumenta la versatilidad y el atractivo global del modelo. Más información en Analytics Vidhya. El modelo también integra un transformador de difusión (DiT) con atención plena 3D para transformar el ruido en fotogramas de vídeo latentes. Este mecanismo condiciona el proceso de generación tanto a las incrustaciones de texto como a la información de los pasos temporales, garantizando que la salida se ajuste estrechamente a la descripción de entrada. Además, Step-Video-T2V emplea un enfoque de Optimización de Preferencia Directa (DPO) basado en vídeo para reducir los artefactos visuales, lo que resulta en salidas de vídeo más suaves y coherentes. Descubra más detalles sobre sus capacidades de inferencia en Replicate. Características principales Step-Video-T2V se distingue por varias características dignas de mención. En primer lugar, su Video-VAE proporciona una compresión de datos eficaz que preserva los detalles visuales críticos. En segundo lugar, la capacidad de codificación de texto en dos idiomas permite manejar con solidez diversas entradas de usuario. En tercer lugar, el uso de un DiT con atención plena 3D mejora la continuidad del movimiento entre fotogramas. Por último, el OPD basado en vídeo del modelo refina el contenido generado, garantizando que los vídeos producidos sean naturales y claros. Para una visión más detallada, visite el sitio web oficial. Rendimiento y evaluación Step-Video-T2V ha sido rigurosamente evaluado en un benchmark específico conocido como Step-Video-T2V-Eval. Esta prueba mide el rendimiento del modelo en varios criterios, como la suavidad del movimiento, el cumplimiento de los plazos y la fidelidad general del vídeo. La evaluación indica que Step-Video-T2V ofrece un alto nivel de rendimiento en comparación con los motores de generación de vídeo comerciales y de código abierto. Los resultados de las pruebas y otras referencias pueden consultarse en páginas relacionadas, como Turtles AI. Además, el modelo demuestra un rendimiento estable incluso en escenarios complejos de generación de vídeo. Su arquitectura está diseñada para manejar secuencias largas sin comprometer la claridad o consistencia del resultado. Este equilibrio entre eficiencia computacional y calidad del resultado es un factor clave para su creciente adopción entre los creadores de contenidos de vídeo y los profesionales de la IA. Aplicaciones y casos de uso Step-Video-T2V tiene aplicaciones prácticas en varios campos. Los creadores de contenidos pueden utilizar este modelo para generar secuencias de vídeo dinámicas a partir de descripciones de texto, lo que supone una nueva herramienta para la narración de historias y las presentaciones multimedia. Los educadores y los profesionales del marketing también encuentran valioso el modelo para crear vídeos instructivos y contenidos digitales atractivos. La facilidad de adaptación del modelo a varios idiomas y su sólido rendimiento a la hora de generar narraciones de vídeo coherentes hacen de Step-Video-T2V una opción atractiva para una amplia gama de proyectos. El modelo está diseñado para su uso en entornos con elevados requisitos de memoria de la GPU, que suelen utilizar GPU NVIDIA con considerable VRAM. A pesar de esta demanda de hardware, su canal de inferencia optimizado garantiza que el proceso de generación sea eficiente y fácil de utilizar. Este equilibrio entre los requisitos de hardware y la calidad del resultado convierte a Step-Video-T2V en una herramienta práctica tanto para la investigación académica como para proyectos comerciales. Perspectivas de futuro Step-Video-T2V sienta las bases para nuevos avances en la generación de texto a vídeo. Los investigadores siguen explorando métodos para potenciar la dinámica de movimiento y mejorar la eficiencia de los recursos. A medida que más desarrolladores integren este modelo en sus flujos de trabajo, se espera que surjan nuevas optimizaciones y mejoras. Con las continuas contribuciones de la comunidad de código abierto, Step-Video-T2V está llamado a desempeñar un papel importante en la evolución de la tecnología de síntesis de vídeo con IA. A lo largo de esta exploración, el término Step-Video-T2V aparece constantemente como foco central, subrayando el impacto del modelo en el campo de la generación de texto a vídeo. Su diseño integral y sus prestaciones lo convierten en un tema de interés para cualquiera que se dedique a la creación de contenidos digitales y a la investigación de la IA. Sección de definiciones Step-Video-T2V: un modelo de conversión de texto a vídeo de última generación con 30.000 millones de parámetros diseñado para generar vídeos a partir de indicaciones textuales. Video-VAE: Autocodificador variacional especializado en la compresión eficaz de datos de vídeo, utilizado en Step-Video-T2V para reducir las dimensiones espaciales y temporales preservando la calidad.