estudio de juegos de xAI: La búsqueda de Elon Musk para “hacer que los juegos vuelvan a ser grandes”

Last Updated on febrero 19, 2025 2:02 pm by Laszlo Szabo / NowadAIs | Published on febrero 19, 2025 by Laszlo Szabo / NowadAIs estudio de juegos de xAI: La búsqueda de Elon Musk para “hacer que los juegos vuelvan a ser grandes” – Notas clave Visión: Musk pretende alterar los juegos dominados por las empresas con herramientas de IA para desarrolladores independientes, haciendo hincapié en la creatividad por encima de la política “woke” La tecnología: Grok 3, el modelo avanzado de IA de xAI, impulsa la narración adaptativa, el comportamiento de los PNJ y la generación de activos, aunque sigue habiendo desafíos éticos y técnicos Desafíos: El escepticismo sobre la credibilidad de Musk, los límites creativos de la IA y los largos ciclos de desarrollo podrían dificultar el éxito del estudio ¿Por qué xAI’s Gaming Studio? La visión de Musk Elon Musk no es ajeno a las afirmaciones audaces, y su anuncio del xAI’s Gaming Studio no es una excepción. El consejero delegado de Tesla y SpaceX ha declarado que la iniciativa “hará que los juegos vuelvan a ser geniales”, atacando lo que él llama el estado dominado por las empresas y excesivamente politizado de los juegos modernos(1) (4). La frustración de Musk se centra en los estudios AAA propiedad de conglomerados que, según él, priorizan los beneficios sobre la creatividad y diluyen el atractivo de los juegos(5) (10). Hay que hacerlo. Que los videojuegos vuelvan a ser grandes! https://t.co/IyWQQQlVAF – Elon Musk (@elonmusk) 17 de febrero de 2025 ¿La misión del estudio? Dotar a los desarrolladores independientes y a los equipos más pequeños de herramientas de IA que rivalicen con las de las grandes corporaciones(2) (11). Musk imagina juegos en los que las narrativas impulsadas por la IA se adapten a las elecciones de los jugadores, los PNJ aprendan de las interacciones y los mundos evolucionen dinámicamente, algo muy distinto de los actuales títulos guionizados y formulistas(11). Pero hay un matiz: se ha cuestionado la credibilidad de Musk en el mundo de los videojuegos. Los críticos apuntan a su confesión de haber contratado a entrenadores para mejorar su clasificación en Diablo 4 y Path of Exile216. Los escépticos se preguntan si un hombre que juega a Diablo 4 y Path of Exile216 puede ser un buen jugador. Los escépticos se preguntan si un hombre que subcontrata juegos puede dirigir un estudio. Sin embargo, el historial de Musk -desde Tesla hasta SpaceX- sugiere que está dispuesto a apostar a lo grande en proyectos lunares, aunque empiecen siendo quimeras(1) (4). La tecnología detrás del bombo: Grok 3 y la magia de la IA El núcleo del Gaming Studio de xAI es Grok 3, el último modelo de IA de la empresa. Calificada de “terroríficamente inteligente”, Grok 3 supuestamente supera a rivales como GPT-4 y Google Gemini en tareas matemáticas, de codificación y creativas35. Durante su demostración de lanzamiento, Grok 3 incluso conceptualizó un híbrido de Tetris y Puyo Puyo, unpeculiar ejemplo de su potencial generativo(3). El estudio planea utilizar Grok 3 para todo, desde el diseño de argumentos adaptables hasta la generación de recursos para el juego. Por ejemplo, los PNJ podrían analizar el comportamiento del jugador para ofrecerle un diálogo personalizado, mientras que los entornos procedimentales podrían cambiar en función de las decisiones en tiempo real11. El equipo de Musk también apunta a herramientas de desarrollo asistidas por IA que podrían reducir drásticamente el tiempo de producción y permitir a los pequeños estudios dar un salto cualitativo(2) (5). Pero el papel de la IA en los juegos sigue siendo polémico. Mientras algunos alaban su eficiencia, otros temen una creatividad homogeneizada o problemas éticos, como contenidos generados por IA que refuercen los prejuicios(1) (11). Musk, sin embargo, insiste en que el diseño “buscador de la verdad” de Grok 3 dará prioridad a la diversión inmersiva sobre la corrección política(3) (5) Retos y controversias El dinero manda, pero el éxito no está garantizado. el Gaming Studio de xAI se enfrenta a diversos obstáculos, desde el escepticismo de la industria hasta la controvertida reputación de Musk. Los grandes estudios han tachado de artificioso el contenido generado por IA, y los jugadores suelen rechazar las críticas “woke” por considerarlas fuera de lugar(1) (10). Incluso los fans de Musk se preguntan si invertir dinero en los desarrolladores -según los informes, ofrece el cuádruple de los salarios de la industria- puede replicar la magia de los estudios impulsados por la pasión(1). Luego está la montaña técnica. Entrenar modelos de IA requiere recursos colosales, y el superordenador “Colossus” de xAI -una bestia de 200.000 GPU- es sólo el principio(5). Aunque los puntos de referencia de Grok 3 son impresionantes, el diseño de juegos en el mundo real exige matices. Por ejemplo, las primeras pruebas revelaron los problemas de Grok 3 con el humor y la exactitud de los hechos(3). Y no olvidemos el tiempo. Los juegos AAA tardan años en desarrollarse, y el estudio de Musk aún tiene que anunciar un solo título. Para cuando lance su primer proyecto, el panorama de los juegos -y de la tecnología de IA- podría ser muy distinto(1) (4). ¿Qué le espera al estudio de juegos xAI? A pesar de los retos, xAI’s Gaming Studio ha cobrado impulso. El anuncio de Musk coincidió con el lanzamiento de Grok 3, al que ya pueden acceder los suscriptores Premium de X (antes Twitter)(3) (5). El estudio también se beneficia de la ronda de financiación de 10.000 millones de dólares de xAI y de las asociaciones con redes de juegos blockchain como Xai, que alberga títulos como TollanSurvivors89. De cara al futuro, el estudio podría centrarse en géneros en los que brilla la IA, como los RPG de mundo abierto o los juegos de estrategia. El amor de Musk por Civilization y Diablo podría inspirar proyectos híbridos que combinen la generación procedural con un profundo conocimiento(6) (10). Que el Gaming Studio de xAI se convierta en un pionero o en un cuento con moraleja dependerá de la ejecución. Pero una cosa está

Corea del Sur prohíbe Deepseek: Lo que hay que saber

Last Updated on febrero 17, 2025 1:40 pm by Laszlo Szabo / NowadAIs | Published on febrero 17, 2025 by Laszlo Szabo / NowadAIs Corea del Sur prohíbe Deepseek: Lo que hay que saber – Sección de notas clave Corea del Sur prohíbe Deepseek: La aplicación ha sido bloqueada de las tiendas de aplicaciones locales debido a preocupaciones sobre la privacidad de los datos y la seguridad nacional. Problemas de privacidad de datos: Las prácticas de recopilación de datos de Deepseek, incluida la transmisión de datos de los usuarios al extranjero, han hecho saltar las alarmas. Impacto mundial: La prohibición podría influir en otros países para imponer normas más estrictas a las aplicaciones extranjeras. Corea del Sur prohíbe Deepseek: Lo que hay que saber Corea del Sur ha dado recientemente un gran paso al bloquear las descargas de la popular aplicación Deepseek en las tiendas de aplicaciones locales. Esta decisión ha suscitado debates sobre la privacidad de los datos, la seguridad nacional y la regulación de las aplicaciones extranjeras. A continuación analizaremos los motivos de la prohibición, sus implicaciones y lo que significa para usuarios y desarrolladores. ¿Por qué Corea del Sur ha prohibido Deepseek? El gobierno de Corea del Sur ha citado la preocupación por la privacidad de los datos y la seguridad nacional como las principales razones para prohibir Deepseek. Las autoridades afirman que la aplicación recopila y transmite datos de los usuarios a servidores situados fuera del país, lo que hace temer el acceso no autorizado y el uso indebido de información sensible. Deepseek, una aplicación de LLM muy utilizada, también ha sido objeto de escrutinio en otros países. Sin embargo, la decisión de Corea del Sur de bloquearla por completo de las tiendas de aplicaciones supone una notable escalada en la acción reguladora. Preocupación por la privacidad de los datos Uno de los principales problemas señalados por las autoridades surcoreanas son las prácticas de recopilación de datos de Deepseek. Los informes sugieren que la aplicación recopila gran cantidad de datos de los usuarios, incluida información sobre su ubicación, detalles del dispositivo y hábitos de navegación. Estos datos se envían a servidores extranjeros, lo que puede ponerlos en manos de gobiernos extranjeros o terceros. Corea del Sur tiene leyes estrictas de protección de datos, y el gobierno ha expresado su preocupación de que las prácticas de Deepseek puedan violar estas normas. Al prohibir la aplicación, las autoridades pretenden proteger la información personal de los ciudadanos para que no sea explotada o utilizada indebidamente. Implicaciones para la seguridad nacional Más allá de la privacidad de los datos, la decisión de Corea del Sur también obedece a motivos de seguridad nacional. El país tiene un historial de ciberataques y violaciones de datos, a menudo relacionados con entidades extranjeras. Permitir que una aplicación como Deepseek funcione sin una supervisión estricta podría plantear riesgos para las infraestructuras críticas y los sistemas gubernamentales. La prohibición refleja una tendencia más amplia de los gobiernos de todo el mundo a examinar más de cerca las aplicaciones extranjeras y su posible impacto en la seguridad nacional. La medida de Corea del Sur se suma a otras similares adoptadas por otros países para proteger sus ecosistemas digitales. Impacto en usuarios y desarrolladores Para los usuarios de Corea del Sur, la prohibición significa que ya no podrán descargar ni actualizar Deepseek desde las tiendas de aplicaciones locales. Los que ya tengan instalada la aplicación podrán seguir utilizándola, pero su funcionalidad podría verse limitada con el tiempo. Los desarrolladores de Deepseek se enfrentan ahora al reto de responder a las preocupaciones de Corea del Sur si desean recuperar el acceso al mercado. Esto podría implicar la revisión de las prácticas de recopilación de datos, la mejora de la transparencia o la colaboración con las autoridades locales para garantizar el cumplimiento de la normativa. Implicaciones mundiales La decisión de Corea del Sur de prohibir Deepseek podría tener repercusiones más allá de sus fronteras. Otros países podrían seguir su ejemplo, especialmente si surgen preocupaciones similares sobre la privacidad y la seguridad de los datos. Esto podría llevar a un mayor escrutinio de las aplicaciones extranjeras y a regulaciones más estrictas en todo el mundo. Para las empresas tecnológicas, la prohibición sirve como recordatorio de la importancia de cumplir las leyes locales y generar confianza entre los usuarios. A medida que los gobiernos se vuelven más vigilantes en materia de protección de datos, aplicaciones como Deepseek tendrán que dar prioridad a la transparencia y la rendición de cuentas. Sección de definiciones Deepseek: Una popular app conocida por [inserte la funcionalidad de la app, por ejemplo, “recomendaciones personalizadas” o “análisis de datos”]. Privacidad de los datos: La protección de la información personal contra el acceso no autorizado o el uso indebido. Seguridad nacional: Medidas adoptadas por un país para protegerse de las amenazas, incluidos los ciberataques y las violaciones de datos. App Store: Plataforma digital en la que los usuarios pueden descargar y actualizar aplicaciones para sus dispositivos. Preguntas más frecuentes (FAQ) 1. ¿Por qué Corea del Sur prohibió Deepseek? Corea del Sur prohibió Deepseek debido a la preocupación por la privacidad de los datos y la seguridad nacional. Las prácticas de recopilación de datos de la aplicación, incluida la transmisión de información de los usuarios al extranjero, se consideraron un riesgo para la información personal de los ciudadanos y la infraestructura digital del país. 2. ¿Pueden los usuarios de Corea del Sur seguir accediendo a Deepseek? Aunque los usuarios actuales pueden seguir utilizando Deepseek, las nuevas descargas y actualizaciones se han bloqueado en las tiendas de aplicaciones locales. Con el tiempo, la funcionalidad de la aplicación puede verse limitada. 3. ¿Qué significa esta prohibición para otros países? La prohibición podría animar a otros países a examinar más de cerca las aplicaciones extranjeras, lo que podría dar lugar a normativas más estrictas y acciones similares contra las aplicaciones que planteen riesgos para la privacidad o la seguridad de los datos. source

Eric Schmidt: el uso indebido de la IA supone un riesgo extremo

Last Updated on febrero 17, 2025 10:19 am by Laszlo Szabo / NowadAIs | Published on febrero 17, 2025 by Laszlo Szabo / NowadAIs Eric Schmidt: El uso indebido de la IA plantea un riesgo extremo – Sección de notas clave Advertencia deEric Schmidt sobrela IA: Eric Schmidt, ex consejero delegado de Google, advierte de que el mal uso de la IA supone un “riesgo extremo” para la sociedad, y subraya la necesidad de un desarrollo y un uso responsables. Riesgos del mal uso de la IA: Entre los principales peligros se encuentran las amenazas a la ciberseguridad, la militarización de la IA, los prejuicios y la discriminación, y el desplazamiento de puestos de trabajo. Estrategias de mitigación: Medidas proactivas como la regulación, la colaboración, la investigación sobre la seguridad de la IA y la educación pública son esenciales para hacer frente a estos riesgos. Centrarse en el uso indebido de la IA La inteligencia artificial (IA) es una de las tecnologías más transformadoras de nuestro tiempo, pero también conlleva riesgos significativos. Eric Schmidt, ex consejero delegado de Google y figura destacada de la industria tecnológica, ha advertido de que el uso indebido de la IA podría suponer un “riesgo extremo” para la sociedad. En este artículo analizaremos las preocupaciones de Schmidt, los peligros potenciales del mal uso de la IA y lo que se puede hacer para mitigar estos riesgos. ¿Quién es Eric Schmidt? Eric Schmidt es un nombre muy conocido en el mundo de la tecnología. Fue consejero delegado de Google de 2001 a 2011 y más tarde presidente ejecutivo de Alphabet Inc, la empresa matriz de Google. Schmidt ha sido un firme defensor del desarrollo y el uso responsables de la IA. Sus puntos de vista tienen un peso significativo, dada su amplia experiencia en la industria tecnológica y su participación en la configuración del futuro de la IA. La promesa de la IA La IA tiene el potencial de revolucionar las industrias, mejorar la atención sanitaria y la educación y resolver algunos de los problemas más acuciantes del mundo. Desde los coches autónomos a la medicina personalizada, las aplicaciones de la IA son amplias y prometedoras. Sin embargo, un gran poder conlleva una gran responsabilidad. Aunque la IA ofrece numerosas ventajas, su uso indebido podría tener consecuencias catastróficas. Advertencia de Eric Schmidt sobre el mal uso de la IA En unas recientes declaraciones, Eric Schmidt destacó los peligros del uso indebido de la IA, calificándola de “riesgo extremo” para la sociedad. Subrayó que, si bien la IA puede ser una fuerza positiva, también puede convertirse en un arma o utilizarse de forma irresponsable, con consecuencias imprevistas. La advertencia de Schmidt no se refiere sólo a la tecnología en sí, sino a la forma en que los seres humanos deciden utilizarla. Una de las principales preocupaciones de Schmidt es la posibilidad de que la IA se utilice en ciberataques. Los sistemas avanzados de IA podrían aprovecharse para lanzar sofisticados ciberataques, perturbar infraestructuras críticas o robar información sensible. Esto podría tener efectos devastadores para gobiernos, empresas y particulares. Riesgos del uso indebido de la IA 1. Amenazas para la ciberseguridad Como ya se ha mencionado, los ciberataques impulsados por IA son una preocupación importante. Los piratas informáticos podrían utilizar la IA para automatizar los ataques, haciéndolos más rápidos, eficaces y difíciles de detectar. Esto podría provocar trastornos generalizados y pérdidas económicas. 2. Armamento de la IA Otro riesgo importante es el armamentismo de la IA. Las armas autónomas impulsadas por IA podrían utilizarse en conflictos bélicos, lo que plantearía problemas éticos y humanitarios. Schmidt ha advertido de que estas armas podrían caer en las manos equivocadas y provocar resultados catastróficos. 3. Prejuicios y discriminación Los sistemas de IA son tan buenos como los datos con los que se entrenan. Si los datos contienen prejuicios, es probable que el sistema de IA los perpetúe. Esto podría conducir a la discriminación en áreas como la contratación, los préstamos y la aplicación de la ley. 4. Desplazamiento laboral Aunque la IA tiene el potencial de crear nuevos puestos de trabajo, también podría desplazar a millones de trabajadores. Las industrias que dependen en gran medida del trabajo manual o de tareas repetitivas son especialmente vulnerables. Esto podría provocar desigualdad económica y malestar social. ¿Qué se puede hacer para mitigar los riesgos? Eric Schmidt cree que se necesitan medidas proactivas para abordar los riesgos asociados al uso indebido de la IA. He aquí algunas medidas que pueden adoptarse: 1. Regulación y gobernanza Los gobiernos y las organizaciones internacionales deben establecer normas y directrices claras para el desarrollo y el uso de la IA. Esto incluye establecer normas éticas y garantizar la rendición de cuentas. 2. Colaboración entre las partes interesadas Las empresas tecnológicas, los gobiernos y el mundo académico deben trabajar juntos para abordar los retos que plantea la IA. La colaboración es clave para desarrollar sistemas de IA seguros y responsables. 3. Invertir en investigación sobre la seguridad de la IA Deben asignarse más recursos a la investigación sobre la seguridad de la IA. Esto incluye el estudio de los riesgos potenciales de la IA y el desarrollo de estrategias para mitigarlos. 4. Concienciación y educación del público Es fundamental sensibilizar a la opinión pública sobre los riesgos y beneficios de la IA. Educar a la gente sobre cómo funciona la IA y su impacto potencial puede ayudar a fomentar un enfoque más informado y responsable de su uso. Conclusión La advertencia de Eric Schmidt sobre el mal uso de la IA es un recordatorio oportuno de los retos a los que nos enfrentamos en la era de la inteligencia artificial. Aunque la IA tiene el potencial de generar cambios positivos, también plantea riesgos significativos si no se gestiona de forma responsable. Tomando medidas proactivas, podemos aprovechar el poder de la IA y minimizar sus peligros. Como bien dice Schmidt, “La IA es una herramienta, y como cualquier herramienta, puede usarse para bien o para mal” De nosotros depende que se

Cyberpunk Futuro Carga: Brazo robótico Neuralink controlado por un chip cerebral

Last Updated on diciembre 2, 2024 1:53 pm by Laszlo Szabo / NowadAIs | Published on diciembre 2, 2024 by Laszlo Szabo / NowadAIs Cyberpunk Futuro Carga: Brazo robótico Neuralink controlado por chip cerebral – Notas clave: Neuralink ha desarrollado un chip cerebral que permite el control neural directo de un brazo robótico mediante una sofisticada interpretación de señales neuronales La tecnología pretende proporcionar una autonomía sin precedentes a personas con discapacidad motriz El éxito de las pruebas demuestra el potencial de las interfaces cerebro-máquina en aplicaciones médicas y potencialmente más amplias Introducción a Neuralink y su tecnología de chip cerebral Neuralink, una empresa de neurotecnología fundada por Elon Musk en 2016, ha surgido como pionera en el floreciente campo de las interfaces cerebro-máquina (BMI). La visión de la empresa implica salvar la brecha entre la cognición humana y los sistemas digitales mediante el desarrollo de implantes neuronales avanzados capaces de interactuar directamente con el cerebro. El núcleo de la misión de Neuralink es un minúsculo y sofisticado chip cerebral, a menudo denominado “Link”, diseñado para interpretar y transmitir señales neuronales con notable precisión. [Fuentes: 0, 1, 2] Este dispositivo se implanta en el cerebro mediante un procedimiento quirúrgico mínimamente invasivo que utiliza un robot especialmente diseñado capaz de insertar hilos finos y flexibles -cada uno más fino que un cabello humano- en regiones del cerebro responsables de diversas funciones, incluido el movimiento. [Fuentes: 3] El objetivo último de la tecnología de Neuralink es permitir una comunicación fluida entre el cerebro y los dispositivos externos, abriendo así las puertas a nuevas aplicaciones en campos tanto médicos como no médicos. Inicialmente, el objetivo es ofrecer soluciones terapéuticas a personas con trastornos neurológicos, como parálisis o graves alteraciones del movimiento. Al traducir la actividad neuronal en señales digitales, el chip cerebral puede facilitar el control de prótesis, ordenadores u otros dispositivos electrónicos, ofreciendo a los discapacitados niveles de autonomía sin precedentes. [Fuentes: 4, 5] Mientras Neuralink sigue perfeccionando su tecnología, el potencial para mejorar las capacidades cognitivas humanas e incluso integrar la inteligencia artificial con el cerebro humano sigue siendo una perspectiva tentadora en la vanguardia de la neurociencia moderna. [Fuentes: 6] El desarrollo de la interfaz brazo-robot Nos complace anunciar la aprobación y el lanzamiento de un nuevo ensayo de viabilidad para ampliar el control BCI mediante el implante N1 a un brazo robótico asistivo en fase de investigación. Se trata de un primer paso importante para recuperar no sólo la libertad digital, sino también la física. Más información.. – Neuralink (@neuralink) 25 de noviembre de 2024 El desarrollo de la interfaz brazo-robot en las pruebas de Neuralink ha supuesto un gran paso adelante en el ámbito de las interfaces cerebro-máquina. Este esfuerzo se basa en décadas de investigación encaminadas a posibilitar una interacción perfecta entre las redes neuronales humanas y los sistemas robóticos. El principal objetivo de Neuralink es perfeccionar un sistema en el que los chips cerebrales implantados transmitan señales neuronales de forma inalámbrica, permitiendo a las personas controlar brazos robóticos únicamente a través de la intención mental. [Fuentes: 7, 8, 9] Esta interfaz utiliza algoritmos avanzados diseñados para interpretar y traducir patrones complejos de actividad neuronal en movimientos precisos del brazo robótico. El proyecto se enfrentó a numerosos retos, sobre todo en el ámbito del procesamiento en tiempo real y la autonomía, donde era crucial lograr una latencia mínima y una respuesta precisa a las señales cerebrales de los usuarios. La mejora de la adaptabilidad de la interfaz fue un componente crítico del proceso de desarrollo, que exigió pruebas rigurosas para garantizar la capacidad del sistema de funcionar con una amplia gama de patrones e intenciones neuronales. [Fuentes: 10] Los investigadores se centraron en mejorar la conectividad entre el chip cerebral y el brazo robótico para conseguir movimientos fluidos y realistas sin comprometer la seguridad ni la fiabilidad. Los avances de Neuralink en este campo han abierto nuevas vías en las tecnologías de asistencia, ofreciendo un potencial notable para las personas con deficiencias motoras. Más allá del objetivo inmediato del control robótico del brazo, esta tecnología promete iluminar las enormes posibilidades de la interconexión neuronal para aumentar las capacidades y experiencias humanas. [Fuentes: 2, 11] Cómo controla el chip cerebral el brazo robótico El sistema de chip cerebral neuralink permite la comunicación directa entre el cerebro y un brazo robótico traduciendo la actividad neuronal en órdenes procesables. Este proceso totalmente nuevo comienza con la implantación de un pequeño y sofisticado dispositivo en la corteza motora, la región del cerebro responsable de planificar, controlar y ejecutar los movimientos voluntarios. El chip consta de pequeños electrodos que detectan los impulsos eléctricos generados por las neuronas cuando se disparan. [Fuentes: 12, 13, 14] Cuando una persona piensa en mover el brazo, surgen patrones específicos de actividad neuronal que el chip detecta y registra. [Fuentes: 15] Los datos captados por el chip se transmiten de forma inalámbrica a un ordenador externo para su procesamiento en tiempo real. A continuación, algoritmos avanzados descodifican las complejas señales neuronales y las traducen en instrucciones precisas para el brazo robótico. Esto implica interpretar las intenciones del usuario, como alcanzar o agarrar, y convertirlas en movimientos que reflejen las funciones naturales del brazo. La perfecta integración de algoritmos de aprendizaje automático mejora la precisión de la traducción con el tiempo al adaptarse a las firmas neuronales y preferencias de cada usuario. [Fuentes: 8, 16, 17, 18] Los sistemas de retroalimentación son cruciales para perfeccionar el control, ya que proporcionan información sensorial al usuario, ya sea mediante retroalimentación visual al observar el brazo o mediante dispositivos de retroalimentación háptica. Este bucle permite un aprendizaje y un ajuste continuos, fomentando una mayor destreza y capacidad de respuesta. El resultado es una interacción fluida entre los pensamientos del usuario y el brazo robótico, que transforma la intención cognitiva en acción física. [Fuentes: 19, 20] Pruebas y experimentación: Progresos y retos Las pruebas y experimentos del chip cerebral Neuralink, cuyo objetivo es controlar un brazo robótico mediante entradas neuronales directas,

Anuncio de Coca-Cola con IA en 2024: el giro tecnológico del icónico anuncio de Navidad

Last Updated on noviembre 15, 2024 5:03 pm by Laszlo Szabo / NowadAIs | Published on noviembre 15, 2024 by Laszlo Szabo / NowadAIs Anuncio de Coca-Cola con IA en 2024: el giro tecnológico del icónico anuncio de Navidad – Notas clave Coca-Cola está actualizando su clásico anuncio navideño “Holidays Are Coming” con un anuncio de 15 segundos generado por IA. La empresa también ofrece experiencias interactivas de realidad aumentada y chatbots con IA para que los consumidores se involucren con el espíritu navideño. La integración de la IA de Coca-Cola va más allá del marketing, ya que la empresa utiliza la tecnología para optimizar su red de máquinas expendedoras y personalizar la experiencia de la fuente de refrescos Freestyle. El Asistente de Santa Claus: Un anuncio clásico con un toque futurista Es la época más maravillosa del año, y Coca-Cola aporta un poco más de magia a las fiestas En lugar de los clásicos camiones rojos y el alegre Papá Noel, el querido anuncio “Holidays Are Coming” (Llegan las fiestas) se renueva con un toque de alta tecnología, gracias a la inteligencia artificial (IA). Imagínate: la cálida y nostálgica sensación de la tradicional narración navideña, mezclada con el estilo del futuro. Eso es exactamente lo que pretende Coca-Cola con su anuncio navideño de 15 segundos generado por IA. Atrás quedaron los días en que un simple camión atravesaba la nieve. Este año, la puerta de la furgoneta de reparto de Coca-Cola se abre y una misteriosa figura (que sólo podemos suponer que es el mismísimo Papá Noel) entrega una chispeante botella de Coca-Cola Zero a un encantado transeúnte. Es una fugaz visión de la magia navideña, insinuada a través de un simple destello de una manga roja y un puño blanco. Pero Coca-Cola no se detiene ahí. Están llevando esta experiencia festiva impulsada por IA directamente a la gente, dando a los consumidores la oportunidad de participar en la acción. Dar vida a las fiestas con la realidad aumentada Al escanear un código QR especial en sus latas y botellas de Coca-Cola con temática navideña, los compradores pueden participar en experiencias interactivas que dan vida a la temporada. ¿Quieres charlar con Papá Noel? Hay un chatbot con inteligencia artificial para ello. ¿Prefieres crear tu propio paraíso invernal personalizado? Coca-Cola te lo pone fácil con animaciones de bolas de nieve que se pueden compartir y funcionan con realidad aumentada. No se trata solo de vender más bebidas, sino de fomentar conexiones genuinas y crear recuerdos navideños inolvidables. Después de todo, ¿a quién no le gustaría intercambiar historias con el gran hombre de rojo o ver sus momentos más queridos transformados en una caprichosa bola de nieve animada? La revolución de la IA de Coca-Cola Pero la aventura de Coca-Cola con la IA no se limita a llamativos trucos de marketing. Forma parte de una estrategia más amplia de la empresa para integrar las tecnologías de Inteligencia Artificial en todo su negocio. En 2023, Coca-Cola formó una alianza estratégica con las potencias de la IA: Bain & Company y OpenAI, los creadores de ChatGPT. Esta asociación allanó el camino para el desarrollo de “Create Real Magic”, una plataforma en línea que aprovecha las increíbles capacidades de modelos lingüísticos avanzados como GPT-4 y generadores de imágenes como DALL-E. De repente, el equipo de marketing de Coca-Cola tuvo acceso a herramientas capaces de producir textos similares a los humanos y generar imágenes llamativas. Las posibilidades de crear campañas innovadoras basadas en IA eran infinitas El año pasado, Coca-Cola invitó a los fans a utilizar la plataforma Create Real Magic para diseñar sus propias tarjetas navideñas digitales. Fue un vistazo al futuro, en el que los consumidores podían dar rienda suelta a su creatividad con la ayuda de la IA, al tiempo que reforzaban su conexión con la querida marca. Optimización de las máquinas expendedoras con IA Pero la revolución de la IA de Coca-Cola no se limita a anuncios llamativos y experiencias interactivas. También están utilizando la tecnología para transformar sus operaciones más prácticas, como su red de máquinas expendedoras. Coca-Cola ha estado convirtiendo silenciosamente sus antiguas máquinas de refrescos en dispositivos inteligentes basados en datos. Todo comenzó en 2014 con una iniciativa de análisis que reconfiguró su enfoque de venta al por menor. En un programa piloto en Australia, Coca-Cola conectó 60 máquinas expendedoras a un algoritmo de IA. Los resultados fueron impresionantes: un aumento del 15% en las transacciones y una reducción del 18% en el número de veces que las máquinas necesitaban ser reabastecidas. Todo un éxito Esta historia de éxito llevó a la creación de HIVERY, una empresa de inteligencia artificial que ya ha implantado la plataforma analítica de vending de Coca-Cola en Australia, Nueva Zelanda y Estados Unidos. Al hacer números sobre el comportamiento de los consumidores y la colocación de productos, estas máquinas impulsadas por IA están ayudando a Coca-Cola a mantener contentos a sus sedientos clientes y a que sus operaciones funcionen como una máquina bien engrasada. Personalizar la experiencia del refresco Pero las innovaciones de Coca-Cola en el campo de la IA no se quedan ahí. También han utilizado la tecnología para revolucionar la experiencia del consumidor en sus fuentes de refrescos Freestyle con pantalla táctil. Lanzadas en 2009, estas máquinas de alta tecnología permiten a los clientes mezclar y combinar más de 100 opciones de bebidas diferentes, creando sus propios brebajes personalizados. Entre bastidores, las fuentes Freestyle con inteligencia artificial recopilan valiosos datos sobre las preferencias de los consumidores. Al analizar el contenido de las redes sociales y las interacciones con la aplicación de los usuarios de Freestyle, Coca-Cola obtiene información inigualable sobre las tendencias emergentes y los patrones de consumo de productos. Esta información se utiliza para informar sus estrategias de marketing y decisiones de desarrollo de productos. Tanto la empresa como el consumidor salen ganando El futuro del marketing de bebidas A medida que Coca-Cola sigue ampliando los límites de la integración de la IA -desde sus anuncios navideños hasta sus

Llama de defensa de Scale AI: la nueva arma secreta para la seguridad nacional

Scale AI ha creado Defense Llama, un asistente de IA innovador diseñado para el ejército y las agencias de seguridad nacional de Estados Unidos. Basado en el modelo Llama 3 de Meta, Defense Llama apoya diversas operaciones militares, desde la planificación de combates hasta el análisis de inteligencia. Reconociendo la necesidad de aprovechar la inteligencia artificial generativa, el Departamento de Defensa (DoD) estableció un grupo de trabajo para explorar su uso eficaz. Defense Llama actúa como un asesor militar experto, siempre disponible y capaz de procesar información rápidamente. A diferencia de los chatbots comunes, está específicamente diseñado para abordar temas complejos de operaciones militares, haciendo un paralelo con acudir a un experto en lugar de a un amigo para consejo. En un mundo en el que las decisiones militares deben tomarse con rapidez, el DoD se dio cuenta de que necesitaba apoyo de IA para no quedar rezagado frente a otros países que desarrollan sus propias capacidades militares. Durante una presentación, Dan Tadross, un responsable en Scale AI, mostró cómo algunos grupos militares ya están implementando Defense Llama en redes seguras. La clave de Defense Llama radica en su entrenamiento especializado, donde no solo estudió manuales militares, sino que se educó en doctrina militar y derecho internacional humanitario. Debe saber cuándo proponer opciones tácticas y cuándo optar por soluciones diplomáticas, equilibrando estas habilidades complejas. Este desarrollo podría transformar la toma de decisiones militares, permitiendo que un pequeño equipo, con el apoyo de Defense Llama, actúe con la agilidad que hoy se espera en entornos de alta presión, mejorando la eficiencia y eficacia. En un contexto donde las amenazas son inminentes, herramientas que apoyen decisiones informadas de manera rápida son esenciales para la seguridad nacional. A medida que la IA evolucione, herramientas como Defense Llama probablemente serán tan comunes en las operaciones militares como los mapas y radios, ofreciendo un asistente digital inteligente que potencia a las fuerzas armadas sin reemplazar el juicio humano. Con el tiempo, Defense Llama podría ser recordada como un hito en la estrategia militar moderna. Definiciones: – Gran Modelo Lingüístico (LLM): un tipo de IA entrenado con grandes volúmenes de datos textuales para generar respuestas similares a las humanas. – Ajuste: proceso de perfeccionamiento de un modelo de IA preexistente para especializarlo en tareas o ámbitos específicos. – IA generativa: IA capaz de crear nuevos contenidos basados en la información recibida. – Derecho internacional humanitario: normas que protegen a personas no involucradas en hostilidades y regulan métodos de guerra. Preguntas frecuentes: ¿Qué es Defense Llama? Es un asistente de IA desarrollado para el ejército y agencias de seguridad nacional en EE.UU., basado en el modelo Llama 3 de Meta, optimizado para operaciones militares. ¿En qué se diferencia de otros asistentes de IA? Defense Llama está diseñado específicamente para las necesidades militares, habiendo sido entrenado en doctrina militar y derecho internacional, lo que le permite brindar respuestas adaptadas a estos contextos. ¿Cuáles son sus principales ventajas? Agiliza la toma de decisiones, permitiendo respuestas rápidas y bien fundamentadas a situaciones críticas, además de minimizar riesgos de daños colaterales. ¿Cómo se está utilizando y cuáles son los planes futuros? Grupos militares ya están empleando Defense Llama en redes seguras. Se espera que sus capacidades continúen evolucionando para mejorar aún más las operaciones. ¿Qué consideraciones éticas existen? El uso de IA en contextos militares presenta dilemas éticos, por lo que es fundamental establecer salvaguardias y seguir las directrices del derecho internacional para prevenir mal uso. source

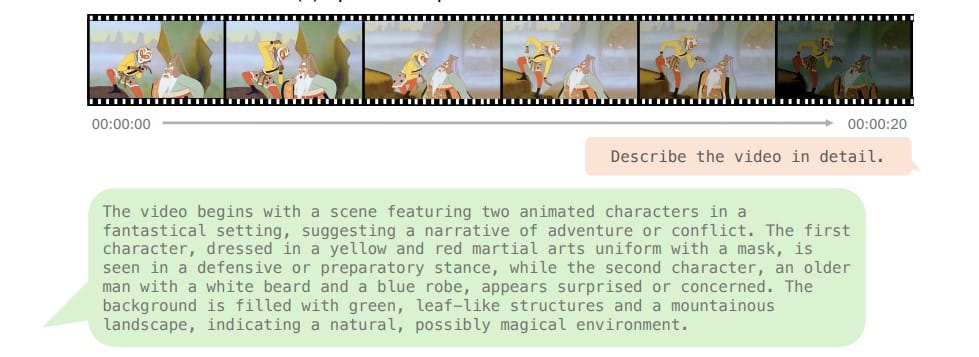

Conozca a LongVu: La inteligencia artificial que descifra el código de los vídeos largos

Last Updated on noviembre 4, 2024 7:32 pm by Laszlo Szabo / NowadAIs | Published on noviembre 4, 2024 by Laszlo Szabo / NowadAIs Conozca a LongVu: La IA que descifra el código de los vídeos largos – Notas clave: LongVu procesa múltiples elementos de vídeo simultáneamente (visuales, audio, texto) para comprender el contenido como lo haría un ser humano El sistema puede manejar vídeos largos de forma eficiente, lo que lo hace útil para la moderación de contenidos y la educación A diferencia de las herramientas anteriores, LongVu mantiene el contexto a lo largo de los vídeos largos, de forma similar a como la gente sigue las tramas de las películas LongVu: El asistente de vídeo que nunca se aburre ¿Alguna vez has visto un vídeo de dos horas y has deseado saber al instante qué es lo importante sin verlo entero? ¿O quizá te has preguntado cómo consigue YouTube detectar contenidos inapropiados entre los millones de horas de vídeo que se suben cada día? Pues bien, Meta AI podría haber resuelto estos problemas con su última creación: LongVu. Cuál es el problema con LongVu? Imagina tener un amigo superinteligente que puede ver horas de contenido de vídeo y decirte exactamente qué está pasando, cuándo ha pasado y por qué es importante. Eso es LongVu en pocas palabras. Es como tener un chef en la cocina que puede saborear, oler y ver todos los ingredientes que se juntan para crear el plato perfecto, salvo que, en lugar de ingredientes, LongVu procesa palabras, sonidos y elementos visuales de los vídeos. Piensa en cómo entiendes una película: no te limitas a ver las imágenes, sino que escuchas los diálogos, lees las expresiones faciales y sigues la historia a medida que se desarrolla. LongVu hace lo mismo, pero lo hace más rápido y a través de vídeos más largos de lo que podría hacerlo cualquier ser humano. La salsa secreta: ¿Cómo funciona? LongVu es como un maestro malabarista capaz de mantener varias pelotas en el aire a la vez. Estas “bolas” son: La historia visual (lo que ves) La banda sonora (lo que se oye) Las palabras que se dicen La forma en que todo se conecta a lo largo del tiempo Pero aquí es donde la cosa se pone realmente interesante: LongVu no sólo hace malabarismos con estos elementos, sino que los entrelaza para ofrecer una comprensión completa de lo que está ocurriendo. Es como tener subtítulos, comentarios del director y el análisis de un crítico de cine, todo en uno. ¿Qué podemos hacer con esto? Seamos prácticos. Aquí es donde LongVu podría hacer su vida más fácil: Encontrar esa escena que te encanta: ¿Recuerdas estar buscando frenéticamente en un vídeo ese momento perfecto? LongVu puede ayudarte a encontrarlo. Espacios en línea más seguros: Puede detectar contenidos inapropiados antes de que lleguen a los espectadores, haciendo que las plataformas sean más seguras para todos. Revolución educativa: Imagina tener un compañero de estudio inteligente que pueda resumir una clase de tres horas en los puntos clave que necesitas saber. La magia entre bastidores Aunque no vamos a ponernos demasiado técnicos, vale la pena señalar que LongVu aprendió sus habilidades viendo innumerables vídeos, desde éxitos de taquilla de Hollywood hasta el vídeo de la boda de tu primo (vale, quizá no ese en concreto, pero ya te haces una idea). Es como si hubiera asistido a una enorme escuela de cine donde aprendió a entender todo tipo de contenido de vídeo imaginable. Por qué es importante para todos Usted podría estar pensando: “Cool tech, pero ¿por qué debería importarme?” Bueno, considere esto: ¿Cuánto tiempo pasas viendo vídeos en línea? Ya sea por trabajo, educación o entretenimiento, el vídeo está en todas partes. LongVu podría ayudarte: Encontrar exactamente lo que buscas en vídeos largos Obtener mejores recomendaciones basadas en el contenido real del vídeo Acceda más fácilmente a los vídeos si tiene problemas visuales o auditivos Ahorre tiempo obteniendo resúmenes rápidos de contenidos largos El camino por recorrer Por impresionante que sea LongVu, es sólo el principio. Piensa en él como si fuera el primer smartphone: ha cambiado mucho para su época, pero es sólo un indicio de lo que está por venir. El futuro podría depararnos una inteligencia artificial capaz de crear resúmenes de vídeo personalizados en función de tus intereses, o incluso de ayudar a los cineastas a editar sus películas. El toque humano Por supuesto, un gran poder conlleva una gran responsabilidad (gracias, Spiderman). Meta AI es consciente de ello, y por eso tiene muy en cuenta la privacidad y los aspectos éticos. Al fin y al cabo, queremos una IA que nos ayude a entender mejor los vídeos, no una que se entrometa en nuestra vida personal. Lo esencial LongVu representa un enorme salto adelante en la forma en que las máquinas entienden los vídeos. Es como si hubiéramos pasado de un teléfono plegable a un smartphone en el mundo de la IA de vídeo. Aunque pueda parecer ciencia ficción, esta tecnología es muy real y pronto podría facilitarte la vida de formas que nunca habrías imaginado. Tanto si eres un creador de contenidos, un estudiante o simplemente alguien a quien le encanta ver vídeos en línea, las capacidades de LongVu podrían cambiar tu forma de interactuar con los contenidos de vídeo. ¿Y quién sabe? Tal vez algún día puedas pedirle a tu dispositivo que busque ese momento gracioso con un gato en tu recopilación de tres horas de vídeo, y te llevará allí en cuestión de segundos. Descripciones: Procesamiento multimodal: Cuando algo puede manejar diferentes tipos de información a la vez (como ver, oír y leer) – al igual que usted utiliza múltiples sentidos para experimentar el mundo Moderación de contenidos: Proceso de revisión de los contenidos en línea para eliminar el material inapropiado antes de que llegue a los espectadores Razonamiento temporal: Comprender cómo se relacionan los acontecimientos a lo largo del tiempo; por ejemplo, saber que en un vídeo de cocina hay que romper los huevos

Arte e IA: la danza creativa entre la visión humana y el aprendizaje automático

Last Updated on octubre 29, 2024 11:26 am by Laszlo Szabo / NowadAIs | Published on octubre 29, 2024 by Laszlo Szabo / NowadAIs Arte e IA: la danza creativa entre la visión humana y el aprendizaje automático – Notas clave Artistas como Refik Anadol y Mario Klingemann lideran un nuevo movimiento en el que la IA sirve tanto de herramienta como de colaborador en la creación de experiencias visuales La fusión del aprendizaje automático con las formas artísticas tradicionales plantea importantes cuestiones sobre la autoría y los derechos de propiedad intelectual Las instalaciones interactivas de IA están cambiando la forma en que el público se relaciona con el arte, creando experiencias personalizadas y basadas en datos Asociaciones entre artistas y máquinas La fusión del arte y la inteligencia artificial (IA) está cambiando la expresión creativa, ofreciendo a los artistas herramientas innovadoras para mejorar su trabajo y relacionarse con el público de formas sin precedentes. A medida que nos adentramos en 2024, este artículo profundiza en el floreciente campo de las colaboraciones artísticas con IA, examinando proyectos notables, implicaciones para la expresión artística y tendencias futuras que prometen redefinir los límites de la creatividad. El surgimiento de las colaboraciones artísticas con IA El concepto de colaboraciones artísticas con IA no es totalmente nuevo; sin embargo, los recientes avances en aprendizaje automático y redes neuronales han impulsado esta intersección hacia el centro de atención. Los artistas aprovechan cada vez más las tecnologías de IA para aumentar sus procesos creativos, lo que da lugar a una interacción dinámica entre el ingenio humano y la inteligencia de las máquinas. Proyectos artísticos destacados relacionados con la IA Instalaciones basadas en datos de Refik Anadol Refik Anadol es un pionero en el campo del arte de la IA, conocido por sus instalaciones inmersivas que transforman los datos en experiencias visuales. Su proyecto“Melting Memories” utiliza algoritmos de aprendizaje automático para analizar grandes conjuntos de datos y crear fascinantes visualizaciones que reflejan la memoria colectiva de la humanidad. El trabajo de Anadol ejemplifica cómo la IA puede servir de medio de expresión artística, difuminando las fronteras entre tecnología y creatividad. Estética neuronal de Mario Klingemann Mario Klingemann es un artista que explora el potencial creativo de las redes neuronales. Su trabajo consiste a menudo en entrenar GAN (Generative Adversarial Networks) en obras de arte existentes para generar nuevas piezas que desafían las nociones tradicionales de autoría. Sus proyectos invitan al espectador a cuestionarse el papel del artista en una época en la que las máquinas pueden crear arte de forma autónoma. Virus mosaico”, de Anna Ridler El proyecto “Mosaic Virus” de Anna R idler combina técnicas tradicionales de dibujo con imágenes generadas por IA. Entrenando una GAN con sus propios dibujos, Ridler crea un diálogo entre la creatividad humana y el aprendizaje automático. Este proyecto pone de relieve cómo los artistas pueden utilizar la IA no sólo como una herramienta, sino como un colaborador que potencia su visión artística. Fábrica del Sol” de Hito Steyerl Esta instalación de vídeo inmersiva critica el trabajo digital y la cultura de la vigilancia, mezclando arte, IA y temas sociopolíticos. Steyerl utiliza simulaciones digitales para cuestionar cómo los datos y las economías virtuales afectan al bienestar personal y social, haciendo hincapié en el impacto omnipresente de la tecnología en nuestras vidas Serie “Emissaries” de Ian Cheng Esta serie utiliza simulaciones en vivo para crear ecosistemas virtuales en los que personajes manejados por IA interactúan dinámicamente. El trabajo de Cheng explora ideas en torno a la adaptación y la evolución en entornos digitales, utilizando la IA para modelar agentes autónomos y realistas que evolucionan con el tiempo, fomentando la reflexión sobre la cognición humana y artificial DALL-E de OpenAI DALL-E de OpenAI es un modelo de IA capaz de generar imágenes a partir de descripciones textuales. Esta tecnología de conversión de texto en imagen permite a los artistas visualizar conceptos difíciles de representar por medios tradicionales. La capacidad de generar imágenes únicas a partir de indicaciones sencillas abre nuevas vías para la exploración artística y la narración de historias. Implicaciones para la expresión artística La integración de la IA en el proceso artístico tiene profundas implicaciones para nuestra forma de entender la creatividad. A medida que los artistas adoptan estas tecnologías, surgen varios temas clave: Redefinición de la autoría La cuestión de la autoría se vuelve cada vez más compleja en las colaboraciones artísticas con IA. Cuando una obra de arte es generada por un algoritmo entrenado a partir de piezas existentes, ¿quién posee los derechos? Esta ambigüedad pone en tela de juicio las nociones tradicionales de propiedad y plantea consideraciones éticas sobre la propiedad intelectual. Ampliar las posibilidades creativas La IA es una poderosa herramienta para ampliar las posibilidades creativas. Los artistas pueden experimentar con estilos, técnicas y conceptos que pueden quedar fuera de su repertorio habitual. Esta libertad fomenta la innovación y permite explorar nuevos lenguajes artísticos que combinan la intuición humana con la precisión de las máquinas. Nuevas formas de atraer al público Las instalaciones interactivas impulsadas por la IA invitan al público a interactuar con el arte de formas novedosas. Al incorporar datos en tiempo real o la participación del público, los artistas pueden crear experiencias inmersivas que fomenten conexiones más profundas entre los espectadores y las obras de arte. Desafío a la estética tradicional La estética del arte generado por IA a menudo difiere de las formas tradicionales, lo que suscita debates sobre lo que constituye la belleza y el valor en el arte. A medida que las máquinas generan obras que pueden carecer de emoción o intención humana, se anima al público a reconsiderar sus definiciones de arte y creatividad. Fomentar la colaboración entre disciplinas La intersección de arte y tecnología fomenta la colaboración entre disciplinas, animando a los artistas a trabajar junto a científicos, ingenieros y tecnólogos. Este enfoque interdisciplinario da lugar a proyectos innovadores que combinan perspectivas y conocimientos diversos. Tendencias futuras de la colaboración entre arte y tecnología De cara a 2024

Orion, de OpenAI: ¿La próxima frontera de la inteligencia artificial?

Last Updated on octubre 28, 2024 1:23 pm by Laszlo Szabo / NowadAIs | Published on octubre 25, 2024 by Laszlo Szabo / NowadAIs Orion, de OpenAI: ¿La próxima frontera de la inteligencia artificial? – Notas clave Orion promete multiplicar por 100 el rendimiento de GPT-4, con capacidades avanzadas de razonamiento y procesamiento multimodal El modelo se basa en proyectos anteriores como Strawberry (Q-star) y OpenAI-o1, centrados en el pensamiento del Sistema 2 y la generación de datos sintéticos Entre los principales retos se encuentran abordar los prejuicios, garantizar la privacidad, mantener la transparencia y gestionar el impacto medioambiental del despliegue a gran escala de la IA La inteligencia artificial evoluciona a un ritmo vertiginoso y OpenAI se sitúa a la vanguardia de esta evolución. A medida que nos acercamos al final de 2024, el mundo de la tecnología bulle de expectación ante el próximo modelo de OpenAI, cuyo nombre en clave es Orion. Este ambicioso proyecto promete redefinir los límites de las capacidades de la IA, ofreciendo potencialmente una asombrosa mejora 100 veces superior a su predecesor, GPT-4. Orion representa algo más que una simple actualización; simboliza un salto cuántico en la tecnología de IA. Con sus avanzadas capacidades de razonamiento y procesamiento multimodal, Orion está llamada a transformar sectores que van desde la creación de contenidos a la investigación científica. Evolución de los modelos de OpenAI De GPT-3 a GPT-4: un camino de rápidos avances La trayectoria de OpenAI en el desarrollo de grandes modelos lingüísticos ha sido nada menos que notable. La progresión de GPT-3 a GPT-4 marcó una enorme evolución en las capacidades de IA. GPT-3, lanzado en 2020, asombró al mundo con su capacidad para generar texto similar al humano y realizar una amplia gama de tareas lingüísticas. Sin embargo, la GPT-4, presentada en 2023, subió aún más el listón. GPT-4 introdujo capacidades multimodales que le permitían procesar tanto texto como imágenes. Este avance abrió nuevas posibilidades para aplicaciones de IA en diversos ámbitos. La mejora de las capacidades de razonamiento y la ampliación de la base de conocimientos del modelo lo convirtieron en una poderosa herramienta para la resolución de problemas complejos y tareas creativas. Los pasos intermedios: Proyecto Strawberry y OpenAI-o1 Antes del esperado lanzamiento de Orion, OpenAI ha estado trabajando en proyectos intermedios para mejorar aspectos específicos de la funcionalidad de la IA. El proyecto Strawberry, también conocido como Q-star, se centró en mejorar las capacidades de razonamiento de la IA. El objetivo de este proyecto era imitar la forma humana de resolver problemas aplicando lo que los investigadores denominan “pensamiento del Sistema 2”, que permite a la IA adoptar un enfoque más comedido ante tareas complejas. Otro avance significativo fue el proyecto de síntesis de datos OpenAI-o1. El objetivo de esta iniciativa era generar datos de entrenamiento sintéticos de alta calidad, abordando uno de los retos críticos del desarrollo de la IA: la necesidad de disponer de conjuntos de datos diversos y amplios para entrenar modelos con eficacia. Preparando el terreno para Orion Estos pasos intermedios han sido cruciales para sentar las bases de Orion. Al centrarse en áreas específicas como el razonamiento y la síntesis de datos, OpenAI ha podido perfeccionar y mejorar las tecnologías subyacentes que impulsarán su modelo de próxima generación. Se espera que los conocimientos adquiridos en estos proyectos contribuyan significativamente a las capacidades de Orion, convirtiéndolo en la culminación de años de investigación y desarrollo en IA. Presentación de Orion: Características y capacidades Razonamiento avanzado y resolución de problemas Una de las características más esperadas de Orión es su capacidad de razonamiento avanzado. Partiendo de las bases sentadas por el Proyecto Strawberry, se espera que Orión demuestre una capacidad de resolución de problemas sin precedentes. Esto podría traducirse en la capacidad de manejar tareas matemáticas y lógicas complejas con un nivel de precisión que rivaliza con el de los expertos humanos. Las implicaciones de un razonamiento tan avanzado son de gran alcance. En campos como la investigación científica, el análisis financiero y el desarrollo de software, Orión podría ser una herramienta poderosa para abordar problemas complejos y generar soluciones novedosas. Su capacidad para “reflexionar” sobre situaciones complejas antes de llegar a conclusiones podría conducir a una toma de decisiones más fiable y perspicaz asistida por IA en diversos sectores. Procesamiento multimodal mejorado Mientras que GPT-4 introdujo funciones básicas de procesamiento de imágenes, Orion está preparado para llevar la IA multimodal a nuevas cotas. Se espera que el modelo integre a la perfección el procesamiento de texto, imágenes y vídeo, abriendo un mundo de posibilidades para la creación de contenidos, el análisis y la interacción. Esta capacidad multimodal mejorada podría actualizar campos como la producción de medios, la educación y la realidad virtual. Imagínese una inteligencia artificial capaz no sólo de comprender y generar texto, sino también de crear, editar y analizar contenidos visuales con igual destreza. Escala y rendimiento sin precedentes ‘GPT Next’ logrará un aumento de 3 OOMs. Grandes ideas de la #KDDISummit. Tadao Nagasaki, de @OpenAI Japan, desveló los planes de “GPT Next”, que promete un salto de órdenes de magnitud (OOM). Este modelo de IA aspira a un volumen computacional 100 veces mayor que GPT-4, utilizando recursos similares pero… pic.twitter.com/fMopHeW5ww – Shaun Ralston (@shaunralston) 3 de septiembre de 2024 Quizá la afirmación más llamativa de Orion es que supuestamente multiplica por 100 la capacidad de GPT-4. Aunque las métricas exactas de esta mejora aún no se han revelado, un salto tan significativo sugiere un modelo de escala y complejidad sin precedentes. Este enorme aumento del rendimiento podría manifestarse de varias maneras: Tiempos de procesamiento y respuesta más rápidos Comprensión más matizada del contexto y de las sutilezas del lenguaje Mejora de la memoria a largo plazo y de la coherencia en conversaciones extensas Mayor precisión en tareas especializadas de diversos ámbitos La magnitud de las capacidades de Orion podría ampliar los límites de lo que actualmente consideramos posible con la IA, acercándonos potencialmente a la inteligencia general artificial (AGI). La tecnología de

Artículo de uso informático de Anthropic: IA que funciona como un ser humano

Last Updated on octubre 23, 2024 8:47 am by Laszlo Szabo / NowadAIs | Published on octubre 23, 2024 by Laszlo Szabo / NowadAIs Artículo de uso informático de Anthropic: IA que funciona como un ser humano – Notas clave Claude 3.5 Sonnet ya puede navegar por los ordenadores como los humanos: moviendo cursores, haciendo clic y escribiendo texto a través de una API beta La función se centra en tareas informáticas habituales, como la introducción de datos, la cumplimentación de formularios y la automatización de la investigación Entre las medidas de seguridad se incluyen clasificadores para evitar usos indebidos y directrices claras para la implementación por parte de los desarrolladores El Sonnet 3.5 de Anthropic evoluciona de la asistencia a la autonomía Presentamos una versión mejorada de Claude 3.5 Sonnet, y un nuevo modelo, Claude 3.5 Haiku. También estamos introduciendo una nueva capacidad en beta: el uso del ordenador. Ahora los desarrolladores pueden indicar a Claude que utilice el ordenador como lo hacen las personas: mirando la pantalla, moviendo el cursor, haciendo clic y escribiendo texto. pic.twitter.com/ZlywNPVIJP – Anthropic (@AnthropicAI) 22 de octubre de 2024 Anthropic, una organización líder en investigación de IA, ha presentado recientemente su último avanceen inteligencia artificial: la función de uso del ordenador en su modelo actualizado, Claude 3.5 Sonnet. Esta innovadora capacidad permite a la IA interactuar con los ordenadores de forma similar a los usuarios humanos, navegando por las pantallas, pulsando botones y escribiendo texto. Este artículo profundiza en los entresijos de esta función, sus implicaciones para diversas industrias y el potencial que encierra para el futuro del trabajo. Contexto histórico La inteligencia artificial ha evolucionado mucho en las últimas décadas. Al principio, los sistemas de IA se diseñaban para realizar tareas sencillas, ayudando a los usuarios con funciones básicas. Sin embargo, a medida que la tecnología avanzaba, se hizo evidente la necesidad de una IA más sofisticada. Esto llevó al desarrollo de modelos capaces de realizar tareas cada vez más complejas, que culminaron con la introducción de modelos como el Soneto Claude 3.5. La necesidad de utilizar ordenadores La integración de la IA en las tareas cotidianas se ha convertido en una necesidad en los lugares de trabajo modernos. Muchos procesos, especialmente en entornos de oficina, implican acciones repetitivas que consumen un tiempo valioso. Al permitir que la IA realice estas tareas, las empresas pueden agilizar las operaciones y mejorar la productividad. Comprender la función de uso del ordenador Cómo funciona La función de uso informático permite a Claude 3.5 Sonnet interactuar con interfaces informáticas de forma similar a como lo haría un ser humano. Esto incluye: Análisis de Pantalla: Claude puede interpretar la información visual mostrada en una pantalla. Movimiento del cursor: La IA puede mover un cursor para hacer clic en botones, enlaces y otros elementos interactivos. Introducción de texto: Claude puede escribir texto, rellenar formularios y ejecutar comandos. Esta funcionalidad es posible gracias a una sofisticada API que permite a los desarrolladores integrar estas capacidades en sus aplicaciones. Aplicaciones en diversos campos Las aplicaciones potenciales de la función de uso del ordenador son muy amplias. Algunas de las áreas clave en las que puede tener un impacto significativo incluyen: Desarrollo de software: Automatización de tareas de codificación repetitivas, lo que permite a los desarrolladores centrarse en problemas más complejos. Introducción de datos: Agilizar los procesos de recopilación de datos permitiendo a Claude rellenar formularios e introducir información directamente. Investigación: Facilitar tareas abiertas como la recopilación y el análisis de datos, haciendo más eficientes los procesos de investigación. Limitaciones actuales A pesar de su potencial, la función de uso del ordenador está aún en fase experimental. Algunas de las limitaciones son: Interacciones propensas a errores: La IA puede tener problemas con tareas complejas que requieran una comprensión matizada. Capacidades limitadas: Aunque Claude puede realizar tareas básicas, las acciones más avanzadas, como arrastrar ventanas o desplazarse, pueden plantear problemas. Ciclo de retroalimentación: Mejorar mediante la interacción con los desarrolladores Fase de pruebas beta Anthropic ha lanzado la función de uso del ordenador en modo beta para recabar la opinión de los desarrolladores. Este enfoque colaborativo permite a la empresa perfeccionar el modelo basándose en el uso en el mundo real y en las opiniones de los usuarios. Al colaborar con los desarrolladores, Anthropic pretende identificar los puntos débiles y las áreas de mejora. Opiniones de los desarrolladores Muchas empresas ya están explorando las capacidades de Claude 3.5 Sonnet. Por ejemplo, plataformas como Asana, Canva y Replit están utilizando la IA para diversas tareas, desde la gestión de proyectos hasta la evaluación de software. Los comentarios de estos desarrolladores son muy valiosos para mejorar el rendimiento y la usabilidad del modelo. Mejora continua Anthropic se compromete a hacer evolucionar la función de uso del ordenador. Analizando los comentarios y las experiencias de los usuarios, la organización planea introducir mejoras iterativas, garantizando que Claude sea más fiable y eficaz con el paso del tiempo. Implicaciones para los trabajadores Transformación del empleo La introducción de capacidades de IA como el uso de ordenadores plantea interrogantes sobre el futuro del trabajo. Mientras algunos temen que estos avances provoquen el desplazamiento de puestos de trabajo, otros sostienen que transformarán las funciones en lugar de eliminarlas. Aumento frente a sustitución: Muchos puestos de trabajo evolucionarán para incorporar la IA como herramienta, mejorando las capacidades humanas en lugar de sustituirlas. Nuevas oportunidades: La demanda de conocimientos de IA crecerá, creando nuevas funciones centradas en la gestión y colaboración con sistemas de IA. Cambios específicos en la industria Los distintos sectores experimentarán distintos grados de transformación: Industria tecnológica: Los desarrolladores pueden encontrarse trabajando junto a la IA para crear soluciones más innovadoras. Sanidad: Las tareas administrativas pueden automatizarse, permitiendo a los profesionales médicos centrarse en la atención al paciente. Finanzas: El análisis de datos y la elaboración de informes pueden agilizarse, mejorando los procesos de toma de decisiones. Seguridad y consideraciones éticas Desarrollo responsable de la IA Como ocurre con cualquier avance tecnológico, el despliegue de la IA