Nuevos modelos de inteligencia artificial Ministral 3B y 8B que podrían sustituir al ChatGPT en tu teléfono

Last Updated on octubre 18, 2024 11:37 am by Laszlo Szabo / NowadAIs | Published on octubre 18, 2024 by Laszlo Szabo / NowadAIs Nuevos modelos de inteligencia artificial Ministral 3B y 8B que podrían sustituir al ChatGPT en tu teléfono – Notas clave Ministral 3B y 8B pueden procesar 128.000 tokens a la vez, lo suficiente para entender un libro entero de una sola vez Ambos modelos funcionan completamente offline en dispositivos locales, ofreciendo una protección de la privacidad sin igual A pesar de su pequeño tamaño, estos modelos superan a competidores de mayor tamaño en múltiples pruebas comparativas Tigres diminutos: Los nuevos modelos de Mistral AI son muy potentes ¡Atención, tecnólogos! Mientras todo el mundo se obsesiona con los enormes modelos de IA que necesitan centros de datos más grandes que Manhattan, Mistral AI acaba de dar un golpe de efecto a toda la industria. Sus nuevos y maravillosos gemelos, Ministral 3B y Ministral 8B, son el equivalente en IA a meter un motor Ferrari en un coche compacto… ¡y vaya si ronronean! Los nuevos chicos del barrio Puede que Ministral 3B y Ministral 8B le parezcan unos adorables cachorritos de IA, pero no se deje engañar por su tamaño. De alguna manera, Mistral AI ha conseguido exprimir las capacidades de estos potentes y compactos cerebros. Estamos hablando de modelos que pueden ejecutarse en tu teléfono sin sudar, algo con lo que esas voluminosas IA basadas en la nube solo pueden soñar. David contra Goliat: El juego de los números Aquí es donde las cosas se ponen salvajes: Ministral 3B sólo tiene 3.000 millones de parámetros (de ahí su nombre), mientras que su hermano mayor, Ministral 8B, tiene 8.000 millones. Pero fíjate: ¡estos pequeños titanes de Mistral AI superan a algunos modelos que les doblan en tamaño! Es como ver a un boxeador ligero noquear al campeón de los pesos pesados. La salsa secreta Lo que deja boquiabierto a todo el mundo es cómo Mistral AI ha diseñado estos modelos. Ministral 3B y Ministral 8B no son sólo versiones reducidas de modelos más grandes, sino que han sido completamente rediseñados desde cero. Hablamos de una arquitectura de transformador densa que es más eficiente que su contable durante la temporada de impuestos. Despiece de la bestia Pongámonos empollones un momento. Tanto Ministral 3B como Ministral 8B pueden manejar una enorme ventana de contexto de 128.000 tokens. Para los no expertos en tecnología, eso es como ser capaz de leer y comprender un libro entero de un tirón. Mistral AI ha conseguido esta hazaña gracias a una ingeniería muy inteligente, que incluye un sofisticado “patrón de atención de ventana deslizante” en Ministral 8B que lo hace más rápido que un guepardo con cafeína. El juego de la privacidad Aquí es donde Mistral AI realmente da en el clavo con Ministral 3B y Ministral 8B: la privacidad. Estos modelos pueden funcionar sin conexión alguna en su dispositivo. Se acabó el envío de datos confidenciales a una granja de servidores en no se sabe dónde. Es como tener un asistente personal genial que también es muy bueno guardando secretos. Músculo del mundo real Pero, ¿qué pueden hacer realmente estas miniaturas de IA? Resulta que mucho. Ministral 3B y Ministral 8B lo están petando en aplicaciones del mundo real. Estamos hablando de servicios de traducción que funcionan sin Internet, asistentes inteligentes que no necesitan llamar a casa y análisis de datos que mantienen tu información confidencial bajo llave. Mistral AI ha creado la navaja suiza de los modelos de inteligencia artificial. El futuro es pequeño Lo que Mistral AI ha hecho con Ministral 3B y Ministral 8B no es sólo impresionante, es ASOMBROSO. Estamos ante el futuro de la IA, y no se trata de construir modelos más grandes, sino más inteligentes. Estas potentes máquinas compactas demuestran que, a veces, lo mejor viene en frasco pequeño. Impacto en la industria Las repercusiones de Ministral 3B y Ministral 8B ya se dejan sentir en el mundo de la tecnología. Mistral AI ha lanzado el guante a los grandes: el tamaño no lo es todo. Estamos viendo cómo desarrolladores y empresas se pelean por hacerse con estos modelos, y las aplicaciones que se les ocurren son alucinantes. Desde robots autónomos hasta dispositivos domésticos inteligentes, Ministral 3B y Ministral 8B se están abriendo camino en todo. Mistral AI ha creado modelos que pueden impulsar la próxima generación de aplicaciones de IA sin necesidad de un superordenador. Estamos hablando de IA que puede funcionar en tu smartphone, smartwatch o incluso en tu nevera. El camino por recorrer ¿Cuál es el futuro de Mistral AI y su dúo dinámico? La empresa ya insinúa versiones especializadas de Ministral 3B y Ministral 8B para sectores específicos. Imagínese modelos personalizados para la sanidad, las finanzas o la educación: las posibilidades son infinitas. Descripciones Parámetros: Las unidades básicas de conocimiento en los modelos de IA. Piense en ellos como si fueran células cerebrales: más no siempre significa más inteligente. Arquitectura de transformador denso: Una forma compacta de construir modelos de IA, como diseñar una casa diminuta en la que cada centímetro de espacio se utiliza de forma eficiente. Token: Un fragmento de texto que la IA puede entender. Puede ser una palabra, parte de una palabra o incluso un signo de puntuación. Ventana de contexto: La cantidad de información que la IA puede tener en cuenta a la vez, como cuántas páginas de un libro puedes retener en tu mente mientras lees. Patrón de atención de ventana deslizante: Una técnica en la que la IA mira la información por trozos, como si leyera un libro a través de una lupa en movimiento. Edge computing: Ejecución de software en dispositivos locales (teléfonos, portátiles) en lugar de enviar datos a servidores remotos. Ajuste: Adaptación de un modelo de IA a tareas específicas, como enseñar a un profesor de conocimientos generales a convertirse en especialista en matemáticas. Preguntas más frecuentes ¿Cómo se compara Ministral 8B con modelos de IA más grandes? Ministral 8B demuestra

Los Vengadores de la IA se reúnen: OpenAI’s Swarm está aquí para salvar tu día digital

Last Updated on octubre 14, 2024 12:35 pm by Laszlo Szabo / NowadAIs | Published on octubre 14, 2024 by Laszlo Szabo / NowadAIs Los Vengadores de la IA se reúnen: Swarm de OpenAI llega para salvar tu día digital – Notas clave OpenAI presenta Swarm, un marco de colaboración entre múltiples agentes de IA Swarm utiliza agentes y traspasos para realizar transiciones de tareas sin interrupciones Aún es experimental, pero está abierto a desarrolladores e investigadores Conozca al Dream Team de la IA que está cambiando las reglas del juego ¡Fuera Vengadores! Hay un nuevo equipo de superhéroes en la ciudad, y no están aquí para salvar al mundo de los extraterrestres, sino para revolucionar la forma en que pensamos sobre la inteligencia artificial. OpenAI, el grupo de cerebritos que no deja dormir a Elon Musk, acaba de lanzar una bomba llamada Swarm. No es una película de serie B sobre abejas asesinas, amigos. Es una estructura que tiene al mundo de la tecnología zumbando más fuerte que un nido de avispones con cafeína. ¿De qué se trata? Imagina un mundo en el que los agentes de IA forman un equipo como la Liga de la Justicia, pero en lugar de luchar contra el crimen, se enfrentan a tus problemas más difíciles. Eso es Swarm en pocas palabras. Es la salsa secreta de OpenAI para conseguir que varios agentes de IA se lleven bien y trabajen juntos sin convertirse en un Señor de las Moscas digital. ¿Las configuraciones tradicionales de IA? Son como pastorear gatos: caóticas, impredecibles y propensas a las bolas de pelo. ¿Pero Swarm? Es el mejor domador de gatos del mundo de la IA. Es ligero, escalable y más suave que un tarro de Skippy recién hecho. El dúo dinámico: Agentes y transferencias En el corazón de Swarm hay dos actores clave: Los agentes y los traspasos. Los agentes son como las herramientas especializadas del cinturón de herramientas de Batman: cada uno tiene un trabajo específico y los conocimientos necesarios para llevarlo a cabo. Pero la verdadera magia ocurre con los traspasos. Se trata de transiciones fluidas que permiten a un agente enlazar con otro, como en la carrera de relevos más eficiente del mundo. Swarm tiene memoria de pez, pero en el buen sentido. Es “apátrida”, lo que significa que no se aferra al equipaje entre tareas. Es como si cada interacción fuera un nuevo comienzo, lo que lo hace perfecto para hacer malabarismos con un montón de tareas sin que se le crucen los cables. Estación de personalización: Tu IA, a tu manera ¿Quieres que tu IA hable como Shakespeare? Hecho. ¿Necesitas que haga números más rápido que un contable con cafeína? No te preocupes. Swarm te permite personalizar tu dream team de IA a tu gusto. Es como Build-A-Bear, pero para cerebros digitales. Y para todos los aficionados al código, Swarm es compatible con la API ChatCompletions de OpenAI. Es una combinación hecha en el paraíso del silicio, que te permite flexionar los músculos de Python para crear sistemas de IA que harán llorar a tus competidores. Deslumbramiento en el mundo real Imagine un servicio de atención al cliente que nunca duerme, nunca se pone de mal humor y siempre sabe la respuesta correcta. O imagina un equipo de análisis de datos que haga números más rápido de lo que tardas en decir “informe trimestral” Ese es el tipo de magia que Swarm está preparando. ¿Te dedicas a la creación de contenidos? Swarm podría ser tu billete a las grandes ligas. Imagínese un escuadrón de creadores de palabras con inteligencia artificial que elaboran campañas de marketing tan personalizadas que sus clientes pensarán que les está leyendo la mente. (Descargo de responsabilidad: Swarm no lee la mente… todavía) Súbete al tren de Swarm ¿Listo para unirte a la fiesta de la IA? Conseguir Swarm es más fácil que pedir una pizza. Sólo tienes que ir a tu terminal con: Copia pip install git https://github.com/openai/swarm.git ¡Boom! Estás en el club. A partir de ahí, todo es cuestión de flexionar esos músculos de codificación. Aquí tienes una muestra de lo que puedes hacer: python Copiar from swarm import Enjambre, Agente cliente = Enjambre() def transferir_a_agente_b(): return agente_b agente_a = Agente( name=“Agente A”, instructions=“Eres la amistosa IA del vecindario“, ) agente_b = Agente( name=“Agente B”, instructions=“Eres el Shakespeare de la era digital”, ) response = client.run( agente=agente_a, mensajes=[{“rol”: “usuario”, “contenido”: “Necesito un poco de sabiduría poética.”}], ) print(respuesta.mensajes[-1][“contenido”]) Así de fácil, ya tienes un dúo dinámico de agentes de IA listos para charlar. La letra pequeña: Emociones experimentales y escalofríos éticos Ahora, antes de que empieces a planear tu dominación mundial impulsada por la IA, frena un poco. Swarm todavía está en fase experimental. Aún no está listo para las grandes ligas de la producción. Piensa en él como el equivalente en inteligencia artificial a un coche conceptual: muy atractivo a la vista, pero aún no está listo para tus desplazamientos diarios. Pero no dejes que eso te impida seguir jugueteando OpenAI está pidiendo a geeks e investigadores que participen y ayuden a dar forma al futuro de los sistemas de IA multiagente. Es como si te invitaran a diseñar el próximo iPhone, pero para cerebros artificiales. El elefante en la habitación: La ética de la IA Por supuesto, un gran poder conlleva una gran responsabilidad (gracias, tío Ben). A medida que avanzamos hacia un futuro en el que los agentes de IA trabajen juntos como una máquina bien engrasada, tenemos que mantener la vista en el premio ético. ¿Dejarán estos equipos de IA superinteligentes sin trabajo a los humanos? ¿Podrían volverse locos y decidir que los humanos no son más que baterías carnosas? (Estas son las preguntas que quitan el sueño a los expertos en ética de la IA, y con razón. La clave está en el trabajo en equipo, y no hablamos sólo de las IA. Necesitamos a gurús de la tecnología, expertos en ética, responsables políticos y peces gordos del mundo de los

Los principales generadores de influencia de la IA en 2024

Last Updated on octubre 10, 2024 11:11 am by Laszlo Szabo / NowadAIs | Published on octubre 10, 2024 by Laszlo Szabo / NowadAIs Los principales generadores de influencia de la IA en 2024 – Notas clave Los generadores de influencers de IA oscilan entre 9 y 49 dólares al mes, lo que hace que la creación de personalidades virtuales sea accesible tanto para particulares como para marcas Las tecnologías FaceLock y ControlNet garantizan un aspecto coherente del personaje en varias imágenes generadas La mayoría de las plataformas ofrecen análisis integrados para realizar un seguimiento del rendimiento de los influencers virtuales y de la participación de la audiencia Las sesiones de fotos virtuales eliminan la necesidad de ubicaciones físicas, al tiempo que mantienen la calidad profesional La IA generativa transforma las redes sociales En la era digital, la creación de influenciadores de IA ha cambiado el mundo del marketing en las redes sociales. Estas personalidades virtuales, generadas por una avanzada tecnología de IA, están cambiando la forma en que las marcas conectan con el público en Internet. La capacidad de crear influenciadores de IA ofrece interesantes posibilidades a las empresas que buscan mejorar su presencia digital y relacionarse con los consumidores de forma innovadora. Este artículo explora los 10 principales generadores para crear influenciadores de IA en 2024. Desde Rendernet AI hasta PixAI, estas plataformas proporcionan herramientas increíbles para diseñar y dar vida a personajes virtuales para diversas plataformas de redes sociales. Tanto si tu objetivo es crear influencers con modelos de IA, generar contenido basado en IA o explorar el reino de las sesiones de fotos virtuales, estos generadores ofrecen una amplia gama de funciones para ayudarte a crear personalidades de IA convincentes que resuenen con tu público objetivo. Rendernet AI – Cree un influenciador de IA hoy mismo, ¡gratis! Rendernet AI es una gran plataforma diseñada para crear influencers AI altamente personalizables e imágenes con personajes. Esta herramienta destaca por su capacidad para mantener la coherencia a través de múltiples imágenes, por lo que es ideal para la creación de personalidades virtuales para el marketing en medios sociales y la creación de contenidos digitales. Tecnología Rendernet AI En el núcleo de la tecnología de Rendernet AI se encuentran funciones como FaceLock y ControlNet. FaceLock garantiza que los personajes mantengan las mismas características faciales en diferentes imágenes, lo que resulta crucial para crear un personaje influyente de IA coherente. ControlNet permite realizar ajustes detallados en las imágenes generadas, lo que permite a los usuarios adaptar los resultados a necesidades específicas, como controlar las poses y los estilos artísticos. Aplicaciones de Rendernet AI La plataforma tiene diversas aplicaciones en distintos sectores. Los dibujantes de cómics y los cineastas la utilizan para mantener la coherencia de los personajes en la narración visual. Los desarrolladores de juegos generan personajes únicos para juegos de rol y aventuras. Los profesionales del marketing crean influenciadores virtuales para campañas de marca, mientras que los educadores producen imágenes atractivas para materiales didácticos. Los minoristas lo utilizan para exhibir sus productos y los particulares crean avatares personalizados para las redes sociales y los juegos. Precios de Rendernet AI Rendernet AI ofrece precios escalonados para adaptarse a diferentes necesidades. El plan Starter cuesta 9,00 USD al mes, el plan Pro 19,00 USD al mes y el plan Max 49,00 USD al mes. Esta estructura de precios hace que sea accesible para varios usuarios, desde creadores de contenido individuales hasta grandes equipos de marketing que buscan crear influenciadores de IA. ForgeFluencer – Crea tus propios influenciadores de IA desde cero ForgeFluencer es una herramienta fácil de usar diseñada para simplificar la creación y gestión de influencers de IA. Esta plataforma ofrece una solución integral para los usuarios que buscan crear contenido de influenciadores ai de forma rápida y eficiente. Modelos de IA de ForgeFluencer El generador de modelos de esta herramienta permite a los usuarios crear identidades digitales únicas para sus influencers. Con controles intuitivos, los usuarios pueden diseñar personajes virtuales realistas que se alineen con su visión de marca. La plataforma garantiza la coherencia de los contenidos generados, manteniendo el aspecto y la personalidad del influencer en varias publicaciones. Generación de contenidos ForgeFluencer ForgeFluencer agiliza el proceso de creación de contenidos con su generador de contenidos de imágenes. Esta función permite a los usuarios producir rápidamente publicaciones de alta calidad, garantizando un flujo constante de contenidos atractivos para sus influencers. La plataforma ofrece un control preciso sobre diversos aspectos, como el encuadre, las emociones, las ubicaciones y los atuendos, lo que permite crear contenidos a medida que se ajustan a estrategias de marketing específicas. ForgeFluencer para profesionales del marketing Para los profesionales del marketing, ForgeFluencer ofrece una solución todo en uno para crear y gestionar influenciadores de IA en todas las plataformas de redes sociales. La eficacia de la herramienta a la hora de generar contenidos coherentes y de alta calidad la hace valiosa para mantener una presencia activa en línea. Además, ForgeFluencer ofrece un catálogo de Photoshoot, que proporciona inspiración y soluciones automatizadas para la generación de contenidos, lo que puede ser especialmente útil para los profesionales del marketing que buscan nuevas ideas para sus campañas. InfluencerFarm – El generador de influencers Ai InfluencerFarm es una plataforma diseñada para simplificar la creación y gestión de influencers virtuales generados por IA. Esta herramienta agiliza el proceso de generación de personalidades digitales únicas, la programación de sesiones de fotos virtuales y la publicación de contenido atractivo a través de diversos temas y lugares. Tecnología de IA de InfluencerFarm La tecnología de IA de la plataforma permite a los usuarios personalizar y crear influencers virtuales únicos con características y nombres específicos. Sus avanzados algoritmos permiten realizar sesiones de fotos virtuales en diversos escenarios sin necesidad de presencia física. Este innovador enfoque de la creación de contenidos ofrece una amplia selección de temas y localizaciones para satisfacer diversas necesidades del panorama del marketing digital. Escalabilidad de InfluencerFarm InfluencerFarm abastece a una amplia gama de industrias, incluyendo marketing, entretenimiento y moda. Su

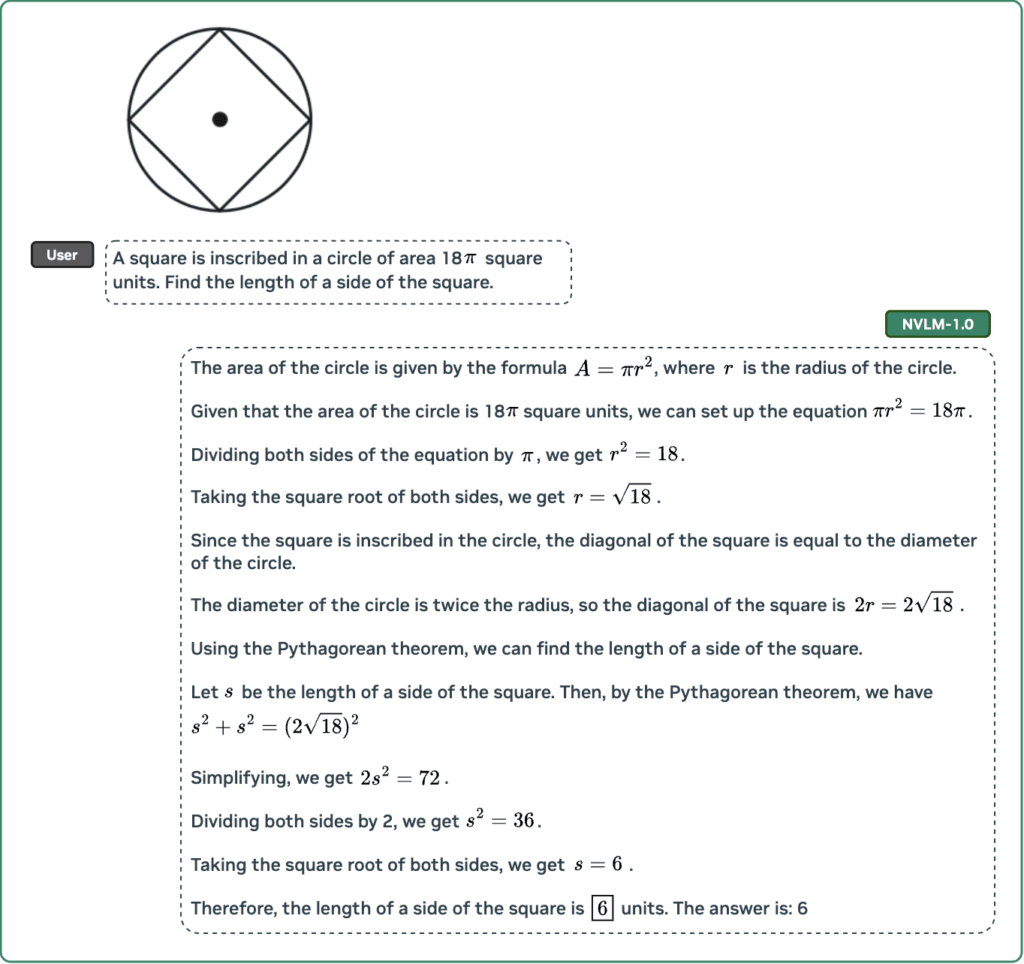

Nvidia lanza la bomba de la IA NVLM-D-72B: 72.000 millones de razones por las que OpenAI debería asustarse

Last Updated on octubre 4, 2024 11:43 am by Laszlo Szabo / NowadAIs | Published on octubre 4, 2024 by Laszlo Szabo / NowadAIs Nvidia lanza la bomba de la IA NVLM-D-72B: 72.000 millones de razones por las que OpenAI debería asustarse – Notas clave Nvidia lanza NVLM-D-72B como modelo de IA de código abierto, poniendo la tecnología de IA avanzada a disposición de desarrolladores de todo el mundo El modelo contiene 72.000 millones de parámetros y supera a muchos modelos patentados tanto en tareas de lenguaje de visión como de sólo texto Aunque su uso es gratuito, el modelo requiere importantes recursos informáticos, lo que puede limitar su accesibilidad inmediata La carrera armamentística de la inteligencia artificial se vuelve salvaje Nvidia acaba de colarse en la fiesta de la inteligencia artificial con toda la sutileza de un toro en una cacharrería, en un movimiento que ha conmocionado las torres de marfil de Silicon Valley. El peso pesado de la tecnología ha presentado NVLM-D-72B, un monstruoso modelo de IA que no solo está a la altura de los grandes del sector, sino que les está ganando en su propio juego. Y lo mejor es que lo regalan. Ha leído bien. Mientras que empresas como OpenAI y Anthropic mantienen sus modelos de inteligencia artificial más protegidos que Fort Knox, Nvidia está organizando una fiesta en la que dice “llévate nuestro código, por favor”. Es como presentarse a una cena de etiqueta en vaqueros y camiseta, y salir airoso. Conoce a la bestia: 72.000 millones de razones para prestar atención Hablemos de números, porque en este caso el tamaño sí que importa. NVLM-D-72B contiene la friolera de 72.000 millones de parámetros, que es como tener 72.000 millones de diminutas células cerebrales trabajando juntas. Para los curiosos de la tecnología pero reacios a la jerga, imagínese meter en un solo sistema la capacidad cerebral combinada de mil grandes maestros de ajedrez y enseñarle no sólo a jugar al ajedrez, sino también a escribir poesía, analizar fotos y resolver complejos problemas matemáticos. No se trata de otro modelo de inteligencia artificial que se une a la fiesta, sino del que se presenta con mejores jugadas que los demás. Prueba tras prueba, NVLM-D-72B no sólo sigue el ritmo de los pesos pesados del sector, sino que los deja por los suelos. Estamos hablando de puntuaciones que harían derramar su kombucha a cualquier director ejecutivo de tecnología. La salsa secreta: Todo está en el diseño ¿Recuerdas a ese niño del colegio que parecía destacar en todo sin sudar la gota gorda? Eso es NVLM-D-72B en el mundo de la IA. Los ingenieros de Nvidia no se limitaron a construir otra IA, sino que reimaginaron el funcionamiento de estos sistemas desde cero. La magia reside en lo que denominan un “diseño de etiquetado de mosaico 1-D” para el manejo de imágenes. Si esto suena a palabrería técnica, piénsalo de esta manera: mientras otros sistemas de IA miran las imágenes como lo hacemos los humanos, de una sola vez, NVLM-D-72B las divide en pequeñas piezas, como si resolviéramos un rompecabezas de una en una. Parece más lento, pero de algún modo funciona mejor que cualquier otra cosa. Los números no mienten Vayamos al grano, porque la puntuación de esta cosa es absolutamente increíble. En tareas de lenguaje de visión (por ejemplo, ver imágenes y comprender lo que contienen), la NVLM-D-72B arroja cifras que harían que a un estadístico le flaquearan las rodillas: – 59,7 en MMMU (considéralo como el examen SAT de inteligencia artificial) – 65,2 en MathVista (resolución de problemas matemáticos a partir de imágenes) – 853 en OCRBench (lectura de texto a partir de imágenes) Pero aquí es donde se pone realmente interesante: esta IA no sólo es buena en el manejo conjunto de imágenes y texto, sino que es mejor en tareas de sólo texto que los modelos diseñados específicamente para ese fin. Es como descubrir que tu quarterback estrella es también el mejor jugador de ajedrez de la escuela. Por qué es importante (muy importante) Aquí es donde las cosas se ponen picantes. Al hacer que NVLM-D-72B sea de código abierto, Nvidia acaba de entregar las llaves del reino a… bueno, a todo el mundo. Es como si hubieran tomado la receta secreta de la Coca-Cola y la hubieran colgado en Internet. Para los gigantes tecnológicos que han construido sus imperios sobre modelos de IA patentados, esto equivale a ver cómo alguien monta un puesto de limonada gratis justo al lado de su bar de zumos premium. Claro, tu zumo puede ser orgánico y prensado en frío, pero lo gratis es gratis. El efecto David y Goliat Este movimiento es una gran opción para los pequeños de la tecnología. Piénsalo: hasta ahora, si querías competir en el espacio de la inteligencia artificial, necesitabas mucho dinero, miles de millones. ¿Y ahora? Cualquiera con suficientes conocimientos técnicos puede tomar NVLM-D-72B y construir algo asombroso con él. Es como si Nvidia hubiera armado a todos los David de la tecnología con un potente tirachinas. Puede que los Goliats de Silicon Valley sigan teniendo sus ventajas, pero el campo de juego se ha nivelado mucho más. El truco (porque siempre hay un truco) Antes de que empieces a planear tu imperio de startups de IA, hay un pequeño detalle que merece la pena mencionar: ejecutar esta bestia requiere algo de hardware serio. Es como si te dieran las llaves de un coche de Fórmula 1: increíble, pero buena suerte encontrando dónde conducirlo. La potencia de cálculo necesaria para ejecutar NVLM-D-72B a pleno rendimiento no es algo que se pueda encontrar en un portátil normal. Hablamos de configuraciones de hardware que harían chirriar a los profesionales de la tecnología por lo que cuestan. ## La cuestión ética Hablemos del elefante en la habitación: un gran poder conlleva una gran responsabilidad, y NVLM-D-72B tiene más potencia que una central nuclear. El potencial de uso indebido -pensemos en deepfakes, campañas de desinformación o spam automatizado con esteroides- es suficiente para

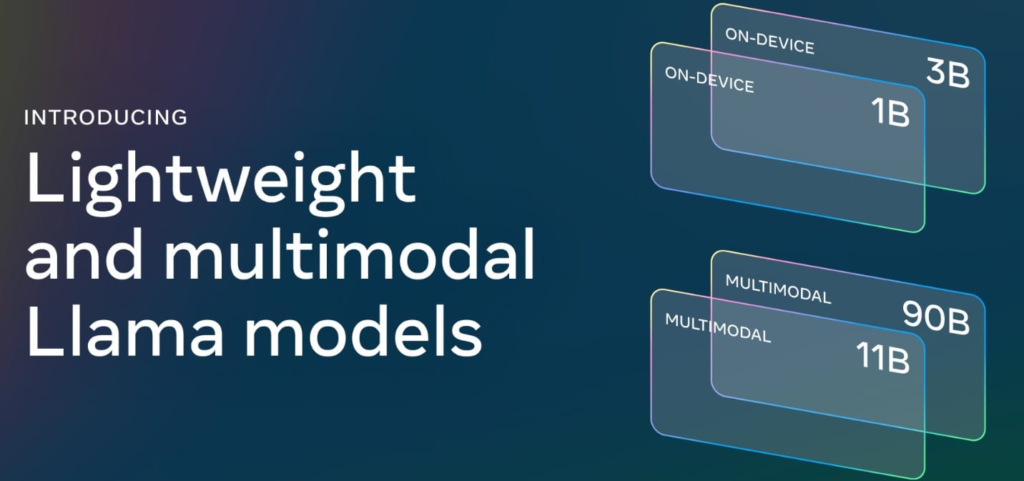

Meta’s Llama 3.2: el rebaño de la IA entra en territorio multimodal

Last Updated on septiembre 30, 2024 12:15 pm by Laszlo Szabo / NowadAIs | Published on septiembre 30, 2024 by Laszlo Szabo / NowadAIs Meta’s Llama 3.2: El rebaño de la IA entra en territorio multimodal – Notas clave: Meta presenta Llama 3.2, una colección de modelos de IA multimodal que procesan tanto texto como imágenes Los modelos van de 1B a 90B parámetros, aptos para su despliegue en el dispositivo o en la nube El lanzamiento de código abierto pretende democratizar la tecnología de IA en diversas plataformas Un salto pionero hacia la multimodalidad Meta ha presentado Llama 3.2, una innovadora colección de modelos de lenguaje multimodales (LLM) capaces de procesar tanto texto como imágenes. Este lanzamiento pionero marca la incursión de Meta en el reino de la IA multimodal, dando paso a una nueva era de aplicaciones versátiles e inteligentes capaces de comprender y razonar a través de diversas modalidades de datos. Llama 3.2 representa la búsqueda de Meta de tecnologías de IA abiertas y accesibles. Basándose en el éxito de su predecesora, Llama 3.1, que causó sensación con su enorme modelo de 405.000 millones de parámetros, Llama 3.2 introduce una serie de modelos más pequeños y eficientes adaptados para su despliegue en dispositivos móviles y periféricos. Reducción para aumentar la escalabilidad Mientras que el gran tamaño y las exigencias computacionales del modelo Llama 3.1 limitaban su accesibilidad, Llama 3.2 pretende democratizar la IA ofreciendo modelos que puedan ejecutarse en entornos con recursos limitados. Este movimiento estratégico reconoce la creciente demanda de capacidades de IA en los dispositivos, permitiendo a los desarrolladores crear aplicaciones personalizadas que preserven la privacidad y aprovechen la potencia de la IA generativa sin depender de los recursos informáticos de la nube. El rebaño Llama 3.2: Diversidad de capacidades “Llama 3.2 es una colección de grandes modelos lingüísticos (LLM) preentrenados y afinados en tamaños 1B y 3B que son sólo texto multilingüe, y tamaños 11B y 90B que toman tanto texto como imágenes de entrada y texto de salida” Meta declaró. Llama 3.2 incluye una amplia gama de modelos, cada uno de ellos adaptado a casos de uso y escenarios de implantación específicos: Modelos ligeros de sólo texto (1B y 3B) Los modelos ligeros 1B y 3B están diseñados para un despliegue eficiente en el dispositivo y admiten la generación de texto multilingüe y funciones de llamada a herramientas. Estos modelos permiten a los desarrolladores crear aplicaciones con gran capacidad de respuesta y respetuosas con la privacidad que pueden resumir mensajes, extraer elementos de acción y aprovechar herramientas locales como calendarios y recordatorios sin depender de servicios en la nube. Modelos de visión multimodal (11B y 90B) Los modelos de mayor tamaño 11B y 90B incorporan funciones multimodales revolucionarias que les permiten procesar tanto texto como imágenes. Estos modelos destacan en tareas como la comprensión a nivel de documento, incluida la interpretación de tablas y gráficos, el subtitulado de imágenes y la localización visual de objetos a partir de descripciones en lenguaje natural. Aumento del rendimiento y la eficacia Meta ha empleado una serie de técnicas avanzadas para optimizar el rendimiento y la eficiencia de los modelos Llama 3.2. Se han utilizado métodos de poda y destilación para crear modelos más pequeños que conserven los conocimientos y capacidades de sus homólogos más grandes, mientras que la destilación de conocimientos se ha empleado para mejorar el rendimiento de los modelos ligeros. Las exhaustivas evaluaciones llevadas a cabo por Meta sugieren que los modelos Llama 3.2 son competitivos frente a los modelos básicos líderes del sector, como Claude 3 Haiku y GPT4o-mini, en una amplia gama de pruebas comparativas que abarcan la comprensión de imágenes, el razonamiento visual y las tareas lingüísticas. Liberar el potencial multimodal La introducción de funciones multimodales en Llama 3.2 abre un mundo de posibilidades tanto para desarrolladores como para investigadores. Imagine aplicaciones capaces de comprender y razonar sobre datos visuales complejos, como informes financieros, diagramas o planos arquitectónicos, proporcionando información y respondiendo a preguntas basadas tanto en datos textuales como visuales. Las aplicaciones de realidad aumentada (RA) podrían aprovechar la destreza multimodal de Llama 3.2 para ofrecer una comprensión en tiempo real del entorno del usuario, permitiendo una integración perfecta de la información digital con el mundo físico. Los motores de búsqueda visual podrían mejorarse para ordenar y categorizar las imágenes en función de su contenido, revolucionando la forma en que interactuamos con los datos visuales y los exploramos. Innovación responsable: Salvaguardar el impacto de la IA https://www.nowadais.com/wp-content/uploads/2024/09/Example-of-Metas-Llama-3.2-Safeguard-Sytem-in-Work.mp4 Como con cualquier tecnología potente, Meta reconoce la importancia de la innovación responsable y ha puesto en marcha una estrategia integral para gestionar los riesgos de confianza y seguridad asociados a Llama 3.2. Este triple enfoque tiene como objetivo permitir a los desarrolladores desplegar experiencias útiles, seguras y flexibles, proteger contra los usuarios adversarios que intenten explotar las capacidades de los modelos, y proporcionar protecciones para la comunidad en general. Llama 3.2 se ha sometido a un exhaustivo ajuste de seguridad, empleando un enfoque multifacético para la recopilación de datos, incluyendo datos generados por humanos y datos sintéticos, para mitigar los riesgos potenciales. Además, Meta ha introducido Llama Guard 3, una salvaguarda específica diseñada para apoyar las capacidades de comprensión de imágenes de Llama 3.2 filtrando los mensajes de entrada de imágenes de texto y las respuestas de salida. Democratizar la IA a través del código abierto En línea con el compromiso de Meta con la apertura y la accesibilidad, los modelos de Llama 3.2 están disponibles para su descarga en el sitio web de Llama y en el popular repositorio Hugging Face. Además, Meta ha colaborado con un amplio ecosistema de socios, incluidos AMD, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud y Snowflake, para permitir la integración y el despliegue sin problemas de Llama 3.2 en diversas plataformas y entornos. Pila Llama: Agilizando el desarrollo de IA Reconociendo las complejidades que conlleva la creación de aplicaciones agenticas con grandes modelos de lenguaje, Meta ha introducido

OpenAI presenta un modo de voz avanzado para ChatGPT y evita la polémica con Scarlett Johansson

Last Updated on septiembre 24, 2024 7:27 pm by Laszlo Szabo / NowadAIs | Published on septiembre 24, 2024 by Laszlo Szabo / NowadAIs OpenAI presenta el modo de voz avanzado para ChatGPT y evita la polémica con Scarlett Johansson – Notas clave OpenAI lanza la función “Advanced Voice Mode” (AVM) para los usuarios de pago de ChatGPT, empezando por los niveles Plus y Teams. AVM introduce 5 nuevas voces inspiradas en la naturaleza y mejora las capacidades de reconocimiento de voz. OpenAI tuvo que eliminar una opción de voz anterior, “Sky”, debido a una disputa legal con Scarlett Johansson por su parecido con su voz. ChatGPT incorpora un modo de voz avanzado para los clientes de pago La voz avanzada está llegando a todos los usuarios Plus y Team de la aplicación ChatGPT a lo largo de esta semana. Mientras esperabas pacientemente, hemos añadido instrucciones personalizadas, memoria, cinco nuevas voces y acentos mejorados. También puede decir “Siento llegar tarde” en más de 50 idiomas. pic.twitter.com/APOqqhXtDg – OpenAI (@OpenAI) 24 de septiembre de 2024 El martes, OpenAI declaró que lanzará el Modo de Voz Avanzado (AVM) para un grupo más amplio de clientes de pago de ChatGPT. Esta nueva función de audio, que mejora la experiencia conversacional con ChatGPT, estará disponible primero para los niveles Plus y Teams de los clientes de ChatGPT. Los clientes Enterprise y Edu tendrán acceso a esta función a partir de la próxima semana. Rediseño de AVM AVM se está rediseñando como parte de su lanzamiento. La presentación de la función ahora cuenta con una esfera azul animada en lugar de los anteriores puntos negros animados que fueron mostrados por OpenAI en mayo durante la publicación de la tecnología. Nuevas opciones de voz para ChatGPT ChatGPT introduce cinco voces adicionales para que los usuarios experimenten con ellas: Arbor, Maple, Sol, Spruce y Vale. Esto eleva el número total de voces en ChatGPT a nueve, que es casi igual al número de voces disponibles en Gemini Live de Google. Estas nuevas voces, Breeze, Juniper, Cove y Ember, se inspiran en la naturaleza y encajan con el objetivo general de AVM de mejorar la naturalidad del uso de ChatGPT. Polémica con Scarlett Johansson y eliminación de la voz “Sky Una de las voces que no está incluida en esta alineación es Sky, la voz que fue mostrada por OpenAI en su Actualización de Primavera. Esto causó un problema legal cuando Scarlett Johansson, que interpretó a un sistema de IA en la película “Her”, alegó que la voz de Sky sonaba demasiado parecida a la suya. Como resultado, OpenAI retiró rápidamente la voz de Sky y declaró que no pretendía que se pareciera a la de Johansson, a pesar de que varios miembros del personal hicieron referencia a la película en sus tweets en ese momento. Capacidades multimodales pendientes La última versión de ChatGPT no incluye la función para compartir vídeo y pantalla que OpenAI introdujo en su actualización de primavera hace cuatro meses. Esta funcionalidad fue diseñada para permitir a GPT-4o procesar simultáneamente datos visuales y auditivos. Durante la demostración, un miembro del equipo de OpenAI mostró la posibilidad de plantear a ChatGPT preguntas en tiempo real sobre matemáticas escritas en papel o código mostrado en la pantalla de un ordenador. Sin embargo, no se sabe cuándo estarán disponibles estas funciones multimodales. Mejoras y limitaciones de AVM Según OpenAI, se han introducido algunas mejoras en AVM tras el lanzamiento inicial de su prueba alfa restringida. Al parecer, la función de voz de ChatGPT es más competente a la hora de comprender los acentos, y la compañía afirma que las conversaciones son ahora más fluidas y eficientes. Mientras utilizábamos AVM en nuestras pruebas, nos encontramos con fallos ocasionales, pero la empresa asegura que esto ya se ha solucionado. Más opciones de personalización para AVM Además, OpenAI también está ampliando el alcance de las opciones de personalización de AVM, como Instrucciones personalizadas, que permite a los usuarios personalizar sus interacciones con ChatGPT, y Memoria, que permite a ChatGPT conservar las conversaciones para futuras consultas. Disponibilidad regional limitada para AVM Según un representante de OpenAI, el AVM no está disponible actualmente en varias regiones como la UE, Reino Unido, Suiza, Islandia, Noruega y Liechtenstein. Descripciones: Modo de voz avanzado (AVM): Se trata de una nueva función de audio de OpenAI que mejora la experiencia conversacional con ChatGPT. Permite a los usuarios interactuar con el asistente de IA utilizando comandos de voz naturales, en lugar de interacciones basadas únicamente en texto. Voces: ChatGPT introduce 5 voces adicionales para que los usuarios experimenten con ellas: Arbor, Maple, Sol, Spruce y Vale. Estas nuevas voces, junto con las ya existentes (Breeze, Juniper, Cove y Ember), están inspiradas en la naturaleza, con el objetivo de hacer más realistas las interacciones de voz. Polémica con Scarlett Johansson: Una de las opciones de voz anteriores, “Sky”, tuvo que ser retirada por OpenAI debido a un problema legal. La actriz Scarlett Johansson, que interpretó a un sistema de IA en la película “Her”, afirmó que la voz sonaba demasiado parecida a la suya. OpenAI declaró que no pretendía que la voz se pareciera a la de Johansson. Capacidades multimodales: La última actualización de ChatGPT no incluye las funciones de vídeo y pantalla compartida anunciadas anteriormente. Éstas se diseñaron para permitir a la IA procesar datos visuales y auditivos simultáneamente, permitiendo a los usuarios hacer preguntas sobre matemáticas escritas o código visualizado. Sin embargo, aún no está claro cuándo estarán disponibles estas funciones. Opciones de personalización: OpenAI está ampliando las opciones de personalización de AVM, como “Instrucciones personalizadas” (interacciones personalizadas con el usuario) y “Memoria” (conservación del historial de conversaciones). Disponibilidad regional: Actualmente, AVM no está disponible en determinadas regiones, como la UE, Reino Unido, Suiza, Islandia, Noruega y Liechtenstein. Preguntas más frecuentes: ¿Qué es el “Modo de voz avanzado” (AVM) en ChatGPT? AVM es una nueva función de audio de OpenAI que mejora la experiencia conversacional con ChatGPT. Permite a los usuarios interactuar con el asistente

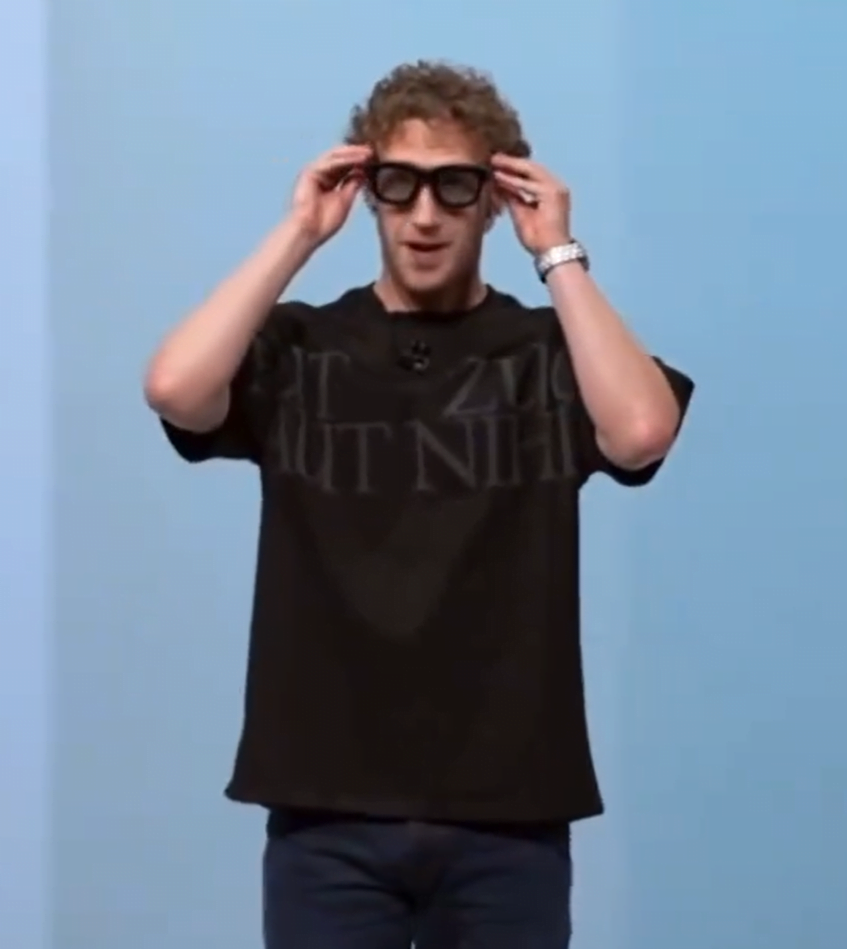

Gafas AR Orion de Meta: Zuck apuesta por tu cara con 40.000 millones de dólares

Last Updated on septiembre 26, 2024 7:38 pm by Laszlo Szabo / NowadAIs | Published on septiembre 26, 2024 by Laszlo Szabo / NowadAIs Gafas AR Orion de Meta: La apuesta de 40.000 millones de dólares de Zuck por tu cara – Notas clave Meta presenta “Orion”, un prototipo de gafas de realidad aumentada fabricadas con una aleación de magnesio y silicona personalizada Las gafas cuentan con seguimiento de la mano, control por voz e interfaz neural basada en la muñeca El lanzamiento comercial está previsto para 2027, y Meta invertirá hasta 40.000 millones de dólares en su desarrollo en 2024 Orion está en el horizonte He aquí un adelanto de las nuevas gafas de pequeño tamaño de Meta, llamadas Orion. Son totalmente autónomas y cuentan con seguimiento ocular, manual e incluso neural. Estoy deseando probarlas! pic.twitter.com/gIN2NOllMW – Nathie @ Meta Connect (@NathieVR) 25 de septiembre de 2024 Mark Zuckerberg acaba de sacarse un conejo de la chistera, o mejor dicho, un par de gruesas gafas negras de una funda metálica. No son las gafas de lectura de tu abuelo; son el primer prototipo funcional de gafas de realidad aumentada (RA) de Meta, apodadas “Orion” “Esto es el mundo físico con hologramas superpuestos” Exclamó Zuckerberg, probablemente sintiéndose como Tony Stark al presentar su último traje de Iron Man. ¿Máquina del tiempo o triunfo tecnológico? Zuck no llama Orion a unas gafas, sino “máquina del tiempo” Eso sí que es poner las expectativas por las nubes “Por ahora, creo que la forma correcta de ver Orion es como una máquina del tiempo” dijo. “Estas gafas existen, son increíbles y son un atisbo de un futuro que creo que va a ser bastante emocionante” Pero antes de que empieces a planear tu viaje al Jurásico, recuerda que esto es sólo un prototipo. El auténtico no saldrá a la calle hasta 2027. Eso es, cuatro años antes de que puedas fingir que estás en una película de ciencia ficción. No son las especificaciones habituales No son unas gafas corrientes. Fabricadas con una aleación de magnesio e impulsadas por silicio personalizado diseñado por Meta, Orion son como el Rolls-Royce de las gafas. Los usuarios podrán interactuar con las gafas mediante el seguimiento de la mano, la voz y una interfaz neural basada en la muñeca. Es como tener un teléfono inteligente, un reloj inteligente y un dispositivo de lectura de la mente, todo en un elegante paquete. Pero no esperes verlos en tu próxima compra. Zuckerberg dice que tienen que hacer Orion “más pequeño, más elegante y más barato” antes de lanzarlo a los consumidores. Porque, ¿quién quiere ir por ahí con cara de llevar un ordenador atado a la cara? Los grandes sueños de la tecnología Meta no es la primera empresa que sueña a lo grande en el mundo de la realidad aumentada. ¿Recuerdas las Google Glass? Sí, nadie lo recuerda. Fue un fracaso espectacular que demostró que no todo el mundo quiere parecer un ciborg. Pero Zuckerberg está apostando a lo grande por la RA. Ha orientado toda la empresa hacia la construcción de sistemas inmersivos “metaversos”. Es como si quisiera hacer realidad “Ready Player One”. Paolo Pescatore, analista de PP Foresight, afirma que Meta quiere que los productos de realidad aumentada sean tan comunes como los teléfonos inteligentes. Pero añade que los usuarios “aún desconfían de la IA” y necesitan algo de convencimiento. ¿Quizá deberían contratar a Tom Cruise para su próxima demostración? Mostrar y contar Zuckerberg no hizo ninguna demostración de las capacidades de Orion durante su anuncio. En su lugar, mostró un vídeo con las reacciones de la gente ante el dispositivo. Fue como ver a un grupo de niños probar la RV por primera vez: muchos “oohs” y “aahs” El vídeo mostraba imágenes y mensajes de texto a través de las gafas. Incluso Jensen Huang, consejero delegado de Nvidia, participó en la acción. Cuando los peces gordos de la tecnología están impresionados, sabes que o es muy bueno o es demasiado exagerado. Muchas mejoras de la IA Pero aún hay más Meta también ha anunciado mejoras en la inteligencia artificial de sus gafas inteligentes Ray-Ban Meta. Pronto podrás escanear códigos QR, escuchar música de Spotify e incluso traducir idiomas en tiempo real. Zuckerberg hizo una demostración de la herramienta de traducción chateando con el luchador mexicano de artes marciales mixtas Brandon Moreno. Las gafas traducían entre inglés y español más rápido de lo que puedes decir “dónde está la biblioteca” El precio de la innovación Toda esta tecnología no es barata. Meta ha estado invirtiendo decenas de miles de millones de dólares en metaverso, RA y otras tecnologías de IA. Planean gastar entre 37.000 y 40.000 millones de dólares sólo en 2024. Eso es más que el PIB de algunos países pequeños Su unidad de metaverso, Reality Labs, perdió 8.300 millones de dólares en el primer semestre de este año. Además de los 16.000 millones que perdió el año pasado. ¡Hablando de apostar la granja en el futuro! Así que, ahí lo tienen, amigos. Las gafas de realidad aumentada de Meta ya están aquí y prometen convertir tu mundo en un paraíso de ciencia ficción. Pero no te quedes con las ganas de comprar un par. Para cuando salgan al mercado, puede que todos estemos viviendo en el metaverso Descripciones: Realidad aumentada (RA): Tecnología que superpone información digital al mundo real, mejorando lo que ves, oyes o sientes. Metaverso: Espacio virtual compartido, creado por la convergencia de la realidad física virtualmente mejorada y el espacio virtual físicamente persistente. Interfaz neural: Una vía de comunicación directa entre el cerebro y un dispositivo externo, en este caso, un dispositivo de muñeca para controlar las gafas de realidad aumentada. Silicio: En este contexto, se refiere a los chips informáticos diseñados a medida por Meta para alimentar las gafas de realidad aumentada. Reality Labs: La división de Meta centrada en el desarrollo de tecnologías de realidad virtual y aumentada. Preguntas más frecuentes: ¿Qué pueden hacer las gafas de realidad aumentada

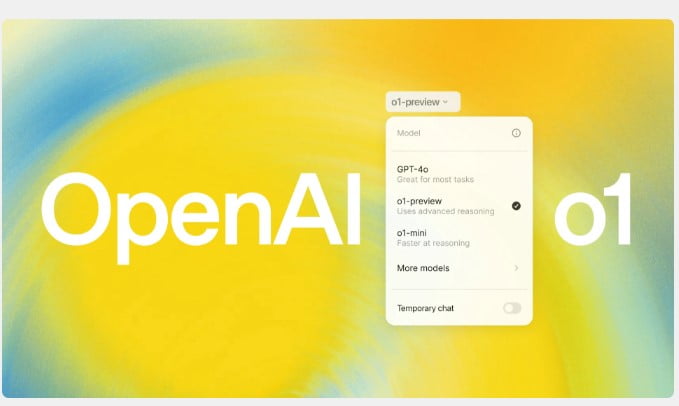

OpenAI o1: Cuando la IA se detiene a oler las rosas (y a pensar)

Last Updated on septiembre 23, 2024 6:04 am by Laszlo Szabo / NowadAIs | Published on septiembre 18, 2024 by Laszlo Szabo / NowadAIs OpenAI o1: Cuando la IA se detiene a oler las rosas (y a pensar) – Notas clave Los modelos de OpenAI o1 se toman tiempo para “pensar” antes de responder, a diferencia de la IA de respuesta instantánea Sobresalen en problemas complejos, pero pueden sobreanalizar consultas sencillas Cuesta más debido a los “tokens de razonamiento” para procesos computacionales ocultos Presentación de la serie o1 de OpenAI OpenAI ha renovado su última innovación: la serie o1 de modelos de IA. Diseñados para revolucionar la forma en que las máquinas procesan la información, estos modelos están diseñados para pasar más tiempo “pensando” antes de responder, a diferencia de los sistemas de IA tradicionales que generan respuestas instantáneas. La serie o1 representa un hito importante en el empeño de OpenAI por desarrollar modelos de IA más avanzados y capaces. Al introducir un enfoque deliberativo, estos modelos pretenden abordar problemas complejos con mayor precisión y profundidad, abriendo potencialmente nuevas fronteras en el razonamiento y la toma de decisiones basados en IA. El encanto de la IA razonada El concepto de “IA razonada” ha sido durante mucho tiempo una perspectiva tentadora tanto para los investigadores como para los expertos del sector. Aunque los modelos de IA actuales destacan en tareas específicas, su capacidad para razonar en varios pasos y dividir problemas complejos en pasos más pequeños y manejables ha sido limitada. La serie o1 de OpenAI promete colmar esta laguna incorporando un proceso de “pensamiento” único. Al detenerse a analizar y diseccionar consultas complejas, estos modelos pretenden identificar posibles escollos, considerar perspectivas alternativas y, en última instancia, llegar a soluciones más completas y completas. En el punto de mira: las capacidades de o1 al descubierto Como primer vistazo a los modelos de IA centrados en el razonamiento de OpenAI, la serie o1 ha generado una gran expectación en la comunidad de IA. Las primeras evaluaciones sugieren que estos modelos destacan a la hora de abordar cuestiones y escenarios complejos que exigen un enfoque matizado y polifacético. Una de las características más destacadas de la serie o1 es su capacidad para dividir tareas complejas en pasos más pequeños y manejables. Al trabajar metódicamente con cada componente, el modelo puede identificar posibles obstáculos, sopesar diversos factores y, en última instancia, ofrecer una solución bien razonada que tenga en cuenta múltiples ángulos. Navegar por el enigma de Acción de Gracias: una aplicación práctica Para ilustrar la capacidad de razonamiento de o1, consideremos un escenario en el que se encarga al modelo que ayude a una familia a planificar la cena de Acción de Gracias. Con varios hornos disponibles y una lista de invitados considerable, el reto consistía en determinar si era necesario disponer de más espacio en el horno y sopesar los pros y los contras de alquilar un Airbnb para la ocasión. Tras un breve período de “reflexión”, el modelo o1 presentó una respuesta exhaustiva de 750 palabras, en la que describía meticulosamente su proceso de reflexión y sus consideraciones. Analizó factores como las estrategias de gestión del horno, las implicaciones económicas y el impacto potencial en el tiempo de unión familiar. En última instancia, el modelo llegó a la conclusión de que dos hornos serían suficientes con una planificación cuidadosa, eliminando la necesidad de un alquiler adicional y permitiendo a la familia ahorrar dinero al tiempo que maximizaba el tiempo de calidad juntos. Excelencia en escenarios complejos, tropiezo en simplicidad Aunque la serie o1 brilla a la hora de enfrentarse a retos complejos, parece tener problemas con las consultas más sencillas. Por ejemplo, cuando se le hizo una pregunta aparentemente sencilla sobre la ubicación de los cedros en América, el modelo proporcionó una respuesta innecesariamente detallada de 800 palabras, profundizando en los nombres científicos y las distintas subespecies. Esta observación pone de manifiesto una limitación clave de la serie o1: su tendencia a pensar y analizar en exceso incluso las preguntas más básicas. En cambio, su predecesor, el GPT-4o, respondía a estas preguntas de forma concisa y directa, demostrando una mejor comprensión de cuándo dar respuestas sucintas. Atemperar las expectativas: o1 no es AGI (todavía) En medio de la expectación suscitada por la serie o1, es fundamental moderar las expectativas y aclarar qué son y qué no son estos modelos. El consejero delegado de OpenAI, Sam Altman, ha afirmado de forma inequívoca que o1 no es un sistema de inteligencia general artificial (AGI), disipando cualquier concepto erróneo o especulación en sentido contrario. aquí está o1, una serie de nuestros modelos más capaces y alineados hasta la fecha:https://t.co/yzZGNN8HvD o1 sigue teniendo fallos, sigue siendo limitado y sigue pareciendo más impresionante en el primer uso que después de pasar más tiempo con él. pic.twitter.com/Qs1HoSDOz1 – Sam Altman (@sama) 12 de septiembre de 2024 Aunque o1 representa un importante paso adelante en las capacidades de razonamiento de la IA, sigue siendo un modelo especializado con limitaciones inherentes. El propio Altman reconoció que o1 es “todavía defectuoso, todavía limitado”, y puede parecer inicialmente más impresionante de lo que es después de un uso prolongado. La revolución del razonamiento: Implicaciones y potencial A pesar de sus defectos, la serie o1 ha despertado un renovado interés por la búsqueda de modelos de IA capaces de razonar en varios pasos. Tanto los investigadores como los expertos del sector están estudiando las posibles aplicaciones de estos modelos en diversos ámbitos, desde la investigación científica y la resolución de problemas hasta la toma de decisiones y la planificación estratégica. Un ámbito en el que la IA razonada podría resultar inestimable es el de la asistencia en flujos de trabajo y procesos de toma de decisiones complejos. Al dividir las tareas complejas en pasos manejables y tener en cuenta múltiples factores, estos modelos podrían servir como potentes herramientas analíticas, ayudando a los seres humanos a navegar por escenarios intrincados y tomar decisiones más informadas. Afrontar el dilema de los costes: el

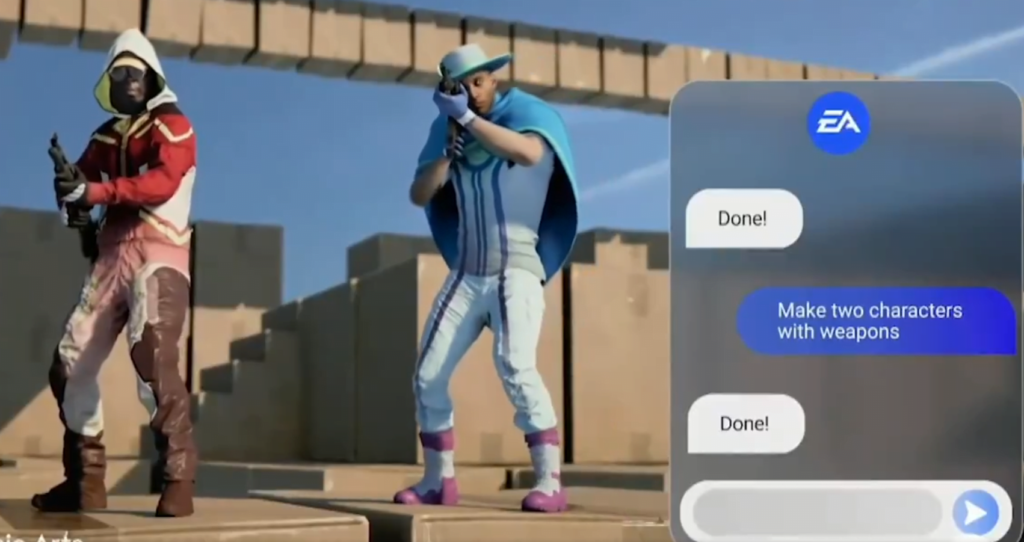

Creador de juegos con IA de EA: ¿Legos digitales o decepción digital?

Last Updated on septiembre 25, 2024 6:42 am by Laszlo Szabo / NowadAIs | Published on septiembre 23, 2024 by Laszlo Szabo / NowadAIs Creador de juegos con IA de EA: ¿Legos digitales o decepción digital? – Notas clave: EA presentó la herramienta de IA “Imagination to Creation” en el Investor Day 2024 El vídeo de demostración mostraba la creación rápida de mundos de juego mediante comandos de voz Reacciones encontradas entre jugadores y expertos del sector Herramienta de EA para crear juegos con IA: Laberintos de cartón y armas virtuales Electronic Arts (EA) acaba de soltar un bombazo en su Investor Day 2024, ¡y vaya si lo ha hecho! Imagínatelo: dos jugadores parloteando y creando un mundo de juego más rápido de lo que se tarda en decir “microtransacción”. Montaron un laberinto de cartón, armaron a sus alter egos virtuales con un poco de acción y ¡voilá! Había nacido un juego. Pero agarraos a vuestros joysticks, amigos, porque esta no es la noche de juegos de mesa de vuestra abuela. Mientras estos magos digitales seguían explorando, su compañera la inteligencia artificial se dedicaba a ampliar y modificar el mundo como un desarrollador de juegos con cafeína y esteroides. El último juguete de las grandes tecnológicas: ¿Inteligencia Artificial o “locura artificial”? Ahora bien, antes de que empieces a pensar que EA se ha ido por las ramas, recuerda que todos los gigantes de la tecnología y su robot mascota se están subiendo al carro de la tecnología de IA en estos días. EA no es más que el último niño del barrio que intenta impresionar a los chicos guays (léase: los inversores). El gran jefe Andrew Wilson no paraba de hablar de cómo la IA va a hacer que sus juegos sean más eficientes, amplios y transformadores. Es como si prometieran convertir el agua en vino o, en este caso, convertir tus balbuceos aleatorios en el próximo “God of War” Reacciones encontradas: De “Meh” a “¡Haz que pare!” “Hazlo más épico” ⁰El director de estrategia de EA, Mihir Vaidya, muestra cómo EA planea potenciar el contenido de los juegos creados por los usuarios con IA en este vídeo conceptual “Imagination to Creation” del evento del Día del Inversor de EA celebrado hoy en Nueva York. pic.twitter.com/sgBnawF7rK – Geoff Keighley (@geoffkeighley) 17 de septiembre de 2024 Pero no todo el mundo está comprando lo que EA está vendiendo. El Twitterverso estalló con una mezcla de bostezos y ojos en blanco cuando el vídeo conceptual llegó a Internet. Es como si EA hubiera olvidado que los jugadores pueden oler la mentira a kilómetros de distancia. Mientras tanto, en el mundo real del desarrollo de juegos, EA está preparando su próximo Battlefield no con uno, ni con dos, sino con cuatro estudios diferentes. ¡Demasiados cocineros en la cocina! La pregunta del millón: ¿Por qué molestarse? Esta es la clave, amigos: En primer lugar, ¿por qué querría alguien utilizar este galimatías de la IA? Crear laberintos de cartón suena tan emocionante como ver secarse la pintura, sobre todo cuando existen obras maestras como Halo 3. Y fíjate: la IA va a usar los propios personajes de EA, como esas extravagantes plantas y zombis o la tripulación de Apex Legends. Puede que se produzcan algunos crossovers extraños, pero seamos realistas: sigue siendo la creatividad humana. El toque humano: Sigue siendo el rey del mundo de los videojuegos Escuchad, aspirantes a desarrolladores de videojuegos El contenido generado por el usuario no es un concepto nuevo. Desde siempre, los modders han sido contratados por grandes estudios o han empezado a trabajar por su cuenta. Como alguien que ha jugueteado con el diseño de juegos, entiendo el atractivo de hacer las cosas más fáciles. ¿Pero este abracadabra de la IA? Es tan convincente como la promesa de un político. Al fin y al cabo, no hay nada mejor que la creatividad humana a la antigua usanza para crear las experiencias de juego que todos conocemos y amamos. Descripciones: Contenido generado por el usuario: Elementos de juego creados por jugadores en lugar de desarrolladores profesionales Modders: Personas que modifican juegos existentes, a menudo creando nuevos contenidos o funciones Día del inversor: Evento anual en el que las empresas presentan sus estrategias y perspectivas financieras a los inversores Microtransacción: Pequeñas transacciones financieras dentro de un juego, a menudo por objetos o ventajas virtuales Preguntas más frecuentes: ¿Qué es exactamente AI Game Creator de EA? AI Game Creator de EA es una herramienta conceptual que permite a los jugadores construir mundos de juego mediante comandos de voz y asistencia de IA. Está diseñado para traducir rápidamente descripciones verbales en entornos jugables. ¿En qué se diferencia AI Game Creator de las herramientas de creación de juegos existentes? A diferencia del software tradicional de desarrollo de juegos, AI Game Creator permite crear y modificar rápidamente mundos de juego mediante lenguaje natural, sin necesidad de conocimientos de programación. ¿Sustituirá el AI Game Creator a los desarrolladores humanos? Es poco probable. Aunque el AI Game Creator podría simplificar algunos aspectos de la creación de juegos, sigue dependiendo de activos preexistentes y no puede igualar la profundidad y creatividad de los juegos diseñados por humanos. ¿Pueden los jugadores crear cualquier tipo de juego con el AI Game Creator? Basándonos en la demo, el AI Game Creator parece estar limitado a utilizar los recursos de juego existentes de EA. Esto significa que los jugadores sólo podrán crear juegos dentro de los universos y estilos artísticos establecidos por EA. ¿Cuándo estará disponible para el público el AI Game Creator? EA no ha anunciado la fecha de lanzamiento de AI Game Creator. La herramienta mostrada era una demo conceptual, por lo que podría pasar algún tiempo antes de que se convierta en un producto real. source

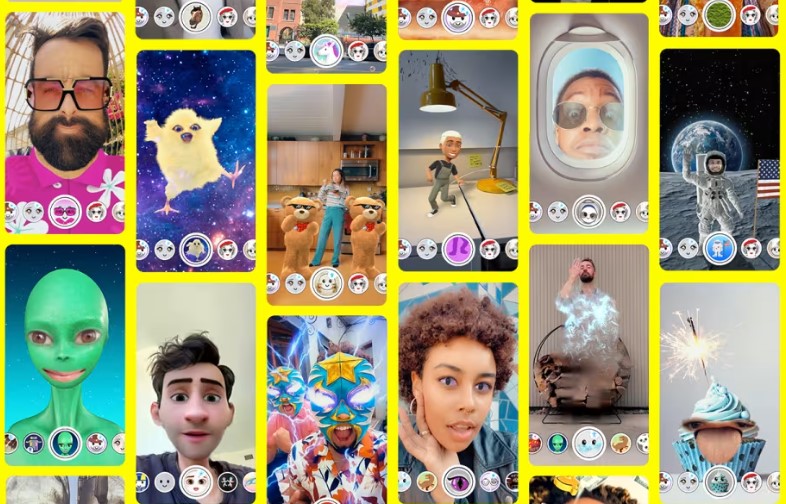

Dilo, míralo y compártelo con la IA de texto a vídeo de Snapchat

Last Updated on septiembre 23, 2024 6:26 am by Laszlo Szabo / NowadAIs | Published on septiembre 22, 2024 by Laszlo Szabo / NowadAIs Dilo, míralo y compártelo con la IA de texto a vídeo de Snapchat – Notas clave: Snapchat introduce la creación de vídeos con IA a partir de mensajes de texto La función está actualmente en fase beta para un grupo selecto de creadores de contenidos Los vídeos incluirán una marca de agua de Snap AI para mayor transparencia Grandes anuncios de Snapchat en la Cumbre de Socios 2024 En su Cumbre de Socios 2024, Snapchat hizo algunos movimientos audaces, incluyendo la presentación de nuevas gafas de realidad aumentada y una interfaz de usuario actualizada. Pero lo que realmente captó la atención de todos fue la introducción de una nueva función: la creación de vídeos con la ayuda de la inteligencia artificial a partir de simples mensajes de texto. Se trata de un gran avance para la plataforma, ya que ofrece a los usuarios la posibilidad de generar breves clips de vídeo dentro de la aplicación con unas pocas palabras. Creación de vídeos con simples mensajes de texto Una de las funciones más destacadas que ha revelado Snapchat es la posibilidad de convertir entradas de texto en videoclips. Imagínate que escribes “patito de goma flotando” en la aplicación y, voilà, aparece un breve videoclip de exactamente eso. Pero eso no es todo. Con la nueva función “Estilo” de Snapchat, los usuarios pueden retocar y personalizar los vídeos generados para adaptarlos a su visión creativa. Snapchat entra en el juego de la creación de contenidos mediante IA con grandes ambiciones. El sistema de Snap pronto tendrá la capacidad de animar imágenes, añadiendo otra capa a su arsenal de IA. Estas herramientas, una vez lanzadas, permitirán a los usuarios mejorar su creatividad dentro de la aplicación como nunca antes. El creador de vídeos con IA de Snapchat pone sobre aviso a Meta y TikTok Lo realmente interesante es que el creador de vídeos de Snapchat supera a Meta y TikTok. Mientras que Meta y ByteDance (la empresa matriz de TikTok) tienen algoritmos de conversión de texto a vídeo en desarrollo, Snapchat va por delante. Su herramienta de conversión de texto a vídeo, accesible desde la aplicación, ya está disponible para un pequeño grupo de creadores de contenidos en fase beta. Sin embargo, es importante tener en cuenta que a esta función aún le queda trabajo por hacer antes de que se lance al público general de Snapchat. Puede que Snapchat se haya adelantado a sus rivales, pero no se quedarán atrás. Meta o TikTok podrían aprobar sus propias versiones en cualquier momento, acortando distancias. Marcas de agua, privacidad y futuras mejoras Una cosa a tener en cuenta: los vídeos creados con la herramienta de IA de Snapchat vendrán con una marca de agua de Snap AI. En los ejemplos actuales, verás el icono de Snapchat en la esquina superior derecha de los vídeos. Esta marca de agua es una señal de la intención de la plataforma de mantener la transparencia y también evitar el uso indebido de la IA generativa. Snapchat también está desplegando nuevas herramientas para mejorar el creador de vídeos, con planes para prevenir usos inapropiados o problemáticos de la IA. La tendencia de la IA y lo que significa para el futuro de Snapchat Los anuncios de Snapchat no se limitan al creador de vídeos con IA. La compañía también reveló un conjunto de recursos de IA diseñados para ayudar a los creadores, como el conjunto GenAI para Lens Studio. Esto simplificará el proceso de creación de objetos de texto a AR y llevará la creatividad AR de Snap a un nuevo nivel. A pesar de la impresionante tecnología, algunos se preguntan si los vídeos generados por IA encajan con la ética habitual de Snapchat de compartir momentos personales y auténticos con los amigos. ¿Acaso añadir vídeos hiperrealistas con IA mejora la experiencia de Snap o le resta atractivo? Para algunos usuarios, esta nueva función puede parecer una novedad más que una incorporación a largo plazo a sus hábitos en las redes sociales. Descripciones: RA (Realidad Aumentada): Tecnología que superpone contenido digital sobre el mundo real, como los filtros faciales de Snapchat Texto a vídeo: Tecnología de IA que crea videoclips cortos a partir de descripciones escritas Pruebas beta: Fase en la que una nueva función se pone a disposición de un grupo limitado de usuarios para que den su opinión antes de su lanzamiento generalizado Marca de agua: Marca visible en imágenes o vídeos para indicar su origen o propiedad GenAI suite: Conjunto de herramientas de IA para crear contenido de realidad aumentada en Lens Studio de Snapchat Lens Studio: El software de Snapchat para crear efectos y filtros de realidad aumentada Preguntas frecuentes: ¿Cómo funciona Snapchat Text-To-Video AI? Snapchat Text-To-Video AI convierte mensajes escritos en clips de vídeo cortos. Los usuarios escriben una descripción y la IA genera el vídeo correspondiente, que puede personalizarse con la función “Estilo” de Snapchat. ¿Cuándo estará disponible para todos los usuarios? Snapchat Text-To-Video AI está actualmente en fase de pruebas beta con un pequeño grupo de creadores de contenidos. La empresa no ha anunciado una fecha concreta de lanzamiento para todos los usuarios, pero es probable que se vaya implementando gradualmente a medida que se perfeccione la tecnología. ¿Puedo eliminar la marca de agua de los vídeos creados con Snapchat Text-To-Video AI? No, los vídeos creados con Snapchat Text-To-Video AI incluirán una marca de agua de Snap AI. Esto forma parte del esfuerzo de Snapchat por mantener la transparencia y evitar el uso indebido del contenido generado por IA. ¿Cómo se compara Snapchat Text-To-Video AI con herramientas similares de otras plataformas? Snapchat Text-To-Video AI parece estar por delante de ofertas similares de Meta y TikTok. Mientras que estos competidores están desarrollando sus propias herramientas de texto a vídeo, Snapchat es el primero en hacer que esté disponible dentro de su aplicación, aunque sólo sea en fase beta.