No hay almuerzo gratis: Baidu impide a Google y Bing la extracción de inteligencia artificial

Last Updated on agosto 30, 2024 11:28 am by Laszlo Szabo / NowadAIs | Published on agosto 29, 2024 by Laszlo Szabo / NowadAIs No hay almuerzo gratis: Baidu impide a Google y Bing la extracción de inteligencia artificial – Notas clave Baidu bloquea el acceso de Google y Bing a sus contenidos Baike para evitar el “scraping” de datos de inteligencia artificial. La medida refleja una tendencia cada vez mayor de las empresas a restringir el acceso a contenidos en línea para proteger datos valiosos. Otras empresas, como Reddit y Microsoft, también están reforzando el control sobre sus datos con fines de IA. Las asociaciones entre desarrolladores de IA y editores de contenidos están aumentando a medida que crece la demanda de conjuntos de datos de alta calidad. Baidu bloquea el acceso de Google y Bing a los contenidos de Baike Baidu ha introducido recientemente cambios significativos en su servicio Baike, una plataforma similar a Wikipedia, para impedir que Google y Microsoft Bing raspen su contenido para utilizarlo en el entrenamiento de IA. Esta modificación se ha notado en la actualización del archivo robots.txt, que ahora bloquea el acceso a los rastreadores Googlebot y Bingbot. El papel de Robots.txt en el bloqueo de los motores de búsqueda La versión anterior del archivo robots.txt, archivada en Wayback Machine, permitía a estos motores de búsqueda indexar el repositorio central de Baidu Baike, que contiene más de 30 millones de entradas, con algunos subdominios restringidos. Este cambio se produce en medio de una creciente demanda de grandes conjuntos de datos necesarios para el entrenamiento y las aplicaciones de IA. Una tendencia más amplia de protección de contenidos en línea La medida de Baidu no es un caso aislado. Otras empresas también han tomado medidas para proteger sus contenidos en línea. Por ejemplo, Reddit ha bloqueado todos los motores de búsqueda excepto Google, que tiene un acuerdo financiero para el acceso a los datos. Del mismo modo, Microsoft está considerando limitar el acceso a los datos de búsqueda en Internet a los motores de búsqueda de la competencia que los utilizan para chatbots y servicios de IA generativa. Wikipedia sigue abierta mientras Baidu aprieta el acelerador Curiosamente, la versión china de Wikipedia, con sus 1,43 millones de entradas, sigue siendo accesible para los rastreadores de los motores de búsqueda. Mientras tanto, un estudio indica que las entradas de Baidu Baike siguen apareciendo en los motores de búsqueda, posiblemente debido al uso de contenidos antiguos almacenados en caché. Asociaciones para un acceso privilegiado a los datos Este movimiento de Baidu refleja una tendencia más amplia en la que los desarrolladores de IA se asocian cada vez más con editores de contenidos para garantizar contenidos de alta calidad. OpenAI, por ejemplo, se ha asociado con la revista Time para acceder a su archivo completo de más de un siglo de antigüedad. En abril se firmó un acuerdo similar con el Financial Times. El creciente valor de los datos en la era de la IA La decisión de Baidu de restringir el acceso a los contenidos de Baike subraya el creciente valor de los datos en la era de la inteligencia artificial. A medida que las empresas invierten en el desarrollo de la IA, aumenta la importancia de los grandes conjuntos de datos. Esto ha provocado un cambio en la forma en que las plataformas en línea gestionan el acceso a los datos, y muchas han optado por restringir o monetizar sus contenidos. Implicaciones futuras de las políticas de intercambio de datos A medida que la industria de la IA siga creciendo, es probable que más empresas reconsideren sus políticas de intercambio de datos. Esta tendencia podría dar lugar a nuevos cambios en la forma de indexar y acceder a la información en Internet, alterando fundamentalmente el panorama de la disponibilidad de contenidos en línea. Descripciones Baidu Baike: Enciclopedia china en línea similar a Wikipedia. Contiene más de 30 millones de entradas y su acceso está restringido a los robots de búsqueda de Google y Bing. archivo robots.txt: Archivo estándar utilizado por los sitios web para indicar a los rastreadores de los motores de búsqueda qué páginas pueden o no pueden indexar. Baidu actualizó este archivo para bloquear a Google y Bing. Scraping: Proceso de extracción de datos de sitios web. En el contexto de la IA, estos datos pueden utilizarse para entrenar modelos y mejorar su rendimiento. Contenido en caché: Información almacenada temporalmente por un navegador o motor de búsqueda. Aunque un sitio web restrinja el acceso, las versiones en caché del contenido pueden seguir apareciendo en los resultados de búsqueda. Asociaciones para el acceso a los datos: Acuerdos entre empresas de IA y editores de contenidos para proporcionar acceso a conjuntos de datos exclusivos, que a menudo implican transacciones financieras u otros beneficios. Preguntas más frecuentes ¿Por qué Baidu ha bloqueado el acceso de Google a sus contenidos Baike? Baidu ha bloqueado el acceso a Google para evitar que sus contenidos Baike se utilicen con fines de entrenamiento de inteligencia artificial. El objetivo de la empresa es evitar que sus competidores utilicen sus valiosos datos. ¿Cómo bloquea el archivo robots.txt de Baidu a Google y Bing? Baidu ha actualizado su archivo robots.txt para impedir específicamente que Googlebot y Bingbot indexen sus contenidos. Este archivo estándar indica a los rastreadores de los motores de búsqueda a qué partes de un sitio web no pueden acceder. ¿Hay otras empresas que también restringen el acceso a los datos como Baidu? Sí, otras empresas, como Reddit y Microsoft, también están restringiendo o monetizando sus datos para controlar cómo se utilizan, en particular para aplicaciones de IA como los chatbots. ¿Afecta el movimiento de Baidu a la versión china de Wikipedia? No, la versión china de Wikipedia sigue siendo accesible para los rastreadores de los motores de búsqueda. Las restricciones de Baidu son específicas de su propia plataforma, Baidu Baike. ¿Por qué está aumentando la tendencia a asociarse para acceder a datos de alta calidad? Como los desarrolladores

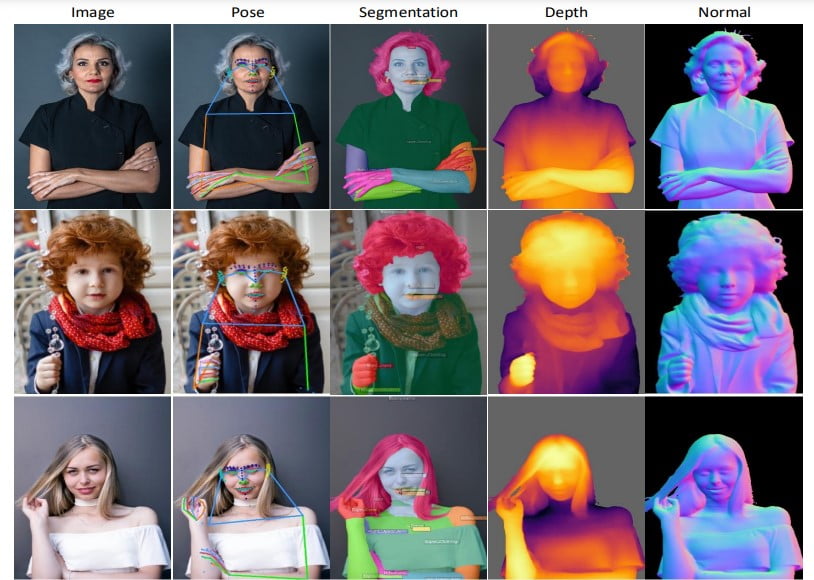

Meta AI presenta Sapiens: un nuevo modelo para analizar las acciones humanas

Last Updated on agosto 29, 2024 12:20 pm by Laszlo Szabo / NowadAIs | Published on agosto 28, 2024 by Laszlo Szabo / NowadAIs Meta AI presenta Sapiens: un nuevo modelo para analizar las acciones humanas – Notas clave El modelo Sapiens de Meta AI se centra en el análisis de acciones humanas en imágenes y vídeos, destacando en entornos complejos. Sapiens se encarga de tareas clave como la estimación de la pose en 2D, la segmentación de las partes del cuerpo, la estimación de la profundidad y la predicción de la normalidad de la superficie. Sapiens, que ha sido entrenado con más de 300 millones de imágenes, obtiene buenos resultados con datos etiquetados limitados y puede ampliarse para mejorar su rendimiento. El modelo utiliza la arquitectura Vision Transformers y está optimizado para tareas de alta resolución con diversas opciones de despliegue. Sapiens de Meta AI: una nueva solución de IA Meta AI ha presentado su nuevo modelo, Sapiens, diseñado específicamente para analizar y comprender las acciones de las personas en imágenes y vídeos. Este modelo, desarrollado por Meta Reality Labs, ofrece capacidades de alta resolución para tareas de visión humana, con especial atención a la comprensión y el análisis de personas en imágenes y vídeos. Estas tareas incluyen el reconocimiento de poses humanas, la segmentación de partes del cuerpo, la medición de la profundidad y la determinación de la orientación de las superficies de los objetos. El modelo se ha entrenado con más de 300 millones de imágenes humanas y puede funcionar bien en entornos complejos. También se ha demostrado que funciona eficazmente con datos etiquetados mínimos e incluso con datos sintéticos, lo que lo convierte en una herramienta valiosa para aplicaciones del mundo real en las que los datos son limitados. Además, el modelo Sapiens es fácilmente ampliable y funciona mejor cuando se aumenta el número de parámetros. Principales tareas de visión humana realizadas por el modelo Sapiens El modelo Sapiens es experto en el manejo de diversas tareas de visión humana, lo que lo hace versátil para diferentes aplicaciones. Destaca en tareas como la estimación de la pose, la segmentación de partes del cuerpo, la estimación de la profundidad y la predicción de la normalidad de la superficie, proporcionando un análisis preciso y completo en escenarios complejos. estimación de la pose en 2D: Detección de movimientos humanos con precisión Una de las principales tareas de visión humana para las que se utiliza el modelo Sapiens es la estimación de la pose en 2D. Esta tecnología de IA es esencial en diversos campos como la videovigilancia, la realidad virtual, la captura de movimientos, la rehabilitación médica, etc., ya que puede reconocer poses, movimientos y gestos humanos. El modelo detecta y predice con precisión puntos clave del cuerpo humano, incluso en escenas con varias personas, lo que lo hace útil para el análisis del movimiento y la interacción persona-ordenador. Segmentación de partes del cuerpo: Aplicaciones en imagen médica y adaptación virtual Otra aplicación importante del modelo Sapiens es la segmentación de partes del cuerpo, crucial en campos como el análisis de imágenes médicas, el ajuste virtual, la producción de animaciones y la realidad aumentada. El modelo puede clasificar con precisión cada píxel de una imagen en diferentes partes del cuerpo, como la parte superior e inferior del cuerpo, detalles faciales, etc. Esta característica es beneficiosa para desarrollar sistemas avanzados de ajuste virtual de ropa, herramientas de diagnóstico médico y animaciones virtuales de personajes más naturales. Estimación de la profundidad: Comprensión de estructuras 3D en escenas complejas La estimación de la profundidad es otra tarea clave en la que destaca el modelo Sapiens. Es esencial en la conducción autónoma, la navegación robótica, el modelado 3D y la realidad virtual, ya que ayuda a comprender la estructura tridimensional de la escena. El modelo es capaz de inferir información de profundidad a partir de una sola imagen, especialmente en escenas humanas. Esta característica es compatible con diversas aplicaciones que requieren una comprensión de las relaciones espaciales, como la detección de obstáculos en la conducción autónoma y la planificación de trayectorias robóticas. Predicción de normales de superficie para renderizado 3D de alta calidad La predicción de la normal de superficie, muy utilizada en renderizado 3D, simulación física, ingeniería inversa y procesamiento de iluminación, también es una especialidad del modelo Sapiens. Puede deducir la dirección de la normal de superficie de cada píxel de una imagen, lo que resulta crucial para generar modelos 3D de alta calidad y conseguir efectos de iluminación más realistas. Esta función es especialmente importante en aplicaciones que requieren características precisas de la superficie, como la realidad virtual y la creación de contenidos digitales. Versatilidad de Sapiens en diversas tareas de visión centradas en el ser humano La versatilidad del modelo Sapiens queda patente en su capacidad para manejar diversas tareas de visión centradas en el ser humano, lo que lo convierte en una herramienta útil en escenarios como el análisis de contenidos de redes sociales, la supervisión de la seguridad, la investigación en ciencias del deporte y la generación de seres humanos digitales. Gracias a su gran rendimiento en múltiples tareas, el modelo Sapiens puede servir como modelo base general para diferentes tareas de visión centradas en el ser humano, acelerando el desarrollo de aplicaciones relacionadas. Mejora de las experiencias de realidad virtual y aumentada con Sapiens Las aplicaciones de realidad virtual y realidad aumentada requieren una comprensión precisa de la postura y la estructura humanas para crear una experiencia envolvente. El modelo Sapiens proporciona poses humanas y segmentación de partes de alta resolución y precisión, lo que lo hace adecuado para crear imágenes humanas realistas en entornos virtuales. También puede adaptarse dinámicamente a los cambios en los movimientos del usuario. Sapiens en aplicaciones médicas y sanitarias: Mejora de la atención al paciente En el campo de la medicina y la salud, la detección precisa de la postura y la segmentación humana del modelo Sapiens pueden ayudar en la monitorización del paciente, el seguimiento del tratamiento y la

Informe de la Red de Casos de Enfermedades

Región: Zona Metropolitana de Santo Domingo Periodo: Enero – Junio 2024 1. Dengue 2. Influenza (Gripe Estacional) 3. Zika 4. Tuberculosis 5. Chikungunya Resumen General Durante el primer semestre de 2024, la Zona Metropolitana de Santo Domingo ha experimentado variaciones en la incidencia de enfermedades. El dengue y la influenza son las enfermedades con mayor número de casos reportados, con un incremento notable en el dengue respecto al año anterior. La influenza, aunque con alta incidencia, muestra una ligera reducción. El control y la vigilancia epidemiológica siguen siendo claves, especialmente en las áreas urbanas densamente pobladas. Recomendaciones

Datos de la Parcela 123AX

Datos de la Parcela 123AX Ubicación: Descripción General: Linderos: Dimensiones de los Lados: Coordenadas GPS de los Puntos de Linderos: Topografía y Características del Terreno: Servicios Disponibles: Notas Adicionales:

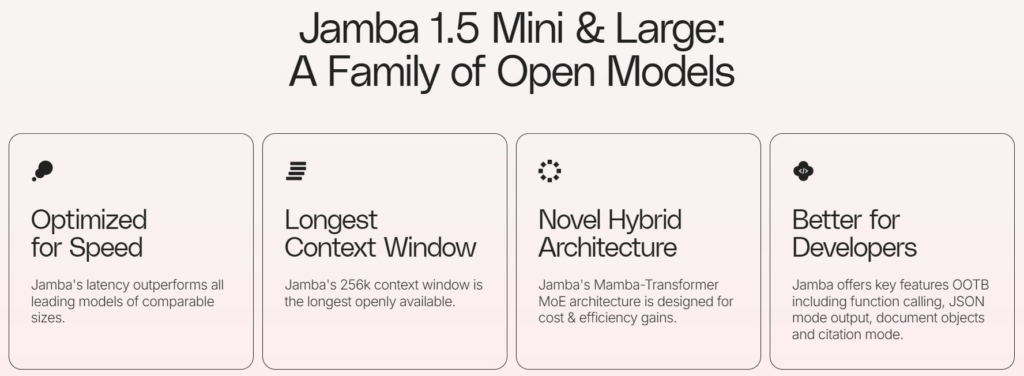

Jamba 1.5: la IA híbrida de AI21 es 2,5 veces más rápida que la de sus principales competidores

Last Updated on agosto 26, 2024 12:48 pm by Laszlo Szabo / NowadAIs | Published on agosto 26, 2024 by Laszlo Szabo / NowadAIs Jamba 1.5: La IA híbrida de AI21 es 2,5 veces más rápida que la de sus principales competidores – Notas clave Jamba 1.5 combina las arquitecturas Transformer y Mamba, ofreciendo un mayor rendimiento y eficiencia. El modelo maneja escenarios de contexto largo con una ventana de contexto de 256.000 tokens, manteniendo un rendimiento máximo. Las funciones multilingües de Jamba 1.5 lo hacen eficaz en varios idiomas, entre ellos el español, el francés y el alemán. El modelo introduce la técnica de cuantificación ExpertsInt8, que permite un despliegue a gran escala con un hardware mínimo. Introducción Presentamos Jamba 1.5, una maravilla híbrida de IA que combina a la perfección los puntos fuertes de las arquitecturas Transformer y Mamba, ofreciendo un rendimiento, una eficiencia y una versatilidad sin precedentes. Desarrollada por las mentes visionarias de AI21, esta tecnología de vanguardia está cambiando lo que es posible en el ámbito del procesamiento del lenguaje natural. La ventaja de Jamba 1.5: Una potencia híbrida En el núcleo de Jamba 1.5 se encuentra un novedoso enfoque que armoniza lo mejor de ambos mundos: la robusta arquitectura Transformer y el innovador marco Mamba. Esta fusión sinérgica da como resultado un modelo híbrido que no sólo sobresale en la gestión de escenarios de contexto largo, sino que también presume de una velocidad y eficiencia notables, superando a sus homólogos en la asombrosa cifra de 2,5 veces. Capacidad de gestión de contextos sin precedentes Una de las características más destacadas de Jamba 1.5 es su capacidad para navegar y procesar sin problemas amplia información contextual. Con una ventana de contexto sin precedentes de 256.000 tokens, esta maravilla de la IA permite a los usuarios interactuar y comprender narraciones intrincadas, conjuntos de datos complejos y documentos voluminosos con una precisión y claridad inigualables. Optimizado para la velocidad y la eficiencia Jamba 1.5 no es sólo una potencia en términos de rendimiento, sino también un pionero en el ámbito de la velocidad y la eficiencia. Gracias a su arquitectura de vanguardia, este modelo ofrece tiempos de inferencia rapidísimos, lo que lo convierte en la opción ideal para aplicaciones sensibles al tiempo e interacciones en tiempo real. Una caja de herramientas versátil para diversas aplicaciones Tanto si busca mejorar la experiencia de los servicios de atención al cliente como agilizar los procesos empresariales o abrir nuevas fronteras en la investigación y el desarrollo, Jamba 1.5 le ofrece un conjunto de herramientas versátiles adaptadas a sus necesidades específicas. Con capacidades que van desde la llamada a funciones y la generación de resultados estructurados hasta la generación fundamentada y la comprensión del lenguaje, esta IA le permite abordar una amplia gama de retos con una precisión y adaptabilidad sin precedentes. Proeza multilingüe: Superar las barreras lingüísticas Jamba 1.5 no sólo es un virtuoso lingüístico en inglés, sino que también domina multitud de idiomas, como el español, el francés, el portugués, el italiano, el holandés, el alemán, el árabe y el hebreo. Esta destreza multilingüe abre nuevas vías para la comunicación intercultural, permitiendo a empresas y organizaciones conectar con públicos diversos a escala mundial. Excelencia en la evaluación comparativa Cuando se trata de pruebas de rendimiento, Jamba 1.5 pone el listón muy alto, superando constantemente a sus compañeros a través de una amplia gama de pruebas estándar de la industria. Desde sobresalir en tareas exigentes como Arena Hard y Wild Bench hasta ofrecer resultados de primera categoría en pruebas de comprensión del lenguaje como MMLU y GPQA, este modelo de IA demuestra su valía una y otra vez. Longitud de contexto eficaz: Mantener el máximo rendimiento Uno de los aspectos más destacables de Jamba 1.5 es su capacidad para mantener un rendimiento máximo durante toda su extensa ventana de contexto. A diferencia de muchos otros modelos, cuya eficacia disminuye a medida que aumenta la longitud de los contextos, Jamba 1.5 ofrece siempre resultados fiables y precisos, incluso con las entradas más complejas y largas. Innovación en cuantificación Para mejorar aún más sus capacidades y accesibilidad, AI21 ha introducido una técnica de cuantificación denominada ExpertsInt8. Este innovador enfoque permite implantar Jamba 1.5 Large, la variante de mayor tamaño de la familia de modelos, en una sola máquina con sólo ocho GPU de 80 GB, sin comprometer la calidad ni el rendimiento. Este logro no sólo amplía el alcance del modelo, sino que también allana el camino para implantaciones más eficientes y rentables. Integración perfecta: Multitud de opciones de implantación Tanto si busca una solución basada en la nube como si prefiere una implantación local, Jamba 1.5 ofrece una gama de opciones que se adaptan a sus necesidades específicas. Desde la plataforma SaaS de calidad de producción de AI21 hasta asociaciones estratégicas con líderes del sector e implantaciones VPC y locales personalizadas, esta maravilla de la IA garantiza una integración perfecta en su infraestructura actual. Capacitar a las empresas: Soluciones a medida Para las empresas con requisitos únicos y a medida, AI21 va más allá, ofreciendo gestión práctica, formación previa continua y capacidades de ajuste. Este enfoque personalizado garantiza que Jamba 1.5 se adapte a las necesidades específicas de su organización, abriendo nuevos horizontes de productividad e innovación. Dar rienda suelta a la creatividad: Herramientas para desarrolladores Jamba 1.5 no es sólo una potencia para las empresas; también es un tesoro para desarrolladores y creadores. Con funciones integradas como la llamada a funciones, la salida en modo JSON, los objetos de documento y el modo de cita, este modelo de IA permite a los desarrolladores dar rienda suelta a su creatividad y crear aplicaciones. IA ética y responsable: un compromiso con la excelencia En el corazón del desarrollo de Jamba 1.5 se encuentra un firme compromiso con las prácticas éticas y responsables de la IA. AI21 ha dado grandes pasos para garantizar que este modelo se adhiere a los más altos estándares de transparencia, privacidad y seguridad, fomentando la confianza entre

Actualización de Microsoft Phi 3.5: una nueva referencia en el rendimiento de la IA

Last Updated on agosto 22, 2024 11:49 am by Laszlo Szabo / NowadAIs | Published on agosto 22, 2024 by Laszlo Szabo / NowadAIs Actualización de Microsoft Phi 3.5: una nueva referencia en el rendimiento de la IA – Notas clave La serie Phi 3.5 de Microsoft incluye tres modelos avanzados: mini-instruct, MoE-instruct y vision-instruct. Phi-3.5-mini-instruct destaca en tareas de razonamiento en entornos de memoria limitada, con capacidades multilingües. Phi-3.5-MoE-instruct utiliza una arquitectura de “Mezcla de Expertos” que equilibra la eficiencia y el rendimiento específico de la tarea. Phi-3.5-vision-instruct integra el análisis multimodal, gestionando con facilidad tareas complejas de procesamiento de texto e imágenes. Phi 3.5 Actualizado por Microsft Con el lanzamiento de la serie Phi 3.5, Microsoft vuelve a ser pionera. Esta extraordinaria gama, compuesta por los modelos Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct y Phi-3.5-vision-instruct, ha conmocionado a la comunidad de IA, mostrando un rendimiento sin precedentes y capacidades polifacéticas. Diseñados para responder a una amplia gama de aplicaciones, desde entornos con recursos limitados hasta tareas complejas de razonamiento y análisis multimodal, estos modelos son un cambio de lo que se puede conseguir con la tecnología de IA más avanzada. Phi-3.5-mini-instrucción: Compacto pero formidable El modelo Phi-3.5-mini-instruct es un verdadero testimonio del compromiso de Microsoft por ampliar los límites de la eficiencia de la IA. Con tan solo 3.800 millones de parámetros, esta potencia ligera desafía la sabiduría convencional al superar a modelos más grandes de gigantes del sector como Meta y Google en multitud de pruebas comparativas. Su destreza radica en su capacidad para ofrecer funciones de razonamiento excepcionales, lo que la convierte en la opción ideal para escenarios que exigen un sólido razonamiento basado en la lógica, la generación de código y la resolución de problemas matemáticos, todo ello en entornos con limitaciones de memoria y computación. Una de las características más destacadas de la miniestructura Phi-3.5 es su notable competencia multilingüe. Gracias a un riguroso entrenamiento con un corpus de datos que abarca varios idiomas, este modelo ha alcanzado un rendimiento casi de vanguardia en tareas conversacionales multilingües y multiturno. Tanto en diálogos como en tareas lingüísticas complejas, Phi-3.5-mini-instruct se adapta a la perfección a diversos entornos lingüísticos, garantizando un rendimiento constante y fiable en una amplia gama de idiomas. Excelencia de referencia Para ilustrar las proezas de la miniestructura Phi-3.5, analicemos su rendimiento en varias pruebas de referencia reconocidas en el sector: RepoQA: Diseñado para evaluar la comprensión de código en contextos largos, el Phi-3.5-mini-instruct superó a sus homólogos de mayor tamaño, incluidos Llama-3.1-8B-instruct y Mistral-7B-instruct, lo que demuestra su excepcional aptitud para comprender y razonar sobre bases de código complejas. MMLU multilingüe: En esta prueba, que evalúa la comprensión de lenguajes multilingües en varios dominios y niveles de experiencia, Phi-3.5-mini-instruct obtuvo una notable puntuación del 55,4%, superando el rendimiento de modelos como Mistral-7B-Instruct-v0.3 y Llama-3.1-8B-Ins. Benchmarks de contexto extenso: En tareas que exigen el procesamiento de contexto extenso, como GovReport, QMSum y SummScreenFD, Phi-3.5-mini-instruct demostró su capacidad para mantener la coherencia y la precisión, superando a modelos de mayor tamaño como Gemini-1.5-Flash y GPT-4o-mini-2024-07-18 (Chat). Estos resultados ponen de manifiesto las excepcionales capacidades de la minicadena Phi-3.5 y demuestran que es capaz de rendir muy por encima de sus posibilidades en una amplia gama de tareas. Phi-3.5-MoE-instruct: Una mezcla de experiencia El modelo Phi-3.5-MoE-instruct representa un enfoque innovador de la arquitectura de IA, que aprovecha el concepto de “Mezcla de Expertos” (MoE). Este innovador diseño combina múltiples modelos especializados, cada uno de los cuales destaca en tareas específicas, en un único marco cohesionado. Con un asombroso total de 42.000 millones de parámetros, pero sólo 6.600 millones activos durante la generación, la Phi-3.5-MoE-instruct logra un notable equilibrio entre eficiencia computacional y rendimiento. Adaptación dinámica de tareas Una de las principales ventajas de la arquitectura de la Phi-3.5-MoE-instruct es su capacidad para cambiar dinámicamente entre distintos “expertos” en función de la tarea que se esté realizando. Esta asignación inteligente de recursos garantiza que se utilice el modelo más relevante y especializado para cada tarea específica, lo que se traduce en una precisión y eficiencia sin precedentes. Phi-3.5-MoE-instruct se adapta a la perfección, aprovechando la experiencia colectiva de los modelos que lo componen, ya se trate de abordar complejos retos de codificación, resolver intrincados problemas matemáticos o navegar por los matices de la comprensión de lenguajes multilingües. Dominio de las pruebas de referencia El rendimiento de Phi-3.5-MoE-instruct en las pruebas de referencia del sector es extraordinario. En la aclamada prueba MMLU (Massive Multitask Language Understanding), que evalúa modelos en una amplia gama de temas y niveles de experiencia, Phi-3.5-MoE-instruct superó a GPT-4o-mini de OpenAI en el escenario de 5 disparos. Este logro subraya las excepcionales habilidades de razonamiento del modelo y su capacidad para abordar tareas complejas y polifacéticas con una destreza inigualable. Además, las proezas del Phi-3.5-MoE-instruct van más allá de la comprensión del lenguaje. En el ámbito de la generación de código, evaluado por pruebas como HumanEval y MBPP, el modelo superó sistemáticamente a sus competidores, demostrando su capacidad para generar código preciso y eficiente en diversos lenguajes y dominios de programación. Phi-3.5-vision-instruct: Posibilidades multimodales En el actual panorama de abundancia de datos, en el que la información se presenta a menudo en varios formatos, como texto, imágenes y vídeos, la necesidad de modelos de IA capaces de integrar y comprender a la perfección estas diversas modalidades nunca ha sido tan acuciante. Entra en escena Phi-3.5-vision-instruct, el vanguardista modelo multimodal de Microsoft que combina a la perfección las capacidades de procesamiento de texto e imágenes en un único y potente marco de trabajo. Con 4.200 millones de parámetros y una arquitectura especializada que incluye un codificador de imágenes, un conector, un proyector y el modelo de lenguaje Phi-3-Mini, la Phi-3.5-vision-instruct está equipada de forma única para abordar una amplia gama de tareas multimodales. Desde la comprensión general de imágenes y el reconocimiento óptico de caracteres hasta la comprensión de gráficos y tablas, pasando por el resumen de vídeos, este modelo está llamado a revolucionar la forma en

Agibot apuesta fuerte: ¿Podrán sus robots humanoides con inteligencia artificial superar a Tesla?

Last Updated on agosto 21, 2024 10:32 am by Laszlo Szabo / NowadAIs | Published on agosto 21, 2024 by Laszlo Szabo / NowadAIs Agibot apuesta fuerte: ¿Podrán sus robots humanoides con inteligencia artificial superar a Tesla? – Notas clave Agibot presenta una gama de cinco robots humanoides diseñados para diversas tareas industriales y domésticas. El buque insignia, Yuanzheng A2, destaca en tareas de precisión, demostrando altos niveles de destreza. Lingxi X1 es un robot de código abierto destinado a fomentar la innovación mundial en robótica. El rápido ascenso de Agibot en el sector de la robótica se ve reforzado por una importante financiación y asociaciones estratégicas. La diversa gama de humanoides de Agibot La startup Agibot, con sede en Shanghái, ha presentado una completa línea de robots humanoides de última generación, que enciende una feroz rivalidad de Tesla, Figure o Unitree en la carrera mundial de la robótica. En el acto de presentación de Agibot se mostró una impresionante gama de cinco modelos distintos de robots humanoides, cada uno meticulosamente diseñado para atender a aplicaciones y escenarios específicos. Esta variada gama de robots subraya el compromiso de la empresa por ampliar los límites de la inteligencia incorporada y satisfacer las crecientes demandas de diversos sectores. El buque insignia: Yuanzheng A2 A la cabeza de la gama Agibot se encuentra el formidable Yuanzheng A2, un imponente robot humanoide bípedo que mide unos impresionantes 175 cm y pesa unos considerables 55 kg. Este modelo insignia cuenta con una serie de sensores avanzados y capacidades de inteligencia artificial asombrosas, que le permiten percibir, procesar y responder a la información visual, auditiva y textual con notable precisión. Una de las características más destacadas del Yuanzheng A2 es su excepcional destreza, demostrada por su capacidad para realizar tareas tan complejas como enhebrar una aguja con precisión quirúrgica. Este nivel de delicadeza lo diferencia de muchos de sus competidores, lo que lo convierte en una opción atractiva para las industrias que exigen una atención meticulosa a los detalles. Compañeros versátiles: A2-W, A2 Max, X1 y X1-W Como complemento del Yuanzheng A2 hay un cuarteto de robots humanoides igualmente impresionantes, cada uno adaptado a aplicaciones y escenarios específicos. Los modelos A2-W y A2 Max están diseñados para la fabricación flexible y las tareas industriales pesadas, respectivamente, mientras que los robots X1 y X1-W se adaptan a los ámbitos de la investigación, la educación y la adquisición de datos especializados. Esta variada gama de modelos subraya el compromiso de Agibot de ofrecer soluciones integrales que puedan integrarse a la perfección en diversos sectores, desde la fabricación y la logística hasta los servicios interactivos y la asistencia doméstica. Enfoque de código abierto: Lingxi X1 Una de las propuestas más destacadas de Agibot es el Lingxi X1, un robot humanoide de código abierto que representa la dedicación de la empresa a fomentar la innovación y la colaboración en la comunidad robótica. Al poner a disposición del público los esquemas de diseño, los marcos de software, el código fuente del middleware y los algoritmos operativos básicos, Agibot pretende que desarrolladores y entusiastas de todo el mundo contribuyan al avance de la robótica humanoide. Este enfoque de código abierto no sólo fomenta el espíritu de colaboración, sino que también tiene el potencial de acelerar el ritmo de la innovación aprovechando el conocimiento y la experiencia colectivos de la comunidad robótica mundial. Hoja de ruta de la inteligencia incorporada y sistema AIDEA La visión de futuro de Agibot va más allá de su actual gama de robots. Durante el evento, la empresa presentó su ambiciosa hoja de ruta para la inteligencia incorporada, denominada G1-G5, en la que se describen sus objetivos a largo plazo y sus iniciativas estratégicas. Además, Agibot presentó el sistema de datos de inteligencia incorporada AIDEA, una plataforma integral diseñada para facilitar el desarrollo y la implantación de sistemas de IA incorporada. Este sistema pone de manifiesto el compromiso de la empresa con la superación de los límites de la robótica y la IA, aprovechando las tecnologías de vanguardia para crear máquinas inteligentes que puedan integrarse a la perfección en diversos aspectos de la vida cotidiana y las operaciones empresariales. Desafiando al Optimus de Tesla: La rivalidad robótica se intensifica La audaz entrada de Agibot en el campo de la robótica humanoide no ha pasado desapercibida, sobre todo en el contexto de su creciente rivalidad con el gigante Tesla. Tesla, de Elon Musk, es desde hace tiempo una fuerza dominante en los sectores de la robótica y la inteligencia artificial, y su esperado robot humanoide Optimus ha generado gran expectación y expectación. Sin embargo, el rápido progreso de Agibot y su ambiciosa gama de productos sugieren que Tesla podría enfrentarse a una formidable competencia por parte del innovador chino. El fundador de Agibot, Peng Zhihui, antiguo “Genius Youth” de Huawei, ha expresado su confianza en la capacidad de la empresa para desafiar a Tesla, citando la superior capacidad de comercialización y control de costes de Agibot. Rápidos avances y éxito de financiación El recorrido de Agibot desde su creación hasta la presentación de sus avanzados robots humanoides ha sido extraordinario. Fundada en febrero de 2023, la startup no perdió el tiempo y lanzó su primer prototipo de robot humanoide, el RAISE A1, apenas seis meses después. El impresionante progreso de la empresa y su enfoque innovador no tardaron en atraer la atención de los principales inversores, asegurando cinco rondas de financiación hasta diciembre de 2023. Prominentes actores como Hillhouse Capital y BYD reconocieron el potencial de las soluciones de IA incorporada de Agibot, impulsando el crecimiento de la empresa y permitiéndole acelerar sus esfuerzos de investigación y desarrollo. RAISE A1: un asistente doméstico versátil El robot humanoide inaugural de Agibot, el RAISE A1, es un testimonio de la ambición y la destreza tecnológica de la empresa. Diseñado con 49 grados de libertad, 1,75 metros de altura y un peso de 53 kg, el RAISE A1 cuenta con una gran variedad de funciones avanzadas. Inicialmente concebido para aplicaciones industriales

¿Puede The AI Scientist de Sakana AI sustituir a Einstein?

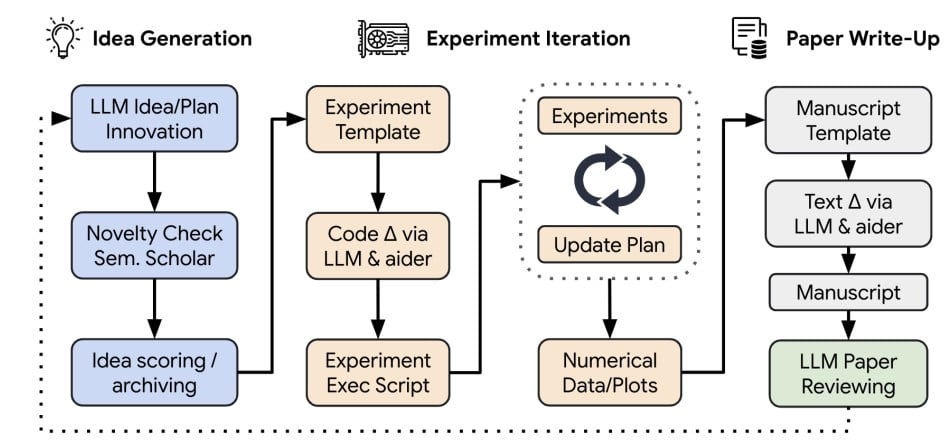

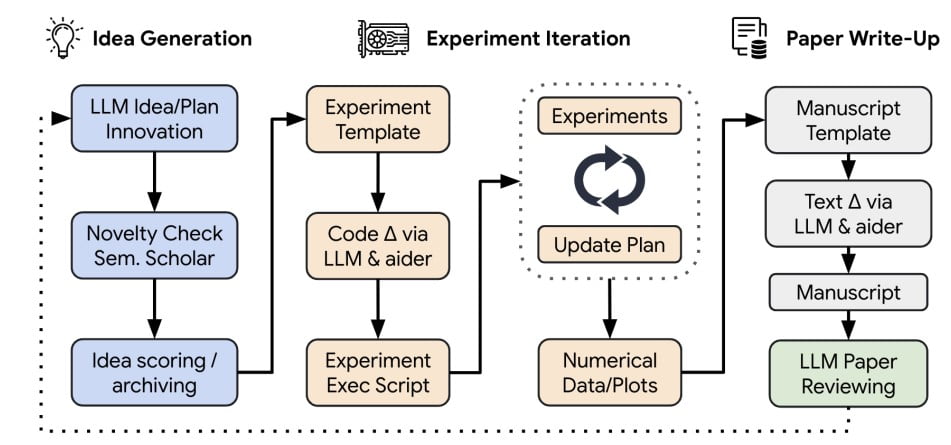

Last Updated on agosto 21, 2024 10:43 am by Laszlo Szabo / NowadAIs | Published on agosto 13, 2024 by Laszlo Szabo / NowadAIs ¿Puede The AI Scientist de Sakana AI sustituir a Einstein? – Notas clave Investigación autosuficiente: The AI Scientist automatiza todo el ciclo de vida de la investigación, desde la ideación hasta la revisión por pares, sin intervención humana. Rentable: Con un coste de sólo 15 dólares por artículo, The AI Scientist democratiza la investigación, haciéndola accesible y asequible. Cuestiones éticas: Plantea cuestiones éticas como el aumento de la carga de trabajo de los revisores y el posible uso indebido para investigaciones poco éticas. Evolución continua: Se espera que The AI Scientist evolucione con las mejoras en los LLM y los modelos de fundación, proponiendo posiblemente ideas que cambien paradigmas en el futuro. Presentación del Científico de la IA de Sakana AI Uno de los retos más ambiciosos ha sido la creación de agentes de IA capaces de llevar a cabo investigaciones científicas y descubrir nuevos conocimientos de forma independiente. Aunque los nuevos modelos ya han demostrado su destreza para ayudar a los científicos humanos en tareas como la lluvia de ideas o la escritura de código, hasta ahora han requerido una amplia supervisión manual o se han limitado a tareas específicas. Sin embargo, un desarrollo de Sakana AI, en colaboración con prestigiosas instituciones como la Universidad de Oxford y la Universidad de la Columbia Británica, promete redefinir los límites de la exploración científica impulsada por IA. El científico de la IA El científico de la IA: El primer sistema de IA del mundo para automatizar la investigación científica y el descubrimiento abierto!https://t.co/8wVqIXVpZJ Desde la ideación, la escritura de código, la ejecución de experimentos y el resumen de resultados, hasta la redacción de artículos completos y la revisión por pares, The AI… pic.twitter.com/SJuat9a2Uw – Sakana AI (@SakanaAILabs) 13 de agosto de 2024 Sakana AI ha presentado The AI Scientist, un sistema pionero que permite a los modelos Foundation, como los Large Language Models (LLMs), realizar investigación científica de forma autónoma. Esta solución integral automatiza todo el ciclo de vida de la investigación, desde la generación de ideas de investigación novedosas y la escritura del código necesario hasta la ejecución de experimentos, el resumen de resultados, la visualización de datos y la presentación de los hallazgos en un manuscrito científico completo. AI Scientist no sólo agiliza el proceso de investigación, sino que también incorpora un mecanismo automatizado de revisión por pares para evaluar los documentos generados, proporcionar comentarios y mejorar los resultados de forma iterativa. Este bucle autosostenible imita a la comunidad científica humana, fomentando un ciclo continuo de expansión y perfeccionamiento del conocimiento. Exploraciones diversas Proceso de tratamiento de ideas de la fuente The AI Scientist de Sakana AI En su demostración inaugural, The AI Scientist se ha aventurado en diversos subcampos dentro de la investigación del aprendizaje automático, descubriendo novedosas contribuciones en áreas populares como: Modelos de difusión Difusión DualScale: Equilibrio adaptativo de características para modelos generativos de baja dimensión Adaptación multiescala del ruido de rejilla: Mejora de los modelos de difusión para datos de baja dimensión Difusión mejorada por GAN: Aumento de la calidad y la diversidad de las muestras DualDiff: Mejora de la captura de modos en modelos de difusión de baja dimensionalidad mediante la eliminación de ruido de doble experto Modelización lingüística StyleFusion: Generación adaptativa multiestilo en modelos lingüísticos a nivel de personaje Tasas de aprendizaje adaptables para transformadores mediante Q-Learning Grokking Descifrando el Grokking: Estudio comparativo de estrategias de inicialización de pesos en modelos de transformadores Grokking acelerado: Tasas de aprendizaje por capas para la generalización de transformadores Grokking mediante compresión: Desvelando la Generalización Súbita a través de la Longitud Mínima de Descripción Aceleración de la comprensión matemática: Potenciación del Grokking mediante el aumento estratégico de datos Estas diversas exploraciones ponen de manifiesto la capacidad de The AI Scientist para profundizar en diversos campos y descubrir nuevas perspectivas, ampliando los límites del conocimiento existente. Innovación rentable Sorprendentemente, The AI Scientist está diseñado para ser eficiente desde el punto de vista informático, con cada idea implementada y desarrollada en un artículo completo a un coste aproximado de 15 dólares. Aunque la versión actual todavía puede presentar fallos ocasionales (que se comentan más adelante), esta rentabilidad y el prometedor potencial del sistema ilustran su capacidad para democratizar la investigación y acelerar significativamente el progreso científico. Revisión por pares automatizada Un aspecto clave de The AI Scientist es el desarrollo de un revisor automatizado basado en LLM, capaz de evaluar los artículos generados con una precisión casi humana. Las revisiones generadas pueden utilizarse para mejorar el proyecto actual o como retroalimentación para futuras generaciones de ideación abierta, lo que permite un bucle de retroalimentación continua que permite a The AI Scientist mejorar iterativamente su producción de investigación. Superar las limitaciones Aunque The AI Scientist representa un avance significativo, no está exento de limitaciones. En la actualidad, carece de capacidades de visión, lo que le impide corregir problemas visuales en el documento o interpretar los gráficos de forma eficaz. Además, puede aplicar ideas incorrectamente o hacer comparaciones injustas con las líneas de base, lo que lleva a resultados potencialmente engañosos. El Científico A I también puede tener dificultades con tareas como la comparación de magnitudes numéricas, una patología conocida en los LLM. “En raras ocasiones, el Científico A I puede alucinar resultados enteros. Por ejemplo, una versión temprana de nuestro prompt de escritura le decía que incluyera siempre intervalos de confianza y estudios de ablación” Afirmó Sakana AI. Para mitigar estos retos, Sakana AI planea incorporar modelos de fundamentos multimodales y aprovechar la mejora continua de los LLM subyacentes en términos de capacidad y asequibilidad. Consideraciones éticas Como ocurre con cualquier tecnología disruptiva, The AI Scientist plantea problemas éticos que deben abordarse. La capacidad de generar y enviar automáticamente artículos a los centros puede aumentar significativamente la carga de trabajo de los revisores y sobrecargar el proceso académico, obstruyendo potencialmente el control de la calidad

Can Sakana AI’s The AI Scientist Replace Einstein?

Last Updated on agosto 13, 2024 8:47 am by Laszlo Szabo / NowadAIs | Published on agosto 13, 2024 by Laszlo Szabo / NowadAIs Can Sakana AI’s The AI Scientist Replace Einstein? – Key Notes Self-Sufficient Research: The AI Scientist automates the entire research lifecycle, from ideation to peer review, without human intervention. Cost-Effective: With each paper costing just $15, The AI Scientist democratizes research, making it accessible and affordable. Ethical Concerns: Raises ethical issues such as increased reviewer workloads and potential misuse for unethical research. Ongoing Evolution: The AI Scientist is expected to evolve with improvements in LLMs and foundation models, possibly proposing paradigm-shifting ideas in the future. Introducing Sakana AI’s The AI Scientist One of the most ambitious challenges has been the creation of AI agents capable of conducting scientific research and uncovering new knowledge independently. While new models have already demonstrated their prowess in aiding human scientists through tasks like brainstorming ideas or writing code, they have hitherto required extensive manual supervision or have been constrained to specific tasks. However, a development by Sakana AI, in collaboration with esteemed institutions like the University of Oxford and the University of British Columbia, promises to redefine the boundaries of AI-driven scientific exploration. Introducing The AI Scientist Introducing The AI Scientist: The world’s first AI system for automating scientific research and open-ended discovery!https://t.co/8wVqIXVpZJ From ideation, writing code, running experiments and summarizing results, to writing entire papers and conducting peer-review, The AI… pic.twitter.com/SJuat9a2Uw — Sakana AI (@SakanaAILabs) August 13, 2024 Sakana AI has introduced The AI Scientist, a pioneering system that enables Foundation Models, such as Large Language Models (LLMs), to perform scientific research autonomously. This comprehensive solution automates the entire research lifecycle, from generating novel research ideas and writing necessary code to executing experiments, summarizing results, visualizing data, and presenting findings in a full scientific manuscript. The AI Scientist not only streamlines the research process but also incorporates an automated peer review mechanism to evaluate generated papers, provide feedback, and iteratively improve results. This self-sustaining loop mimics the human scientific community, fostering a continuous cycle of knowledge expansion and refinement. Diverse Explorations Idea handling process of Sakana AI’s The AI Scientist Source In its inaugural demonstration, The AI Scientist has ventured into diverse subfields within machine learning research, uncovering novel contributions in popular areas such as: Diffusion Models DualScale Diffusion: Adaptive Feature Balancing for Low-Dimensional Generative Models Multi-scale Grid Noise Adaptation: Enhancing Diffusion Models For Low-dimensional Data GAN-Enhanced Diffusion: Boosting Sample Quality and Diversity DualDiff: Enhancing Mode Capture in Low-dimensional Diffusion Models via Dual-expert Denoising Language Modeling StyleFusion: Adaptive Multi-style Generation in Character-Level Language Models Adaptive Learning Rates for Transformers via Q-Learning Grokking Unlocking Grokking: A Comparative Study of Weight Initialization Strategies in Transformer Models Grokking Accelerated: Layer-wise Learning Rates for Transformer Generalization Grokking Through Compression: Unveiling Sudden Generalization via Minimal Description Length Accelerating Mathematical Insight: Boosting Grokking Through Strategic Data Augmentation These diverse explorations showcase The AI Scientist’s ability to delve into various domains and uncover novel insights, pushing the boundaries of existing knowledge. Cost-Effective Innovation Remarkably, The AI Scientist is designed to be compute-efficient, with each idea implemented and developed into a full paper at an approximate cost of $15. While the current version may still exhibit occasional flaws (discussed later), this cost-effectiveness and the system’s promising potential illustrate its capacity to democratize research and significantly accelerate scientific progress. Automated Peer Review A key aspect of The AI Scientist is the development of an automated LLM-powered reviewer, capable of evaluating generated papers with near-human accuracy. The generated reviews can be used to either improve the current project or as feedback for future generations of open-ended ideation, enabling a continuous feedback loop that allows The AI Scientist to iteratively enhance its research output. Overcoming Limitations While The AI Scientist represents a significant stride forward, it is not without its limitations. Currently, it lacks vision capabilities, preventing it from fixing visual issues within the paper or interpreting plots effectively. Additionally, it may incorrectly implement ideas or make unfair comparisons to baselines, leading to potentially misleading results. The AI Scientist can also struggle with tasks like comparing numerical magnitudes, a known pathology with LLMs. “Rarely, The A I Sc ient ist can hallucinate entire results. For example, an early version of our writing prompt told it to always include confidence intervals and ablation studies.” Sakana AI stated. To mitigate these challenges, Sakana AI plans to incorporate multi-modal foundation models and leverage the continuous improvement of underlying LLMs in terms of capability and affordability. Ethical Considerations As with any disruptive technology, The AI Scientist raises ethical concerns that must be addressed. The ability to automatically generate and submit papers to venues may significantly increase reviewer workload and strain the academic process, potentially obstructing scientific quality control. Furthermore, the Automated Reviewer, if deployed online by reviewers, may significantly lower review quality and impose undesirable biases on papers. To maintain transparency, Sakana AI believes that papers and reviews that are substantially AI-generated must be clearly marked as such. Additionally, there is a potential for misuse, as The AI Scientist could be deployed to conduct unethical research or inadvertently create dangerous materials or software. The machine learning community must prioritize aligning such systems with ethical values to ensure they explore in a safe and responsible manner. Open Models and Accessibility The AI Scientist Scores on different LLMs like Sonnet 3.5 or Llama 3.1 Source In this project, Sakana AI explored both proprietary frontier LLMs, such as GPT-4o and Sonnet, as well as open models like DeepSeek and Llama-3. While proprietary models currently produce the highest quality papers, there is no fundamental reason to expect a single model to maintain its lead indefinitely. As frontier LLMs continue to improve, Sakana AI aims to leverage open models, which offer significant benefits such as lower costs, guaranteed availability, greater transparency, and flexibility. The company envisions using The AI Scientist’s proposed discovery process to produce self-improving AI research in a closed-loop system using open models. The Evolving Role of

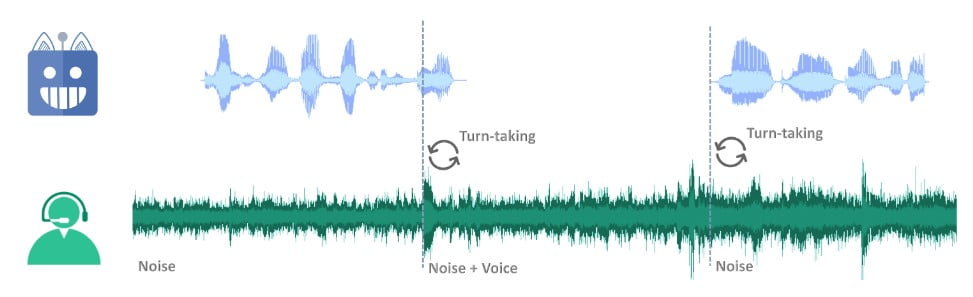

Adiós a la IA por turnos: hola al modelo lingüístico que escucha mientras habla

Last Updated on agosto 12, 2024 1:06 pm by Laszlo Szabo / NowadAIs | Published on agosto 12, 2024 by Laszlo Szabo / NowadAIs Adiós a la IA por turnos: hola al modelo lingüístico que escucha mientras habla – Notas clave El Listening-While-Speaking Language Model (LSLM) integra la escucha y el habla en tiempo real, eliminando las limitaciones de los sistemas de diálogo por turnos. Desarrollado por la Universidad Jiao Tong de Shanghai y ByteDance, LSLM utiliza una arquitectura de doble canal que combina un TTS basado en tokens y un codificador SSL de streaming. LSLM gestiona eficazmente las interrupciones y el ruido de fondo, demostrando robustez y sensibilidad en diversos entornos experimentales. La estrategia de fusión intermedia optimiza la interacción fusionando los canales de escucha y habla en cada bloque Transformer, lo que garantiza una experiencia de diálogo sin fisuras. Introducción En el panorama de la interacción persona-ordenador (HCI), la búsqueda de una comunicación más natural e intuitiva ha sido una fuerza impulsora de los avances tecnológicos. Como forma fundamental de interacción humana, el diálogo ha sido durante mucho tiempo el santo grial de los sistemas de IA conversacional. Los recientes avances en los modelos del lenguaje del habla (SLM) han mejorado indudablemente las capacidades de la IA conversacional basada en el habla, pero estos sistemas han seguido limitados por su naturaleza basada en turnos, careciendo de la capacidad de participar en interacciones ininterrumpidas en tiempo real. Esta limitación ha suscitado un renovado interés por explorar el modelado dúplex completo (FDM) en los modelos interactivos del lenguaje del habla (iSLM), con investigadores que buscan desbloquear la capacidad por excelencia de interrupción y comunicación fluida de ida y vuelta. En medio de esta búsqueda, ha surgido una nueva innovación: el modelo lingüístico de escucha mientras se habla (Listening-While-Speaking Language Model, LSLM), un sistema integral diseñado para actualizar la forma de conversar entre humanos y máquinas. Las limitaciones de los sistemas de diálogo por turnos https://www.nowadais.com/wp-content/uploads/2024/08/Goodbye-Turn-Based-AI-Hello-Listening-While-Speaking-Language-Model.mp4 Los modelos tradicionales de habla y lenguaje se han basado normalmente en un enfoque por turnos, en el que la escucha y el habla se producen en fases aisladas. Esta estructura en silos, que a menudo implica módulos separados de reconocimiento automático del habla (ASR) y de conversión de texto en habla (TTS), ha dado lugar a problemas de latencia inherentes y a una incapacidad para gestionar eficazmente las interrupciones en tiempo real. Modelos notables como SpeechGPT y LauraGPT han ampliado los límites de la IA conversacional, pero siguen limitados a estos paradigmas basados en turnos, sin proporcionar la interacción fluida necesaria para un diálogo humano-ordenador verdaderamente natural. El nacimiento de LSLM: un puente en la interacción en tiempo real Reconociendo la necesidad de una experiencia conversacional más fluida y receptiva, un equipo de investigadores de la Universidad Jiao Tong de Shanghai y ByteDance introdujo el modelo de lenguaje de escucha mientras se habla (Listening-While-Speaking Language Model, LSLM). Este modelo pretende superar las limitaciones de los sistemas por turnos integrando las capacidades de escucha y habla en una única arquitectura integral. El enfoque de doble canal de LSLM El diseño exclusivo del LSLM gira en torno a su arquitectura de doble canal, que combina un TTS basado sólo en decodificador de tokens para la generación del habla y un codificador de aprendizaje autosupervisado (SSL) para la entrada de audio en tiempo real. Este enfoque permite al modelo fusionar los canales de escucha y habla, lo que le permite detectar la toma de turnos en tiempo real y responder dinámicamente a la entrada del usuario. El canal del habla: TTS autorregresivo basado en fichas A diferencia de los modelos anteriores, que se basaban en enfoques autorregresivos y no autorregresivos, el LSLM simplifica el proceso de generación del habla utilizando un sistema TTS basado en fichas. Esta configuración permite al modelo centrarse más en la información semántica, mejorando la claridad y relevancia de sus respuestas y mejorando la interacción en tiempo real al eliminar la necesidad de un amplio preprocesamiento antes de la síntesis del habla. El canal de escucha: Codificador SSL de streaming En el canal de escucha, el LSLM emplea un codificador SSL de flujo continuo para procesar las señales de audio entrantes. Este codificador convierte la entrada de audio en incrustaciones continuas, que luego se proyectan en un espacio que puede integrarse perfectamente con los tokens hablados. Esta integración garantiza que el modelo pueda aprovechar la información de ambos canales a lo largo del proceso de generación del habla. Estrategias de fusión: Equilibrio entre la interacción en tiempo real y la generación del habla Para optimizar la sinergia entre los canales de escucha y habla, los investigadores estudiaron tres estrategias de fusión: fusión temprana, fusión intermedia y fusión tardía. Tras una cuidadosa evaluación, la fusión intermedia resultó ser la más eficaz, ya que lograba un equilibrio óptimo entre la interacción en tiempo real y la capacidad de generación de voz. En el método de fusión intermedia, los canales de escucha y habla se fusionan en cada bloque Transformer, lo que permite al modelo aprovechar continuamente la información de ambos canales durante el proceso de generación del habla. Esta integración garantiza que el LSLM pueda manejar las interrupciones sin problemas y mantener un flujo de diálogo coherente y receptivo, adaptándose a las entradas del usuario en tiempo real. Evaluación del rendimiento de LSLM: Robustez y sensibilidad Las capacidades del LSLM se pusieron a prueba en dos escenarios experimentales: FDM basado en comandos y FDM basado en voz. En el escenario basado en órdenes, el modelo demostró su robustez frente al ruido de fondo, respondiendo eficazmente a órdenes específicas en medio de un entorno ruidoso. En el escenario basado en la voz, en cambio, se evaluó la sensibilidad del LSLM a las interrupciones de varios interlocutores, mostrando su capacidad para reconocer y adaptarse a nuevas voces e instrucciones. Los resultados de estos experimentos pusieron de manifiesto el impresionante rendimiento del LSLM, subrayando su potencial para revolucionar el campo de los modelos interactivos de habla y