YI-VL-34B: Redefinición de la IA multimodal en inglés y chino

Last Updated on agosto 8, 2024 1:32 pm by Laszlo Szabo / NowadAIs | Published on agosto 8, 2024 by Laszlo Szabo / NowadAIs YI-VL-34B: Redefinición de la IA multimodal en inglés y chino – Notas clave YI-VL-34B es un modelo lingüístico de visión bilingüe que destaca tanto en inglés como en chino, desarrollado por 01.AI. El modelo lidera las pruebas MMMU y CMMMU, mostrando un rendimiento sin igual en IA multimodal. YI-VL-34B es accesible a través de plataformas como Hugging Face, con recursos de código abierto para investigadores y desarrolladores. Yi-VL-34B Disponible Yi-VL-34B, el modelo de visión del lenguaje (VLM) de código abierto desarrollado por 01.AI, se ha convertido en la punta de lanza mundial en el campo de la inteligencia artificial multimodal. Este monstruo bilingüe, experto tanto en inglés como en chino, se ha asegurado el codiciado primer puesto entre todos los modelos de código abierto existentes en las pruebas MMMU (Multimodal Multidisciplinary Multilingual Understanding) y CMMMU (Chinese Multimodal Multidisciplinary Multilingual Understanding), en enero de 2024. Proeza multimodal pionera Yi-VL-34B es un pionero que inaugura una nueva era de inteligencia multimodal. Sus extraordinarias capacidades van mucho más allá de la mera comprensión de texto, permitiéndole interpretar y conversar a la perfección sobre información visual. Este innovador VLM puede comprender y analizar imágenes sin esfuerzo, extraer detalles intrincados y generar descripciones textuales perspicaces o participar en sesiones de preguntas visuales de varias rondas. Ingenio arquitectónico: El marco LLaVA En el núcleo de Yi-VL-34B se encuentra la ingeniosa arquitectura LLaVA (Large Language and Vision Assistant), una armoniosa fusión de tres componentes críticos: Transformador de Visión (ViT): Inicializado con el modelo CLIP ViT-H/14 de última generación, este componente se encarga de codificar la información visual con una precisión sin precedentes. Módulo de proyección: Diseñado para salvar la brecha entre las representaciones de imagen y texto, este intrincado módulo alinea las características visuales con el espacio de características textuales, garantizando una integración perfecta. Gran modelo lingüístico (LLM): La columna vertebral de la destreza lingüística de Yi-VL-34B, este componente se inicializa con el formidable modelo Yi-34B-Chat, famoso por sus excepcionales capacidades de comprensión y generación bilingües. Completo régimen de entrenamiento Para liberar todo el potencial de Yi-VL-34B, 01.AI empleó un riguroso proceso de entrenamiento en tres fases, meticulosamente diseñado para alinear la información visual y lingüística dentro del espacio semántico del modelo: Etapa 1: Los parámetros del ViT y del módulo de proyección se entrenaron utilizando una resolución de imagen de 224×224, aprovechando un enorme conjunto de datos de 100 millones de pares imagen-texto del corpus LAION-400M. El objetivo de esta etapa inicial era mejorar la comprensión visual del ViT y lograr una mejor alineación con el componente LLM. Fase 2: Se aumentó la resolución de la imagen a 448×448, lo que permitió afinar aún más los parámetros del ViT y del módulo de proyección. Esta etapa se centró en aumentar la capacidad del modelo para discernir detalles visuales intrincados, a partir de un conjunto de datos diverso de 25 millones de pares imagen-texto, incluidos LAION-400M, CLLaVA, LLaVAR, Flickr, VQAv2, RefCOCO y Visual7w, entre otros. Etapa 3: La etapa final consistió en afinar todo el modelo, sometiendo a entrenamiento todos los componentes (ViT, módulo de proyección y LLM). Este paso crucial tenía como objetivo mejorar la competencia de Yi-VL-34B en las interacciones de chat multimodales, permitiéndole integrar e interpretar a la perfección entradas visuales y lingüísticas. El conjunto de datos de entrenamiento comprendía aproximadamente un millón de pares imagen-texto de diversas fuentes, como GQA, VizWiz VQA, TextCaps, OCR-VQA, Visual Genome y LAION GPT4V, entre otras, con un límite en la contribución máxima de cada fuente para garantizar el equilibrio de los datos. Rendimiento sin precedentes: Supremacía en pruebas comparativas La destreza de Yi-VL-34B queda patente en su incomparable rendimiento en los últimos benchmarks, lo que consolida su posición como líder indiscutible entre los VLM de código abierto. En las pruebas MMMU y CMMMU, que abarcan una amplia gama de preguntas multimodales de múltiples disciplinas, Yi-VL-34B superó a todos los contendientes, estableciendo un nuevo estándar para la IA multimodal de código abierto. Comprensión visual Para ilustrar las extraordinarias capacidades de comprensión visual de Yi-VL-34B, 01.AI ha compartido una serie de ejemplos cautivadores que muestran la destreza del modelo en tareas de descripción detallada y respuesta a preguntas visuales. Estos ejemplos, disponibles tanto en inglés como en chino, sirven como testimonio de la capacidad del modelo para interpretar y conversar sobre intrincadas escenas visuales con notable fluidez y precisión. Aplicaciones diversas Con sus incomparables capacidades multimodales, Yi-VL-34B encierra un inmenso potencial para una amplia gama de aplicaciones, que abarcan campos tan diversos como la visión por ordenador, el procesamiento del lenguaje natural y el análisis multimedia. Desde el subtitulado de imágenes y la respuesta visual a preguntas hasta la comprensión de escenas y el razonamiento multimodal, este innovador VLM promete abrir nuevas fronteras en las soluciones basadas en IA. Accesibilidad y facilidad de uso Para fomentar la adopción y exploración generalizadas, 01.AI ha hecho que Yi-VL-34B esté disponible a través de varios canales, incluidas las conocidas plataformas Hugging Face, ModelScope y wisemodel. Ya sea usted un investigador experimentado, un científico de datos o un entusiasta de la IA, nunca ha sido tan cómodo acceder a Yi-VL-34B y experimentar con él. Requisitos de hardware y consideraciones sobre la implantación Para aprovechar todo el potencial de Yi-VL-34B, los usuarios deben cumplir unos requisitos de hardware específicos. Para obtener un rendimiento óptimo, 01.AI recomienda implantar el modelo en GPU de gama alta, como cuatro GPU NVIDIA RTX 4090 o una sola GPU A800 con 80 GB de VRAM. Es fundamental asegurarse de que el hardware cumple estas especificaciones para disfrutar al máximo de las capacidades del modelo. Colaboración de código abierto En consonancia con el espíritu de innovación de código abierto, 01.AI reconoce y expresa su gratitud a los desarrolladores y colaboradores de varios proyectos de código abierto que han desempeñado un papel fundamental en el desarrollo de Yi-VL-34B. Esto incluye la base de código LLaVA, OpenCLIP

FLUX.1 de Black Forest Labs: ¡ya está aquí tu asistente para convertir texto en imágenes!

Last Updated on agosto 9, 2024 8:13 am by Laszlo Szabo / NowadAIs | Published on agosto 9, 2024 by Laszlo Szabo / NowadAIs FLUX.1 de Black Forest Labs: ¡ya está aquí tu asistente para convertir texto en imágenes! – Notas clave Flux 1 es una IA de texto a imagen de última generación desarrollada por Black Forest Labs, con tres versiones: [pro], [dev]y [schnell]. El modelo combina técnicas de transformador y difusión con innovaciones avanzadas como la coincidencia de flujo, ofreciendo una calidad de imagen y una diversidad superiores. Flux 1 promueve el desarrollo ético de la IA con estrictas directrices de uso y acceso de código abierto para fines de investigación y no comerciales. Introducción Black Forest Labs, una startup fundada por los creadores originales del célebre modelo Stable Diffusion, acaba de presentar su sorprendente suite de IA de texto a imagen, FLUX.1. “Hoy, como primer paso hacia este objetivo, lanzamos la suite FLUX.1 de modelos que amplían las fronteras de la síntesis de texto a imagen” Este lanzamiento histórico está llamado a encender una nueva era de creatividad, accesibilidad e innovación en el mundo de la IA generativa. El nacimiento de FLUX.1: Fusión de técnicas de vanguardia Hoy lanzamos el conjunto de modelos FLUX.1, que amplía las fronteras de la síntesis texto-imagen. Más información en https://t.co/49zTUK8Q5V pic.twitter.com/hmcKRIlizn – Black Forest Labs (@bfl_ml) 1 de agosto de 2024 Black Forest Labs, dirigido por un equipo de investigadores visionarios entre los que se incluyen Robin Rombach, Patrick Esser y Andreas Blattmann, ha aprovechado sus profundos conocimientos para crear FLUX.1. Este conjunto de modelos es el resultado de una armoniosa mezcla de técnicas de transformación y difusión, ampliada hasta la impresionante cifra de 12.000 millones de parámetros. Gracias a la incorporación de enfoques innovadores como el “flow matching”, FLUX.1 demuestra un notable nivel de rendimiento, superando incluso a modelos de la talla de Midjourney v6.0 y DALL-E 3 en aspectos como la calidad de imagen, la adherencia puntual y la diversidad de resultados. Un trío de potencias: FLUX.1 [pro], [dev]y [schnell] FLUX.1 se presenta en tres variantes distintas, cada una de ellas adaptada a las diversas necesidades de la comunidad de IA generativa. El modelo insignia, FLUX.1 [pro]ofrece un rendimiento de vanguardia y está disponible a través de la API de la empresa, destinada a aplicaciones comerciales. El modelo FLUX.1 [dev] de código abierto, se dirige a usuarios no comerciales y permite trabajar a investigadores, aficionados y profesionales creativos por igual. El trío se completa con la versión FLUX.1 [schnell]una iteración más rápida optimizada para el desarrollo local y el uso personal, publicada bajo licencia Apache 2.0. Desarrollo ético de la IA: Priorizar la responsabilidad Junto a su destreza técnica, Black Forest Labs ha puesto un gran énfasis en el desarrollo responsable de la IA. La empresa ha establecido estrictas directrices de uso, que prohíben utilizar su tecnología para generar información falsa, imágenes no consentidas o cualquier contenido que pueda perjudicar a personas o grupos. Es probable que este compromiso con el desarrollo ético de la IA sea objeto de un minucioso escrutinio a medida que FLUX.1 vaya ganando adeptos, lo que subraya la importancia de navegar por el despliegue responsable de los modelos generativos. Opciones arquitectónicas innovadoras Los modelos FLUX.1 no sólo impresionan por su rendimiento, sino también por sus innovaciones técnicas. La incorporación del “flow matching”, un método que generaliza los modelos de difusión, así como el uso de incrustaciones posicionales rotatorias y capas de atención paralelas, han contribuido a mejorar el rendimiento y la eficiencia del hardware de FLUX.1. Estas elecciones arquitectónicas han dado lugar a un importante salto adelante en calidad visual, adherencia puntual y diversidad de resultados. Ampliando horizontes: De texto a imagen a texto a vídeo Las ambiciones de Black Forest Labs van mucho más allá de la generación de texto a imagen. La empresa ha puesto sus miras en el desarrollo de sistemas avanzados de conversión de texto en vídeo, que podrían consolidar aún más su posición de líder en tecnología de medios generativos. El éxito de estos modelos de vídeo podría abrir nuevas posibilidades en ámbitos como la creación de contenidos digitales, la visualización científica e incluso la industria del entretenimiento. Democratización de potentes herramientas de IA El lanzamiento de FLUX.1 representa un hito importante en la democratización de potentes herramientas de IA. Al ofrecer variantes tanto de código cerrado como de código abierto, Black Forest Labs pone la tecnología de IA generativa de vanguardia al alcance de un amplio abanico de usuarios, desde entidades comerciales hasta creadores e investigadores individuales. Este enfoque tiene el potencial de remodelar la dinámica competitiva en la industria de la IA e influir en el debate actual sobre los modelos de desarrollo de código abierto frente a los de código cerrado. Financiación sustancial y asesores destacados La ambiciosa visión de Black Forest Labs está respaldada por importantes recursos financieros. La empresa ha cerrado recientemente una ronda de financiación Series Seed de 31 millones de dólares, liderada por la renombrada firma de capital riesgo Andreessen Horowitz (a16z), con inversiones adicionales de General Catalyst y MätchVC. “Estamos encantados de anunciar el cierre con éxito de nuestra ronda de financiación Series Seed de 31 millones de dólares. Esta ronda fue liderada por nuestro principal inversor, Andreessen Horowitz, incluyendo la notable participación de los inversores ángeles Brendan Iribe, Michael Ovitz, Garry Tan, Timo Aila y Vladlen Koltun y otros expertos de renombre en investigación de IA y creación de empresas.” – declararon. Capacitar a creativos y profesionales El impacto de FLUX.1 va mucho más allá de la comunidad de investigadores en IA. Diseñadores gráficos, artistas digitales y profesionales creativos pueden descubrir nuevas posibilidades en la capacidad del modelo para generar imágenes de alta calidad en una amplia gama de estilos y relaciones de aspecto. Además, la naturaleza abierta de FLUX.1 [dev] y [schnell] podría desencadenar una nueva ola de aplicaciones e integraciones en diversos sectores, transformando la forma en que creamos e interactuamos con los medios visuales. No dudes

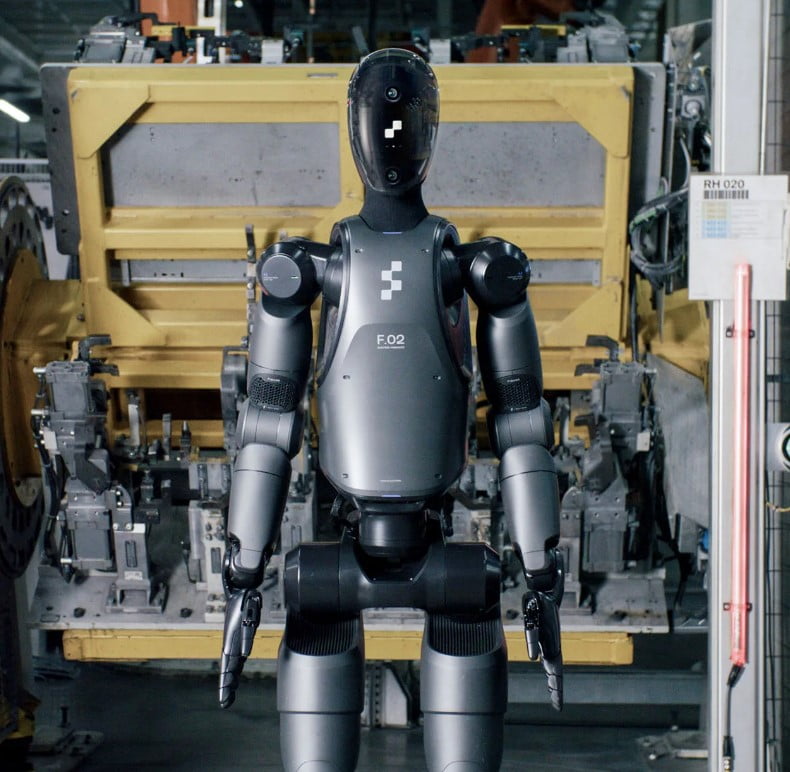

Robot Figure 2 respaldado por OpenAI: Comienza la revolución de los humanoides con IA

Last Updated on agosto 7, 2024 8:40 am by Laszlo Szabo / NowadAIs | Published on agosto 7, 2024 by Laszlo Szabo / NowadAIs Robot Figure 2 respaldado por OpenAI: Comienza la revolución de los humanoides impulsados por IA – Notas clave Figure 2 hace gala de una movilidad y destreza humanoides avanzadas, con potentes articulaciones y 16 grados de libertad en las manos. Equipado con una batería personalizada de 2,25 kWh, Figure 2 ofrece una mayor autonomía y es capaz de interactuar en conversaciones. El robot se utiliza en la industria manufacturera y tiene aplicaciones potenciales en sectores como la logística y el comercio minorista. El robot Figure 2 de Figur AI ya está a la venta Conoce a Figure 02: el hardware de IA más avanzado del mundo pic.twitter.com/OeFekIuxuA – Figure (@Figure_robot) 6 de agosto de 2024 Figure, una empresa pionera en robótica con inteligencia artificial respaldada por OpenAI, ha dado un gran paso hacia la realización del sueño de los robots humanoides inteligentes y ha presentado su segunda generación: el robot Figure 2. Esta creación de vanguardia representa un rediseño completo de la oferta inaugural de la empresa, con mejoras significativas en todos los aspectos de su hardware y software. Una fusión de destreza humana e inteligencia artificial de vanguardia Diseñado para emular la destreza y versatilidad de la forma humana, el robot Figure 2 combina a la perfección las capacidades de un cuerpo humanoide con el poder de la inteligencia artificial avanzada (IA). Su elegante exterior gris metalizado, complementado con revestimientos de tela estratégicamente colocados, no sólo desprende una estética futurista, sino que también oculta una gran cantidad de funciones innovadoras. Proeza informática sin precedentes En el núcleo del robot Figura 2 se encuentra una formidable potencia de cálculo. Esta maravilla, que triplica asombrosamente la capacidad de procesamiento y el rendimiento de inferencia de IA de su predecesor, permite ejecutar tareas de IA del mundo real con una autonomía y precisión sin precedentes. Una maravilla multisensorial Para navegar y comprender su entorno, el robot Figure 2 está equipado con un conjunto de seis cámaras RGB estratégicamente situadas alrededor de su estructura, incluidas dos integradas en su expresivo rostro animado de panel curvo. Este conjunto multisensorial, unido al modelo de lenguaje de visión patentado por Figure, dota al robot de la capacidad de percibir e interpretar su entorno, lo que facilita la toma de decisiones inteligentes y la ejecución de tareas. Movilidad y destreza inigualables La forma humanoide del robot Figure 2 demuestra su excepcional movilidad y destreza. Sus articulaciones, como las de los hombros, con un notable par de 50 Nm y una amplitud de movimiento de 148 grados, las de las rodillas, con un par de 150 Nm y una amplitud de 135 grados, y las de la cadera, con un par de 150 Nm y una amplitud de 195 grados, permiten movimientos fluidos y precisos similares a los de un ser humano. Además, las avanzadas manos del robot, con 16 grados de libertad y una fuerza equivalente a la humana, le permiten realizar una gran variedad de tareas complejas con una destreza y una precisión inigualables. Mayor autonomía y capacidad de conversación El robot Figure 2, que aborda una de las limitaciones críticas de su predecesor, cuenta con un vanguardista paquete de baterías personalizado de 2,25 kWh integrado en su torso. Esta innovadora fuente de energía proporciona más de un 50% más de energía, lo que amplía significativamente el tiempo de funcionamiento del robot y permite una funcionalidad autónoma prolongada. Además, el robot Figure 2 cuenta con altavoces y micrófonos integrados que facilitan las conversaciones cara a cara con los humanos. Gracias a los modelos de IA personalizados desarrollados en colaboración con OpenAI, esta capacidad de conversación abre nuevos campos de interacción entre humanos y robots, fomentando una conexión y un entendimiento más profundos entre ambas entidades. Forjar asociaciones para aplicaciones del mundo real Consciente del inmenso potencial de su creación, Figure ha forjado alianzas estratégicas con líderes del sector para explorar y validar las aplicaciones del robot Figure 2 en el mundo real. Una de estas colaboraciones es con el gigante automovilístico BMW, que ha desplegado el robot en sus instalaciones de fabricación para recopilar datos de inteligencia artificial y entrenarlo en casos de uso. Una visión para mejorar la productividad y la calidad de vida El objetivo global de Figure con el robot Figure 2 va más allá de la mera innovación tecnológica. La empresa imagina un futuro en el que estos robots humanoides avanzados no sólo aumenten la productividad y la eficiencia, sino que también contribuyan a mejorar la calidad de vida de los seres humanos. Al aliviar la carga de tareas arduas y peligrosas, el robot Figure 2 pretende que los trabajadores humanos puedan centrarse en tareas más creativas e intelectualmente estimulantes, fomentando una coexistencia armoniosa entre humanos y robots en la mano de obra mundial. Una potencia versátil para la fabricación y más allá Aunque el despliegue inicial del robot Figura 2 está dirigido a líneas de producción comercial y entornos de fabricación, su versatilidad y adaptabilidad son muy prometedoras para aplicaciones en diversos sectores. Desde la logística y el almacenamiento hasta el comercio minorista, esta maravilla humanoide dotada de inteligencia artificial está llamada a revolucionar la forma en que percibimos e interactuamos con los asistentes robóticos. Un vistazo al futuro de la robótica La presentación del robot Figure 2 marca un momento crucial en la evolución de la robótica y la inteligencia artificial. Al ver esta maravilla en acción, echamos un tentador vistazo a un futuro en el que los límites entre el ser humano y la máquina se difuminan, y en el que los robots inteligentes se integran perfectamente en nuestro mundo, aumentando nuestras capacidades y enriqueciendo nuestras vidas de formas que apenas podemos imaginar. Con el robot Figure 2, Figure AI no sólo ha establecido un nuevo punto de referencia en la robótica humanoide, sino que también ha encendido una chispa de inspiración, desafiándonos a

Generación rápida de activos 3D de Stability AI: Stable Fast 3D

Last Updated on agosto 5, 2024 12:00 pm by Laszlo Szabo / NowadAIs | Published on agosto 4, 2024 by Laszlo Szabo / NowadAIs Generación rápida de activos 3D de Stability AI: Stable Fast 3D – Notas clave Stable Fast 3D de Stability AI permite crear activos 3D de alta calidad a partir de una sola imagen en sólo 0,5 segundos. El modelo destaca en el renderizado de detalles intrincados y texturas realistas utilizando una sofisticada red de transformadores. Se puede acceder a Stable Fast 3D a través de la API, con recursos de código abierto disponibles en GitHub y Hugging Face. Presentación de Stable Fast 3D de Stability AI En el panorama en constante evolución de la tecnología 3D, la velocidad y la calidad han estado a menudo reñidas, obligando a los creadores a sacrificar una por la otra. Sin embargo, una innovación de Stability AI promete acabar con este antiguo dilema. Presentamos Stable Fast 3D, un modelo de vanguardia que permite a los usuarios generar activos 3D de alta fidelidad a partir de una sola imagen en un tiempo asombrosamente breve de tan solo 0,5 segundos. Esta nueva hazaña no sólo marca un nuevo hito en cuanto a eficiencia, sino que inaugura una nueva era de creación rápida de prototipos y exploración creativa en diversos sectores. La evolución de la generación rápida de activos 3D El viaje de Stability AI hacia Stable Fast 3D ha sido un testimonio de su compromiso inquebrantable con la superación de los límites de la IA generativa. Basándose en el éxito de su anterior colaboración TripoSR, la empresa se ha embarcado en una ambiciosa búsqueda para revolucionar el proceso de reconstrucción 3D. Gracias a una investigación y un desarrollo meticulosos, Stability AI ha introducido mejoras arquitectónicas y técnicas novedosas que permiten crear activos 3D de alta calidad con una velocidad y una precisión sin precedentes. Libera el poder de Stable Fast 3D https://www.nowadais.com/wp-content/uploads/2024/08/Stable-Fast-3D-introducing-video-by-Stability-AI.mp4 En el núcleo de Stable Fast 3D se encuentra una sofisticada red de transformadores que genera triplanos de alta resolución -representaciones volumétricas en 3D- a partir de una única imagen de entrada. Este innovador enfoque no sólo capta los detalles más intrincados, sino que también mitiga los artefactos de aliasing, garantizando un resultado perfecto y visualmente impresionante. Además, la eficacia del modelo a la hora de manejar resoluciones mayores minimiza la complejidad computacional, lo que contribuye aún más a su notable rapidez. Una solución polifacética para la creación de activos 3D Las capacidades de Stable Fast 3D van mucho más allá de la mera generación de mallas. A través de una ingeniosa combinación de técnicas, el modelo aborda los retos habituales de la reconstrucción 3D rápida al tiempo que mejora la calidad de los resultados. Una característica notable es la capacidad del modelo para estimar las propiedades del material y la iluminación, lo que permite predecir los valores globales de metal y rugosidad mediante un novedoso método probabilístico. Este enfoque innovador no sólo mejora la calidad y la coherencia de las imágenes, sino que también facilita la integración perfecta de los activos generados en diversos entornos de renderizado. Agilización del proceso creativo El verdadero poder de Stable Fast 3D reside en su capacidad de agilizar el proceso creativo para una amplia gama de profesionales. Los desarrolladores de juegos y realidad virtual pueden aprovechar las rápidas capacidades de creación de prototipos del modelo, lo que les permite experimentar e iterar con facilidad durante la fase de preproducción. Además, el potencial del modelo se extiende a sectores como el comercio minorista, la arquitectura y el diseño, donde la necesidad de activos 3D de alta calidad es primordial. Accesibilidad y facilidad de uso Reconociendo la importancia de la accesibilidad, Stability AI ha hecho que Stable Fast 3D esté disponible a través de múltiples canales. Los usuarios pueden integrar perfectamente el modelo en sus flujos de trabajo a través de la API de Stability AI o el chatbot Stable Assistant. Además, el código y los pesos del modelo son accesibles abiertamente en GitHub y Hugging Face, respectivamente, fomentando la colaboración y la innovación dentro de la comunidad de IA. Aplicaciones en todos los sectores La versatilidad de Stable Fast 3D no tiene límites, ya que se adapta a una amplia gama de aplicaciones en diversos sectores: Producción de juegos y películas Creación rápida de prototipos durante las fases de preproducción Generación de activos de juego estáticos (objetos de fondo, desorden, mobiliario) Creación acelerada de modelos 3D para experiencias de realidad aumentada y virtual Comercio electrónico y minorista Visualización fotorrealista de productos en 3D para catálogos en línea y campañas de marketing Arquitectura y diseño Conceptualización y visualización de modelos arquitectónicos y conceptos de diseño de interiores Rápida iteración y exploración de alternativas de diseño Educación y formación Creación de simulaciones y recursos de aprendizaje interactivos en 3D Desarrollo de entornos virtuales inmersivos para el desarrollo de habilidades y la formación basada en escenarios Velocidad y calidad inigualables https://www.nowadais.com/wp-content/uploads/2024/08/3d-models-created-with-Stable-Fast-3D.mp4 La verdadera fuerza de Stable Fast 3D reside en su capacidad para ofrecer una velocidad inigualable sin comprometer la calidad. Con tiempos de inferencia de tan sólo 0,5 segundos en una GPU con 7 GB de VRAM o una generación casi instantánea en la API Stability AI, el modelo supera a sus competidores por un margen significativo. Además, los activos generados cuentan con mallas de alta calidad sin envoltura UV, parámetros de materiales precisos y un entrelazamiento de iluminación reducido en las texturas, lo que garantiza una integración perfecta en varios conductos de renderizado. Fomento de la colaboración y la IA responsable En línea con su compromiso con los principios del código abierto y las prácticas responsables de la IA, Stability AI ha publicado Stable Fast 3D bajo la licencia comunitaria de Stability AI. Esta licencia no sólo fomenta el uso no comercial y el uso comercial para particulares u organizaciones con ingresos anuales de hasta un millón de dólares, sino que también promueve la transparencia y la colaboración dentro de la comunidad de la

Todo sobre la actualización Midjourney 6.1 y cómo activarla

Last Updated on agosto 1, 2024 1:48 pm by Laszlo Szabo / NowadAIs | Published on agosto 1, 2024 by Laszlo Szabo / NowadAIs Todo sobre la actualización Midjourney 6.1 y cómo activarla – Notas clave Midjourney 6.1 mejora la calidad de imagen con menos artefactos de píxeles, mejores texturas y un renderizado más natural. El modelo de personalización mejorado captura las preferencias del usuario para ofrecer una experiencia creativa a medida. Las nuevas opciones de escalado permiten obtener texturas de mayor calidad, perfectas para escenas complejas. La actualización Midjourney 6.1 está funcionando Midjourney, la renombrada plataforma de generación de imágenes, ha vuelto a poner el listón de la innovación y la excelencia con el lanzamiento de su esperada actualización a la versión 6.1. Esta última iteración del modelo Midjourney promete redefinir los límites de lo que es posible en el ámbito de las imágenes generadas por IA, ofreciendo una experiencia transformadora a artistas, creadores y entusiastas por igual. Calidad y coherencia de imagen mejoradas En el corazón de la actualización Midjourney 6.1 se encuentra una profunda mejora de la calidad y la coherencia de la imagen. El nuevo modelo presenta una notable reducción de los artefactos de píxel, texturas mejoradas y una representación más natural de la piel, las extremidades y otros detalles intrincados. Atrás quedaron los días de elementos inconexos o que distraían la atención, ya que el modelo Midjourney actualizado combina a la perfección los distintos componentes de una imagen, creando una sensación de cohesión y armonía visual que antes era inalcanzable. Renderizado de texturas y detalles mejorado Una de las características más destacadas de Midjourney 6.1 es su capacidad mejorada para capturar y renderizar texturas complejas y detalles a pequeña escala. Desde los delicados mechones de pelo hasta los intrincados patrones de la ropa, el nuevo modelo garantiza que cada elemento esté meticulosamente elaborado, elevando el realismo general y el atractivo visual de las imágenes generadas. Representación precisa de rasgos faciales y apéndices El equipo de Midjourney ha prestado especial atención a la representación precisa de rasgos faciales, manos y otros apéndices, que históricamente han supuesto un reto para la generación de imágenes mediante IA. Con la versión 6.1, los usuarios pueden esperar un nivel de detalle y precisión que antes era dominio exclusivo de los artistas humanos, lo que permite crear retratos y diseños de personajes asombrosamente realistas. Procesamiento más rápido y mayor precisión del texto Además de las mejoras visuales, Midjourney 6.1 también presenta mejoras significativas en la velocidad de procesamiento y la precisión del texto. El nuevo modelo es aproximadamente un 25% más rápido en las tareas estándar de generación de imágenes, lo que permite a los usuarios trabajar de forma más eficiente y agilizar sus flujos de trabajo creativos. Renderizado de texto mejorado Una de las mejoras más notables de Midjourney 6.1 es la mayor precisión en el renderizado de texto dentro de las imágenes generadas. Al incorporar un nuevo modelo de precisión del texto, la plataforma garantiza ahora que cualquier texto incluido en la imagen, ya sean títulos, pies de foto o etiquetas, se reproduzca fielmente con una legibilidad y precisión excepcionales. Actualizaciones del modelo de personalización Midjourney también ha actualizado su modelo de personalización, que ahora ofrece más matices, sorpresa y precisión en las imágenes generadas. Esto significa que los usuarios pueden esperar una experiencia más adaptada e individualizada, ya que el modelo capta mejor las preferencias únicas y las elecciones estilísticas de cada creador. Mayor capacidad de ampliación La actualización Midjourney 6.1 también introduce avances significativos en las capacidades de escalado de la plataforma. Los nuevos escaladores 2x ofrecen una calidad de imagen y textura mucho mejor, lo que permite a los usuarios escalar sus creaciones sin sacrificar la integridad visual general. El modo –q 2: Aumento de escala centrado en las texturas Una de las novedades más interesantes de Midjourney 6.1 es la introducción del modo –q 2. Esta opción de reescalado especializado tarda más tiempo en reescalar las texturas. Esta opción de escalado especializado tarda más en procesarse, pero ofrece un enorme aumento de la calidad de las texturas, lo que mejora aún más el realismo y el atractivo visual de las imágenes generadas. Manejo mejorado de escenas y elementos complejos La última actualización de Midjourney también ha demostrado avances significativos en su capacidad para manejar escenas y elementos complejos, como figuras humanas, animales, plantas e incluso criaturas fantásticas. Representación coherente de extremidades, cuerpos y apéndices La mejor comprensión de la anatomía humana por parte del nuevo modelo y la forma en que representa brazos, piernas, manos y otras partes del cuerpo garantizan una representación más coherente y natural de la forma humana, incluso en las composiciones más imaginativas o surrealistas. Representación realista de elementos naturales La actualización Midjourney 6.1 también muestra una notable mejora en la representación de elementos naturales, como plantas, paisajes y efectos atmosféricos. La capacidad del modelo para captar los intrincados detalles y matices de estos complejos elementos ha mejorado notablemente, lo que se traduce en una experiencia visual más envolvente y creíble. Integración perfecta con Runway Gen-3 Alpha Uno de los avances más interesantes de la actualización Midjourney 6.1 es su perfecta integración con la función de conversión de imagen a vídeo Gen-3 Alpha de Runway. Esta potente combinación permite a los usuarios tomar sus imágenes generadas por IA y transformarlas sin esfuerzo en animaciones realistas de alta calidad, ampliando aún más las posibilidades creativas de artistas y narradores. Realismo asombroso en la animación con IA La integración de Midjourney 6.1 con Runway Gen-3 Alpha ha dado como resultado algunas de las animaciones generadas por IA más realistas y cautivadoras vistas hasta la fecha. El nivel de detalle, fluidez y realismo general conseguido gracias a esta colaboración es un testimonio de los avances de vanguardia en el campo de la creación de contenidos visuales basados en IA. El compromiso de Midjourney con los comentarios de la comunidad El compromiso inquebrantable de Midjourney con su comunidad ha sido la fuerza motriz que

OpenAI presenta el modo de voz avanzado: Transformando la forma en que nos comunicamos

Last Updated on julio 31, 2024 12:27 pm by Laszlo Szabo / NowadAIs | Published on julio 31, 2024 by Laszlo Szabo / NowadAIs OpenAI presenta el modo de voz avanzado: Transformando la forma en que nos comunicamos – Notas clave El modo de voz avanzado facilita las conversaciones naturales y en tiempo real con la IA. Es compatible con varios idiomas, lo que mejora la accesibilidad global y la inclusión. Proporciona asistencia en tiempo real en diversas aplicaciones, como asistencia sanitaria y atención al cliente. Un hito en la comunicación con IA OpenAI ha desvelado su última función, el Modo de Voz Avanzada, preparado para cambiar el dominio de la inteligencia artificial y la comunicación. Este innovador avance supone un gran paso adelante en la forma en que las personas y las empresas interactúan con las tecnologías de IA, y promete un futuro en el que la comunicación por voz sin fisuras se convierta en la norma. Estamos empezando a desplegar el Modo Voz avanzado a un pequeño grupo de usuarios de ChatGPT Plus. El Modo Voz avanzado ofrece conversaciones más naturales y en tiempo real, te permite interrumpir en cualquier momento y detecta y responde a tus emociones. pic.twitter.com/64O94EhhXK – OpenAI (@OpenAI) 30 de julio de 2024 Tradicionalmente, las interacciones con la IA se han basado predominantemente en texto, que, aunque eficaz, carece del matiz y el dinamismo de la comunicación por voz. El Modo Voz pretende salvar esta brecha permitiendo interacciones más ricas y naturales. Principales características y ventajas Flujo de conversación natural: el modo de voz avanzado de OpenAI aprovecha las tecnologías más avanzadas de reconocimiento y síntesis del habla para facilitar conversaciones fluidas y naturales entre los usuarios y la IA. El modelo está entrenado en diversos patrones de habla para entender y responder a una amplia gama de acentos y dialectos, garantizando la inclusión y la precisión. Mayor accesibilidad: Al permitir la interacción por voz, OpenAI hace que la IA sea más accesible para las personas con discapacidad o para quienes los métodos tradicionales de introducción de texto suponen un reto. Esta inclusión fomenta un entorno digital más equitativo, en el que todos pueden beneficiarse de los avances de la IA. Asistencia en tiempo real: La función está diseñada para proporcionar asistencia en tiempo real en diversas aplicaciones, desde atención al cliente y asistentes virtuales hasta tareas complejas de resolución de problemas. La inmediatez y eficiencia de la comunicación por voz mejoran la experiencia del usuario y la eficacia operativa. Asistencia multilingüe: Reconociendo la aplicabilidad global de la IA, el modo de voz avanzado de OpenAI es compatible con varios idiomas. Esta funcionalidad permite a los usuarios de todo el mundo interactuar con la IA en su lengua materna, salvando las barreras culturales y lingüísticas. Aplicaciones en todos los sectores Se espera que el lanzamiento del modo de voz avanzado tenga un impacto transformador en numerosos sectores: Sanidad: Los profesionales médicos pueden aprovechar la IA de voz para la documentación manos libres, la interacción con el paciente y el acceso a información crítica, mejorando así tanto la eficiencia como la atención al paciente. Atención al cliente: Las organizaciones pueden mejorar sus operaciones de servicio al cliente mediante la implementación de bots habilitados para voz para manejar consultas, solucionar problemas y proporcionar asistencia personalizada, lo que lleva a una mayor satisfacción del cliente. Educación: El modo de voz avanzado puede servir como una herramienta interactiva para el aprendizaje, ayudando a los educadores a involucrar a los estudiantes de manera más efectiva y proporcionando a los alumnos una experiencia educativa más inmersiva. Retos y perspectivas de futuro Aunque el Modo Avanzado de Voz de OpenAI presenta oportunidades notables, también se enfrenta a retos, sobre todo en términos de privacidad y seguridad de los datos. Garantizar que los datos de voz se manejan de forma responsable y segura es primordial para mantener la confianza de los usuarios y el cumplimiento de la normativa. De cara al futuro, OpenAI se compromete a seguir perfeccionando el modo de voz, con planes para integrar funciones adicionales como la detección de emociones y las respuestas sensibles al contexto. Estas mejoras pretenden que las interacciones sean aún más matizadas y similares a las humanas. Conclusión El modo de voz avanzado de OpenAI es un testimonio de los rápidos avances de las tecnologías de IA y de su potencial para remodelar nuestros paradigmas de interacción. Al introducir una función que combina el procesamiento del lenguaje natural con funciones de voz avanzadas, OpenAI no sólo se mantiene a la vanguardia, sino que está dando forma activamente al futuro de la comunicación mediante IA. A medida que esta tecnología evolucione, sus implicaciones en diversos sectores podrían anunciar una nueva era de eficiencia, accesibilidad e innovación. Con un compromiso con el uso ético y la mejora continua, el Modo de Voz Avanzada de OpenAI se erige como un faro de progreso en el panorama de la IA. Descripciones Modode voz avanzado de OpenAI: Una característica innovadora de OpenAI que permite a los usuarios interactuar con la IA utilizando la comunicación de voz natural, apoyando las conversaciones en tiempo real y la detección emocional en ChatGPT. Tecnologías de reconocimiento y síntesis de voz: Estas tecnologías permiten a la IA entender el lenguaje hablado con precisión y responder con un habla que suena natural, mejorando la fluidez de las conversaciones. Soporte multilingüe: La capacidad de la IA para entender y responder en varios idiomas, lo que la hace accesible a un público global. Detección de emociones: Una función que se está desarrollando para permitir que la IA perciba y responda a las emociones del usuario, haciendo que las interacciones sean más personalizadas y empáticas. Respuestas conscientes del contexto: La capacidad de la IA para comprender el contexto de la conversación y responder adecuadamente, haciendo que las interacciones sean más significativas y eficientes. Preguntas más frecuentes 1. ¿Qué es el modo de voz avanzado de OpenAI? El modo de voz avanzado de OpenAI es una nueva función que

El poder de Llama 3.1: El último modelo de IA de código abierto de Meta

Last Updated on julio 30, 2024 1:26 pm by Laszlo Szabo / NowadAIs | Published on julio 30, 2024 by Laszlo Szabo / NowadAIs El poder de Llama 3.1: El último modelo de IA de código abierto de Meta – Notas clave Llama 3.1 de Meta ofrece tres modelos: 8B, 70B y 405B parámetros. Llama 3.1 mejora las capacidades de IA con una ventana contextual de tokens de 128K y soporte multilingüe avanzado. Disponibilidad de código abierto bajo licencia Apache 2.0. Mejoras significativas en la estabilidad del entrenamiento, la calidad de los datos y la optimización de la inferencia. Introducción – Conozca la potencia del modelo LLM Llama 3.1 de Meta El lanzamiento de Llama 3.1 por Meta Platforms ha conmocionado sin duda al sector. Como última iteración del modelo de gran lenguaje de código abierto de Meta, Llama 3.1 promete redefinir los límites de lo que es posible con la tecnología de IA. Ahora nos adentramos en las capacidades, la arquitectura y el ecosistema que rodean a este extraordinario modelo, explorando cómo está preparado para impulsar la innovación y capacitar a los desarrolladores de todo el mundo. La familia Llama 3.1: Capacidades sin precedentes en todo el espectro La Llama 3. 1 de Meta está disponible en tres variantes distintas: los modelos paramétricos 8B, 70B y el buque insignia 405B. Cada una de estas versiones cuenta con sus propios puntos fuertes, que se adaptan a una amplia gama de casos de uso y requisitos. Llama 3.1 8B: un caballo de batalla versátil El modelo 8B, aunque es el más pequeño de la gama Llama 3.1, no se queda atrás en lo que a rendimiento se refiere. Con sus impresionantes capacidades en áreas como el conocimiento general, las matemáticas y la codificación, la variante 8B es una opción ideal para los desarrolladores que buscan un asistente de IA ligero pero muy capaz. Sus rápidas capacidades de inferencia y su bajo consumo de memoria lo convierten en la solución perfecta para su implantación en una amplia gama de plataformas, desde dispositivos periféricos hasta aplicaciones basadas en la nube. Llama 3.1 70B: equilibrio entre potencia y eficiencia El modelo 70B logra un notable equilibrio entre potencia bruta y rentabilidad. Esta variante destaca en tareas que requieren un razonamiento más avanzado, competencia multilingüe y una sólida utilización de herramientas. El modelo 70B, con una longitud de contexto significativamente mayor (128.000) y capacidades de última generación, es idóneo para casos de uso complejos como el resumen de textos largos, los agentes conversacionales multilingües y los asistentes de codificación sofisticados. Llama 3.1 405B: el buque insignia de la potencia La joya de la corona de la familia Llama 3.1 es el modelo de parámetros 405B. Este monstruo es el primer modelo disponible abiertamente que puede rivalizar con los mejores modelos de IA en términos de conocimientos generales, maniobrabilidad, matemáticas, uso de herramientas y traducción multilingüe. Sus capacidades sin parangón lo convierten en la opción preferida de los desarrolladores que buscan ampliar los límites de lo que es posible con la IA generativa. Desde la generación de datos sintéticos hasta la destilación de modelos, el modelo 405B abre un mundo de posibilidades para la comunidad de código abierto. Innovaciones arquitectónicas: Llama alcanza nuevas cotas Desarrollar un modelo de la escala y complejidad de Llama 3.1 405B no fue tarea fácil. El equipo de investigadores e ingenieros de IA de Meta superó numerosos retos para crear una arquitectura realmente asombrosa. Optimización para el entrenamiento a escala Para permitir el entrenamiento del modelo 405B en más de 15 billones de fichas, Meta tomó varias decisiones de diseño clave. Optaron por una arquitectura de modelo de transformador de sólo descodificador estándar, que priorizaba la estabilidad del entrenamiento frente a enfoques más complejos. Además, implementaron un procedimiento iterativo de post-entrenamiento, aprovechando el ajuste fino supervisado y la optimización directa de preferencias para crear datos sintéticos de alta calidad y mejorar las capacidades del modelo. Mejora de la calidad y la cantidad de los datos Reconociendo la importancia de los datos en el rendimiento del modelo, Meta invirtió mucho en mejorar tanto la cantidad como la calidad de los datos utilizados para el preentrenamiento y el postentrenamiento. Esto incluyó el desarrollo de procesos de preprocesamiento y curación más rigurosos, así como la aplicación de técnicas avanzadas de filtrado y control de calidad. Optimización de la inferencia a gran escala Para apoyar la inferencia eficiente del modelo masivo 405B, Meta cuantificó el modelo de 16 bits (BF16) a 8 bits (FP8) numéricos. Esta optimización redujo significativamente los requisitos de cálculo, permitiendo que el modelo se ejecutara en un único nodo servidor sin sacrificar el rendimiento. Llama en acción: Seguimiento de instrucciones y funciones de chat Uno de los principales objetivos del equipo de desarrollo de Llama 3.1 era mejorar la utilidad, la calidad y la capacidad de seguimiento de instrucciones detalladas del modelo en respuesta a las preguntas de los usuarios. Se trataba de un reto importante, sobre todo si se tenía en cuenta el aumento del tamaño del modelo y la ampliación de la ventana contextual de 128K. Mejora del seguimiento de instrucciones El enfoque de Meta para mejorar el seguimiento de instrucciones incluyó varias rondas de Ajuste Supervisado (SFT), Muestreo de Rechazo (RS) y Optimización de Preferencia Directa (DPO). Gracias a la generación de datos sintéticos y a rigurosas técnicas de procesamiento de datos, el equipo pudo escalar la cantidad de datos de ajuste fino en todas las capacidades, garantizando una alta calidad y seguridad en todas las tareas. Refuerzo de las capacidades conversacionales Además del seguimiento de instrucciones, Meta también se centró en mejorar las capacidades de conversación de los modelos Llama 3.1. Mediante una combinación de SFT, RS y DPO, el equipo desarrolló modelos finales de chat que mantienen altos niveles de utilidad, calidad y seguridad, incluso a medida que los modelos crecen en tamaño y complejidad. El ecosistema Llama: Desbloquear nuevas posibilidades La visión de Meta para Llama 3.1 va más allá de los propios modelos,

SearchGPT de OpenAI, el batidor de Google, en fase de pruebas

Last Updated on julio 26, 2024 11:06 am by Laszlo Szabo / NowadAIs | Published on julio 26, 2024 by Laszlo Szabo / NowadAIs SearchGPT de OpenAI, el batidor de Google, en fase de pruebas – Notas clave OpenAI presenta SearchGPT para obtener respuestas rápidas y relevantes de fuentes creíbles. SearchGPT pretende mejorar la experiencia de búsqueda con respuestas conversacionales. Planea integrar SearchGPT en ChatGPT para obtener respuestas útiles en tiempo real. Las acciones de Alphabet cayeron un 3% tras el anuncio. Detalles de SearchGPT de OpenAI OpenAI ha revelado recientemente su nuevo motor de búsqueda, SearchGPT, con el objetivo de proporcionar a los usuarios respuestas rápidas y relevantes de fuentes creíbles. La empresa planea integrar esta herramienta, que actualmente se está probando con un pequeño grupo de usuarios, en su chatbot ChatGPT. Este movimiento podría afectar a Google y a su motor de búsqueda dominante, ya que los inversores de Alphabet han mostrado su preocupación desde el lanzamiento de ChatGPT en noviembre de 2022. El prototipo de SearchGPT es el intento de OpenAI de mejorar la experiencia de búsqueda, permitiendo a los usuarios hacer preguntas de forma conversacional y recibir respuestas de seguimiento. En una entrada del blog X, el CEO de OpenAI, Sam Altman, declaró: “Creemos que hay margen para mejorar significativamente el estado actual de las búsquedas” creemos que hay margen para hacer que la búsqueda sea mucho mejor de lo que es hoy. estamos lanzando un nuevo prototipo llamado SearchGPT: https://t.co/A28Y03X1So aprenderemos del prototipo, lo mejoraremos y luego integraremos la tecnología en ChatGPT para que sea útil en tiempo real. – Sam Altman (@sama) 25 de julio de 2024 Como resultado de este anuncio, las acciones de Alphabet cayeron un 3%, mientras que el Nasdaq bajó menos de un 1%. ¿Google en problemas? En mayo, Google lanzó AI Overview, descrito por el CEO Sundar Pichai como el cambio más significativo en la búsqueda en los últimos 25 años, a una audiencia limitada. Sin embargo, esta función recibió críticas por ofrecer resultados sin sentido e inexactos sin la opción de excluirse. El lanzamiento de OpenAI de su nuevo modelo de IA, “GPT-4o mini” y el prototipo de SearchGPT, forma parte de sus esfuerzos por liderar en el campo de la “multimodalidad”, ofreciendo una diversa gama de medios generados por IA dentro de una sola herramienta: ChatGPT. OpenAI, respaldada por Microsoft y valorada en más de 80.000 millones de dólares, se enfrenta al reto de seguir siendo competitiva en un mercado en rápido crecimiento como el de la IA generativa y, al mismo tiempo, encontrar formas de generar ingresos mientras sigue invirtiendo en procesadores e infraestructura para sus modelos. Para reforzar su equipo, OpenAI ha contratado recientemente a dos altos ejecutivos y ha formado una alianza con Apple para una integración ChatGPT-Siri. Sarah Friar, anteriormente consejera delegada de Nextdoor y jefa de finanzas de Square, se ha incorporado como directora financiera, mientras que Kevin Weil, ex vicepresidente sénior de Twitter y vicepresidente de Facebook e Instagram, se ha incorporado como director de producto. Estos movimientos estratégicos reflejan el deseo de OpenAI de mantenerse a la vanguardia en el mercado de la IA generativa, en constante evolución. Descripciones SearchGPT: El nuevo motor de búsqueda de OpenAI diseñado para proporcionar resultados de búsqueda conversacionales y relevantes de fuentes creíbles. Búsqueda conversacional: Un enfoque de búsqueda en el que los usuarios pueden hacer preguntas de forma natural y conversacional y recibir respuestas directas y comprensibles. Multimodalidad: La capacidad de integrar múltiples formas de medios e información, como texto, imágenes y vídeos, en una única herramienta o respuesta. GPT-4o Mini: Un modelo avanzado de IA lanzado por OpenAI como parte de sus esfuerzos por mejorar las capacidades de la IA multimodal. Visión general de la IA: La función de búsqueda basada en IA de Google lanzada en mayo, criticada por sus imprecisiones y la falta de opciones de exclusión. Preguntas más frecuentes 1. ¿Qué es SearchGPT de OpenAI? SearchGPT de OpenAI es un nuevo motor de búsqueda diseñado para proporcionar respuestas rápidas y relevantes de fuentes creíbles utilizando IA conversacional. Su objetivo es mejorar la experiencia de búsqueda permitiendo a los usuarios hacer preguntas de forma natural y recibir respuestas de seguimiento. 2. ¿Cómo afectará SearchGPT a motores de búsqueda como Google? SearchGPT tiene el potencial de desafiar el dominio de Google ofreciendo una experiencia de búsqueda más conversacional y fácil de usar. Tras el anuncio, las acciones de Alphabet cayeron un 3%, lo que indica la preocupación del mercado por la posición competitiva de Google. 3. ¿Cuándo estará disponible SearchGPT para el público? Actualmente, SearchGPT se está probando con un pequeño grupo de usuarios. OpenAI tiene previsto aprender de este prototipo, introducir mejoras e integrar la tecnología en ChatGPT para un uso público más amplio. 4. ¿Cuáles son las principales características de SearchGPT? SearchGPT ofrece respuestas conversacionales, información fidedigna e integración con ChatGPT para obtener respuestas en tiempo real. También forma parte del esfuerzo más amplio de OpenAI por liderar la multimodalidad, combinando texto, imágenes y vídeos. source

mistral AI y NVIDIA lanzan el modelo 12B NeMo

Last Updated on julio 26, 2024 12:44 pm by Laszlo Szabo / NowadAIs | Published on julio 24, 2024 by Laszlo Szabo / NowadAIs mistral AI y NVIDIA lanzan el modelo 12B NeMo – Notas clave Mistral AI y NVIDIA han colaborado para crear el modelo 12B NeMo. NeMo cuenta con una ventana de contexto de 128.000 tokens. El modelo destaca en razonamiento, conocimiento general y precisión de codificación. NeMo está diseñado para sustituir fácilmente a Mistral 7B gracias a su arquitectura estándar. Disponibilidad de código abierto bajo licencia Apache 2.0 para puntos de control preentrenados. NeMo admite la inferencia FP8 sin pérdida de rendimiento. Optimizado para aplicaciones globales y multilingües. NeMo incluye Tekken, un tokenizador con un 30% más de eficiencia de compresión para código fuente y muchos idiomas. NeMo AI Model por pesos pesados de la industria La empresa Mistral AI acaba de presentar su nuevo modelo 12B, NeMo, desarrollado en colaboración con NVIDIA. Este último modelo tiene una ventana de contexto de 128.000 tokens y se dice que consigue resultados de primera categoría en razonamiento, conocimientos generales y precisión de codificación dentro de su rango de tamaño. La colaboración entre Mistral AI y NVIDIA ha dado lugar a un modelo que no sólo amplía los límites de su rendimiento, sino que también prioriza la comodidad. Mistral NeMo se ha creado para sustituir sin esfuerzo a los sistemas existentes que utilizan Mistral 7B, gracias a su uso de la arquitectura estándar. Rendimiento del modelo NeMo AI Mistral AI ha tomado recientemente la gran decisión de promover el uso y el avance de su modelo proporcionando acceso a los puntos de control preentrenados y a los puntos de control ajustados a las instrucciones bajo la licencia Apache 2.0. Se espera que este enfoque de disponibilidad de código abierto atraiga la atención tanto de investigadores como de empresas, agilizando potencialmente la integración del modelo en diversas aplicaciones. Un aspecto clave de Mistral NeMo es su capacidad para ser consciente de la cuantificación durante el entrenamiento, lo que permite la inferencia FP8 sin sacrificar el rendimiento. Esta característica podría ser muy beneficiosa para las organizaciones que pretendan implantar eficientemente grandes modelos lingüísticos. Mistral AI ha realizado un análisis de rendimiento del modelo base Mistral NeMo y de otros dos modelos preentrenados de código abierto, Gemma 2 9B y Llama 3 8B, y ha proporcionado una comparación entre sus rendimientos. El rendimiento del modelo está optimizado para su uso en aplicaciones globales y multilingües. Su entrenamiento se centra en la llamada a funciones y posee una amplia ventana contextual, lo que lo hace especialmente competente en varios idiomas como inglés, francés, alemán, español, italiano, portugués, chino, japonés, coreano, árabe e hindi. El Tekken Mistral NeMo ha lanzado recientemente Tekken, un novedoso tokenizador que se basa en Tiktoken. Este nuevo tokenizador ha sido entrenado en un conjunto diverso de más de 100 idiomas. Tekken cuenta con capacidades de compresión mejoradas tanto para texto en lenguaje natural como para código fuente, superando el rendimiento del tokenizador SentencePiece utilizado en modelos anteriores de Mistral. Según la empresa, Tekken es capaz de lograr una eficacia de compresión un 30% superior para el código fuente y varios idiomas muy hablados, con mejoras aún más sustanciales para el coreano y el árabe. Según Mistral AI, Tekken tiene un mayor rendimiento de compresión de texto en comparación con el tokenizador Llama 3 en aproximadamente el 85% de los idiomas. Esto podría proporcionar a Mistral NeMo una ventaja competitiva en aplicaciones multilingües. Ya se puede acceder a los pesos del modelo en HuggingFace, tanto para la versión base como para las versiones con instrucciones. Los desarrolladores pueden empezar a explorar Mistral NeMo utilizando la herramienta mistral-inference y modificándola con mistral-finetune. Para los usuarios de la plataforma Mistral, el modelo puede encontrarse bajo el nombre open-mistral-nemo. Como reconocimiento a la colaboración con NVIDIA, Mistral NeMo también se ofrece como microservicio de inferencia NIM de NVIDIA en ai.nvidia.com. Esta inclusión puede facilitar el proceso de implantación a las empresas que ya utilizan el ecosistema de IA de NVIDIA. El lanzamiento de Mistral NeMo supone un notable avance en la puesta al alcance de todos de modelos avanzados de IA. Este modelo, desarrollado por Mistral AI y NVIDIA, ofrece alto rendimiento, capacidades multilingües y está disponible de forma abierta, lo que lo convierte en una solución versátil para una gran variedad de usos de la IA en diferentes industrias y dominios de investigación. Definiciones LLM Alucinante: Cuando grandes modelos lingüísticos generan salidas plausibles pero incorrectas o sin sentido. HaluBench: Conjunto de datos de referencia utilizado para evaluar la precisión de los modelos de IA en la detección de alucinaciones, que abarca diversos temas del mundo real. Conjunto de datos PubMedQA: Conjunto de datos diseñado para evaluar modelos de IA en el ámbito de la respuesta a preguntas médicas, garantizando la precisión en contextos médicos. Técnica de aprendizaje automático FSDP: Fully Sharded Data Parallelism, una técnica utilizada para mejorar la eficiencia y escalabilidad del entrenamiento de grandes modelos lingüísticos mediante la distribución de datos y cálculos en múltiples GPU. Preguntas más frecuentes 1. ¿Qué es el Modelo NeMo de Mistral AI? El Modelo NeMo de Mistral AI es un modelo de IA con 12.000 millones de parámetros desarrollado en colaboración con NVIDIA, diseñado para destacar en razonamiento, conocimientos generales y precisión de codificación. 2. ¿En qué se diferencia el Modelo NeMo de modelos anteriores como el Mistral 7B? NeMo ofrece una ventana de contexto significativamente mayor, de 128.000 tokens, y un rendimiento mejorado en razonamiento y codificación, lo que lo convierte en un sustituto superior del Mistral 7B. 3. ¿Cuáles son las principales características de NeMo? NeMo incluye una amplia ventana de contexto, compatibilidad con la inferencia FP8, capacidades multilingües y utiliza el nuevo tokenizador Tekken para mejorar la eficacia de la compresión. 4. ¿Cómo gestiona NeMo las aplicaciones multilingües? NeMo está optimizado para aplicaciones globales, soportando múltiples idiomas como inglés, francés, alemán, español, italiano, portugués, chino, japonés, coreano, árabe e hindi. 5.

Los 10 mejores generadores de vídeo AI para 2024

Last Updated on julio 26, 2024 12:53 pm by Laszlo Szabo / NowadAIs | Published on julio 21, 2024 by Laszlo Szabo / NowadAIs Los 10 mejores generadores de vídeo con IA para 2024 – Notas clave Los generadores de vídeo de IA han transformado la creación de contenidos de vídeo, haciéndola más eficiente y accesible. Estas herramientas son adecuadas para diversas aplicaciones, desde marketing y educación hasta entretenimiento. Las características clave de los mejores generadores de video AI incluyen generación de scripts, plantillas personalizables y salidas de video de alta calidad. Los precios varían desde planes gratuitos con funciones básicas hasta planes premium que ofrecen amplias capacidades. Entre los generadores de vídeo AI más populares se encuentran InVideo, Synthesia, Pictory, Runway y DeepBrain AI. Los mejores generadores de vídeo AI para 2024 – Curated En una era en la que el contenido de vídeo domina el panorama del marketing digital, la búsqueda de los mejores generadores de vídeo de IA se ha vuelto más crítica que nunca. Con la evolución de las herramientas de vídeo de IA, la creación de contenido ha pasado de los métodos tradicionales de producción de vídeo a soluciones más innovadoras y eficientes. Estos generadores de vídeo de IA no sólo están transformando el ámbito del marketing de vídeo; están revolucionando la forma en que creamos vídeo de IA, convirtiendo ideas intrincadas en narrativas visuales convincentes sin necesidad de grandes recursos o tiempo. Desde contenidos generados por IA que imitan las sutilezas humanas hasta tecnologías de IA de texto a vídeo que elaboran vídeos a partir de guiones escritos, las capacidades de estas herramientas están remodelando el proceso de creación de vídeos. Este artículo presenta una lista de los 10 mejores generadores de vídeo de IA para 2024, cuidadosamente seleccionados para satisfacer una amplia gama de necesidades de producción de vídeo. Tanto si estás buscando un creador de vídeo de IA para crear avatares de IA, como si buscas una herramienta de conversión de texto a vídeo de IA para convertir tus artículos en atractivos vídeos, o si necesitas un creador de películas de IA para crear historias cautivadoras, esta guía te ofrece todo lo que necesitas. Con cada generador de vídeo de IA destacado, profundizamos en sus ofertas únicas, desde las capacidades de vídeo generadas por IA hasta su papel en la creación de contenidos, proporcionando información sobre cómo estas plataformas pueden elevar su estrategia de marketing de vídeo y agilizar su proceso de producción de vídeo. InVideo InVideo – una de las mejores herramientas generadoras de vídeo AI InVideo se destaca como una robusta plataforma de generación de video AI adaptada para una variedad de necesidades de producción de video, incluyendo anuncios de video, videos promocionales y contenido de medios sociales. Sus completas funciones se adaptan tanto a usuarios principiantes como experimentados, lo que la convierte en una opción versátil en el ámbito de los generadores de vídeo AI. Características de InVideo InVideo cuenta con una amplia biblioteca de más de 4000 plantillas y un rico repositorio de medios de archivo, que abarca millones de videos e imágenes. Esta amplia colección es crucial para los creadores que carecen de una biblioteca multimedia personal. La plataforma está diseñada con una interfaz de usuario intuitiva, asegurando que incluso los nuevos en la edición de vídeo puedan navegar y utilizar la herramienta con eficacia. Además, InVideo apoya los esfuerzos de colaboración a través de una función de inicio de sesión compartido, lo que permite a varios usuarios trabajar en proyectos de forma simultánea. Una característica exclusiva de InVideo es la capacidad de la IA de convertir instrucciones de texto en guiones completos, que pueden transformarse en vídeos, con voz en off y subtítulos, en cuestión de minutos. Precios de InVideo InVideo ofrece múltiples planes de precios para adaptarse a las diferentes necesidades y presupuestos de los usuarios. El plan gratuito es un excelente punto de partida, aunque incluye una marca de agua en los vídeos exportados. Para funciones más avanzadas, los planes de pago empiezan en 24 $, con opciones como los planes InVideo AI Plus y Max que proporcionan mayores recursos para uso profesional, incluyendo más minutos de generación AI y bibliotecas de medios más grandes. Pros y contras de InVideo Pros: Amplia biblioteca de plantillas que se actualiza periódicamente para ofrecer nuevas opciones creativas. Interfaz fácil de usar con la funcionalidad de arrastrar y soltar para facilitar su uso. Alabado sea el servicio de atención al cliente, atento y servicial. Herramientas avanzadas de IA para la generación de guiones y la conversión de vídeo a partir de texto. Desventajas: Dependencia de una conexión a Internet estable debido a su naturaleza online. Algunos usuarios encuentran engorrosa la transición entre plantillas. Los tiempos de exportación pueden ser largos para proyectos complejos. Las funciones avanzadas requieren una curva de aprendizaje que puede resultar complicada para los principiantes. InVideo es especialmente beneficioso para las pequeñas empresas y los creadores de contenidos que necesitan una herramienta de creación de vídeo potente pero accesible. Su combinación de simplicidad, amplias opciones de medios de comunicación, y las características de colaboración lo convierten en una opción destacada para mejorar las estrategias de marketing de vídeo y agilizar los procesos de producción de vídeo. Synthesia – Entre las Mejores Herramientas de Generación de Video AI Disponibles Synthesia: Entre las mejores herramientas de generación de vídeo de IA disponibles Synthesia ha surgido como una de las principales plataformas de generación de vídeo con IA, ampliamente reconocida por su eficacia a la hora de transformar texto en vídeos visualmente atractivos sin necesidad de recurrir a los montajes de filmación tradicionales. Esta plataforma es célebre por su capacidad para ahorrar hasta un 80% de tiempo y presupuesto a más de 50.000 equipos en todo el mundo, lo que la convierte en la mejor opción para una gran variedad de necesidades de producción de vídeo. Características de Synthesia Synthesia ofrece una impresionante gama de características que agilizan el proceso de creación de vídeo. Con más de