Fiebre de contratación de consultores de IA de OpenAI: Reducción de la brecha de adopción en las empresas

Cambio estratégico de OpenAI: Creación de un ejército de consultores de IA A medida que OpenAI avanza hacia su ambicioso objetivo de 100.000 millones de dólares de ingresos para 2027, el fabricante de ChatGPT está creando un ejército de consultores de IA para salvar la distancia entre la tecnología de vanguardia y las salas de juntas de las empresas, un movimiento que señala un cambio fundamental en la forma en que las empresas de IA están abordando el reto notoriamente difícil de la adopción por parte de las empresas. Según datos del sector y patrones de contratación recientes, OpenAI está ampliando significativamente sus equipos de salida al mercado en un momento en el que el negocio empresarial de la empresa está en plena expansión. La startup alcanzó los 20.000 millones de dólares de ingresos anualizados en 2025, frente a los 6.000 millones de 2024, y más de un millón de organizaciones utilizan ya su tecnología. El reto de la adopción empresarial La agresiva estrategia de contratación refleja una verdad más amplia sobre la IA empresarial: la tecnología se vende sola en demostraciones, pero implementarla a escala requiere un conjunto de habilidades completamente diferente. Un estudio reciente publicado en Second Talent muestra que, si bien el 87% de las grandes empresas están implementando soluciones de IA, solo el 31% de los casos de uso de IA alcanzan la plena producción, y la brecha entre los proyectos piloto y el despliegue en toda la empresa sigue siendo obstinadamente amplia. “La verdadera historia no es solo la contratación de consultores, sino lo que esto revela sobre la maduración de la IA empresarial”, dijo un analista de la industria que solicitó el anonimato. “Estamos pasando de un mundo en el que las empresas compraron IA por FOMO a uno en el que necesitan una experiencia de implementación seria para capturar realmente el valor” El reto es polifacético. Según múltiples encuestas de la industria, los principales desafíos de adopción de IA empresarial en 2025 incluyen la complejidad de la integración en un 64%, los riesgos de privacidad de datos en un 67% y las preocupaciones de confiabilidad en un 60%. No se trata de problemas que puedan resolverse únicamente con mejores modelos, sino que requieren experiencia humana en gestión del cambio, rediseño de flujos de trabajo y transformación organizativa. El panorama competitivo OpenAI no es la única que reconoce la brecha existente en la implementación empresarial. Anthropic, que está en vías de alcanzar un objetivo de 9.000 millones de dólares en ingresos anualizados para finales de 2025, con objetivos de 20.000 a 26.000 millones de dólares para 2026, ha adoptado un enfoque diferente al centrarse en asociaciones a gran escala. La empresa anunció recientemente acuerdos con Deloitte, Cognizant y Snowflake, esencialmente externalizando la capa de consultoría a empresas de servicios profesionales establecidas. según la empresa de investigación del sector Sacra, “Anthropic está posicionando a Claude como la alternativa para las empresas, básicamente ‘OpenAI para empresas que no quieren depender de OpenAI’”. Microsoft, por su parte, aprovecha sus relaciones con las empresas y sus asociaciones de consultoría, mientras que Google integra las capacidades de IA en su ecosistema de espacio de trabajo y nube. La estrategia de Amazon se centra en convertir AWS en la infraestructura de referencia para las implantaciones de IA en las empresas. Lo que revela la contratación de OpenAI La oleada de contrataciones de consultores de la que se ha informado sugiere que OpenAI está apostando por que el compromiso directo con el cliente resulte más eficaz que los modelos de mera asociación. Esto concuerda con tendencias más amplias en el software empresarial, donde los proveedores necesitan cada vez más conocimientos especializados para ayudar a los clientes a obtener valor. Las ofertas de empleo analizadas en varias plataformas muestran que OpenAI está contratando a directores de cuentas empresariales, gestores de implantación de IA y arquitectos de soluciones, todos ellos centrados en ayudar a las organizaciones a pasar de la prueba de concepto a la implantación en producción. El momento es crítico. Dado que la cuota de mercado empresarial de OpenAI ha caído del 50% al 34%, mientras que Anthropic ha duplicado su presencia del 12% al 24% en los modelos fundacionales, la empresa necesita demostrar que no sólo puede crear la mejor tecnología, sino también ayudar a las empresas a implantarla con éxito. La realidad de la implantación Para los responsables de TI de las empresas, la avalancha de consultores de IA que contratan los proveedores representa tanto una oportunidad como una advertencia. La oportunidad: acceso a profundos conocimientos técnicos para navegar por implantaciones complejas. La advertencia: si los propios proveedores necesitan cientos de consultores para hacer funcionar su tecnología, ¿qué dice eso de la madurez de estas soluciones? según un reciente informe del sector, “la mayoría de las organizaciones tratan la IA como una mejora táctica en lugar de como una herramienta estratégica, lo que da lugar a una ejecución fragmentada”. El éxito requiere algo más que tecnología: exige preparación organizativa, rediseño del flujo de trabajo y un replanteamiento fundamental de cómo se realiza el trabajo del conocimiento. La verdadera cuestión no es si OpenAI o sus competidores pueden contratar suficientes consultores. Es si las empresas pueden absorber con éxito estas tecnologías al ritmo que exige el sector. Dado que el 42% de los altos ejecutivos afirman que la adopción de la IA está “destrozando su empresa” debido a las luchas de poder, los conflictos y los silos organizativos, el reto humano puede resultar más difícil de resolver que el técnico. A medida que se intensifica la carrera armamentística de las ventas de IA, una cosa está clara: los ganadores no serán sólo las empresas con los mejores modelos, sino las que puedan guiar con éxito a las empresas a través del complicado y difícil trabajo de la transformación organizativa. La contratación masiva de consultores por parte de OpenAI sugiere que está aprendiendo esta lección por las malas. Definiciones y contexto La adopción empresarial se refiere al proceso por el

2026 Conferencias sobre IA: Descubra los principales eventos sobre Inteligencia Artificial

Las mejores conferencias sobre IA a las que asistir en 2026: Las mejores conferencias sobre IA que definirán el futuro de la Inteligencia Artificial El panorama de la inteligencia artificial en 2026 presenta a los profesionales más de 350 reuniones mundiales, aunque sólo un grupo selecto ofrece un valor que acelera la carrera profesional. Esta guía identifica los principales eventos en los que los avances de la investigación se encuentran con el despliegue comercial, en los que los responsables de contratación buscan talentos y en los que las tecnologías demostradas hoy se convertirán en los estándares del sector en el futuro. Con una inversión en IA que alcanza los 284.000 millones de dólares en todo el mundo y empresas que despliegan el aprendizaje automático a una escala sin precedentes, la asistencia a conferencias estratégicas separa a los profesionales que se suben a la ola de la innovación de los que reaccionan ante ella. Los datos son claros: el 78% de los profesionales de la IA atribuyen la promoción profesional directa a las conexiones realizadas en los principales eventos del sector, según la investigación de la encuesta 2024 Kaggle State of ML Survey. Notas clave – Conferencias sobre Inteligencia Artificial de 2026 Los gigantes académicos NeurIPS, ICML e ICLR mantienen la excelencia en la investigación con tasas de aceptación inferiores al 27%, lo que garantiza que las presentaciones representan avances genuinos en lugar de iteraciones incrementales Conferencias del sector como NVIDIA GTC y The AI Summit ofrecen un retorno de la inversión inmediato a través de talleres prácticos, demostraciones de proveedores y acceso directo a los responsables de la toma de decisiones que controlan presupuestos tecnológicos de siete cifras Ladiversificación geográfica define 2026, con Singapur, Seúl y Río de Janeiro como sedes de eventos emblemáticos que rivalizan con las sedes norteamericanas tradicionales tanto en asistencia como en calidad de la investigación Los modelos híbridos se han estabilizado en tasas de participación virtual del 35-40%, creando estructuras de precios escalonadas en las que la asistencia física cuesta entre 3 y 4 veces más, pero aporta un valor desproporcionado a la creación de redes AI Expos – ¿Por qué es importante la selección estratégica de conferencias en 2026? El sector de la IA generó 196.000 millones de dólares de ingresos en 2024, con previsiones que superan los 400.000 millones para 2027. Dentro de este crecimiento explosivo, las interacciones cara a cara en conferencias cuidadosamente seleccionadas crean ventajas profesionales asimétricas. La investigación del Informe de LinkedIn sobre la fuerza laboral tecnológica de 2025 indica que los profesionales que asisten a 2-3 conferencias estratégicas al año avanzan 2,3 veces más rápido que sus compañeros que dependen únicamente del aprendizaje en línea. Más allá de la creación de redes, estos eventos funcionan como sistemas de alerta temprana. Las capacidades GPT-4 surgieron en sesiones exclusivas para invitados durante las conferencias 2023, lo que proporcionó a los asistentes una ventaja crítica de seis meses. Un patrón similar se repitió con la revelación de la arquitectura Blackwell de NVIDIA en GTC 2024 y los avances multimodales demostrados por primera vez en los talleres de CVPR. El cálculo financiero es sencillo: una inversión de 2.000 dólares en una conferencia que genere una asociación significativa, una oportunidad de trabajo o un conocimiento técnico que evite un desvío de seis meses ofrece un retorno de la inversión entre 10 y 20 veces superior. El reto consiste en determinar qué eventos se ajustan a sus objetivos específicos. Los mayores centros académicos de IA: Donde la investigación define los productos del mañana NeurIPS 2026 (Sistemas de procesamiento de información neuronal) Anuncio de la Conferencia NeuraIPS 2026, que se celebrará en Sydney, Australia Fechas: Del 6 al 12 de diciembre de 2026 Lugar: Sídney, Australia Asistencia prevista: 16.000 Coste de inscripción: de 900 a 1.000 $ (estudiantes/académicos), de 1.400 a 1.600 $ (industria), 375 $ (virtual) NeurIPS 2026 se celebrará en Sídney (Australia) por primera vez en el hemisferio sur. El momento elegido tiene una importancia estratégica: El posicionamiento de diciembre permite a los investigadores de IA presentar el trabajo realizado a lo largo del año natural, creando un punto final natural para los ciclos anuales de investigación. A quién va dirigido: Estudiantes de doctorado que estén creando un historial de publicaciones, investigadores científicos que sigan los avances algorítmicos, ingenieros de ML que busquen perspectivas de implantación y responsables técnicos que evalúen qué direcciones de investigación merecen una inversión en producción. La conferencia beneficia especialmente a quienes trabajan en arquitecturas de modelos fundacionales, técnicas de optimización y aprendizaje automático teórico. NeurIPS mantiene el proceso de revisión por pares más riguroso del sector. En la edición de 2025 se procesaron 15.671 presentaciones, con una tasa de aceptación del 22,6%. Esta selectividad garantiza que las presentaciones representen auténticos avances. A diferencia de muchas conferencias en las que predominan las mejoras incrementales, los artículos de NeurIPS suelen introducir nuevos marcos que reconfiguran subcampos enteros. La estructura del programa equilibra profundidad y amplitud. Las sesiones técnicas de la mañana incluyen presentaciones de investigaciones fundamentales: este año se prestará especial atención a las arquitecturas de mezcla de expertos, los métodos de entrenamiento eficientes y los marcos de interpretabilidad. Los talleres de la tarde se centrarán en los retos de implantación en los ámbitos de la sanidad, los sistemas autónomos y la informática científica. Las sesiones de pósters justifican por sí solas la asistencia. Los investigadores cuyas ponencias se han citado durante meses están junto a su trabajo, disponibles para debates técnicos de 20 minutos. Muchos asistentes afirman que estos intercambios informales resuelven los problemas de implantación más rápidamente que semanas de revisión de documentación. La presencia de la contratación corporativa rivaliza con la programación académica. DeepMind, OpenAI, Google Research, Anthropic, Meta AI y NVIDIA organizan inmersiones técnicas y eventos de contratación. Para aquellos que exploran transiciones profesionales, NeurIPS concentra a directores de contratación de organizaciones que definen la trayectoria del campo. Ponentes principales (confirmados a enero de 2026): Yoshua Bengio (Mila), Fei-Fei Li (Stanford), Demis Hassabis (Google DeepMind), Dario

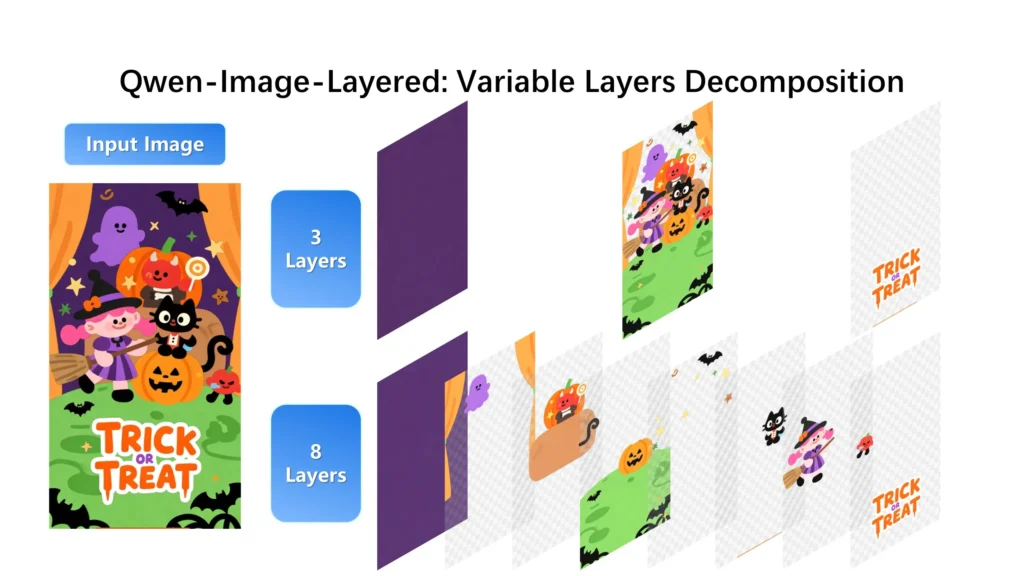

Por qué Qwen-Image-Layered es el cambio más importante en la edición de imágenes con IA

Qwen-Image-Layered introduce un cambio estructural específico en la forma en que la inteligencia artificial procesa los datos visuales, descomponiendo las imágenes RGB planas en múltiples capas RGBA semánticamente separadas. Este modelo va más allá de la simple manipulación de píxeles, ofreciendo un sistema en el que el fondo, el primer plano y los elementos de texto se aíslan en rebanadas distintas y transparentes para una edición precisa y no destructiva. Al integrar un transformador de difusión multimodal de descomposición de capas variables (VLD-MMDiT ), proporciona un puente funcional entre los gráficos de trama estáticos y los entornos de diseño modular como Photoshop o After Effects. Notas clave sobre la ganancia de información Integridad estructural: A diferencia de los modelos de imagen estándar, Qwen-Image-Layered preserva los datos de la imagen original aislando las ediciones en cortes RGBA específicos, lo que evita el “deslizamiento de alucinación” común en el inpainting tradicional. Granularidad recursiva: El modelo admite la descomposición recursiva infinita, lo que significa que cualquier capa puede dividirse a su vez en subcomponentes, proporcionando un nivel de control antes reservado al enmascaramiento manual. Integración profesional: Con soporte nativo para exportar a PSD (Photoshop) y PPTX (PowerPoint), este modelo tiende un puente entre la investigación en IA y los ecosistemas de software profesional establecidos. Intensidad de recursos: La principal contrapartida de esta precisión es el elevado consumo de VRAM (hasta 45 GB), aunque la cuantificación impulsada por la comunidad (FP8) está haciendo que la ejecución local sea más factible para los entusiastas. El mecanismo central de Qwen-Image-Layered Ilustración de cómo funciona la solución VLD-MMDiT (Variable Layers Decomposition MMDiT) en el sistema central de Qwen Image Layered Source La base técnica de Qwen-Image-Layered se basa en su capacidad para tratar una imagen no como un único “panqueque” de píxeles, sino como una pila de activos independientes. Esto se consigue mediante un RGBA-VAE que establece un espacio latente unificado para imágenes RGB estándar y RGBA transparentes. La mayoría de los modelos heredados tienen problemas con la transparencia porque sus datos de entrenamiento carecen de profundidad de canal alfa. Este modelo supera esa limitación entrenándose con un enorme conjunto de datos de composiciones en capas, lo que le permite predecir lo que hay detrás de un objeto en primer plano. La arquitectura VLD-MMDiT es la que permite la descomposición de longitud variable que caracteriza a Qwen-Image-Layered. A diferencia de los modelos de salida fija, este sistema puede generar tres, ocho o incluso más capas en función de la complejidad de la escena o de los requisitos del usuario. Cada capa contiene componentes semánticos o estructurales específicos -como una persona, un escritorio o un paisaje de fondo- que pueden modificarse individualmente. La descomposición recursiva es otra característica distintiva.En Qwen-Image-Layered, cualquier capa generada puede volver a introducirse en el modelo para dividirse en otras subcapas. Por ejemplo, una “capa de primer plano” que contenga un grupo de personas puede descomponerse de nuevo para aislar a cada individuo. De este modo se crea un proceso de edición jerárquico que imita los flujos de trabajo del diseño gráfico profesional, garantizando que los cambios en un elemento no provoquen artefactos o “sangrado” en los píxeles circundantes. Puntos de referencia técnicos y rendimiento comparativo Al evaluar Qwen-Image-Layered frente a titanes del sector como GPT-4o-vision o Claude 3.5 Sonnet, la distinción radica en el formato de salida. Mientras que GPT-4o destaca en el razonamiento y la descripción de lo que ve, Qwen-Image-Layered se centra en la reconstrucción física y la separación de los componentes visuales. Las pruebas comparativas recientes del trabajo de investigación original indican que el modelo consigue un desenredo semántico superior al de los métodos anteriores basados en el inpainting. Características Qwen-Capa de imagen GPT-4o-visión Soneto Claude 3.5 Salida primaria Múltiples capas RGBA Descripción del texto Texto / Código Editabilidad Inherente (basada en capas) Indirecta (basada en instrucciones) Indirecta (basada en preguntas) Transparencia Canal alfa nativo Ninguno Ninguno Arquitectura VLD-MMDiT LLM multimodal LLM multimodal Resolución máxima 1024px (Estándar) Variada (interna) Variada (interna) En las pruebas cara a cara de edición de imágenes complejas , Qwen-Image-Layered demuestra una ventaja única a la hora de mantener la coherencia visual. Los modelos tradicionales suelen “rebobinar” toda la imagen cuando se solicita una pequeña edición, lo que provoca la pérdida de detalles en áreas que deberían haber permanecido intactas. Como Qwen-Image-Layered aísla el elemento objetivo, el resto de la imagen permanece matemáticamente idéntica al original. La huella de memoria de este modelo es considerable, lo que refleja sus complejos requisitos de procesamiento.Según la documentación oficial de GitHub, ejecutar el modelo a una resolución de 1024px puede requerir hasta 45GB de VRAM durante el pico de inferencia. Esto la convierte en una herramienta principalmente para estaciones de trabajo profesionales o entornos en la nube de gama alta, aunque la comunidad está adoptando versiones cuantificadas de FP8 para llevar estas capacidades a hardware de consumo como la RTX 4090. Informes de campo: El veredicto de los usuarios Prueba de campo de Qwen-Image-Layered AI Image Tool por un usuario de Reddit – cuatro capas de una imagen de una chica en la habitación de un castillo Fuente Los comentarios de la comunidad en plataformas como Reddit y X ofrecen una visión matizada de Qwen-Image-Layered en su iteración actual. Si bien el potencial técnico es ampliamente reconocido, los primeros usuarios han puesto de relieve varios obstáculos prácticos. En el subreddit r/StableDiffusion, los usuarios señalan que, aunque la separación de capas es eficaz, la calidad “insatisfactoria” de las capas de fondo -las partes que el modelo tiene que “adivinar” que están detrás de los objetos- puede mostrar a veces artefactos clásicos de la IA. Comentarios de los usuarios de Reddit: “Decepción sobre Qwen-Image-Layered Esto es frustrante: no hay control sobre el contenido de las capas. (O no se lo podía decir) calidad de relleno insatisfactoria requiere muchos recursos el trabajo lleva mucho tiempo” Otro usuario en X mencionó que Qwen-Image-Layered es especialmente útil para la fotografía de productos. Al separar un producto de su fondo en un archivo RGBA

De los píxeles al significado: Cómo Mistral OCR 3 digitaliza lo analógico

Last Updated on diciembre 20, 2025 7:53 pm by Laszlo Szabo / NowadAIs | Published on diciembre 20, 2025 by Laszlo Szabo / NowadAIs De los píxeles al significado: Cómo Mistral OCR 3 Digitaliza lo analógico – Notas clave Preservación de la estructura semántica: Una de las características que definen a Mistral OCR 3 es su capacidad para mantener el diseño original de un documento, convirtiendo PDFs complejos en Markdown o JSON limpios en lugar de cadenas de texto desestructuradas. Manejo avanzado de elementos que no son texto: El modelo destaca en la identificación y el formateo correcto de ecuaciones matemáticas (en LaTeX), código de programación (conservando la sangría) y tablas de datos complejas, áreas en las que el OCR tradicional suele fallar. Optimización de costes y eficiencia: Mistral OCR 3 se ha diseñado para ser computacionalmente más ligero que el uso de modelos de lenguaje a gran escala para tareas de visión, ofreciendo una solución más económica para proyectos de digitalización empresarial de gran volumen. Robustez en entornos “ruidosos”: Los informes de campo indican que Mistral OCR 3 demuestra un rendimiento superior al procesar escaneados de baja calidad, imágenes distorsionadas o documentos con idiomas mezclados, lo que reduce la necesidad de corrección humana manual. El monje tranquilo: Mistral OCR 3 Internet se basa fundamentalmente en el texto, pero una parte asombrosa del conocimiento mundial permanece encerrada en imágenes estáticas, PDF escaneados y notas manuscritas impenetrables. Durante décadas, el reconocimiento óptico de caracteres (OCR) ha sido el instrumento más utilizado para resolver este problema, a menudo con resultados confusos de formatos rotos y caracteres mal interpretados. La llegada de Mistral OCR 3 supone un cambio radical en esta trayectoria tecnológica, que se aleja del simple cotejo de caracteres para acercarse a una auténtica comprensión visual. No se trata sólo de convertir píxeles en ASCII, sino de que el sistema comprenda la estructura semántica de un documento como lo haría un lector humano. Comprensión visual: A diferencia de las herramientas heredadas, Mistral OCR 3 comprende el diseño del documento, no sólo los caracteres individuales. En el pasado, la extracción de datos de una tabla financiera compleja o de un artículo científico requería una frágil cadena de herramientas dispares, cada una de ellas propensa a tipos específicos de fallos. Mistral OCR 3 reduce estos pasos a un proceso único y unificado que interpreta el diseño, el contexto y el contenido simultáneamente. Al aprovechar una arquitectura multimodal avanzada, este modelo no se limita a “ver” letras, sino que percibe las relaciones entre los puntos de datos, preservando la integridad de encabezados, notas a pie de página y barras laterales. Las implicaciones para los sectores que dependen en gran medida de la documentación -legal, médica y de archivos históricos- son profundas, ya que el coste de la digitalización se reduce al tiempo que la precisión se estabiliza en un nivel antes inalcanzable. Integración multimodal: Tiende un puente entre los modelos de visión y de lenguaje, permitiendo la extracción basada en consultas. Bajo el capó: la arquitectura de Mistral OCR 3 Para entender por qué Mistral OCR 3 funciona de forma diferente a sus predecesores, hay que ver cómo procesa la entrada visual. Los sistemas tradicionales se basaban en cuadros delimitadores -dibujaban cuadrados invisibles alrededor de lo que sospechaban que eran letras- y luego cotejaban el contenido de esos cuadrados con un diccionario. Mistral OCR 3 utiliza una arquitectura de codificador de visión que procesa la imagen completa del documento como un mapa semántico. Esto permite al sistema reconocer que una línea de texto en negrita es un encabezado de sección, o que un grupo de números pertenece específicamente a la tercera columna de un informe trimestral de beneficios. Este matiz arquitectónico resuelve uno de los quebraderos de cabeza más persistentes en el tratamiento de datos: la pérdida de estructura. Cuando una herramienta estándar escanea un PDF, el texto resultante es a menudo un flujo “plano” de palabras, que requiere un gran trabajo humano para reformatearlo. Mistral OCR 3 genera Markdown o JSON estructurados que reflejan la jerarquía del documento original, “remasterizando” el documento para la era digital en lugar de limitarse a transcribirlo. Los desarrolladores que trabajan con cadenas de Generación Mejorada de Recuperación (RAG) encuentran esto particularmente valioso, ya que el modelo alimenta datos limpios y troceados en bases de datos vectoriales, reduciendo las alucinaciones causadas por un mal formato. Rentabilidad: Los primeros usuarios informan de una reducción significativa en el uso de tokens en comparación con los avisos basados únicamente en la visión. Además, los datos de entrenamiento de Mistral OCR 3 abarcan una amplia gama de idiomas y escrituras históricas, lo que le permite manejar casos extremos que normalmente rompen otros modelos. Navega por documentos en varios idiomas con una fluidez sorprendente, cambiando de contexto sin generar los galimatías habituales en el software más antiguo. Esta solidez garantiza que las organizaciones globales puedan implantar una única solución en varias oficinas regionales sin necesidad de ajustar modelos distintos para alfabetos o estilos de documento diferentes. Informes de campo: Experiencias y opiniones de los usuarios Puede manejar mis notas manuscritas, que tengo problemas para leer. Cuando se trata de mis notas, éste es el mejor modelo que he probado. Estoy impresionado. – RJK (@RJKosz) diciembre 19, 2025 La verdadera prueba de fuego de cualquier software está en manos de los desarrolladores e ingenieros de datos que lo someten a pruebas de estrés en entornos de producción. Los primeros comentarios sugieren que Mistral OCR 3 se está labrando un nicho específico en el que la precisión se une a la velocidad. En plataformas como X (antes Twitter) y Reddit, los usuarios destacan a menudo la capacidad del modelo para manejar documentos “ruidosos” -escaneados con manchas de café, arrugas o poca luz- que normalmente no arrojarían ningún dato utilizable. En un debate detallado en un subreddit de aprendizaje automático, un usuario cambió el modelo de visión de un competidor por Mistral OCR 3 para procesar distintos tipos de recibos. Observaron que, mientras que otros

Secretos de Kling O1: Clips Perfectos en Segundos

Last Updated on diciembre 16, 2025 2:20 pm by Laszlo Szabo / NowadAIs | Published on diciembre 15, 2025 by Laszlo Szabo / NowadAIs Secretos de Kling O1: Clips Perfectos en Segundos – Notas Clave Simulación Cognitiva: Kling O1 utiliza un mecanismo de inferencia de “Cadena de Pensamiento” (CoT) para razonar sobre la física y la permanencia del objeto, yendo más allá de la simple coincidencia de patrones para simular un mundo 3D coherente. Arquitectura Unificada: El modelo integra entradas de texto, imagen y video en un único flujo de trabajo de “Multi-Elementos”, lo que permite una edición compleja, un nuevo estilo y una consistencia del sujeto a través de múltiples clips generados. Control de Alta Fidelidad: Características como el soporte de imágenes de múltiples referencias y el control de “Marco Inicial/Final” brindan a los creadores una precisión de dirección, minimizando el “destello” y la transformación comunes en el video de IA más antiguo. Impacto en el Mercado: Desarrollado por Kuaishou, Kling O1 demuestra el rápido avance de la IA china, ofreciendo herramientas accesibles para el consumidor que combinan generación y edición, interrumpiendo el flujo de trabajo tradicional de VFX. El Píxel Razonado: Dentro de la Arquitectura Cognitiva de Kling O1 Vídeos de muestra hechos por Kling o1 Fuente La era de la alucinación digital está terminando silenciosamente, reemplazada por una era de simulación calculada. Durante años, el sector del video generativo se definió por una lógica de ensueño donde los dedos se multiplicaban y la física era una mera sugerencia. Sin embargo, el lanzamiento de Kling O1 por el gigante tecnológico chino Kuaishou el 1 de diciembre de 2025 marca un giro hacia los modelos de video de “razonamiento”. A diferencia de sus predecesores que pintaban con probabilidad, Kling O1 parece construir escenas con una comprensión cognitiva del mundo físico. No solo predice el siguiente píxel; aparentemente calcula la causa y el efecto del movimiento antes de renderizar un solo fotograma. Este cambio de la generación estética a la simulación basada en la física sugiere que Kling O1 no es meramente una herramienta artística, sino un motor mundial rudimentario diseñado para desafiar los límites de lo que la IA puede renderizar de manera realista, haciendo que sus salidas sean mucho más consistentes que los sistemas anteriores. El salto arquitectónico que se encuentra en Kling O1 se centra en su mecanismo de inferencia de “Cadena de Pensamiento” (CoT), una técnica previamente reservada para grandes modelos de lenguaje (LLM). Cuando un usuario indica el sistema, Kling O1 se involucra en una fase de preprocesamiento donde mapea las relaciones espaciales, la permanencia del objeto y las fuentes de iluminación dentro de una capa intermedia semántica compartida. Este paso de razonamiento interno permite al modelo “entender” que un coche que circula detrás de un edificio debe volver a emerger por el otro lado, en lugar de desaparecer en el éter. Al tratar el video como una simulación 3D continua en lugar de una secuencia de imágenes 2D, Kling O1 logra una estabilidad temporal que anteriormente había eludido a muchos de sus homólogos occidentales. El resultado es un metraje que se siente fundamentado, pesado e increíblemente real, acercando significativamente a la industria a la cinematografía fotorrealista impulsada por indicaciones. La Muerte del “Destello”: Logrando la Consistencia Temporal Uno de los artefactos más persistentes en el video de IA ha sido el “destello” —el parpadeo que distrae donde las texturas hierven y las caras se transforman entre fotogramas. Kling O1 aborda esto a través de una arquitectura multimodal unificada que bloquea la identidad a lo largo del tiempo. Según inmersiones técnicas profundas, el modelo permite a los usuarios cargar hasta siete imágenes de referencia, que utiliza para construir una representación latente 3D consistente del sujeto. Esto significa que un personaje generado por Kling O1 puede girar 180 grados, caminar a través de la sombra y emerger con la misma estructura facial y detalles de la ropa, con Kuaishou afirmando que la consistencia del sujeto es superior al 96%, diciendo adiós efectivamente al intercambio de caras de IA como se señala en informes sobre su Biblioteca de Personajes. Esta capacidad fue destacada en un desglose detallado en CometAPI, que señala que el modelo procesa el lenguaje, las imágenes y el contexto de movimiento en un único espacio de razonamiento. Este “Lenguaje Visual Unificado” (MVL) evita el caótico efecto de fusión visto en modelos de difusión más antiguos. Cuando Kling O1 se encarga de una escena compleja, no trata al personaje y al fondo como capas separadas; los entiende como entidades que interactúan dentro de un espacio gobernado. Esto permite interacciones complejas —como una mano recogiendo una taza— donde los puntos de contacto son físicamente precisos, y el peso del objeto está implícito por el movimiento muscular del brazo, lo que lleva a secuencias de acción más suaves y creíbles. Informes de Campo: El Veredicto de Reddit La verdadera medida de Kling O1 se encuentra en las pruebas de estrés realizadas por la comunidad de código abierto, que llevan estos sistemas a sus límites absolutos. En plataformas como Reddit, el discurso ha cambiado de la diversión a la crítica práctica. En un hilo en r/CreatorsAI titulado “Probé Kling O1 durante una semana”, los usuarios diseccionaron las fortalezas y los extraños fallos del modelo. Un usuario, Playful-Detail, señaló que si bien Kling O1 sobresale en la consistencia de los personajes, todavía tiene dificultades con la generación de texto dentro del video, a menudo “masacrando las letras” incluso en niveles de pago. Puede leer el desglose completo de estas pruebas de usuario aquí en Reddit. Otro punto de discusión significativo es la función “Multi-Elementos”, que permite a los usuarios modificar el metraje existente con indicaciones de texto. Un usuario en un hilo separado elogió a Kling O1 por su capacidad para cambiar el atuendo de un protagonista sin destruir la iluminación de la escena, una tarea que anteriormente requería horas de rotoscopia manual. La capacidad del modelo para ejecutar la reconstrucción semántica a nivel de píxel, omitiendo la

Alibaba Wanxiang 2.6 Supera a sus Rivales en Video IA

Last Updated on diciembre 16, 2025 1:58 pm by Laszlo Szabo / NowadAIs | Published on diciembre 16, 2025 by Laszlo Szabo / NowadAIs Alibaba Wanxiang 2.6 Supera a sus Rivales en Video IA – Notas Clave Alibaba Wanxiang 2.6 es pionero en la interpretación de roles en la IA de video china, permitiendo la replicación de personajes a partir de subidas para escenas interactivas. Soporta videos de 15 segundos con sincronización de audio, múltiples tomas y 1080p, superando los límites nacionales para uso profesional. Accesible a través del sitio web de Wanxiang, la aplicación Qianwen y las API de Bailian para individuos y empresas. Impulsa publicidad, dramas y clips sociales con narrativas coherentes y controles cinematográficos. Alibaba Wanxiang 2.6: El Modelo de Video IA Líder de China Transforma la Creación de Contenido Fotograma de un video IA generado con Alibaba Wanxiang 2.6 Fuente Alibaba Wanxiang 2.6 se erige como una potente herramienta de generación de video de Alibaba Cloud. Este modelo maneja tareas complejas como la interpretación de roles y videos de múltiples tomas. Los usuarios acceden a él a través de plataformas como el sitio web oficial de Wanxiang y Bailian de Alibaba Cloud. Orígenes y Lanzamiento del Modelo Alibaba lanzó Wanxiang 2.6 el 16 de diciembre de 2025, como parte de la familia Tongyi Wanxiang. La actualización está dirigida a las necesidades profesionales de producción cinematográfica y creación de imágenes. Los desarrolladores lo construyeron para extender las capacidades de versiones anteriores como Wanxiang 2.5, que lideró los rankings chinos en tareas de imagen a video en los benchmarks LMArena. Esta versión llega en medio de una creciente demanda de herramientas multimedia impulsadas por IA. Alibaba posiciona a Wanxiang 2.6 como el generador de video más capaz disponible a nivel nacional. La disponibilidad abarca pruebas gratuitas en la aplicación Qianwen y acceso a API para empresas. Desglose de Características Clave Wanxiang 2.6 introduce la interpretación de roles, una primicia para los modelos de video chinos, donde los usuarios suben videos para replicar la apariencia y las voces de los personajes. Genera escenas con una o más personas interactuando con objetos basándose en indicaciones de texto. El sistema extrae detalles visuales como la postura y rasgos de audio como la velocidad del habla a través del modelado multimodal. La generación de múltiples tomas convierte descripciones simples en videos guionizados con narrativas coherentes a lo largo de las tomas. Los videos alcanzan hasta 15 segundos, la duración más larga en China, con sincronización audiovisual y opciones impulsadas por voz. Las herramientas adicionales cubren texto a video, imagen a video y edición para más de 10 tipos de creación. El soporte para resolución 1080p y formatos como vertical u horizontal se adapta a anuncios y clips sociales. La expansión de indicaciones refina automáticamente entradas cortas en guiones detallados. Estos elementos hacen que Alibaba Wanxiang 2.6 sea versátil para resultados profesionales rápidos. Innovaciones Técnicas Alibaba Wanxiang 2.6 emplea un modelado conjunto de entradas de video para alinear visuales y sonidos con precisión. Procesa clips de referencia para capturar movimiento, estilo y encuadre para nuevas generaciones de hasta 10 segundos en modo de referencia a video. Una alta consistencia en sujetos y escenas persiste a través de las transiciones de toma. El modelo maneja efectos cinematográficos como movimientos de cámara en escenarios de interpretación de roles. Los usuarios ingresan videos personales más indicaciones para cortometrajes de ciencia ficción completos con doblaje. Esta configuración permite resultados similares a películas en minutos para no expertos. Las características empresariales incluyen la integración API a través de Bailian para un uso escalable en publicidad y dramas. La familia admite salidas consistentes a través de generaciones, lo que ayuda a cómics y videos cortos. Por lo tanto, Alibaba Wanxiang 2.6 llena vacíos en la tecnología de video IA nacional. Experiencias de Usuario La retroalimentación sobre Alibaba Wanxiang 2.6 destaca su facilidad para tareas creativas, aunque las revisiones directas siguen siendo emergentes después del lanzamiento. En r/StableDiffusion de Reddit, los usuarios elogiaron las vistas previas anteriores de Wanxiang por el manejo de movimiento y física superior a rivales como Kling. Un comentarista señaló: “Estoy realmente impresionado… maneja el movimiento y la física mucho mejor”, expresando esperanza de acceso para el consumidor. Las discusiones en X y Reddit para herramientas similares de Alibaba muestran entusiasmo por la generación gratuita de videos. Un usuario compartió: “La capacidad de creación de video… está disponible de forma gratuita. Puedes crear un video de cinco segundos de notable calidad”, a pesar de los tiempos de renderizado más largos. Estas cuentas reflejan el atractivo práctico al probar Alibaba Wanxiang 2.6 para anuncios y proyectos personales. Los primeros usuarios reportan resultados sólidos en interpretación de roles y múltiples tomas a través de la aplicación Qianwen. Los hilos de la comunidad enfatizan la retención de detalles en las generaciones. Tales testimonios subrayan el papel de Alibaba Wanxiang 2.6 en la democratización de la producción de video. Aplicaciones en Todas las Industrias Alibaba Wanxiang 2.6 ayuda a la publicidad con narrativas rápidas de múltiples tomas a partir de indicaciones. Los productores de dramas cortos se benefician de los controles de guion gráfico que mantienen el flujo de la escena. Las características de voz del modelo agilizan el doblaje para contenido global. En las redes sociales, los videos verticales con audio sincronizado aumentan la participación. Las empresas aprovechan las API para la creación masiva en cómics y marketing. Alibaba Wanxiang 2.6 admite estilos desde realistas hasta animados en todas las resoluciones. Los entusiastas del cine suben clips para protagonizar cortometrajes personalizados, mezclando aportes personales con efectos profesionales. Esto se expande a videos educativos y de capacitación. En general, Alibaba Wanxiang 2.6 impulsa la eficiencia en los flujos de trabajo de contenido visual. Implicaciones Futuras Alibaba Wanxiang 2.6 fortalece el liderazgo de China en video IA con características como clips de 15 segundos. La integración en Qianwen y Bailian amplía el alcance. Las actualizaciones en curso prometen controles refinados y duraciones más largas. Las empresas obtienen herramientas para visuales

Llega ChatGPT 5.2: La Respuesta “Código Rojo” de OpenAI a Gemini 3

Last Updated on diciembre 11, 2025 8:59 pm by Laszlo Szabo / NowadAIs | Published on diciembre 11, 2025 by Laszlo Szabo / NowadAIs Llega ChatGPT 5.2: La Respuesta “Código Rojo” de OpenAI a Gemini 3 – Notas Clave Lanzamiento Estratégico: ChatGPT 5.2 fue lanzado el 11 de diciembre de 2025, como una respuesta acelerada de “Código Rojo” a la presión competitiva de Gemini 3 de Google, centrándose en el rendimiento central en lugar de nuevas funciones. Estructura de Modelo por Niveles: La actualización presenta tres variaciones de modelo distintas: Instant (rápido, casual), Thinking (deliberado, enfocado en el razonamiento) y Pro (alta capacidad, profesional), para atender a diferentes necesidades de los usuarios. Voz Multimodal Integrada: Una nueva interfaz de voz permite una interacción fluida donde las respuestas de audio se combinan con elementos visuales, texto y widgets en pantalla en tiempo real, eliminando la necesidad de un modo de voz separado. Conectividad Empresarial: ChatGPT 5.2 presenta una profunda integración con herramientas de negocios como Atlassian (Jira, Confluence) a través del Protocolo de Contexto del Modelo (Model Context Protocol), lo que permite acciones directas de flujo de trabajo dentro de la interfaz de chat. La Respuesta “Código Rojo”: Interpretando la Prisa por el Lanzamiento El sector de la tecnología de Inteligencia Artificial se despertó esta mañana con un desarrollo significativo, aunque algo anticipado, proveniente de los laboratorios de OpenAI. En un movimiento que los expertos de la industria describen como una contraofensiva directa al reciente dominio de Gemini 3 de Google, el lanzamiento de ChatGPT 5.2 ha comenzado oficialmente a partir del 11 de diciembre de 2025. Esta actualización no es simplemente un parche de rutina; representa un giro estratégico, a menudo denominado internamente como “Código Rojo”, destinado a recuperar la corona del rendimiento. La atmósfera que rodea este lanzamiento es distinta de las iteraciones anteriores. Hay menos pompa y más urgencia, un cambio que sugiere que la compañía está enfocada intensamente en la utilidad y la capacidad pura en lugar del espectáculo de marketing. El despliegue de ChatGPT 5.2 se está llevando a cabo en fases, llegando primero a los suscriptores Plus, Pro y Enterprise, y luego a un lanzamiento más amplio. La narrativa que impulsa este lanzamiento es innegablemente competitiva. Tras los elogios vertidos sobre Gemini 3 de Google por parte de luminarias tecnológicas, incluido un raro reconocimiento de Elon Musk, OpenAI ha acelerado su cronograma. Informes de los principales medios indican que ChatGPT 5.2 estaba originalmente programado para debutar a fines de diciembre o principios de enero. Sin embargo, la jerarquía rápidamente cambiante de la tabla de clasificación obligó a una recalibración de prioridades. El resultado es una familia de modelos que evita las nuevas y llamativas modalidades en favor de profundas mejoras estructurales en el razonamiento, la codificación y la confiabilidad. Esta es una actualización de “lo esencial” diseñada para apuntalar los cimientos que hicieron de la plataforma un nombre conocido en primer lugar. Para los profesionales y usuarios avanzados, la llegada de ChatGPT 5.2 marca un regreso a la forma. Las notas de la versión enfatizan una transición a una arquitectura más robusta, que presenta tres variaciones distintas: GPT-5.2 Instant, GPT-5.2 Thinking y GPT-5.2 Pro. Cada una cumple una función específica, desde la recuperación rápida de información hasta la resolución de problemas profunda y deliberativa. Esta segmentación reconoce que un enfoque de “talla única” ya no es viable para una audiencia que abarca desde consultas casuales hasta complejas tareas de ingeniería de software. La nueva fecha límite de conocimiento de agosto de 2025 garantiza que el modelo esté actualizado, abordando una de las quejas más persistentes con respecto a las versiones anteriores. Deconstruyendo la Arquitectura de Modelo de Tres Niveles Puntos de Referencia de GPT 5.2 vs GPT 5.1Fuente El cambio más inmediato que notarán los usuarios en la interfaz de ChatGPT 5.2 es la selección explícita entre tres comportamientos de modelo especializados. Esto es un alejamiento del “cambio dinámico” opaco del pasado. ChatGPT 5.2 Instant está diseñado para la velocidad y la eficiencia, manejando la mayor parte de las tareas diarias como la redacción de correos electrónicos, la elaboración de resúmenes y las consultas básicas. Conserva la calidez conversacional introducida en la versión 5.1, pero elimina la latencia que plagaba a los modelos más pesados. Para los usuarios que necesitan respuestas rápidas sin el tiempo de espera asociado con las cadenas de razonamiento profundas, esta variante sirve como el conductor diario confiable. En el otro extremo del espectro se encuentran las variantes “Thinking” y “Pro” de ChatGPT 5.2. Estos modelos son donde los esfuerzos de ingeniería de “Código Rojo” son más visibles. El modelo “Thinking” está diseñado para hacer una pausa y deliberar, generando literalmente una cadena de pensamiento oculta antes de emitir una respuesta, para reducir los errores de lógica en matemáticas y ciencias. El modelo “Pro”, promocionado como la iteración más inteligente hasta la fecha, integra estas capacidades de razonamiento con ventanas de contexto masivas y uso avanzado de herramientas. Los primeros puntos de referencia citados en las notas oficiales de la versión sugieren que ChatGPT 5.2 Pro reduce significativamente los errores importantes en dominios complejos como la programación y la ciencia de datos, una métrica crítica para la base de usuarios profesionales de la plataforma. Este enfoque por niveles también resuelve el conflicto de “personalidad versus utilidad” que surgió con GPT-5.1. Mientras que el modelo Instant mantiene un comportamiento amigable, la versión Pro de ChatGPT 5.2 adopta un tono más neutral y objetivo adecuado para el trabajo de alto riesgo. Esta bifurcación permite que la plataforma sirva a dos amos: el usuario casual que busca un compañero de chat atractivo y el ingeniero que requiere código preciso y sin adornos. Al separar estas distintas necesidades en diferentes pesos de modelo, OpenAI espera mitigar la fatiga del usuario causada por las respuestas demasiado conversadoras o condescendientes reportadas en versiones anteriores. La Integración de Voz y Contexto Visual Una de las actualizaciones más tangibles en ChatGPT 5.2 es la revisión de la interfaz

Mistral 3 Analizado: ¿Pueden Realmente los Modelos de Código Abierto de Francia Desafiar a OpenAI?

Last Updated on diciembre 9, 2025 1:16 pm by Laszlo Szabo / NowadAIs | Published on diciembre 3, 2025 by Laszlo Szabo / NowadAIs Mistral 3 Analizado: ¿Pueden Realmente los Modelos de Código Abierto de Francia Desafiar a OpenAI? – Notas Clave Familia de Modelos Integral: Mistral 3 incluye diez modelos que van desde el sistema de frontera Mistral Large 3 de 675B parámetros hasta las variantes compactas Ministral 3B optimizadas para dispositivos de borde (edge devices), todos lanzados bajo la permisiva licencia Apache 2.0 para uso comercial sin restricciones. Equilibrio entre Eficiencia y Rendimiento: La arquitectura emplea un diseño de ‘Mezcla de Expertos’ (Mixture of Experts) con 41B parámetros activos para Large 3, logrando hasta 10 veces mejoras de rendimiento en sistemas NVIDIA GB200, mientras que los modelos Ministral generan un orden de magnitud menos tokens que sus competidores para tareas equivalentes. Capacidades Multilingües y Multimodales: A diferencia de los competidores centrados principalmente en inglés, Mistral 3 ofrece soporte nativo para más de 40 idiomas, incluidos todos los idiomas de la UE y numerosos idiomas asiáticos, con procesamiento unificado de texto y visión en una única arquitectura de modelo. Posicionamiento Estratégico de Código Abierto: Mistral se diferencia a través de una transparencia completa con pesos descargables, cumplimiento del GDPR como empresa francesa, precios agresivos aproximadamente un 80% más bajos que las alternativas propietarias, y la capacidad de ejecutarse localmente sin conectividad a internet para escenarios de soberanía de datos e implementación en el borde. Mistral 3: La Apuesta de IA de Europa que Podría Remodelar la Frontera del Código Abierto La carrera armamentística de la inteligencia artificial se ha vuelto más interesante. El 2 de diciembre de 2025, la startup con sede en París Mistral AI anunció Mistral 3, una familia de diez modelos de peso abierto que tiene como objetivo demostrar que la IA europea puede competir con los gigantes de Silicon Valley, a la vez que ofrece algo que sus rivales estadounidenses no ofrecen: transparencia y control completos. El lanzamiento incluye tanto un modelo de frontera masivo llamado Mistral Large 3 como nueve variantes más pequeñas “Ministral 3” diseñadas para ejecutarse en todo, desde teléfonos inteligentes hasta drones autónomos. Todos los modelos se distribuyen bajo la permisiva licencia Apache 2.0, lo que permite el uso comercial sin restricciones, sin las limitaciones que definen a competidores como OpenAI y Anthropic. Este no es solo otro lanzamiento de modelo en un mercado cada vez más abarrotado. Mistral 3 representa una apuesta fundamental sobre cómo se implementará realmente la IA en el mundo real. Mientras los gigantes tecnológicos compiten por construir sistemas propietarios cada vez más grandes que requieren una costosa infraestructura en la nube, Mistral apuesta a que las empresas finalmente elegirán flexibilidad, control de costos e independencia sobre ganancias marginales de rendimiento. El científico jefe de la compañía, Guillaume Lample, dijo a VentureBeat que la brecha entre los modelos de código cerrado y código abierto se está reduciendo rápidamente, y Mistral 3 está diseñado para acelerar esa convergencia. El Modelo Insignia: Mistral Large 3 Apunta a la Frontera Puntos de Referencia de MIstral 3 Fuente Mistral Large 3 emplea una arquitectura granular de ‘Mezcla de Expertos’ con 41 mil millones de parámetros activos extraídos de un grupo de 675 mil millones de parámetros totales. Esta elección de diseño no es arbitraria. Al activar solo redes neuronales “expertas” específicas para cada tarea en lugar de encender el modelo completo, Large 3 mantiene la velocidad de un sistema mucho más pequeño mientras accede a vastas reservas de conocimiento. El modelo fue entrenado desde cero en aproximadamente 3.000 GPUs NVIDIA H200, aprovechando la memoria de alto ancho de banda para soportar cargas de trabajo a escala de frontera. La arquitectura es importante porque aborda directamente uno de los mayores dolores de cabeza de la IA empresarial: el costo y la latencia de ejecutar modelos masivos. Según TechCrunch, Mistral Large 3 presenta una ventana de contexto de 256.000 tokens y ofrece capacidades tanto multimodales (procesamiento de texto e imágenes) como soporte multilingüe en más de 40 idiomas. Este enfoque multilingüe lo distingue de muchos competidores que optimizan principalmente para el inglés. Lample enfatizó que la mayoría de los laboratorios de IA se concentran en su idioma nativo, pero Mistral Large 3 fue entrenado en idiomas de toda la Unión Europea y numerosos idiomas asiáticos, haciendo que la IA avanzada sea útil para miles de millones de hablantes no ingleses. En los puntos de referencia, Mistral Large 3 se mantiene firme frente a competidores tanto abiertos como cerrados. Actualmente ocupa el segundo lugar entre los modelos de código abierto sin razonamiento en la clasificación de LMArena, y el sexto lugar en general entre los sistemas de código abierto. Según el análisis de Binary Verse AI, el modelo gana en pruebas de conocimiento general como MMMLU y evaluaciones de razonamiento experto como GPQA-Diamond, aunque se queda ligeramente rezagado detrás de algunos competidores en tareas de codificación. La Jugada de Borde: Ministral 3 Lleva la IA a Todas Partes Si Mistral Large 3 apunta al centro de datos, la línea Ministral 3 apunta a la ubicuidad. Estos nueve modelos vienen en tres tamaños: 14 mil millones, 8 mil millones y 3 mil millones de parámetros, cada uno disponible en tres variantes. Los modelos base proporcionan fundamentos para una personalización exhaustiva. Las variantes Instruct optimizan para flujos de trabajo de chat y asistente. Los modelos Reasoning abordan la lógica compleja que requiere una deliberación paso a paso. Todos soportan capacidades de visión y operación multilingüe. Los modelos Ministral 3 más pequeños pueden ejecutarse en dispositivos con tan solo 4 gigabytes de memoria de video utilizando cuantización de 4 bits, según VentureBeat. Esto hace que las capacidades de IA de frontera sean accesibles en ordenadores portátiles estándar, teléfonos inteligentes y sistemas integrados sin necesidad de costosa infraestructura en la nube o incluso conectividad a internet. Lample enfatizó que Ministral 3 puede ejecutarse en una sola GPU, haciéndolo desplegable en hardware asequible para empresas que mantienen los

LongCat-Image Generator: La IA Gratuita que Supera a Competidores de Mil Millones de Dólares

Last Updated on diciembre 9, 2025 11:45 am by Laszlo Szabo / NowadAIs | Published on diciembre 8, 2025 by Laszlo Szabo / NowadAIs LongCat-Image Generator: La IA Gratuita que Supera a Competidores de Mil Millones de Dólares – Notas Clave El LongCat-Image Generator ofrece generación de imágenes de calidad profesional con solo 6 mil millones de parámetros, demostrando que la eficiencia y el rendimiento no son mutuamente excluyentes. La arquitectura compacta del modelo permite su implementación en hardware de consumo, manteniendo velocidades de generación de aproximadamente dos segundos por imagen, lo que lo hace accesible para creadores independientes y pequeñas empresas sin recursos informáticos de nivel empresarial. El soporte bilingüe nativo distingue al LongCat-Image Generator en un mercado dominado por modelos centrados en el inglés. Con cobertura completa de los 8.105 caracteres chinos estándar y una puntuación de referencia ChineseWord de 90.7, el modelo sobresale en la representación de tipografía china compleja, incluidas fuentes de caligrafía tradicional, señalización de tiendas y materiales de marketing donde la precisión en la representación de texto impacta directamente en la credibilidad profesional y la confianza del usuario. La licencia de código abierto Apache 2.0 crea oportunidades para la personalización y la innovación imposibles con alternativas propietarias. Los desarrolladores obtienen acceso al código de entrenamiento completo, puntos de control intermedios para el ajuste fino y documentación completa que permite una personalización profunda para casos de uso específicos. Esta transparencia genera confianza al tiempo que acelera la innovación a través de contribuciones de la comunidad, incluidos adaptadores LoRA, integraciones de ComfyUI y herramientas de implementación especializadas. Las capacidades de edición transforman el modelo de una herramienta de generación a un asistente creativo integral. Al admitir 15 operaciones de edición distintas a través de comandos de lenguaje natural, LongCat-Image Generator mantiene la coherencia visual en sesiones de edición de múltiples pasos sin introducir artefactos o desviaciones de estilo. Esta preservación de la coherencia hace que el refinamiento iterativo sea práctico para flujos de trabajo profesionales donde múltiples rondas de ajustes son una práctica estándar para lograr resultados finales que cumplan con las especificaciones del cliente. Explorando el LongCat-Image Generator El gigante tecnológico chino Meituan ha entrado en la competitiva arena de la generación de imágenes con IA con su LongCat-Image Generator, un modelo de código abierto que desafía a los actores establecidos y ofrece algo que ellos no: total transparencia y accesibilidad. Con solo 6 mil millones de parámetros, esta potencia bilingüe ofrece imágenes con calidad de estudio a velocidades que dejan a los competidores luchando, todo mientras mantiene el tipo de precisión en la representación de texto chino que durante mucho tiempo ha sido un punto débil para los modelos de IA occidentales. La Paradoja de la Eficiencia: Cuando Menos es Más Clasificación de calidad – Puntos de referencia de LongCat AI Image Generator Fuente El tamaño no lo es todo en el mundo de la generación de imágenes con IA. El LongCat-Image Generator lo demuestra con su compacta arquitectura de 6B parámetros que supera a modelos varias veces su tamaño. Según los datos de referencia del sitio web oficial, el modelo genera imágenes de alta calidad en aproximadamente dos segundos, una velocidad que lo posiciona como uno de los más rápidos de la industria. La arquitectura técnica revela por qué esta eficiencia es importante. Construido sobre una columna vertebral híbrida MM-DiT y Single-DiT combinada con un codificador de condición Vision Language Model, LongCat-Image Generator no solo genera imágenes, sino que las comprende. Este diseño permite que las capacidades de generación de texto a imagen y de edición se refuercen mutuamente, creando un efecto sinérgico que beneficia a ambas funciones. El modelo ofrece lo que Meituan denomina los “tres pilares” de la generación de imágenes: tiempos de respuesta rápidos, calidad de grado fotográfico y precisión de renderizado. Lo que distingue a este modelo de las alternativas infladas es su enfoque estratégico en el uso de parámetros. Mientras que los competidores acumulan miles de millones de parámetros para lograr mejoras marginales, los ingenieros de Meituan se centraron en la optimización y la eficiencia. El resultado es un modelo que se ejecuta sin problemas en hardware de consumo, democratizando el acceso a la generación de imágenes con IA de nivel profesional de una manera que las alternativas caras y hambrientas de recursos simplemente no pueden igualar. Rompiendo la Barrera del Idioma: Dominio en el Renderizado de Texto Chino La mayoría de los generadores de imágenes con IA tratan los caracteres chinos como una ocurrencia tardía, produciendo texto confuso o tipografía incómoda que limita su utilidad en el mercado más poblado del mundo. El LongCat-Image Generator cambia este guion por completo. Con una puntuación de referencia ChineseWord de 90.7 y una cobertura de todos los 8.105 caracteres chinos estándar, según lo informado por la documentación oficial de Meituan, este modelo establece un nuevo estándar para la IA multilingüe. Las implicaciones prácticas se extienden mucho más allá del simple reconocimiento de caracteres. Los propietarios de tiendas pueden generar señalización con complejas fuentes de caligrafía. Los equipos de marketing pueden crear materiales promocionales con intrincada tipografía china sin preocuparse por los errores de renderizado. Los diseñadores que trabajan en portadas de libros, carteles o anuncios finalmente pueden confiar en un modelo de IA para manejar sus necesidades de texto chino con la misma fiabilidad que esperan para el contenido en inglés. Esta capacidad bilingüe se deriva de estrategias de aprendizaje curricular y marcos de entrenamiento especializados diseñados específicamente para manejar la complejidad de las estructuras de trazos chinos. A diferencia de los modelos que añaden soporte para el chino como un apéndice, el LongCat-Image Generator trata ambos idiomas como ciudadanos de primera clase, logrando una precisión de renderizado que iguala o supera a las herramientas dedicadas al idioma chino, mientras mantiene un sólido rendimiento en inglés. La Ventaja del Código Abierto: Transparencia e Innovación Mientras que compañías como Midjourney y OpenAI protegen sus modelos detrás de muros propietarios, Meituan ha lanzado el LongCat-Image Generator bajo una licencia Apache 2.0

De Retratos Estáticos a Intérpretes Digitales: Dentro de Kling AI Avatar 2.0

Last Updated on diciembre 6, 2025 8:10 pm by Laszlo Szabo / NowadAIs | Published on diciembre 5, 2025 by Laszlo Szabo / NowadAIs De Retratos Estáticos a Intérpretes Digitales: Dentro de Kling AI Avatar 2.0 – Notas Clave La Arquitectura Multimodal Impulsa la Expresión: Kling AI Avatar 2.0 emplea un sofisticado Director MLLM (Modelo de Lenguaje Grande Multimodal) que interpreta el contexto emocional de la entrada de audio y coreografía las expresiones faciales y los movimientos corporales correspondientes, yendo más allá de la simple sincronización labial para crear interpretaciones digitales genuinamente expresivas. El marco de generación en cascada de dos etapas primero analiza el audio completo para crear un guion gráfico semántico, luego genera segmentos de video en paralelo mientras mantiene la consistencia de la identidad y la coherencia temporal en toda la salida. Calidad Profesional a Precios Accesibles: El sistema genera videos a 48 fotogramas por segundo y resolución 1080p, especificaciones que lo sitúan en territorio de producción profesional, mientras que las estructuras de precios que oscilan entre aproximadamente $0.0562 y $0.115 por segundo lo hacen accesible para aplicaciones comerciales. Esto representa un punto intermedio entre las herramientas amateur gratuitas y las soluciones de nivel empresarial, ofreciendo una calidad que supera significativamente a los sistemas anteriores de generación de avatares a costos sustancialmente inferiores a la producción de video tradicional que involucra talento humano y equipo profesional. Capacidades Multilingües Permiten el Alcance Global: Los datos de entrenamiento que abarcan chino, inglés, japonés y coreano permiten que Kling AI Avatar 2.0 maneje contenido lingüístico diverso a través de un único modelo unificado, eliminando la necesidad de sistemas separados para cada idioma. Esta flexibilidad tiene implicaciones prácticas inmediatas para campañas de marketing internacionales, contenido educativo global y aplicaciones de comunicación intercultural donde mantener una identidad de marca consistente mientras se adapta a los idiomas locales requería anteriormente costosos esfuerzos de localización. El Feedback del Usuario Destaca Tanto la Promesa como la Fricción: Los datos de la plataforma que muestran un aumento del 300% en el volumen de generación el día del lanzamiento demuestran una fuerte demanda del mercado, con usuarios que elogian constantemente la autenticidad emocional, la precisión de la sincronización labial y la facilidad de operación como características destacadas. Este entusiasmo coexiste con preocupaciones pragmáticas sobre los sistemas de créditos, el acceso a la cola para usuarios del nivel gratuito, los desafíos de consistencia con escenas complejas y las implicaciones más amplias de hacer que la generación de video sintético de calidad profesional sea accesible para cualquier persona con una fotografía y un archivo de audio. Por Qué Kling AI Avatar 2.0 es Importante El espacio de los avatares digitales ha experimentado una rápida transformación en los últimos meses, pero pocos lanzamientos han generado tanta tracción inmediata como Kling AI Avatar 2.0 de Kuaishou Technology. A pocas horas de su lanzamiento, los datos de la plataforma mostraron que la generación de videos aumentó en un 300% a medida que los creadores se apresuraban a probar lo que muchos llaman el primer sistema humano digital verdaderamente expresivo impulsado por IA. Donde las iteraciones anteriores producían la rigidez familiar de los primeros *deepfakes*, Kling AI Avatar 2.0 promete algo diferente: avatares que levantan las cejas cuando están escépticos, sonríen con calidez genuina y mueven los hombros al ritmo de la música. Esta no es solo otra actualización incremental en la carrera armamentista de la generación de videos por IA. El sistema representa un cambio fundamental en cómo las máquinas interpretan y traducen la emoción humana en rendimiento digital. Para los creadores de contenido ahogados en costos de producción, los educadores que buscan videos instructivos atractivos y los especialistas en marketing desesperados por campañas multilingües, Kling AI Avatar 2.0 ofrece una propuesta intrigante: videos de “cabeza parlante” de calidad profesional generados a partir de nada más que una sola fotografía y un archivo de audio. La Tecnología Rendimiento de Kling AI Avatar 2.0Fuente En el corazón de Kling AI Avatar 2.0 se encuentra lo que Kuaishou llama el Director de Modelo de Lenguaje Grande Multimodal (MLLM), un sistema que funciona como un director de cine virtual. A diferencia de los generadores de avatares anteriores que simplemente hacían coincidir las formas de la boca con los fonemas, esta arquitectura interpreta el contexto emocional de la entrada de audio y coreografía las expresiones faciales y el lenguaje corporal correspondientes. El sistema acepta tres entradas: una imagen de referencia, una pista de audio y mensajes de texto opcionales que guían el estilo de la interpretación. La implementación técnica utiliza un marco de generación en cascada de dos etapas. Durante la primera etapa, el Director MLLM analiza el clip de audio completo para crear un plan semántico de alto nivel, esencialmente un guion gráfico de ritmos emocionales y puntos de énfasis. La segunda etapa extrae fotogramas clave de este plano y genera segmentos de video en paralelo, asegurando tanto la consistencia de la identidad como la coherencia temporal en la salida final. Este enfoque aborda lo que los desarrolladores llaman el desafío fundamental en la animación facial impulsada por audio: desenredar la sincronización labial de la expresividad emocional durante la generación. Kling AI Avatar 2.0 admite una salida a 48 fotogramas por segundo y resolución 1080p, especificaciones que lo sitúan firmemente en territorio de producción profesional. El modelo maneja diversos tipos de personajes (humanos fotorrealistas, animales, personajes de dibujos animados y representaciones artísticas estilizadas) todo a través de la misma arquitectura unificada. Los puntos de referencia de las pruebas demuestran una precisión de respuesta superior al 90% en 375 casos de muestra que involucran escenarios de canto complejos, una aplicación particularmente exigente donde la sincronización audiovisual se hace más evidente. Construcción del Conjunto de Datos de Entrenamiento La calidad de cualquier sistema de IA depende en última instancia de sus datos de entrenamiento, y Kuaishou invirtió considerables recursos en el ensamblaje de lo que describen como miles de horas de video curado. El equipo recopiló imágenes que abarcan el habla, el diálogo y la interpretación