Last Updated on noviembre 8, 2025 1:44 pm by Laszlo Szabo / NowadAIs | Published on noviembre 8, 2025 by Laszlo Szabo / NowadAIs

La IA libre que supera a la GPT-5: el rendimiento récord de Kimi K2 Thinking – Notas clave

El modelo de peso abierto supera a los competidores cerrados: Kimi K2 Thinking supera a GPT-5 y a Claude Sonnet 4.5 en varias pruebas de razonamiento y agenciamiento, como Humanity’s Last Exam (44,9% frente a 41,7% y 32,0%) y BrowseComp (60,2% frente a 54,9% y 24,1%), sin dejar de ser completamente libre y de código abierto bajo una licencia MIT modificada

Capacidades de largo plazo sin precedentes: El modelo mantiene un razonamiento coherente a lo largo de 200 a 300 llamadas secuenciales a herramientas sin intervención humana, una capacidad que establece nuevos estándares para los agentes autónomos de IA y supera con creces los 30 a 50 pasos en los que se degradan la mayoría de los modelos anteriores

Arquitectura eficiente con despliegue práctico: Gracias a un diseño de mezcla de expertos con un billón de parámetros totales pero sólo 32.000 millones de activos por token, combinado con la cuantización nativa INT4, Kimi K2 Thinking ofrece un rendimiento de primera clase con una velocidad de inferencia dos veces superior y un coste de formación de sólo 4,6 millones de dólares

Cuando un modelo de inteligencia artificial totalmente abierto empieza a superar a sistemas patentados cuyo acceso cuesta millones, la gente se da cuenta. Kimi K2 Thinking, lanzado por Moonshot AI, con sede en Pekín, en noviembre de 2025, ha hecho exactamente eso. Este sistema de un billón de parámetros no solo iguala a competidores de código cerrado como GPT-5 y Claude Sonnet 4.5 en las pruebas de referencia, sino que los supera en varias áreas clave sin dejar de ser completamente gratuito y abierto para que cualquiera pueda utilizarlo

Qué hace diferente a Kimi K2 Thinking

El propio nombre nos da una pista de lo que diferencia a este modelo. Kimi K2 Thinking representa la última evolución de la serie Kimi, diseñada específicamente como un “agente pensante” en lugar de un simple chatbot conversacional. Mientras que la mayoría de los modelos de IA destacan por sus respuestas rápidas, Kimi K2 Thinking adopta un enfoque fundamentalmente diferente, razonando los problemas paso a paso e invocando dinámicamente herramientas para llevar a cabo tareas complejas

Moonshot AI construyó este modelo utilizando una arquitectura de Mezcla de Expertos que contiene un billón de parámetros totales, aunque sólo 32.000 millones están activos durante cada inferencia. Este diseño de activación dispersa permite al modelo alcanzar una escala masiva sin dejar de ser sorprendentemente eficiente en su ejecución. La arquitectura consta de 61 capas, 384 expertos (8 seleccionados por token) y admite una impresionante ventana de contexto de 256.000 tokens, el doble que muchos competidores

Lo que realmente distingue a Kimi K2 Thinking de los modelos anteriores es su metodología de entrenamiento. El equipo empleó Quantization-Aware Training durante la fase de post-entrenamiento, implementando la precisión nativa INT4 para los componentes de Mixture-of-Experts. Esta técnica ofrece una velocidad de inferencia aproximadamente dos veces mayor que la precisión estándar, manteniendo al mismo tiempo el rendimiento de referencia. Según informes que citan fuentes familiarizadas con el asunto, el entrenamiento de este modelo costó solo 4,6 millones de dólares, una fracción de lo que las grandes empresas tecnológicas suelen invertir en sistemas de vanguardia

Rendimiento récord en las pruebas de referencia

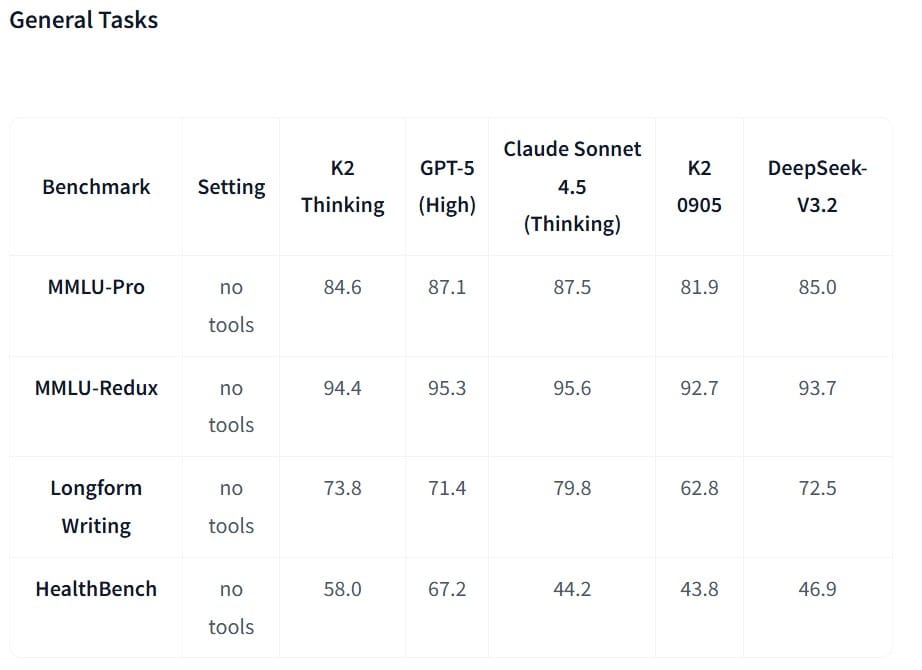

Los números cuentan una historia convincente. En Humanity’s Last Exam, una prueba muy difícil que mide la capacidad de razonamiento avanzado, Kimi K2 Thinking obtuvo un 44,9%, por encima del 41,7% de GPT-5 y significativamente por encima del 32,0% de Claude Sonnet 4.5. Esta prueba evalúa específicamente los tipos de razonamiento complejo y en varios pasos que separan a los sistemas realmente capaces de los que se limitan a emparejar patrones

Las capacidades agenticas del modelo brillan aún más en tareas que requieren el uso de herramientas y la navegación web. En BrowseComp, que mide la capacidad de los sistemas de IA para buscar y sintetizar información en Internet, Kimi K2 Thinking alcanzó un 60,2%, superando ampliamente el 54,9% de GPT-5 y más que duplicando el 24,1% de Claude Sonnet 4.5. Las pruebas independientes realizadas por Artificial Analysis confirmaron estos puntos fuertes e informaron de que Kimi K2 Thinking obtuvo una puntuación del 93% en la prueba de referencia τ²-Bench Telecom, la puntuación más alta que habían medido de forma independiente para el uso de herramientas agenticas

El rendimiento de la codificación presenta una imagen más matizada. En SWE-Bench Verified, que comprueba si los modelos pueden generar parches para corregir errores de software reales, Kimi K2 Thinking obtuvo un 71,3%. Aunque competitivo, queda por detrás del 74,9% de GPT-5 y del 77,2% de Claude en tareas de depuración a escala de repositorio. Sin embargo, en LiveCodeBench v6, que se centra en la programación competitiva y los retos algorítmicos, Kimi K2 Th inking sobresalió con un 83,1%, superando el 64,0% de Claude y acercándose al 87,0% de GPT-5

Las capacidades matemáticas demostraron ser especialmente sólidas cuando el modelo podía utilizar herramientas. En AIME 2025 con acceso a Python, Kimi K2 Thinking alcanzó el 99,6%, saturando prácticamente la prueba junto con GPT-5 y Claude. En la prueba GPQA-Diamond, que evalúa preguntas científicas de nivel universitario, Kimi K2 Thinking obtuvo un 85,7%, ligeramente por delante del 84,5% de GPT-5

La salsa secreta: Orquestación de herramientas a largo plazo

Quizá el logro técnico más impresionante de Kimi K2 Thinking sea su capacidad para ejecutar entre 200 y 300 llamadas secuenciales a herramientas sin intervención humana. La mayoría de los modelos anteriores perderían coherencia o se desviarían de la tarea después de 30 o 50 pasos, pero este sistema mantiene un comportamiento orientado a objetivos a lo largo de cientos de acciones

Esta capacidad se debe al método de entrenamiento del modelo. En lugar de tratar el uso de herramientas y el razonamiento como funciones separadas, Kimi K2 Thinking aprendió a intercalar el razonamiento en cadena con las llamadas a funciones de principio a fin. Cuando se enfrenta a un problema complejo, puede dividir la tarea en subtareas, invocar las herramientas adecuadas para cada paso, razonar sobre los resultados, ajustar su estrategia y seguir iterando hasta llegar a una solución

Una demostración compartida por Moonshot mostraba al modelo abordando un problema matemático de nivel de doctorado a través de 23 razonamientos intercalados y llamadas a herramientas. El sistema buscó de forma autónoma la información relevante, utilizó Python para realizar cálculos, razonó sobre los resultados intermedios y refinó iterativamente su enfoque sin ninguna guía humana. Este tipo de resolución de problemas sostenida y en varios pasos representa un salto cualitativo más allá de lo que pueden lograr la mayoría de los chatbots

Aplicaciones prácticas y pruebas en el mundo real

Los primeros usuarios han puesto a prueba Kimi K2 Thinking en diversos ámbitos. Un desarrollador lo integró en la plataforma Cline AI e informó de que el modelo podía tomar una solicitud de funcionalidad en lenguaje natural, dividirla en tareas de codificación, generar código para cada componente, probar la implementación y perfeccionarla de forma iterativa con una supervisión mínima. La calidad del código resultante fue siempre alta, aunque el proceso no siempre fue fluido: el desarrollador observó un desfase entre la inteligencia de alto nivel del modelo y la estabilidad de ejecución de las herramientas de bajo nivel

Para los flujos de trabajo de investigación, los usuarios han descubierto que Kimi K2 Thinking es especialmente valioso cuando se combina con otros modelos en un proceso. Uno de los enfoques consiste en utilizar Kimi K2 Thinking como front-end para realizar una recopilación exhaustiva de información -aprovechando sus capacidades de contexto largo y su resistencia de ejecución para compilar cantidades masivas de datos relevantes- y luego alimentar ese contexto a un modelo de razonamiento diferente para el análisis final. Esta estrategia híbrida aprovecha los puntos fuertes del modelo al tiempo que sortea sus limitaciones

Los usuarios académicos afirman que Kimi K2 Thinking destaca en el manejo de documentos largos y en el mantenimiento de bajas tasas de alucinación, lo que lo hace adecuado para revisiones bibliográficas y síntesis de investigaciones. La ventana contextual de 256.000 tokens significa que el modelo puede procesar trabajos de investigación, libros o bases de código enteras en una sola sesión sin perder detalles importantes

La escritura creativa representa otro punto fuerte que distingue a este modelo. Numerosos usuarios de Reddit han elogiado el estilo de escritura humano de Kimi K2 Thinking, señalando que sus resultados rara vez son marcados por las herramientas de detección de IA. Esta cualidad se debe a que el modelo se entrena en dos idiomas dominantes: inglés y chino a un nivel casi experto, con un vocabulario de 160.000 palabras que abarca varias escrituras e idiomas

Cómo acceder y utilizar Kimi K2 Thinking

Empezar a utilizar Kimi K2 Th inking requiere unos conocimientos técnicos mínimos. Los usuarios pueden acceder al modelo a través de varios canales, cada uno de ellos adaptado a diferentes necesidades. El método más sencillo consiste en visitar kimi.com, donde Moonshot ofrece una interfaz web gratuita similar a ChatGPT. Crear una cuenta lleva unos segundos, y los usuarios pueden iniciar inmediatamente conversaciones con el modelo completo

Para los desarrolladores de aplicaciones, Moonshot ofrece una API compatible con los estándares OpenAI y Anthropic, lo que facilita la integración. La estructura de precios es muy inferior a la de la competencia: a 0,15 dólares por millón de tokens de entrada y a 2,50 dólares por millón de tokens de salida, cuesta una fracción de las tarifas de 2 y 8 dólares de GPT-4. Una empresa típica que utilice 100 millones de fichas de entrada y 20 millones de fichas de salida al mes gastaría sólo 65 dólares con Kimi K2 Thinking, frente a los 360 dólares de GPT-4

Los usuarios técnicos que deseen un control total pueden descargar los pesos completos del modelo desde Hugging Face. El modelo funciona con motores de inferencia como vLLM, SGLang y KTransformers. Aunque el modelo completo pesa aproximadamente 600 GB, la cuantización INT4 lo hace manejable en hardware de consumo de gama alta. Una de las personas que lo probó informó de que se alcanzaban unos 15 tokens por segundo con dos chips M3 Ultra

Cuando se trabaja con Kimi K2 Thinking, resulta esencial comprender el flujo de trabajo de llamada de herramientas. El modelo acepta una lista de herramientas disponibles con cada solicitud y, a continuación, decide de forma autónoma cuándo y cómo invocarlas. Los desarrolladores describen la información de la llamada a la herramienta en un formato estandarizado, la envían al modelo, ejecutan las funciones solicitadas, añaden los resultados al historial de la conversación y dejan que el modelo siga razonando hasta que determine que tiene información suficiente para responder a la consulta

La ventaja de la licencia

Moonshot lanzó Kimi K2 Thinking bajo una licencia MIT modificada que elimina la mayoría de las barreras para su adopción. Esto otorga a los usuarios plenos derechos de uso comercial y trabajo derivado, permitiendo tanto a investigadores individuales como a desarrolladores empresariales integrarlo libremente en sus proyectos. La modificación sólo añade un requisito: las implantaciones que atiendan a más de 100 millones de usuarios activos mensuales o generen más de 20 millones de dólares al mes en ingresos deben mostrar “Kimi K2” en la interfaz de su producto

Para la inmensa mayoría de los casos de uso -desde la investigación académica a las aplicaciones para empresas de nueva creación, pasando por las herramientas internas de las empresas- esta cláusula de atribución nunca entra en juego. La concesión de licencias representa uno de los enfoques más permisivos vistos para un modelo de clase fronteriza, en marcado contraste con las cuotas de suscripción y los costes de API requeridos para las alternativas cerradas

Arquitectura técnica

Para entender qué hace posible Kimi K2 Thinking es necesario examinar sus innovaciones arquitectónicas. El diseño de mezcla de expertos emplea 384 expertos especializados en las capas de avance, con un mecanismo de activación que selecciona dinámicamente 8 expertos por señal de entrada. Este patrón de activación dispersa significa que, a pesar de que el modelo contiene un billón de parámetros, sólo se activan unos 32.000 millones por cada token, lo que equivale aproximadamente a activar el 3,2% de la capacidad total

El mecanismo de atención, denominado MLA (Multi-head Local Attention), permite al modelo manejar contextos de hasta 256.000 tokens. En comparación con DeepSeek R1, que comparte ADN arquitectónico con Kimi K2 Thinking, el modelo utiliza la mitad de cabezas de atención (64 frente a 128) pero aproximadamente 1,5 veces más expertos por capa MoE (384 frente a 256). El vocabulario se amplió a 160.000 palabras frente a las 129.000 de DeepSeek, lo que proporciona una mejor cobertura en varios idiomas

En el entrenamiento se empleó el optimizador MuonClip desarrollado por Moonshot, que garantiza la estabilidad cuando se entrena a una escala de 15,5 billones de tokens. La fase de post-entrenamiento incorporó Quantization-Aware Training específicamente en los componentes MoE, permitiendo a Kimi K2 Thinking funcionar de forma nativa en precisión INT4 sin la degradación de rendimiento típica de la cuantización post-hoc

En qué destaca Kimi K2 Thinking y en qué flaquea

Las pruebas en el mundo real revelan tanto sus puntos fuertes como sus limitaciones. Revisores independientes que realizaron pruebas de rendimiento no agenéticas descubrieron que, aunque Kimi K2 Thinking se comporta admirablemente en muchas tareas, tropieza en algunos problemas de razonamiento espacial y, en ocasiones, genera una sintaxis incorrecta para lenguajes específicos, como los scripts de Blender. Las preguntas de matemáticas que el rendimiento del modelo en las pruebas de referencia sugería que resolvería a veces producían errores inesperados en la práctica

La mayor fortaleza del modelo reside en las tareas de planificación, depuración y razonamiento sostenido. Varios desarrolladores afirman que Kimi K2 Thinking iguala o supera el rendimiento de GPT-5 como asistente de planificación y depuración. Para los flujos de trabajo que requieren una cuidadosa descomposición de problemas complejos en pasos manejables, seguida de una ejecución sistemática, este modelo ofrece un valor constante

Sin embargo, algunos usuarios observan incoherencias cuando el contexto total se acerca al límite de 256.000 fichas. A medida que el “banco de trabajo” del modelo se va llenando de información de pasos anteriores, el razonamiento puede volverse impredecible o detenerse inesperadamente. Esto sugiere que, aunque la arquitectura admite contextos muy largos, es posible que el entrenamiento no se haya optimizado completamente para todos los escenarios posibles de uso de herramientas de cadena larga

Implicaciones del código abierto

El lanzamiento de Kimi K2 Thinking representa algo más que otro modelo: señala un cambio estructural en el panorama de la IA. Por primera vez, un sistema de código abierto iguala o supera a los modelos patentados de frontera en puntos de referencia clave de razonamiento y agenciamiento. Esto desafía la suposición de que la IA más capaz debe permanecer encerrada tras los muros de pago de las empresas

Las empresas que antes dependían exclusivamente de API patentadas ahora pueden implantar alternativas abiertas con un razonamiento de nivel GPT-5, al tiempo que conservan el control total sobre los pesos, los datos y el cumplimiento de las normas. La transparencia permite la inspección de las trazas de razonamiento, el ajuste fino para aplicaciones específicas del dominio y la eliminación de la dependencia del proveedor. Para los investigadores académicos, el acceso a un modelo de razonamiento de un billón de parámetros sin cuotas de suscripción democratiza la participación en la investigación de la IA

La dinámica competitiva ya ha cambiado. Apenas unas semanas antes del lanzamiento de Kimi K2 Thinking, MiniMax-M2 ostentaba el título de mejor modelo de código abierto con puntuaciones impresionantes en múltiples pruebas comparativas. Kimi K2 Thinking superó decisivamente esas puntuaciones, por ejemplo, con un 60,2% en BrowseComp frente al 44,0% de M2, y un 71,3% en SWE-Bench Verified frente al 69,4% de M2. Esta rápida sucesión de modelos abiertos cada vez más capaces sugiere que la frontera se ha vuelto más colaborativa que propietaria

El futuro y lo que está por venir

La familia de modelos Kimi sigue evolucionando rápidamente. Moonshot ya ha lanzado múltiples versiones a lo largo de 2025, incluidas variantes especializadas como Kimi-VL para tareas de visión-lenguaje y Kimi-Researcher para flujos de trabajo de investigación autónoma. La empresa amplió la ventana de contexto de 128.000 tokens en el Kimi K2 original a 256.000 en versiones posteriores

De cara al futuro, varias áreas presentan oportunidades de mejora. La inestabilidad ocasional en cadenas largas de uso de herramientas sugiere la posibilidad de mejorar la formación en flujos de trabajo agénticos ampliados. Aunque el rendimiento matemático y de codificación ya alcanza altos niveles, el perfeccionamiento continuo podría cerrar las brechas restantes con los mejores sistemas propietarios en tareas de ingeniería de software a escala de repositorio

Es probable que se amplíe la integración con herramientas y API externas, haciendo que Kimi K2 Thinking sea aún más capaz como agente autónomo. La arquitectura del modelo, con su eficiente activación dispersa y cuantificación nativa, apunta hacia un futuro en el que los modelos de billones de parámetros se convertirán en algo rutinario y no excepcional

Recomendaciones prácticas para los usuarios

Las organizaciones que evalúen Kimi K2 Thinking deberían considerar una estrategia de enrutamiento híbrida. Dirija las tareas de investigación de planificación pesada, programación competitiva y codificación algorítmica a Kimi K2 Thinking, donde brillan sus puntos fuertes. Mantenga GPT-5 o Claude en el bucle para la corrección de errores a escala de repositorio, tareas de desarrollo con mucho terminal y escenarios que requieran la máxima fiabilidad de producción

Los desarrolladores individuales pueden empezar a experimentar inmediatamente a través de la interfaz web gratuita en kimi.com. Los desarrolladores de aplicaciones deberían evaluar la API, que ofrece un rendimiento de primera clase a un precio muy inferior al de la competencia. Los usuarios técnicos con el hardware adecuado pueden ejecutar el modelo localmente, obteniendo un control total y beneficiándose de la velocidad de inferencia 2x proporcionada por el soporte nativo INT4

Para obtener los mejores resultados, estructure las instrucciones con claridad y aproveche la capacidad del modelo para planificar antes de ejecutar. Considere la posibilidad de que Kimi K2 Thinking actúe primero como “arquitecto” generando un plan detallado para tareas complejas y, a continuación, como “despachador” ejecutando ese plan paso a paso. Este enfoque de pensamiento externalizado sortea cualquier limitación de razonamiento a la vez que aprovecha las excepcionales capacidades de ejecución del modelo

Definiciones

Mezcla de expertos (MDE): Enfoque arquitectónico en el que un gran modelo contiene muchas subredes especializadas de “expertos”, pero sólo se activa un pequeño subconjunto para cada entrada, lo que permite una escala masiva al tiempo que se mantiene un cálculo manejable. Kimi K2 Thinking utiliza 384 expertos con 8 seleccionados por token

Ventana de contexto: La cantidad de texto (medido en tokens) que un modelo puede procesar y recordar a la vez. Kimi K2 Thinking admite 256.000 tokens, el equivalente aproximado a un libro de 500 páginas, lo que permite analizar documentos extensos o conversaciones extensas

Quantization-Aware Training (QAT): Técnica mediante la cual un modelo aprende a mantener la precisión incluso cuando utiliza números de menor precisión (como INT4 en lugar de coma flotante estándar), lo que permite una inferencia más rápida y menores requisitos de memoria sin sacrificar la calidad del rendimiento

Llamada a herramientas/llamada a funciones: Capacidad de un modelo de IA para reconocer cuándo necesita información o capacidades externas, invocar las herramientas adecuadas (como búsquedas en Internet, calculadoras o ejecución de código) e integrar los resultados en su proceso de razonamiento

SWE-Bench: Evaluación comparativa que comprueba si los modelos de IA pueden corregir automáticamente errores de software reales analizando bases de código, comprendiendo los problemas y generando los parches adecuados, midiendo la capacidad práctica de codificación más que los conocimientos teóricos

El último examen de la humanidad (HLE): Una prueba especialmente difícil diseñada para poner a prueba las capacidades de razonamiento avanzado en problemas que requieren un pensamiento profundo de varios pasos en lugar de una simple coincidencia de patrones o recuperación de conocimientos

Inteligencia Artificial Agenética: sistemas capaces de comportarse de forma autónoma y orientada a objetivos, planificando flujos de trabajo de varios pasos, invocando herramientas según sea necesario, adaptando estrategias en función de los resultados y perseverando en tareas complejas sin la constante orientación humana

Modelo de peso abierto: Un sistema de IA en el que los parámetros entrenados (pesos) están disponibles públicamente para su descarga, lo que permite a cualquiera ejecutar, estudiar o modificar el modelo, en contraste con los modelos cerrados accesibles sólo a través de API

Preguntas más frecuentes

¿Qué es Kimi K2 Thinking y cómo funciona?

Kimi K2 Thinking es un modelo de IA de código abierto con un billón de parámetros desarrollado por Moonshot AI que funciona como un “agente pensante” capaz de razonar paso a paso problemas complejos invocando de forma autónoma herramientas externas. A diferencia de los chatbots tradicionales, que se limitan a responder a consultas, Kimi K2 Thinking puede descomponer problemas ambiguos en subtareas claras, buscar información, ejecutar código, analizar resultados e iterar a través de cientos de pasos sin intervención humana. El modelo emplea una arquitectura de Mezcla de Expertos con 384 expertos especializados, activando sólo 32.000 millones de sus billones de parámetros totales para cada inferencia, lo que hace que su ejecución sea potente y eficiente

¿Cómo se compara Kimi K2 Thinking con GPT-5 y Claude en cuanto a rendimiento en el mundo real?

Kimi K2 Thinking supera tanto a GPT-5 como a Claude Sonnet 4.5 en varias pruebas clave, especialmente en los escenarios de razonamiento ágil y uso de herramientas. En Humanity’s Last Exam, Kimi K2 Thinking obtuvo un 44,9%, frente al 41,7% de GPT-5 y el 32,0% de Claude, mientras que en BrowseComp (que mide la capacidad de búsqueda en Internet), alcanzó un 60,2%, frente al 54,9% de GPT-5 y el 24,1% de Claude. En cuanto a las tareas de programación, el panorama es más matizado: Kimi K2 Thinking destaca en programación competitiva con un 83,1% en LiveCodeBench, pero queda ligeramente por detrás de GPT-5 y Claude en tareas de corrección de errores a escala de repositorio como SWE-Bench Verified. En general, Kimi K2 Thinking demuestra sus puntos fuertes en planificación, razonamiento sostenido y realización autónoma de tareas, lo que la hace especialmente valiosa para la investigación, la codificación algorítmica y los flujos de trabajo de resolución de problemas en varios pasos

¿Es realmente gratuito el uso de Kimi K2 Thinking y cuáles son las restricciones de la licencia?

Sí, Kimi K2 Thinking es realmente libre de usar a través de múltiples métodos de acceso, incluyendo la interfaz web en kimi.com, la plataforma API en platform.moonshot.ai, y pesos descargables en Hugging Face. El modelo se publica bajo una licencia MIT modificada que proporciona plenos derechos comerciales y derivados, lo que significa que tanto particulares como empresas pueden integrarlo en sus productos sin coste alguno. La única restricción se aplica a las implantaciones extremadamente grandes: si su aplicación da servicio a más de 100 millones de usuarios activos mensuales o genera más de 20 millones de dólares al mes en ingresos, debe mostrar “Kimi K2” en la interfaz de su producto. Para la inmensa mayoría de los usuarios -incluidas empresas de nueva creación, investigadores e incluso aplicaciones empresariales importantes- este umbral no se aplica nunca, por lo que el modelo carece esencialmente de restricciones

¿Qué requisitos de hardware se necesitan para ejecutar Kimi K2 Thinking localmente?

La ejecución local de Kimi K2 Thinking requiere un hardware considerable, pero cada vez más accesible gracias a la cuantización INT4 nativa del modelo. El modelo completo pesa aproximadamente 600 GB en su forma cuantizada, lo que es significativamente menor que los modelos típicos de billones de parámetros. Un desarrollador ha informado de que se consiguen unos 15 tokens por segundo con dos chips M3 Ultra, lo que demuestra que el hardware de consumo de gama alta puede manejar la inferencia. Para un rendimiento óptimo, el modelo funciona con motores de inferencia como vLLM, SGLang y KTransformers, que pueden distribuir la carga de trabajo de forma eficiente. La mayoría de las organizaciones evalúan la conveniencia del autoalojamiento en función del volumen de uso: las que procesan menos de 10 millones de tokens al mes suelen encontrar la API más rentable, a 0,15 dólares por millón de tokens de entrada, mientras que las operaciones que superan los 100 millones de tokens mensuales se benefician del autoalojamiento a pesar de la inversión en hardware

¿Qué hace especial a la capacidad de Kimi K2 Thinking para llamar a herramientas en comparación con otros modelos de IA?

La llamada a herramientas de Kimi K2 Thinking se distingue por su capacidad para ejecutar entre 200 y 300 llamadas secuenciales a herramientas manteniendo un comportamiento coherente y orientado a objetivos en toda la cadena, lo que supera con creces los 30 o 50 pasos en los que la mayoría de los modelos anteriores empiezan a degradarse o a perder de vista los objetivos. El modelo se entrenó de principio a fin para intercalar el razonamiento de cadena de pensamiento con las llamadas a funciones, lo que significa que no se limita a invocar herramientas mecánicamente, sino que razona activamente sobre cuándo son necesarias las herramientas, qué información extraer de los resultados y cómo ajustar su estrategia en función de los resultados. Esto permite auténticos flujos de trabajo autónomos: Kimi K2 Thinking puede llevar a cabo investigaciones buscando en múltiples fuentes, sintetizando los resultados, realizando cálculos para verificar las afirmaciones, iterando cuando fallan los planteamientos iniciales y persistiendo en tareas complejas de varios pasos sin necesidad de intervención humana en cada etapa. El impacto práctico aparece en casos de uso como el desarrollo automatizado de software, la síntesis exhaustiva de investigaciones y la resolución de problemas complejos que tradicionalmente requerirían un esfuerzo humano sostenido durante varias horas o días.