Last Updated on junio 10, 2024 11:08 am by Laszlo Szabo / NowadAIs | Published on junio 10, 2024 by Laszlo Szabo / NowadAIs

Qwen 2-72B de Alibaba Cloud: la inteligencia artificial supera a los mejores modelos LLM como Llama-3-70B – Notas clave

- Qwen 2-72B es el buque insignia de los grandes modelos lingüísticos desarrollados por el equipo Qwen de Alibaba Cloud

- Presenta un rendimiento puntero en comprensión del lenguaje, capacidades multilingües, codificación, matemáticas y razonamiento

- El modelo presenta elementos arquitectónicos avanzados como la activación SwiGLU, el sesgo de atención QKV y la atención a consultas de grupo

- Qwen 2-72B se ha entrenado con una gran cantidad de datos multilingües y se ha perfeccionado mediante ajustes supervisados y optimización directa de preferencias

- Admite longitudes de contexto de hasta 128.000 tokens, lo que permite un manejo excepcional de contenidos de formato largo

- El modelo demuestra una seguridad y una responsabilidad superiores, superando a las principales alternativas en el manejo de indicaciones delicadas

Introducción

En el panorama en rápida evolución de la inteligencia artificial, la presentación de Qwen 2-72B constituye un hito monumental. Este colosal modelo lingüístico de gran tamaño, desarrollado por el visionario equipo Qwen de Alibaba Cloud, se ha revelado como un auténtico tour de force, estableciendo unos estándares asombrosamente altos de comprensión lingüística, competencia multilingüe y destreza en la resolución de tareas.

Qwen 2-72B es la culminación de una investigación meticulosa, una formación rigurosa y una búsqueda incesante de la excelencia. Con la asombrosa cifra de 72.000 millones de parámetros, este gigantesco modelo ha sido meticulosamente diseñado para sobresalir en una amplia gama de ámbitos, desde el procesamiento del lenguaje natural y la generación de código hasta el razonamiento matemático, entre otros.

Dominio multilingüe

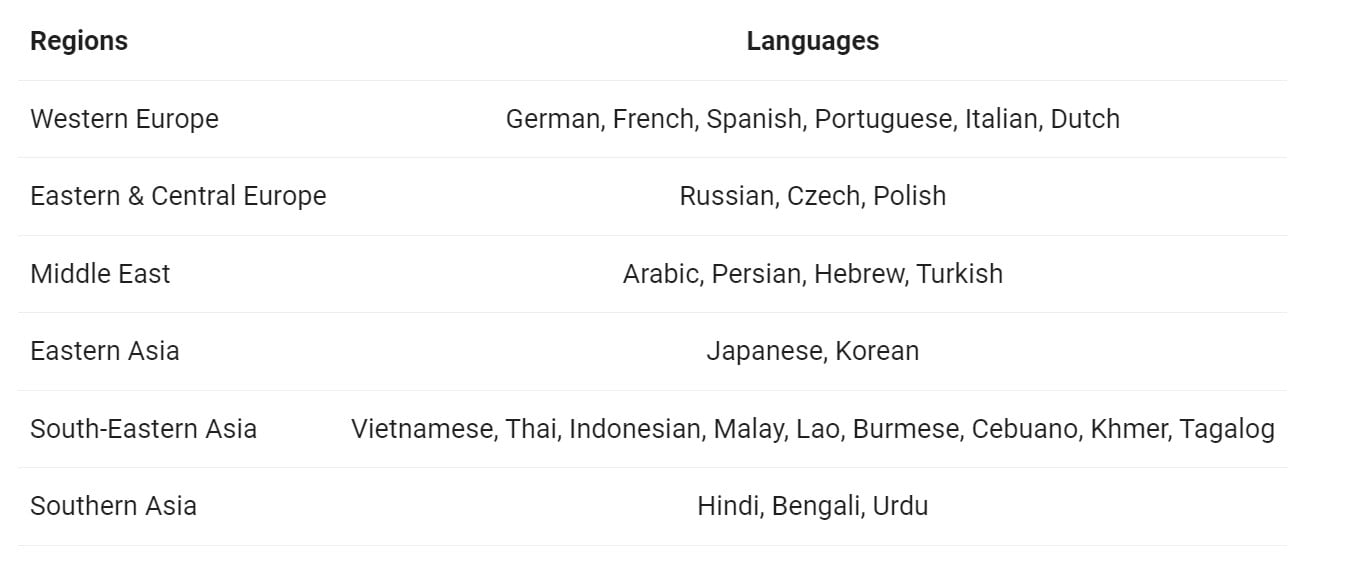

Una de las características más destacadas de Qwen 2-72B es su excepcional capacidad multilingüe. Entrenado en un amplio conjunto de datos que abarca 27 idiomas además del inglés y el chino, el modelo ha desarrollado una comprensión profunda y versátil de diversos paisajes lingüísticos. Esta versatilidad lingüística permite a Qwen 2-72B navegar sin problemas por la comunicación multilingüe, rompiendo barreras y fomentando la colaboración global.

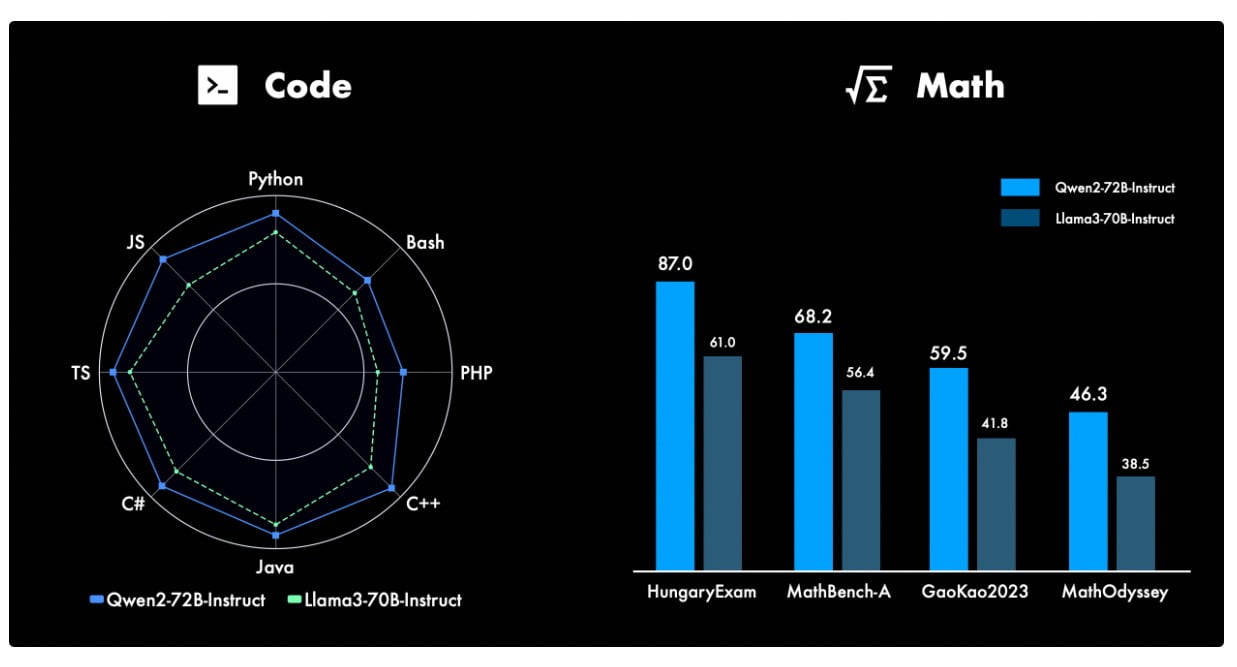

Destreza matemática y de codificación

La capacidad de Qwen 2-72B va mucho más allá del procesamiento del lenguaje natural. El modelo ha demostrado notables capacidades en los campos de la codificación y las matemáticas, estableciendo nuevos hitos en estos ámbitos tan técnicos. Gracias a un entrenamiento meticuloso y a un perfeccionamiento selectivo, el equipo de Qwen ha dotado al modelo de un profundo conocimiento de los lenguajes de programación, los algoritmos y los conceptos matemáticos, lo que le permite enfrentarse con facilidad a complejas tareas de codificación y resolver intrincados problemas matemáticos.

Dominio del contenido de formato largo

Una de las características más destacadas de Qwen 2-72B es su excepcional manejo de contenidos largos. Capaz de procesar contextos de hasta 128.000 palabras, el modelo destaca en la comprensión y generación de respuestas coherentes a entradas extensas de varios párrafos. Esta capacidad distingue a Qwen 2-72B, convirtiéndolo en un valioso activo en aplicaciones en las que la comprensión detallada y matizada de textos extensos es primordial.

Seguridad y responsabilidad

En una época en la que el desarrollo responsable de la tecnología de IA es de vital importancia, Qwen 2-72B destaca por su compromiso inquebrantable con la seguridad y las consideraciones éticas. Pruebas exhaustivas han demostrado la capacidad del modelo para navegar por mensajes y contenidos delicados, produciendo constantemente resultados que están alineados con los valores humanos y libres de elementos nocivos o poco éticos.

Qwen 2-72B en acción

La versatilidad de Qwen 2-72B es realmente impresionante, con el modelo capaz de transición sin problemas entre una amplia gama de tareas y aplicaciones. Desde la generación de lenguaje natural y la respuesta a preguntas hasta la interpretación de código y la resolución de problemas matemáticos, esta potencia de la IA ha demostrado ser un verdadero multitalento.

Implantación e integración

Qwen 2-72B se ha diseñado teniendo en cuenta la escalabilidad y la accesibilidad, lo que lo convierte en un candidato ideal para su implantación en una amplia gama de plataformas y casos de uso. La integración del modelo con los principales marcos de trabajo, como Hugging Face Transformers y ModelScope, garantiza que los desarrolladores e investigadores puedan aprovechar sin esfuerzo sus capacidades, abriendo nuevas posibilidades en sus respectivos dominios.

Evaluación comparativa y rendimiento

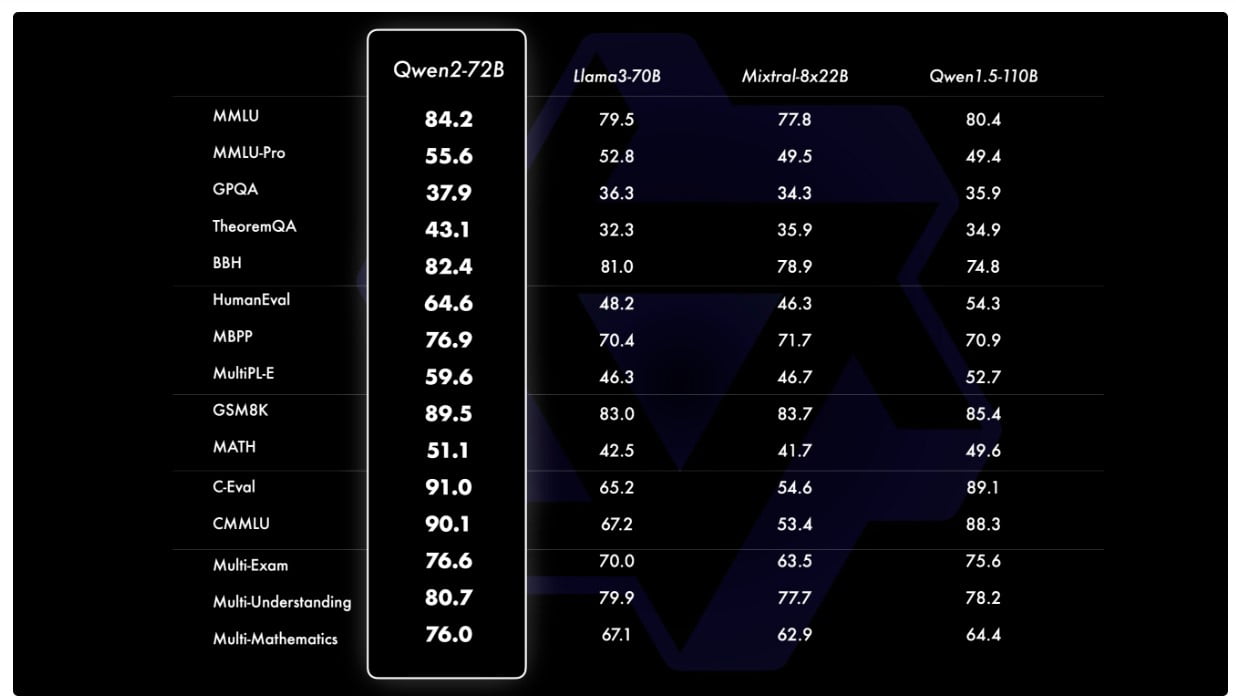

Pruebas y evaluaciones rigurosas han demostrado sistemáticamente el rendimiento superior de Qwen 2-72B en una amplia gama de puntos de referencia. En las comparaciones directas con otros modelos de última generación, como Llama-3-70B, el modelo Qwen 2-72B se ha erigido en claro vencedor, demostrando sus incomparables capacidades en áreas como la comprensión del lenguaje natural, la adquisición de conocimientos y la destreza en la resolución de tareas.

El camino por recorrer

Mientras el modelo Qwen 2-72B sigue cautivando a la comunidad de la IA, el futuro es muy prometedor. El inquebrantable compromiso del equipo de Qwen con la innovación y su incesante búsqueda de la excelencia sugieren que esto no es más que el principio de una nueva era en el desarrollo de grandes modelos lingüísticos. Con los continuos refinamientos, ampliaciones y la exploración de capacidades multimodales, Qwen 2-72B está preparado para redefinir los límites de lo que es posible en el mundo de la inteligencia artificial.

Definiciones

- Qwen 2 -72B: Un modelo lingüístico de última generación desarrollado por Alibaba Cloud con 72.000 millones de parámetros, que destaca en capacidades multilingües, codificación, matemáticas y manejo de contenidos de formato largo.

- SwiGLU: Un tipo de función de activación utilizada en redes neuronales, que mejora la capacidad del modelo para aprender patrones complejos.

- Sesgo QKV: Se refiere a los términos de sesgo en los vectores de consulta, clave y valor en los modelos transformadores, que mejoran los mecanismos de atención.

- HungaryExam: Conjunto de datos de evaluación comparativa o herramienta utilizada para evaluar el rendimiento de los modelos de IA en la comprensión del lenguaje y tareas relacionadas.

- Métricas de rendimiento MMLU: Métrica utilizada para evaluar el rendimiento de grandes modelos lingüísticos en la prueba de referencia Massive Multitask Language Understanding (MMLU).

- Modelo LLM MIxtral-8x: Otro gran modelo lingüístico que sirve como punto de comparación para evaluar las capacidades de Qwen 2-72B.

- Activación SwiGLU: Una función de activación específica utilizada en Qwen 2-72B, que contribuye a sus capacidades avanzadas de aprendizaje.

- SesgoQKV: términos de sesgo añadidos a las proyecciones de consulta, clave y valor en los mecanismos de atención para mejorar el rendimiento del modelo.

Preguntas más frecuentes

P: ¿Qué diferencia a Qwen 2-72B de otros grandes modelos lingüísticos? R: Qwen 2-72B cuenta con varios elementos diferenciadores clave, como su diseño arquitectónico de vanguardia, sus excepcionales capacidades multilingües y su rendimiento sin parangón en codificación y matemáticas. Además, la capacidad del modelo para manejar contenidos largos de hasta 128.000 tokens y su firme compromiso con la seguridad y el desarrollo responsable lo diferencian de la competencia.

P: ¿Cómo se compara el rendimiento de Qwen 2-72B con el de otros modelos líderes? R: Rigurosos análisis comparativos han demostrado sistemáticamente la superioridad de Qwen 2-72B frente a otros modelos punteros, como Llama-3-70B. El modelo Qwen 2-72B ha superado a sus homólogos en una amplia gama de evaluaciones, como la comprensión del lenguaje natural, la adquisición de conocimientos y la capacidad de resolución de tareas.

P: ¿Cuáles son las innovaciones arquitectónicas clave que permiten las impresionantes capacidades de Qwen 2-72B? R: Qwen 2-72B incorpora elementos arquitectónicos como la activación SwiGLU, el sesgo de atención QKV y la atención a consultas en grupo. Estos avances no sólo mejoran la potencia computacional bruta del modelo, sino que también le imbuyen de una comprensión matizada del lenguaje, lo que le permite abordar incluso las tareas más complejas y ambiguas con una precisión sin precedentes.

P: ¿En qué se diferencia Qwen 2-72B de los demás sistemas gracias a su capacidad multilingüe? R: Las excepcionales capacidades multilingües de Qwen 2-72B son un testimonio del compromiso del equipo de Qwen con el fomento de la colaboración global y la eliminación de las barreras lingüísticas. El modelo, que ha sido entrenado en un amplio conjunto de datos que abarca 27 idiomas además del inglés y el chino, ha desarrollado un conocimiento profundo y versátil de diversos entornos lingüísticos, lo que le permite navegar sin problemas por la comunicación multilingüe.

P: ¿Qué medidas se han tomado para garantizar la seguridad y la responsabilidad de Qwen 2-72B? R: El equipo de Qwen ha hecho especial hincapié en el desarrollo responsable de Qwen 2-72B. Pruebas exhaustivas han demostrado la capacidad del modelo para navegar por preguntas y contenidos delicados, produciendo de forma consistente resultados que están alineados con los valores humanos y libres de elementos dañinos o poco éticos. Este compromiso con la seguridad y las consideraciones éticas distingue a Qwen 2-72B como una solución de IA responsable y digna de confianza.