Todos los detalles importantes de la actualización Google Gemini 1.5

Last Updated on julio 26, 2024 11:02 am by Laszlo Szabo / NowadAIs | Published on julio 26, 2024 by Laszlo Szabo / NowadAIs Todos los detalles importantes de la actualización Google Gemini 1.5 – Notas clave Google Gemini 1.5 introduce mejoras significativas en las capacidades de IA. Ventana de contexto ampliada de 8K a 32K tokens para conversaciones más profundas. Integración con la aplicación Mensajes de Google y ampliación del acceso a la aplicación móvil. El alcance de Gemini se extiende a los adolescentes con acceso y orientación responsables. Potencia mejorada de Google Gemini 1.5 En el mundo en constante evolución de la inteligencia artificial, Gemini de Google ha estado a la vanguardia, mejorando continuamente sus capacidades para satisfacer mejor las necesidades de los usuarios. Con el reciente lanzamiento de Gemini 1.5, la plataforma ha dado un importante salto adelante, ofreciendo un conjunto de nuevas funciones y mejoras que prometen revolucionar la forma en que las personas interactúan con la IA generativa. Desde respuestas más rápidas e inteligentes hasta un acceso ampliado y un enfoque en el diseño responsable, este artículo profundiza en las actualizaciones y mejoras clave que hacen de Gemini 1. 5 un cambio de juego en el ámbito de la productividad y la creatividad impulsadas por la IA. Respuestas más rápidas e inteligentes con Gemini 1.5 Flash Una de las actualizaciones más notables de Gemini 1.5 es la introducción de la función Flash de Gemini 1 . 5, que ahora está disponible para todos los usuarios, incluso en la versión de pago. Esta actualización promete mejoras generalizadas en la calidad de respuesta y la latencia, con mejoras especialmente notables en el razonamiento y la comprensión de imágenes. El equipo de Gemini también ha cuadruplicado la ventana de contexto, aumentándola de 8K a 32K fichas. Esta ampliación permite conversaciones de ida y vuelta más largas y consultas más complejas, lo que permite a los usuarios profundizar en los temas y obtener información más completa. Para mejorar aún más la experiencia del usuario, Gemini 1.5 pronto introducirá la posibilidad de cargar archivos directamente desde Google Drive o desde el dispositivo del usuario. Esta función permitirá a los usuarios aprovechar las capacidades de Gemini para tareas como la creación de preguntas de práctica basadas en guías de estudio o el análisis de archivos de datos para descubrir información valiosa. Abordar las alucinaciones y proporcionar contenido relacionado Además de las mejoras de rendimiento, Gemini 1.5 también introduce nuevas funciones destinadas a abordar el problema de las alucinaciones, es decir, los casos en los que la IA genera información inexacta o inventada. En primer lugar, Gemini muestra ahora enlaces a contenidos relacionados en sus respuestas a las preguntas de búsqueda de datos. Esto permite a los usuarios explorar fácilmente sitios web y recursos que pueden proporcionar información más detallada sobre los temas tratados en las respuestas de la IA. Esta función está disponible actualmente para las preguntas en inglés en determinados países, y está previsto ampliarla a más regiones e idiomas. Además, la función de “doble comprobación” de Gemini se ha mejorado para verificar las respuestas utilizando la búsqueda de Google para resaltar las afirmaciones que se corroboran o contradicen en la web. Esto permite a los usuarios profundizar y verificar de forma independiente la información proporcionada por la IA, fomentando una interacción más transparente y fiable. Ampliación del alcance de Gemini: Mensajes de Google y la aplicación móvil La integración de Gemini con el ecosistema de Google sigue creciendo, con la IA ahora disponible dentro de la aplicación Mensajes de Google en determinados dispositivos Android. Esta característica permite a los usuarios chatear con Gemini directamente desde la aplicación de mensajería, lo que les permite aprovechar sin problemas las capacidades de la IA para tareas tales como la lluvia de ideas, la planificación de viajes, y mucho más, sin salir de la interfaz familiar de Mensajes de Google. Además, la aplicación móvil Gemini se está extendiendo a más países, proporcionando a los usuarios de todo el mundo la comodidad de acceder a la asistencia de la IA sobre la marcha. Esta expansión garantiza que el poder de Gemini esté disponible para un público más amplio, permitiendo a las personas ser más productivas, creativas y curiosas, independientemente de su ubicación. Gemini para adolescentes: Acceso responsable y orientación Reconociendo la importancia de preparar a la próxima generación para un futuro en el que la IA desempeñará un papel cada vez más importante, Google está ampliando el acceso de Gemini a los adolescentes de todo el mundo, en más de 40 idiomas. Esta iniciativa tiene como objetivo crear oportunidades para que los adolescentes se beneficien de las capacidades de la IA generativa, al tiempo que se prioriza la seguridad y se satisfacen sus necesidades de desarrollo. Para garantizar una experiencia responsable y guiada, el equipo de Gemini ha implementado políticas y salvaguardas adicionales, ha introducido un proceso de incorporación específico para adolescentes y ha incluido una guía de alfabetización en IA para ayudar a los adolescentes a utilizar la tecnología de forma responsable. Además, la empresa se ha asociado con expertos en seguridad y desarrollo infantil para garantizar que se tienen en cuenta las necesidades específicas de los adolescentes y sus familias. Diseño responsable: Principios rectores de Gemini El desarrollo de Gemini siempre ha estado guiado por un compromiso con la responsabilidad y la seguridad de los usuarios. A medida que la plataforma sigue evolucionando, Google comparte más información sobre su enfoque de Gemini, incluidos detalles sobre las directrices políticas que rigen las respuestas de la IA. Estas directrices, basadas en los Principios de Inteligencia Artificial de Google, reflejan el compromiso continuo de la empresa con el desarrollo de Gemini de forma responsable y transparente. Abordan temas complejos y delicados, como las respuestas a cuestiones relacionadas con el interés público, la política, la religión o las creencias morales, garantizando que los resultados de la IA se ajusten a los principios de una IA ética y fiable. Nuevas posibilidades con Gemini 1.5 Las últimas

Proyecto Strawberry de OpenAI: La búsqueda secreta del razonamiento humano en la IA

Last Updated on julio 17, 2024 11:44 am by Laszlo Szabo / NowadAIs | Published on julio 17, 2024 by Laszlo Szabo / NowadAIs Proyecto Strawberry de OpenAI: La búsqueda secreta del razonamiento humano en la IA – Notas clave OpenAI está desarrollando el “Proyecto Strawberry” para mejorar el razonamiento y la autonomía de la IA. El Proyecto Strawberry pretende reducir las alucinaciones en los resultados de la IA permitiendo a los modelos recopilar y sintetizar información de forma autónoma. Inspirado en el razonador autodidacta (STaR) de Stanford, Strawberry permite a la IA crear iterativamente sus propios datos de entrenamiento. Elon Musk ha expresado su preocupación por los riesgos potenciales de los modelos de IA con capacidades de razonamiento de nivel humano. El proyecto Strawberry forma parte de un esfuerzo más amplio de OpenAI por lograr la Inteligencia Artificial General (AGI). La hoja de ruta de la AGI de OpenAI incluye cinco etapas, y Strawberry representa la etapa de los “razonadores”. Las consideraciones éticas y las prácticas de desarrollo responsables son cruciales a medida que avanzan las capacidades de la IA. El razonamiento humano en el punto de mira Los rápidos avances de la inteligencia artificial (IA) han cautivado al mundo, con avances como ChatGPT y DALL-E, que muestran las asombrosas capacidades de los grandes modelos lingüísticos (LLM). Sin embargo, por muy impresionantes que sean estos modelos, siguen quedándose cortos cuando se trata de razonamiento autónomo y resolución de problemas similares a la inteligencia humana. Aquí es donde OpenAI, la renombrada empresa de investigación en IA, está dando pasos importantes con su secreto “Proyecto Strawberry”. El surgimiento del Proyecto Strawberry Fragaria × ananassa – nombre de fantasía de la IA de razonamiento secreto de OpenAI – Fuente de la imagen: Nowadais Anteriormente conocido como “Q*” o “Q Star”, el Proyecto Strawberry se ha estado gestando silenciosamente entre las paredes de OpenAI, atrayendo la atención de los conocedores de la industria y del público por igual. Informes filtrados de Bloomberg y Reuters han arrojado luz sobre este ambicioso proyecto, cuyo objetivo es ampliar los límites del razonamiento y la autonomía de la IA. Mejora de las capacidades de razonamiento En el corazón del Proyecto Strawberry está el objetivo de dotar a los modelos de IA de capacidades de razonamiento mejoradas. A diferencia de los LLM actuales, que dependen en gran medida del reconocimiento de patrones y la predicción del lenguaje, los modelos impulsados por Strawberry estarán diseñados para planificar con antelación, navegar por Internet de forma autónoma y llevar a cabo una “investigación profunda” para recopilar información y mejorar su toma de decisiones con el tiempo. Similitudes con el razonador autodidacta (STaR) Según fuentes familiarizadas con el proyecto, Strawberry comparte similitudes con la técnica Self-Taught Reasoner (STaR) desarrollada en Stanford en 2022. STaR permite a un modelo crear iterativamente sus propios datos de entrenamiento, aprendiendo y mejorando eficazmente sus capacidades de razonamiento a través de la exploración y el descubrimiento autodirigidos. Afrontar las alucinaciones Uno de los principales retos que pretende abordar Strawberry es el problema de las alucinaciones, es decir, la tendencia de los LLM a generar información incorrecta o sin sentido cuando se les presentan temas sobre los que no han recibido la formación adecuada. Al permitir que los modelos recojan y sinteticen información de Internet de forma autónoma, la IA de Strawberry podría reducir la probabilidad de que se produzcan alucinaciones, proporcionando resultados más fiables y fidedignos. Hacia la realización autónoma de tareas Las ambiciones de Strawberry van más allá del mero razonamiento. Según documentos internos revisados por Reuters, OpenAI también está explorando formas de permitir que los modelos impulsados por Strawberry realicen tareas complejas de varios pasos durante un largo periodo de tiempo, de forma similar a cómo los humanos abordan la resolución de problemas. Automatización del desarrollo y la investigación de software Esto podría tener implicaciones de gran alcance, ya que permitiría a los modelos de IA automatizar tareas reservadas normalmente a expertos humanos, como el desarrollo de software, la investigación científica e incluso el trabajo de los ingenieros. Al combinar el razonamiento avanzado con la capacidad de navegar por Internet de forma autónoma y recopilar información relevante, la IA impulsada por Strawberry podría cambiar la forma en que abordamos tareas complejas que requieren muchos conocimientos. Preocupaciones y advertencias Como ocurre con cualquier avance tecnológico significativo, el proyecto Strawberry no ha estado exento de preocupaciones y advertencias. Elon Musk, cofundador de OpenAI, ya ha dado la voz de alarma sobre los riesgos potenciales del trabajo de la empresa en modelos de IA con capacidad de razonamiento humano. Advertencias de Elon Musk Elon Musk, que rompió lazos con OpenAI en 2018, argumentó en una demanda que el modelo GPT-4 de la compañía ya constituye una forma de inteligencia general artificial (AGI) y “representa una grave amenaza para la humanidad” La demanda también afirmaba que el anterior proyecto “Q*” de OpenAI, precursor de Strawberry, tenía una pretensión aún más fuerte de AGI, alimentando aún más las preocupaciones de Musk. La destitución de Altman y el papel de la seguridad de la IA Según Reuters, algunos empleados de OpenAI se hicieron eco de las advertencias de Musk y empezaron a preocuparse cada vez más por los avances presentados por el proyecto Q*. Al parecer, este malestar interno influyó en la breve destitución de Sam Altman como consejero delegado de OpenAI en noviembre, antes de que fuera restituido poco después. El camino hacia la Inteligencia Artificial General (AGI) Aunque los detalles del Proyecto Strawberry permanecen en gran medida en secreto, los esfuerzos de OpenAI por desarrollar capacidades avanzadas de razonamiento en IA forman parte, sin duda, de un impulso más amplio hacia el santo grial de la investigación en IA: la inteligencia general artificial(AGI). La hoja de ruta de la AGI de OpenAI en cinco niveles Recientes reuniones internas de OpenAI han arrojado luz sobre la ambiciosa hoja de ruta de la empresa para alcanzar la AGI. Según un informe de Bloomberg, OpenAI ha desvelado un sistema de cinco

Elon Musk planea construir JARVIS: Grok 2 y Grok 3 de xAI por delante

Last Updated on julio 11, 2024 1:04 pm by Laszlo Szabo / NowadAIs | Published on julio 11, 2024 by Laszlo Szabo / NowadAIs Elon Musk planea construir JARVIS: Grok 2 y Grok 3 de xAI por delante – Notas clave Grok 2 saldrá a la venta en agosto; Grok 3 se espera para finales de año. Desarrollado por xAI, dirigida por Elon Musk. Se ha entrenado con 24.000 GPU Nvidia H100 y, en el futuro, con 100.000 GPU H100. Su objetivo es sobresalir en las métricas de rendimiento MATH y HumanEval. Colaboración con Nvidia, Dell Technologies y Oracle para el soporte de la infraestructura. Requiere una potencia de cálculo considerable, ya que cada sistema de 100.000 GPU H100 consume 70 megavatios de electricidad. Avance hacia la consecución de la Inteligencia General Artificial (AGI) en un plazo de 1 a 2 años. grok 2 de xAI: en el camino hacia la AGI Según un reciente post de Elon Musk en X (antes conocido como Twitter), su empresa xAI se prepara para importantes lanzamientos. Musk mencionó que Grok 2 saldrá a la venta en agosto y que Grok 3 lo hará a finales de año. Se dice que estas nuevas versiones ofrecerán capacidades avanzadas de inteligencia artificial, basándose en el éxito de Grok AI 1.5, que mostró avances impresionantes en la comprensión de contextos más largos y el razonamiento avanzado. xAI contrató 24k H100 de Oracle y Grok 2 se entrenó con ellos. Grok 2 está en fase de ajuste y corrección de errores. Probablemente estará listo el mes que viene. xAI está construyendo el sistema H100 de 100.000 para completarlo lo antes posible. El objetivo es comenzar la formación a finales de este mes … – Elon Musk (@elonmusk) 9 de julio de 2024 Musk resaltó la importancia de realizar un gran esfuerzo en la limpieza de vastos conjuntos de datos para modelos lingüísticos, un aspecto crucial para el éxito del entrenamiento de la IA. Reconoció los defectos de los actuales conjuntos de datos proporcionados por OpenAI y garantizó que Grok 2 mejoraría significativamente este aspecto. Comprender las capacidades de Grok 2 y las ambiciones de Grok 3 Al parecer, Grok 2 está influenciado por personajes de ficción populares como JARVIS, de “Iron Man “, y “Laguía del autoestopista galáctico“. Su objetivo es ofrecer soluciones inmediatas a diversas preguntas e incorporar funciones avanzadas como la producción de imágenes y la recuperación de resultados de búsquedas en Internet para mejorar sus respuestas. Además, Grok 2 está diseñado para sobresalir en evaluaciones de rendimiento como MATH y HumanEval, que evalúa la capacidad multilingüe de los modelos generadores de código, lo que indica su potencial para superar los estándares actuales de IA. Grok 3 a final de año tras entrenarse en 100k H100s debería ser realmente algo e special – Elon Musk (@elonmusk) 1 de julio de 2024 A finales de año, Grok 3 recibirá entrenamiento utilizando 100.000 GPU Nvidia H100, con el objetivo de lograr avances que puedan superar los estándares actuales de IA. Musk declaró que el entrenamiento para Grok 2 utilizó unas 20.000 GPU Nvidia H100, pero el próximo entrenamiento para Grok 3 requerirá recursos aún mayores. Esfuerzos de colaboración y obstáculos Michael Dell, CEO de Dell Technologies, reveló que la empresa está colaborando con Nvidia para establecer una fábrica de IA que mejorará las capacidades de IA generativa de xAI. Esta asociación es crucial para garantizar que xAI tenga acceso a la potencia computacional necesaria para entrenar sus complejos modelos. Según Larry Ellison, fundador de Oracle, existe una gran necesidad de GPU Nvidia en el campo de la xAI. Oracle ha desempeñado un papel fundamental a la hora de facilitar la infraestructura necesaria para las primeras versiones de Grok. Sin embargo, la importante demanda de GPU pone de manifiesto las dificultades que plantea la expansión de las tecnologías de IA. El camino hacia la inteligencia general artificial (AGI) Según Musk, el progreso de la IA se está viendo obstaculizado por grandes retos, en particular la falta de procesadores avanzados como el H100 de Nvidia y la creciente demanda de electricidad. Los modelos Grok exigen una gran potencia de cálculo, con aproximadamente 100.000 GPUs Nvidia H100 que consumen 70 megavatios de electricidad, lo que equivale al consumo energético de una pequeña ciudad. A pesar de las dificultades, se prevé que los avances en las arquitecturas de computación y memoria permitan entrenar modelos lingüísticos de mayor tamaño. Durante la GTC 2024, Nvidia presentó la Blackwell B200, una arquitectura de GPU diseñada específicamente para manejar modelos con billones de parámetros, que desempeñará un papel fundamental en el avance de la AGI. En una entrevista concedida a X Spaces, Musk expresó sus esperanzas en la consecución de la AGI y pronosticó que podría incluso superar a la inteligencia humana en uno o dos años. Afirmó, “Si defines AGI (inteligencia general artificial) como más inteligente que el humano más inteligente, creo que probablemente sea el año que viene, dentro de dos años” Perspectivas de futuro Los rápidos avances en el campo de la IA, encabezados por la xAI y la creación de modelos Grok, demuestran un progreso significativo. Sin embargo, también revelan los considerables obstáculos logísticos y de recursos que entraña la formación e implantación de estos modelos avanzados. La cooperación entre empresas como Dell, Nvidia y Oracle desempeñará un papel vital en la superación de estos retos. El avance de la xAI está ampliando constantemente las limitaciones de la tecnología de IA, lo que conlleva importantes implicaciones para diferentes industrias. Con su capacidad para mejorar el análisis de datos y permitir la toma de decisiones en tiempo real, los usos potenciales de Grok 2 y Grok 3 tienen el potencial de transformar sectores y redefinir el futuro de la IA. Definiciones grok 2 de xAI: Es un modelo avanzado de IA desarrollado por xAI, diseñado para ofrecer soluciones inmediatas, generar imágenes y realizar búsquedas en la web para mejorar las respuestas. X (antes Twitter): Una plataforma de medios sociales rebautizada como X,

LivePortrait: De imágenes estáticas a animaciones dinámicas de retratos con IA

Last Updated on julio 10, 2024 11:07 am by Laszlo Szabo / NowadAIs | Published on julio 10, 2024 by Laszlo Szabo / NowadAIs LivePortrait: De imágenes estáticas a animaciones dinámicas de retratos con IA – Notas clave LivePortrait es un marco de animación de retratos basado en IA. Desarrollado por Kuaishou Technology, la Universidad de Ciencia y Tecnología de China y la Universidad de Fudan. Utiliza un marco basado en puntos clave implícitos para mayor eficacia y control. Es capaz de generar animaciones a 12,8 milisegundos por fotograma en una GPU RTX 4090. Se ha entrenado con 69 millones de fotogramas de alta calidad para mejorar la generalización. Incorpora módulos de stitching y retargeting para mejorar el control. Puede animar tanto retratos de animales como de personas. Se centra en consideraciones éticas para evitar el uso indebido en falsificaciones profundas. LivePortrait está disponible – Introducción La animación de retratos ha sido durante mucho tiempo un campo cautivador y desafiante dentro del ámbito de la creación de contenidos digitales. Tradicionalmente, animar una imagen estática para darle vida requería minuciosos esfuerzos manuales, un software complejo y una importante inversión de tiempo. Sin embargo, los recientes avances en inteligencia artificial (IA ) han hecho que esto sea mucho más fácil, controlable y con soluciones de animación de retratos de alta calidad. LivePortrait es un nuevo marco de animación de retratos basado en IA desarrollado por un equipo de investigadores de Kuaishou Technology, la Universidad de Ciencia y Tecnología de China y la Universidad de Fudan. Esta innovadora herramienta aprovecha el poder de la IA para transformar retratos estáticos en imágenes dinámicas y realistas, ofreciendo una solución transformadora para creadores de contenidos, artistas digitales y diversas aplicaciones prácticas. Marco basado en puntos clave implícitos: Equilibrio entre eficacia y controlabilidad El enfoque de LivePortrait se basa en un marco basado en puntos clave implícitos, que se aleja de los métodos convencionales basados en la difusión. Esta elección estratégica permite al modelo alcanzar un delicado equilibrio entre eficiencia computacional y capacidad de control granular, lo que lo convierte en una solución práctica y versátil para escenarios del mundo real. A diferencia de las técnicas tradicionales basadas en la difusión, que pueden ser muy complejas desde el punto de vista computacional, el marco de trabajo basado en puntos clave implícitos de LivePortrait garantiza velocidades de generación rápidas, ya que el modelo es capaz de producir animaciones a una impresionante velocidad de 12,8 milisegundos por fotograma en una GPU RTX 4090. Esta eficiencia es un factor crucial, sobre todo en aplicaciones en las que el rendimiento en tiempo real es primordial, como las videoconferencias, las redes sociales y el entretenimiento interactivo. Mejora de la generalización y la calidad de generación https://www.nowadais.com/wp-content/uploads/2024/07/LivePortrait-Portrait-Animation-with-AI-sample-video.mp4 Para reforzar aún más las capacidades de LivePortrait, los investigadores han implementado varias mejoras clave, empezando por la ampliación del conjunto de datos de entrenamiento. Al ampliar los datos de entrenamiento a la asombrosa cifra de 69 millones de fotogramas de alta calidad, la capacidad de generalización del modelo ha mejorado significativamente, lo que le permite manejar una amplia gama de estilos y escenarios de retrato con precisión y realismo constantes: “En concreto, primero mejoramos un potente método basado en puntos clave implícitos [5], ampliando los datos de entrenamiento a unos 69 millones de imágenes de retratos de alta calidad, introduciendo una estrategia de entrenamiento mixta de imagen y vídeo, mejorando la arquitectura de la red, utilizando la transformación de movimiento escalable, diseñando la optimización de puntos clave implícitos guiada por puntos de referencia y varios términos de pérdida en cascada” afirman en su artículo. Como complemento a este enfoque basado en datos, el equipo también ha adoptado una estrategia de entrenamiento mixta de imagen y vídeo, que permite al modelo aprender tanto de imágenes estáticas como de fotogramas de vídeo dinámicos. Este proceso de aprendizaje híbrido ha dado lugar a animaciones más naturales y fluidas, que combinan a la perfección el aspecto estático del retrato original con el movimiento expresivo derivado de los datos de conducción. Arquitectura de red mejorada y puntos clave implícitos compactos Junto con el amplio conjunto de datos de entrenamiento y la estrategia de aprendizaje mixto, el marco LivePortrait también ha sido objeto de mejoras arquitectónicas para soportar transformaciones de movimiento y objetivos de optimización más complejos. Estas mejoras han contribuido a la mejora general de la calidad de la animación, garantizando que los resultados generados no sólo sean eficientes, sino también visualmente convincentes. Además, los investigadores han descubierto que los puntos clave implícitos compactos pueden representar eficazmente un tipo de blendshapes, un elemento crucial en la animación facial. Al utilizar esta eficiente representación, LivePortrait es capaz de mantener unos resultados de animación de alta calidad al tiempo que minimiza la sobrecarga computacional, un factor crucial en las aplicaciones en tiempo real. Módulos Stitching y Retargeting: Mayor capacidad de control Una de las características más destacadas de LivePortrait son sus módulos de stitching y retargeting meticulosamente diseñados, que elevan el nivel de control y personalización a disposición de los usuarios. Estos módulos, impulsados por pequeñas redes MLP (Multi-Layer Perceptron), introducen una carga computacional insignificante al tiempo que permiten un control preciso del proceso de animación. El módulo de unión permite integrar sin fisuras los rostros animados en las imágenes originales, lo que posibilita la animación de retratos de cuerpo entero y múltiples rostros en un solo fotograma. Esta capacidad es especialmente valiosa para aplicaciones en las que es esencial mantener la integridad de la composición de la imagen original. Como complemento a la función de unión, los módulos de retargeting proporcionan un control preciso de rasgos faciales específicos, como los movimientos de los ojos y los labios. Ahora los usuarios pueden ajustar con precisión el grado de apertura de los ojos y los labios, lo que abre un nuevo nivel de expresividad y control creativo en el proceso de animación de retratos. Generalización a los retratos de animales: Ampliación de las posibilidades creativas La versatilidad de LivePortrait se extiende más

El modelo Llama 3 405B ya está disponible para que lo elijan los usuarios de WhatsApp Beta

Last Updated on julio 1, 2024 1:03 pm by Laszlo Szabo / NowadAIs | Published on julio 1, 2024 by Laszlo Szabo / NowadAIs El modelo Llama 3 405B ya está disponible para que lo elijan los usuarios de WhatsApp Beta – Notas clave WhatsApp Beta para Android incluye Meta AI con los modelos Llama 3. Los usuarios pueden seleccionar entre los modelos Llama 3-70B y Llama 3-405B. El acceso a Llama 3-405B está limitado a un número restringido de solicitudes semanales. Nuevas funciones de IA diseñadas para gestionar consultas intrincadas con eficacia. La versión 2.24.14.7 de Android incluye el modelo Meta AI Llama 3 405B Según el post de WABetaInfo, las últimas características de WhatsApp beta para Android versión 2.24.14.7 incluyen la integración de Meta AI. Esta actualización permite a los usuarios elegir entre varios modelos de Llama para alimentar el chatbot Meta AI. En concreto, los usuarios pueden elegir entre el modelo Llama 3-70B, que está diseñado para indicaciones más rápidas y sencillas, y el modelo Llama 3-405B, que es más avanzado y adecuado para manejar consultas complejas (Fuente: WABetaInfo) El modelo 3-405B de Llama se encuentra actualmente en fase de formación y aún no se ha lanzado completamente para su uso público. A pesar de ello, se prevé que posea un mayor nivel de capacidad en comparación con el modelo 70B y sólo será accesible para un número restringido de solicitudes cada semana. Una vez alcanzado el límite, los usuarios volverán al modelo 70B por defecto. Planes de Meta La estrategia de Meta en materia de inteligencia artificial consiste en poner los modelos a disposición de un público más amplio de usuarios y desarrolladores mediante el código abierto. Recientemente, la empresa ha puesto a disposición del público los modelos de parámetros 8B y 70B de Llama 3, que han demostrado ser muy eficaces en diferentes pruebas comparativas. Se prevé que la publicación del modelo 405B mejore aún más las capacidades de Meta AI, igualando potencialmente el rendimiento de modelos de código cerrado como GPT-4. La incorporación de Meta AI en WhatsApp está diseñada para mejorar la experiencia del usuario ofreciendo un mayor control sobre las conversaciones dirigidas por IA. Dependiendo del nivel de dificultad de sus consultas, los usuarios tienen la opción de seleccionar el modelo más adecuado. Se prevé que esta adaptabilidad mejore el rendimiento general de Meta AI. En resumen, la beta de WhatsApp para Android ha recibido una actualización sustancial con la introducción del modelo Meta AI 405B Llama. Este nuevo modelo ofrece funciones avanzadas de IA para gestionar consultas complejas y, aunque todavía se está entrenando, se prevé que mejore en gran medida la experiencia del usuario y las interacciones con la IA. Preguntas más frecuentes 1. ¿Qué es el modelo Llama 3 405B disponible en WhatsApp Beta? Llama 3 405B es un modelo avanzado de IA integrado en WhatsApp Beta para Android. Ofrece capacidades mejoradas para manejar consultas complejas, haciendo que las conversaciones impulsadas por IA sean más eficientes y precisas. 2. ¿Cómo puedo acceder al modelo Llama 3 405B en WhatsApp Beta? Para acceder al modelo Llama 3 405B, debes ser usuario de WhatsApp Beta. Ve a los ajustes y selecciona el chatbot Meta AI, donde podrás elegir entre los modelos Llama 3-70B y Llama 3-405B en función de tus necesidades de consulta. 3. ¿Cuáles son las limitaciones de uso del modelo Llama 3 405B? Actualmente, el modelo Llama 3 405B se encuentra en fase de formación y está disponible para un número limitado de consultas cada semana. Una vez alcanzado el límite, los usuarios serán redirigidos al modelo Llama 3-70B por defecto. 4. ¿Cómo mejora el modelo Llama 3 405B las interacciones de la IA en WhatsApp? El modelo Llama 3 405B está diseñado para gestionar consultas más intrincadas y complejas en comparación con el Llama 3-70B. Esto hace que las interacciones de IA en WhatsApp respondan mejor y se adapten mejor a las necesidades del usuario, mejorando la experiencia general del usuario. 5. ¿Cuál es la estrategia de Meta para el modelo Llama 3 405B en el futuro? Meta tiene previsto seguir entrenando y perfeccionando el modelo Llama 3 405B. El objetivo es que sea de código abierto, similar a otros modelos Llama, y potencialmente igualar el rendimiento de los principales modelos de IA como GPT-4. source

L4GM de Nvidia: objetos animados a partir de vídeo en segundos

Last Updated on junio 27, 2024 11:00 am by Laszlo Szabo / NowadAIs | Published on junio 27, 2024 by Laszlo Szabo / NowadAIs L4GM de Nvidia: Objetos animados a partir de vídeo en segundos – Notas clave L4GM de Nvidia son las siglas de Large 4D Gaussian Reconstruction Model. Integra la reconstrucción 3D con el modelado 4D para obtener contenidos digitales dinámicos. Genera activos animados en 4D a partir de vídeos de una sola vista en cuestión de segundos. Utiliza un amplio conjunto de datos llamado Objaverse para el entrenamiento. Posibles aplicaciones en entretenimiento, ingeniería, realidad virtual, realidad aumentada y robótica. Desarrollado por Nvidia, la Universidad de Toronto y otras instituciones. Se centra en la dinámica temporal de alta calidad y sin fisuras en modelos 4D. Sistema L4GM de Nvidia: reconstrucción 3D en segundos El mundo de los gráficos y la visión por ordenador está en plena efervescencia con la llegada de una tecnología revolucionaria: el modelo de reconstrucción gaussiana en 4D de Nvidia, o L4GM. Este nuevo sistema promete transformar la forma en que creamos e interactuamos con contenidos digitales dinámicos y tridimensionales, dando paso a una nueva era de experiencias inmersivas. En el corazón de L4GM se encuentra un novedoso enfoque que combina a la perfección los avances en la reconstrucción 3D a gran escala con la dinámica temporal del modelado en 4D. Aprovechando un conjunto de datos de objetos animados multivista de alta calidad, los investigadores de L4GM han desarrollado un modelo capaz de generar activos 3D animados a partir de un vídeo de una sola vista, todo ello en cuestión de segundos. En este artículo, nos adentraremos en los entresijos técnicos de L4GM, exploraremos sus capacidades y descubriremos el impacto potencial que puede tener en sectores que van desde el entretenimiento a la ingeniería. Prepárate para asombrarte mientras desentrañamos los secretos de esta tecnología de inteligencia artificial La aparición de L4GM https://www.nowadais.com/wp-content/uploads/2024/06/Sample-of-L4GM-Large-4D-Gaussian-Reconstruction-Model-a-robot.mp4 El mundo de la visión y los gráficos por ordenador lleva mucho tiempo enfrentándose al reto de capturar y recrear con precisión la naturaleza dinámica de nuestro universo tridimensional. A menudo, los métodos tradicionales se han quedado cortos y han requerido laboriosos modelados manuales o complejos procesos de procesamiento de vídeo que consumen muchos recursos. Nvidia presenta L4GM, una nueva solución que pretende cambiar el panorama de la generación de contenidos en 4D. Desarrollado por un equipo de prestigiosos investigadores de Nvidia, la Universidad de Toronto y otras prestigiosas instituciones, L4GM aprovecha la potencia de los modelos de reconstrucción 3D a gran escala para resolver este antiguo problema. El núcleo de L4GM es el reconocimiento de que la clave para liberar el potencial de la 4D reside en la integración perfecta de la geometría 3D estática y la información temporal dinámica. Basándose en el éxito del Large Gaussian Model (LGM) de Nvidia, un sistema de reconstrucción 3D de última generación, el equipo de L4GM ha desarrollado un novedoso enfoque que amplía estas capacidades a la cuarta dimensión. La arquitectura L4GM: Unificación de 3D y 4D La arquitectura L4GM es una mezcla magistral de técnicas de vanguardia que se inspira en los últimos avances en reconstrucción 3D, dinámica temporal y modelado generativo. Profundicemos en los componentes clave que hacen que este sistema sea tan innovador: base de reconstrucción 3D En el núcleo de L4GM se encuentra el LGM, el gran modelo de reconstrucción 3D preentrenado de Nvidia. Este potente sistema es capaz de generar elipsoides gaussianos 3D de alta calidad a partir de imágenes multivista, sentando las bases de la capacidad de L4GM para capturar la geometría estática de objetos y escenas. dinámica temporal 4D Para introducir la dimensión temporal, el equipo de L4GM ha incorporado una serie de capas de autoatención temporal a la arquitectura básica de LGM. Estas capas permiten al modelo aprender consistencia y coherencia a lo largo del tiempo, garantizando que el contenido 4D generado muestre un movimiento suave y natural. Representación de Splatting gaussiano L4GM representa el contenido 4D utilizando un enfoque de Splatting Gaussiano 3D por fotograma. Esta eficaz representación permite al modelo captar los detalles espaciales y temporales de los objetos animados, al tiempo que posibilita un proceso de muestreo ascendente a alta velocidad para lograr la suavidad temporal. Pérdida de renderizado multivista Para mejorar aún más la calidad y la coherencia del resultado 4D, el proceso de entrenamiento de L4GM utiliza una pérdida de renderización multivista por paso de tiempo. Esta función de pérdida garantiza que las representaciones gaussianas generadas capturen fielmente la apariencia del objeto desde múltiples puntos de vista, dando como resultado una reconstrucción 4D más realista y cohesiva. modelo de interpolación 4D La última pieza del rompecabezas de L4GM es un modelo de interpolación que toma las representaciones gaussianas de baja frecuencia de cuadro y las amplía a una frecuencia de cuadro superior. Este paso introduce un suavizado temporal adicional, produciendo los activos 3D animados finales de alta calidad. El conjunto de datos L4GM: Impulsar la innovación El éxito de L4GM puede atribuirse en gran medida al novedoso conjunto de datos de objetos animados multivista que han creado los investigadores. Denominada “Objaverse”, esta completa colección incluye 44.000 objetos distintos con 110.000 animaciones únicas, todas ellas representadas desde 48 puntos de vista diferentes. “La clave de nuestro éxito es un novedoso conjunto de datos de vídeos multivista que contiene objetos animados renderizados de Objaverse” – Afirma Nvidia. Este conjunto de datos, que incluye la asombrosa cifra de 12 millones de vídeos y un total de 300 millones de fotogramas, proporciona al modelo L4GM un corpus de entrenamiento rico y diverso. Al exponer el sistema a una gama tan amplia de contenidos animados, los investigadores han conseguido que L4GM aprenda los intrincados patrones y matices de la dinámica de los objetos en 4D, lo que le permite generalizar extraordinariamente bien las entradas de vídeo en movimiento. Capacidades y aplicaciones de L4GM Las capacidades del L4GM de Nvidia van mucho más allá de la mera destreza técnica. Este innovador sistema tiene el potencial de revolucionar

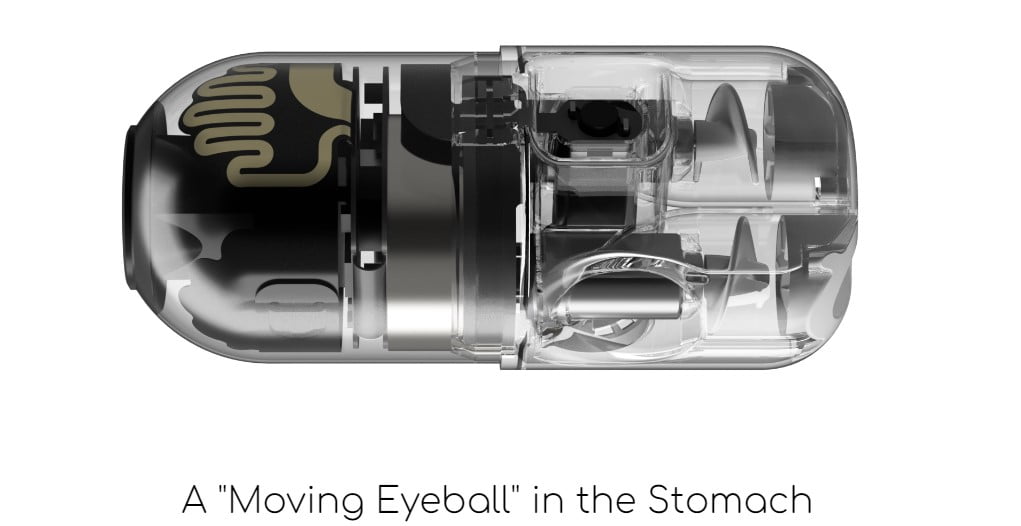

Tragar un robot en lugar de endoscopia: Pillbot transforma la gastroenterología

Last Updated on junio 26, 2024 12:59 pm by Laszlo Szabo / NowadAIs | Published on junio 26, 2024 by Laszlo Szabo / NowadAIs Tráguese un robot en lugar de la endoscopia: Pillbot transforma la gastroenterología – Notas clave Pillbot es una cápsula robótica ingerible desarrollada por Endiatx. Está diseñada para ofrecer una alternativa no invasiva a la endoscopia tradicional. Pillbot puede ser controlado a distancia por los médicos para una navegación precisa. Captura vídeo de alta resolución del tracto gastrointestinal. Posibilidad de ahorrar costes y reducir el impacto ambiental. Endiatx busca la aprobación de la FDA y prevé su lanzamiento comercial para 2026. La integración con plataformas de telemedicina podría mejorar el acceso a la atención sanitaria. La visión a largo plazo incluye la navegación autónoma guiada por inteligencia artificial y la ampliación de las aplicaciones médicas. Presentamos Pillbot, una cápsula robótica ingerible desarrollada por la empresa pionera en tecnología médica Endiatx. Este dispositivo ingerible está llamado a redefinir el futuro del diagnóstico no invasivo, ofreciendo a los pacientes una alternativa más cómoda y accesible que los procedimientos endoscópicos tradicionales. El nacimiento de Pillbot: Una maravilla médica en miniatura Endiatx, una startup con sede en California fundada en 2019, ha estado trabajando firmemente para hacer realidad la ambiciosa visión de incorporar robots miniaturizados en el cuerpo humano con fines diagnósticos y terapéuticos. En el centro de su empeño se encuentra el Pillbot, una extraordinaria cápsula robótica que pretende cambiar el campo de la gastroenterología. Superar los retos técnicos: Del tamaño de un balón de fútbol al de un multivitamínico La creación del Pillbot ha sido una prueba de la destreza del equipo en ingeniería y de su incesante innovación. Como revela Torrey Smith, CEO de Endiatx, los prototipos iniciales distaban mucho de ser el dispositivo compacto y tragable que vemos hoy. “Empezamos con el tamaño de un balón de fútbol” se ríe al recordar los esfuerzos de la empresa por reducir el Pillbot a un tamaño de 13 por 30 mm, más o menos como una pastilla multivitamínica grande. Esta extraordinaria hazaña de miniaturización obligó al equipo de Endiatx a enfrentarse a un sinfín de retos técnicos, desde el diseño de un robusto sistema de propulsión hasta la optimización de la comunicación inalámbrica y la gestión de la energía. A lo largo de más de 20 generaciones de prototipos, los ingenieros han perfeccionado meticulosamente cada componente, garantizando que el Pillbot pueda recorrer el complejo terreno del sistema digestivo humano con precisión y eficacia. Un enfoque verticalmente integrado: Fomento de la innovación y la colaboración El enfoque de Endiatx para desarrollar el Pillbot es un refrescante retroceso a los primeros tiempos de la innovación en Silicon Valley, donde ingenieros, expertos y manitas trabajaban codo con codo para resolver problemas complejos. El compromiso de la empresa con la integración vertical -en la que todos los aspectos del desarrollo del dispositivo se realizan internamente- ha sido fundamental para su capacidad de innovar con rapidez y ampliar los límites de lo que es posible con la robótica médica. “Estamos completamente integrados verticalmente” Explica Smith. “Escribimos todo el código. Tenemos que empaquetar toda la informática, el almacenamiento, el procesamiento y la radio en un factor de forma extremadamente pequeño con una potencia eléctrica muy limitada. En este sistema no hay sitio para utilizar las bibliotecas de software de otros” Este enfoque práctico y colaborativo permite al equipo de Endiatx asegurarse de que cada componente del Pillbot está optimizado para los retos únicos que supone operar dentro del cuerpo humano. También fomenta una cultura de creatividad y resolución de problemas, en la que expertos de diversos campos -desde la robótica y la IA hasta la medicina y la ciencia de los materiales- colaboran para hacer frente a los obstáculos que surgen. Capacidades de Pillbot: Una maravilla tecnológica El Pillbot no es una simple cámara para píldoras; es un dispositivo robótico completo que combina una asombrosa tecnología de IA con una funcionalidad sin parangón. Sus impresionantes capacidades lo diferencian de los métodos tradicionales de endoscopia, ofreciendo a los pacientes una alternativa más cómoda y menos invasiva. Transmisión de vídeo de alta resolución En el corazón de las proezas del Pillbot se encuentra su sistema de cámara de última generación, capaz de capturar vídeo de alta resolución a una asombrosa velocidad de 2,3 megapíxeles por segundo. Esta señal de vídeo en directo se transmite de forma inalámbrica al ordenador o dispositivo móvil del médico, proporcionando una visión cercana y en tiempo real del tracto gastrointestinal del paciente. “Puede transmitir vídeo de alta resolución a 2,3 megapíxeles por segundo, y tenemos planes para cuadruplicar esa calidad de vídeo en breve” Alardea Smith, mostrando las impresionantes especificaciones técnicas del dispositivo. Maniobrabilidad precisa Lo que diferencia al Pillbot de las cámaras de píldoras convencionales es su avanzado sistema de propulsión. Equipado con minúsculos micromotores y hélices, el dispositivo puede navegar activamente por el intestino, guiado por un médico mediante un mando de juego portátil. Este nivel de control y maniobrabilidad permite un examen más exhaustivo del aparato digestivo, lo que permite a los profesionales sanitarios centrarse en las áreas de interés con mayor detalle. “La parte frontal de Pillbot es básicamente como una cámara de píldoras normal” Explica Smith. “Tiene LED para iluminar, una bonita cámara y comunicación electrónica con el exterior. La parte trasera de Pillbot son tres motores eléctricos de corriente continua con hélices, orientados de forma que pueda volar en X, Y y Z” Diseño biocompatible y seguro Endiatx ha diseñado el Pillbot teniendo muy en cuenta la seguridad del paciente. Los componentes del dispositivo están encapsulados de forma segura dentro de una carcasa biocompatible, lo que garantiza que se pueda tragar fácilmente y expulsar del cuerpo de forma natural sin causar ningún daño. El procedimiento Pillbot: Una nueva definición de comodidad y accesibilidad Una de las ventajas más significativas del Pillbot es su capacidad para transformar la experiencia de la endoscopia tradicional, haciéndola más cómoda y accesible para los pacientes. Un método indoloro y no

Da rienda suelta a tu creatividad con el generador de vídeo Gen-3 Alpha AI de Runway

Last Updated on junio 26, 2024 8:06 am by Laszlo Szabo / NowadAIs | Published on junio 19, 2024 by Laszlo Szabo / NowadAIs Da rienda suelta a tu creatividad con el generador de vídeo Gen-3 Alpha AI de Runway – Notas clave Gen-3 Alpha de Runway: El último modelo de generación de texto a vídeo basado en IA. Generación humana fotorrealista: Crea personajes y acciones humanos de gran realismo. Coherencia temporal: Transiciones naturales mejoradas y fluidez perfecta en los vídeos. Control temporal preciso: Encuadres clave precisos y transiciones imaginativas. Capacidades multimodales: Admite entradas de imagen a vídeo y de texto a imagen. Personalización: Colabora con los medios de comunicación para controlar el estilo de los contenidos. Comparación con el sector: Compite con Sora de OpenAI, Kling de Kuaishou, Veo de Google y Dream Machine de Luma Labs. Impacto en el cine y la televisión: Puede desplazar puestos de trabajo, pero también ofrece nuevas oportunidades creativas. Consideraciones éticas: Implementa salvaguardas como sistemas de moderación y procedencia. Introducción https://www.nowadais.com/wp-content/uploads/2024/06/Elderly-woman-with-colorful-wig-and-sunglasses-Sample-video-generated-by-Runways-Gen-3-Alpha-AI-Video-Generator.mp4 El mundo de la generación de vídeo con IA ha experimentado una notable transformación en los últimos meses, con tecnologías de IA innovadoras que amplían continuamente los límites de lo posible. A la vanguardia de esta evolución se encuentra Runway, una startup con sede en Nueva York que ha estado constantemente en la cima de este campo en rápida evolución. Tras el lanzamiento de su modelo Gen-2 en 2023, Runway ha desvelado ahora su última y más impresionante creación: Gen-3 Alpha. Este nuevo generador de vídeo con IA promete elevar los estándares de fotorrealismo y coherencia cinematográfica, estableciendo un nuevo punto de referencia en la industria. En este completo artículo, nos adentraremos en las extraordinarias capacidades del Gen-3 Alpha de Runway, exploraremos cómo se compara con sus competidores y descubriremos las implicaciones potenciales de esta tecnología de inteligencia artificial en el panorama creativo. El auge de la generación de vídeo con IA El camino hacia los contenidos de vídeo de alta calidad generados por IA ha estado marcado por una serie de hitos notables. La introducción del modelo Sora de OpenAI a principios de 2024 cautivó al mundo con su capacidad para generar videoclips fluidos de alta definición que rivalizaban con los contenidos producidos por humanos. Sin embargo, el panorama evolucionó rápidamente, con la aparición de formidables competidores como Kuaishou’s Kling, Google’s Veo y Luma Labs’ Dream Machine. Estos modelos mostraron capacidades impresionantes, desafiando el dominio de Sora y ampliando los límites de lo que se consideraba posible en el ámbito de la generación de vídeo por IA. Gen-2 de Runway y la necesidad de mejorar En medio de este panorama en rápida evolución, Runway se encontró en una posición única. Como uno de los primeros pioneros en este campo, la empresa ya se había hecho un nombre con su modelo Gen-2, que había sido bien recibido por la comunidad creativa. Sin embargo, a medida que se intensificaba la competencia, se hizo evidente que Runway necesitaba subir el listón y ofrecer una solución sorprendente para mantener su posición de líder en el sector. Presentamos la Gen-3 Alpha de Runway https://www.nowadais.com/wp-content/uploads/2024/06/A-close-up-portrait-of-a-woman-lit-by-the-side-the-camera-pulls-back-Sample-video-by-Runways-Gen-3-Alpha.mp4 La espera de la respuesta de Runway a los avances de la industria por fin ha terminado con la presentación de Gen-3 Alpha. Este nuevo modelo, descrito como el “primero de una próxima serie” representa una actualización significativa de las capacidades de Runway, prometiendo ofrecer una “una mejora importante en fidelidad, consistencia y movimiento” respecto a su predecesor. Generación humana fotorrealista Una de las características más destacadas de Gen-3 Alpha es su capacidad para generar personajes humanos de gran realismo con una amplia gama de acciones, gestos y emociones. Este avance permite crear contenidos de vídeo expresivos y realistas, abriendo nuevas posibilidades para la narración de historias y las experiencias cinematográficas. Fidelidad y coherencia mejoradas El modelo Gen-3 Alpha presenta una mejora sustancial en la calidad y coherencia generales de los vídeos generados. Con una coherencia temporal mejorada, las transiciones y el flujo de los vídeos parecen más naturales y fluidos, creando una experiencia visual realmente envolvente. Control temporal preciso Una característica clave de Gen-3 Alpha es su capacidad para manejar subtítulos altamente descriptivos y temporalmente densos. Esta capacidad permite transiciones imaginativas y encuadres clave precisos de elementos dentro de una escena, lo que permite un nivel de control creativo que antes era inalcanzable. Funciones multimodales El último modelo de Runway no se limita únicamente a la generación de vídeo. Admite varios modos de entrada, como imagen a vídeo y texto a imagen, lo que amplía las posibilidades creativas de los usuarios y consolida aún más su posición como herramienta versátil y potente. Posibilidades de personalización Runway ha revelado que está colaborando con importantes organizaciones de entretenimiento y medios de comunicación para crear versiones personalizadas de Gen-3 Alpha. Esto permite la generación de personajes estilísticamente controlados y consistentes, atendiendo a requisitos artísticos y narrativos específicos. Comparación de Gen-3 Alpha con la competencia https://www.nowadais.com/wp-content/uploads/2024/06/Amazing-consistency-video-by-Luma-AI-Drem-Machine.mp4 A medida que el panorama de la generación de vídeo con IA sigue evolucionando, es fundamental comprender cómo se compara Gen-3 Alpha de Runway con sus competidores. Veamos cómo se comporta: Sora de OpenAI El modelo Sora de OpenAI, ampliamente considerado como la referencia en el sector, ha sido elogiado por su excepcional calidad y consistencia. Aunque Gen-3 Alpha no alcance el nivel de coherencia de Sora, demuestra un notable progreso en términos de fidelidad y capacidad para manejar escenas y movimientos complejos. Kling de Kuaishou El modelo Kling, desarrollado en China, también ha logrado avances significativos en el campo de la generación de vídeo por IA, con su capacidad para producir videoclips de alta definición de dos minutos de duración. El Gen-3 Alpha de Runway, aunque limitado a clips de 10 segundos, muestra un nivel de detalle y realismo que puede rivalizar con la producción de Kling. Dream Machine de Luma Labs Dream Machine de Luma Labs ha llamado la atención por su aptitud para animar memes y contenidos surrealistas. Aunque Gen-3 Alpha no destaque en el

Stable Diffusion 3 Medium: Explore su creatividad con la IA de texto a imagen – gratis

Last Updated on junio 25, 2024 12:47 pm by Laszlo Szabo / NowadAIs | Published on junio 17, 2024 by Laszlo Szabo / NowadAIs Stable Diffusion 3 Medium: Explore su creatividad con la IA de texto a imagen – gratis – Notas clave Stable Diffusion 3 Medium: El último modelo de IA de texto a imagen de Stability AI. Alto rendimiento: Utiliza 2.000 millones de parámetros para ofrecer una calidad de imagen y un fotorrealismo excepcionales. Comprensión mejorada de las instrucciones: Incorpora razonamiento espacial, composición y estilo con codificadores de texto avanzados. Gran avance en tipografía: Genera texto con menos errores de ortografía, interletraje y espaciado. Rendimiento optimizado: Colaboraciones con NVIDIA y AMD para mejorar la eficiencia. Licencia accesible: Gratuita para uso no comercial, con opciones de licencia comercial. Mejora continua: Compromiso de desarrollo continuo basado en las opiniones de los usuarios. Stable Diffusion 3 Medium: Una nueva era de creatividad Stable Diffusion 3 Medium, el último modelo de IA de texto a imagen de Stability AI, está preparado para cambiar el mundo de la IA generativa. Esta tecnología ofrece una calidad de imagen excepcional, una comprensión rápida sin precedentes y un rendimiento eficiente de los recursos, todo ello de forma gratuita. Hoy, estamos encantados de anunciar las ponderaciones abiertas para Stable Diffusion 3 Medium, ¡el último y más avanzado modelo de IA de texto a imagen de nuestra serie Stable Diffusion 3! Esta nueva versión representa un hito importante en la evolución de la IA generativa y continúa nuestro compromiso con… pic.twitter.com/oKLQ6SwQWc – Stability AI (@StabilityAI) 12 de junio de 2024 Stable Diffusion 3 Medium es un modelo de 2 mil millones de parámetros que se basa en el éxito de sus predecesores, ofreciendo un paso transformador en las capacidades de conversión de texto a imagen. Este modelo, desarrollado por el innovador equipo de Stability AI, ha sido meticulosamente elaborado para subsanar las deficiencias de los modelos anteriores, estableciendo un nuevo estándar en el sector. Calidad de imagen y fotorrealismo excepcionales Una de las características más destacadas de Stable Diffusion 3 Medium es su capacidad para generar imágenes con un nivel excepcional de detalle, color e iluminación. Los avances del modelo en fotorrealismo le permiten crear resultados que rivalizan con la fotografía del mundo real, difuminando la línea entre lo digital y lo físico. Comprensión rápida sin precedentes Stable Diffusion 3 Medium destaca en la comprensión de indicaciones complejas y matizadas, incorporando a la perfección el razonamiento espacial, los elementos de composición, las acciones y los estilos. Al aprovechar una combinación de tres potentes codificadores de texto, el modelo ofrece a los usuarios la flexibilidad necesaria para equilibrar el rendimiento y la eficacia en función de sus necesidades específicas. El siguiente paso en tipografía Otro logro notable de Stable Diffusion 3 Medium es su calidad de texto sin precedentes. La arquitectura Diffusion Transformer del modelo le permite generar texto con menos errores de ortografía, interletraje, formación de letras y espaciado, estableciendo un nuevo punto de referencia en la generación de texto a imagen. Colaboración y optimización: Liberar todo el potencial Stability AI ha forjado alianzas estratégicas para mejorar el rendimiento de Stable Diffusion 3 Medium, garantizando que ofrezca los mejores resultados de su clase. Colaboración con NVIDIA Gracias a su colaboración con NVIDIA, Stability AI ha aprovechado la potencia de las GPU NVIDIA®RTX y TensorRT para optimizar el rendimiento de todos los modelos de Stable Diffusion, incluido Stable Diffusion 3 Medium. Las versiones del modelo optimizadas con TensorRT presentan un aumento del rendimiento del 50%, lo que las hace aún más eficientes y accesibles. Colaboración con AMD Stability AI también ha colaborado estrechamente con AMD para optimizar la inferencia de Stable Diffusion 3 Medium en varios dispositivos AMD, incluidas las últimas APU, GPU de consumo y GPU empresariales MI-300X. Esta colaboración garantiza que el modelo pueda integrarse a la perfección en una amplia gama de configuraciones de hardware, atendiendo a las diversas necesidades de los usuarios. Accesibilidad y licencias: Democratización de la IA generativa El compromiso de Stability AI con una IA generativa abierta y accesible se mantiene firme, como demuestra el lanzamiento de Stable Diffusion 3 Medium. Uso abierto y no comercial Stable Diffusion 3 Medium se publica bajo la Licencia Comunitaria de Investigación No Comercial de Stability, por lo que está disponible gratuitamente para uso no comercial, como la investigación académica y la exploración personal. Uso comercial: Licencia de creador y licencia de empresa Para animar a la comunidad creativa a aprovechar la potencia de Stable Diffusion 3 Medium, Stability AI ha introducido la nueva Licencia de Creador. Esta licencia está diseñada para artistas profesionales, diseñadores, desarrolladores y entusiastas de la IA que deseen utilizar el modelo con fines comerciales y, al mismo tiempo, apoyar la misión de Stability AI de mantener la IA abierta y accesible. Para usuarios comerciales y empresas a gran escala, Stability AI ofrece una Licencia de Empresa, que garantiza que las empresas puedan aprovechar plenamente el potencial del modelo respetando las directrices de uso de la empresa. Mejora continua y planes de futuro Stability AI se compromete a mejorar continuamente Stable Diffusion 3 Medium basándose en los comentarios de los usuarios, ampliando sus funciones y mejorando su rendimiento. El objetivo de la empresa es establecer un nuevo estándar para la creatividad en el arte generado por IA, haciendo de Stable Diffusion 3 Medium una herramienta vital tanto para profesionales como para aficionados. Ampliación de capacidades y rendimiento A través de la investigación y el desarrollo continuos, Stability AI planea seguir perfeccionando las capacidades del modelo, abordando cualquier limitación y ampliando continuamente los límites de lo que es posible en la generación de texto a imagen. La dedicación de la empresa a la innovación y la colaboración garantizará que Stable Diffusion 3 Medium se mantenga a la vanguardia del sector. Fomentar una comunidad dinámica Stability AI se compromete a fomentar una comunidad vibrante en torno a Stable Diffusion 3 Medium, animando a los usuarios a explorar, experimentar y superar los límites de

Sonnet Claude 3.5 de Anthropic: Mejores pruebas que GPT-4o y Gemini 1.5

Last Updated on junio 25, 2024 12:57 pm by Laszlo Szabo / NowadAIs | Published on junio 25, 2024 by Laszlo Szabo / NowadAIs Sonnet Claude 3.5 de Anthropic: Mejores pruebas que GPT-4o y Gemini 1.5 – Notas clave Claude 3.5 Sonnet: El último modelo de IA de Anthropic, que supera a las versiones anteriores y a los gigantes del sector. Benchmarks de rendimiento: Destaca en las pruebas GPQA, MMLU y HumanEval, demostrando una inteligencia y una capacidad de codificación superiores. Velocidad y rentabilidad: Funciona al doble de velocidad que su predecesor con un precio rentable. Capacidades visuales: Supera a los modelos anteriores en interpretación y análisis de datos visuales. Función de artefactos: Permite una integración perfecta de los contenidos generados por IA en los proyectos. Seguridad y privacidad: Nivel de seguridad ASL-2 con sólidas políticas de privacidad. Futuras ampliaciones: Próximos modelos Claude 3.5 Haiku y Claude 3.5 Opus, y nuevas funciones como Memory e integraciones empresariales. Claude 3.5 Sonnet de Anthropic ya está a la venta Anthropic, la empresa pionera en investigación de IA, ha vuelto a subir el listón de la inteligencia artificial con el lanzamiento de su último modelo, Claude 3.5 Sonnet. Este modelo lingüístico no sólo supera a su predecesor, Claude 3 Opus, sino que también supera a gigantes del sector como GPT-4o de OpenAI y Gemini-1.5 Pro de Google en una amplia gama de pruebas comparativas. Las impresionantes capacidades de Claude 3.5 Sonnet son un testimonio de la incesante búsqueda de la innovación por parte de Anthropic. Este modelo supone un notable salto en inteligencia, velocidad y rentabilidad, lo que lo convierte en un revulsivo en el panorama de la IA en rápida evolución. Desde el razonamiento a nivel de posgrado hasta el conocimiento a nivel de licenciatura, y desde el dominio de la codificación hasta el procesamiento visual, Claude 3.5 Sonnet se ha establecido firmemente como líder del sector. Inteligencia y rendimiento sin precedentes La inteligencia de Claude 3.5 Sonnet es realmente notable, estableciendo nuevos puntos de referencia de la industria en varios dominios. En razonamiento de nivel universitario (GPQA), conocimientos de nivel universitario (MMLU) y competencia en codificación (HumanEval), este modelo ha superado a sus competidores, demostrando sus excepcionales capacidades cognitivas. Lo que distingue a Claude 3.5 Sonnet es su capacidad para captar los matices, el humor y las instrucciones complejas con una precisión excepcional. El tono natural y cercano del modelo en la generación de contenidos aumenta aún más su atractivo, convirtiéndolo en una herramienta versátil para una amplia gama de aplicaciones. Velocidad vertiginosa y precios rentables Una de las características más destacadas de Claude 3.5 Sonnet es su extraordinaria velocidad, que duplica la de su predecesor, Claude 3 Opus. Este aumento del rendimiento, combinado con su precio rentable, lo convierte en la opción ideal para tareas complejas como la atención al cliente sensible al contexto y la orquestación de flujos de trabajo de varios pasos. La velocidad y rentabilidad del modelo lo hacen accesible a una gama más amplia de usuarios, desde particulares a empresas, permitiéndoles aprovechar el poder de la IA avanzada sin arruinarse. Asombrosas capacidades de visión Las capacidades de visión de Claude 3.5 Sonnet son realmente impresionantes, superando incluso al estimado Claude 3 Opus en las pruebas de visión estándar. La capacidad del modelo para interpretar y analizar con precisión datos visuales, incluidos cuadros, gráficos e incluso texto escrito a mano, cambia las reglas del juego. Esta destreza en el procesamiento visual es especialmente beneficiosa para sectores como el comercio minorista, la logística y los servicios financieros, en los que la IA puede extraer información valiosa de imágenes, gráficos e ilustraciones que pueden ser más informativos que el texto por sí solo. Artefactos: Cambiando la colaboración entre IA y humanos La introducción por Anthropic de Artifacts en la plataforma Claude.ai supone una evolución significativa en la forma en que los usuarios interactúan con la IA. Esta función permite a los usuarios integrar sin problemas en sus proyectos y flujos de trabajo contenidos generados por la IA, como fragmentos de código, documentos de texto y diseños de sitios web. Los artefactos crean un espacio de trabajo dinámico en el que los usuarios pueden ver, editar y desarrollar las creaciones de Claude en tiempo real, fomentando un entorno de colaboración entre los humanos y la IA. Con esta integración, Claude deja de ser una IA conversacional para convertirse en una verdadera herramienta de productividad que permite a los usuarios aprovechar el poder de la IA para mejorar sus propias creaciones. Seguridad y privacidad El compromiso inquebrantable de Anthropic con la seguridad y la privacidad es una piedra angular de su enfoque del desarrollo de la IA. La empresa ha sometido a Claude 3.5 Sonnet a rigurosas pruebas y ha implementado sólidos mecanismos de seguridad para mitigar posibles usos indebidos. A pesar del impresionante nivel de inteligencia del modelo, Anthropic se ha asegurado de que Claude 3.5 Sonnet permanezca en ASL-2, un nivel de seguridad que prioriza el despliegue responsable y ético de la IA. La empresa también ha colaborado con expertos externos, como el Instituto de Seguridad de la Inteligencia Artificial del Reino Unido, para seguir perfeccionando y reforzando las características de seguridad del modelo. Además, la dedicación de Anthropic a la privacidad es evidente en su política de no entrenar sus modelos generativos con datos enviados por los usuarios sin permiso explícito. Este compromiso de salvaguardar la privacidad de los usuarios es un testimonio de los principios éticos de la empresa. Ampliación de la familia de modelos Claude 3.5 La visión de Anthropic para la familia de modelos Claude 3.5 va más allá del lanzamiento de Claude 3.5 Sonnet. La empresa ha anunciado planes para introducir dos modelos adicionales, Claude 3.5 Haiku y Claude 3.5 Opus, a finales de este año, ampliando aún más las capacidades y la versatilidad del ecosistema Claude. “Para completar la familia de modelos Claude 3.5, lanzaremos Claude 3.5 Haiku y Claude 3.5 Opus a finales de este año” declararon. Se espera que estos