Qwen 2-72B de Alibaba Cloud: la inteligencia artificial supera a los mejores modelos LLM como Llama-3-70B

Last Updated on junio 10, 2024 11:08 am by Laszlo Szabo / NowadAIs | Published on junio 10, 2024 by Laszlo Szabo / NowadAIs Qwen 2-72B de Alibaba Cloud: la inteligencia artificial supera a los mejores modelos LLM como Llama-3-70B – Notas clave Qwen 2-72B es el buque insignia de los grandes modelos lingüísticos desarrollados por el equipo Qwen de Alibaba Cloud Presenta un rendimiento puntero en comprensión del lenguaje, capacidades multilingües, codificación, matemáticas y razonamiento El modelo presenta elementos arquitectónicos avanzados como la activación SwiGLU, el sesgo de atención QKV y la atención a consultas de grupo Qwen 2-72B se ha entrenado con una gran cantidad de datos multilingües y se ha perfeccionado mediante ajustes supervisados y optimización directa de preferencias Admite longitudes de contexto de hasta 128.000 tokens, lo que permite un manejo excepcional de contenidos de formato largo El modelo demuestra una seguridad y una responsabilidad superiores, superando a las principales alternativas en el manejo de indicaciones delicadas Introducción En el panorama en rápida evolución de la inteligencia artificial, la presentación de Qwen 2-72B constituye un hito monumental. Este colosal modelo lingüístico de gran tamaño, desarrollado por el visionario equipo Qwen de Alibaba Cloud, se ha revelado como un auténtico tour de force, estableciendo unos estándares asombrosamente altos de comprensión lingüística, competencia multilingüe y destreza en la resolución de tareas. Qwen 2-72B es la culminación de una investigación meticulosa, una formación rigurosa y una búsqueda incesante de la excelencia. Con la asombrosa cifra de 72.000 millones de parámetros, este gigantesco modelo ha sido meticulosamente diseñado para sobresalir en una amplia gama de ámbitos, desde el procesamiento del lenguaje natural y la generación de código hasta el razonamiento matemático, entre otros. Dominio multilingüe Una de las características más destacadas de Qwen 2-72B es su excepcional capacidad multilingüe. Entrenado en un amplio conjunto de datos que abarca 27 idiomas además del inglés y el chino, el modelo ha desarrollado una comprensión profunda y versátil de diversos paisajes lingüísticos. Esta versatilidad lingüística permite a Qwen 2-72B navegar sin problemas por la comunicación multilingüe, rompiendo barreras y fomentando la colaboración global. Destreza matemática y de codificación La capacidad de Qwen 2-72B va mucho más allá del procesamiento del lenguaje natural. El modelo ha demostrado notables capacidades en los campos de la codificación y las matemáticas, estableciendo nuevos hitos en estos ámbitos tan técnicos. Gracias a un entrenamiento meticuloso y a un perfeccionamiento selectivo, el equipo de Qwen ha dotado al modelo de un profundo conocimiento de los lenguajes de programación, los algoritmos y los conceptos matemáticos, lo que le permite enfrentarse con facilidad a complejas tareas de codificación y resolver intrincados problemas matemáticos. Dominio del contenido de formato largo Una de las características más destacadas de Qwen 2-72B es su excepcional manejo de contenidos largos. Capaz de procesar contextos de hasta 128.000 palabras, el modelo destaca en la comprensión y generación de respuestas coherentes a entradas extensas de varios párrafos. Esta capacidad distingue a Qwen 2-72B, convirtiéndolo en un valioso activo en aplicaciones en las que la comprensión detallada y matizada de textos extensos es primordial. Seguridad y responsabilidad En una época en la que el desarrollo responsable de la tecnología de IA es de vital importancia, Qwen 2-72B destaca por su compromiso inquebrantable con la seguridad y las consideraciones éticas. Pruebas exhaustivas han demostrado la capacidad del modelo para navegar por mensajes y contenidos delicados, produciendo constantemente resultados que están alineados con los valores humanos y libres de elementos nocivos o poco éticos. Qwen 2-72B en acción La versatilidad de Qwen 2-72B es realmente impresionante, con el modelo capaz de transición sin problemas entre una amplia gama de tareas y aplicaciones. Desde la generación de lenguaje natural y la respuesta a preguntas hasta la interpretación de código y la resolución de problemas matemáticos, esta potencia de la IA ha demostrado ser un verdadero multitalento. Implantación e integración Qwen 2-72B se ha diseñado teniendo en cuenta la escalabilidad y la accesibilidad, lo que lo convierte en un candidato ideal para su implantación en una amplia gama de plataformas y casos de uso. La integración del modelo con los principales marcos de trabajo, como Hugging Face Transformers y ModelScope, garantiza que los desarrolladores e investigadores puedan aprovechar sin esfuerzo sus capacidades, abriendo nuevas posibilidades en sus respectivos dominios. Evaluación comparativa y rendimiento Pruebas y evaluaciones rigurosas han demostrado sistemáticamente el rendimiento superior de Qwen 2-72B en una amplia gama de puntos de referencia. En las comparaciones directas con otros modelos de última generación, como Llama-3-70B, el modelo Qwen 2-72B se ha erigido en claro vencedor, demostrando sus incomparables capacidades en áreas como la comprensión del lenguaje natural, la adquisición de conocimientos y la destreza en la resolución de tareas. El camino por recorrer Mientras el modelo Qwen 2-72B sigue cautivando a la comunidad de la IA, el futuro es muy prometedor. El inquebrantable compromiso del equipo de Qwen con la innovación y su incesante búsqueda de la excelencia sugieren que esto no es más que el principio de una nueva era en el desarrollo de grandes modelos lingüísticos. Con los continuos refinamientos, ampliaciones y la exploración de capacidades multimodales, Qwen 2-72B está preparado para redefinir los límites de lo que es posible en el mundo de la inteligencia artificial. Definiciones Qwen 2 -72B: Un modelo lingüístico de última generación desarrollado por Alibaba Cloud con 72.000 millones de parámetros, que destaca en capacidades multilingües, codificación, matemáticas y manejo de contenidos de formato largo. SwiGLU: Un tipo de función de activación utilizada en redes neuronales, que mejora la capacidad del modelo para aprender patrones complejos. Sesgo QKV: Se refiere a los términos de sesgo en los vectores de consulta, clave y valor en los modelos transformadores, que mejoran los mecanismos de atención. HungaryExam: Conjunto de datos de evaluación comparativa o herramienta utilizada para evaluar el rendimiento de los modelos de IA en la comprensión del lenguaje y tareas relacionadas. Métricas de rendimiento MMLU: Métrica utilizada para evaluar el rendimiento de grandes modelos lingüísticos

Kling, el modelo de generación de vídeo basado en IA de Kuaishou, desafía a Sora de OpenAI

Last Updated on junio 7, 2024 10:44 am by Laszlo Szabo / NowadAIs | Published on junio 7, 2024 by Laszlo Szabo / NowadAIs Kling, el modelo de generación de vídeo basado en IA de Kuaishou, desafía a Sora de OpenAI – Notas clave Kling de Kuaishou: Nuevo modelo de generación de texto a vídeo basado en IA. Tecnología avanzada: Utiliza Diffusion Transformer y 3D VAE para la producción de vídeo de alta calidad. Video capabilities: Produce vídeos de hasta 2 minutos de duración en resolución 1080p a 30 fps. Capacidades de simulación: Modela con precisión las propiedades físicas y las interacciones del mundo real. Versatilidad: Combina efectos visuales realistas e imaginativos para diversas aplicaciones. Competencia: Desafía a Sora de OpenAI y a otros modelos chinos como Dreamina y Vidu. Accesibilidad: Disponible para uso público a través de la aplicación de edición de vídeo de Kuaishou, Kuaiying. Impacto potencial: Podría transformar el cine, la publicidad, los juegos y las experiencias de realidad virtual. Introducción En el mundo de la inteligencia artificial, que evoluciona a gran velocidad, se ha intensificado la carrera por desarrollar modelos generativos de vanguardia, y tanto los gigantes tecnológicos como las nuevas empresas compiten por superar los límites de lo posible. A la vanguardia de esta revolución tecnológica se encuentra Kuaishou, la plataforma china de vídeos cortos que acaba de presentar su última creación: Kling, un modelo de generación de texto a vídeo que aspira a rivalizar con el reputado Sora de OpenAI. Kling participa en la competición en curso para crear herramientas de generación de vídeo impulsadas por IA que puedan transformar el panorama creativo. Mientras el mundo espera con impaciencia el lanzamiento de Sora de OpenAI, Kuaishou ha aceptado el reto y ha mostrado las impresionantes capacidades de Kling, que podría superar a su esperado competidor. La destreza técnica de Kling: Superando los límites de la generación de vídeo https://www.nowadais.com/wp-content/uploads/2024/06/Vulcano-in-a-cup-of-coffee-an-ai-generated-video-by-Kuaishous-AI-Powered-Video-Generation-Model-Kling.mp4 En el corazón de la proeza tecnológica de Kling se encuentra su capacidad para generar vídeos largos de alta calidad a partir de simples mensajes de texto. El equipo de inteligencia artificial de Kuaishou ha desarrollado Kling utilizando técnicas avanzadas, como la arquitectura Diffusion Transformer y la tecnología patentada 3D VAE (Variational Autoencoder), que permiten al modelo traducir textos ricos en escenas vívidas y realistas. Una de las características más destacadas de Kling es su capacidad para producir vídeos de hasta dos minutos de duración, con una resolución de 1080p y una frecuencia de imagen de 30 fotogramas por segundo. Esta impresionante hazaña supera el límite de un minuto de vídeo de Sora, de OpenAI, y demuestra la capacidad de Kling para crear experiencias visuales más largas y envolventes. Capacidades de simulación de Kling: Dar vida al realismo físico Las proezas técnicas de Kling van más allá de la mera generación de vídeo; el modelo también demuestra una notable capacidad para simular propiedades e interacciones físicas del mundo real. Mediante la implementación de un sistema de atención espacio-temporal en 3D, Kling puede modelar con precisión secuencias de movimiento complejas y captar los matices de los fenómenos físicos. Un ejemplo cautivador mostrado por Kuaishou es un vídeo que muestra a un niño montando en bicicleta por un jardín, en el que los cambios de estación se integran perfectamente en la escena. La atención al detalle del modelo para captar los sutiles cambios del entorno y la coherencia de los movimientos del niño son un testimonio de las avanzadas capacidades de simulación de Kling. Versatilidad de Kling: Del realismo a la imaginación https://www.nowadais.com/wp-content/uploads/2024/06/White-Cat-Driving-through-a-City-sample-AI-generated-video-by-Kuaishous-AI-Powered-Video-Generation-Model-Kling.mp4 Aunque la destreza de Kling para generar vídeos realistas es innegable, el modelo también demuestra su capacidad para combinar imaginación y creatividad. Kuaishou ha demostrado la capacidad de Kling para combinar diversos conceptos y generar escenas ficticias, como un gato conduciendo un coche por una bulliciosa ciudad. Esta flexibilidad en la transición entre imágenes realistas e imaginativas subraya el potencial de Kling para revolucionar diversos sectores, desde el cine y la publicidad hasta los juegos y las experiencias virtuales. Al permitir a los creadores dar vida a sus ideas con una facilidad y precisión sin precedentes, Kling abre nuevas vías para la expresión artística y la narración. El panorama competitivo de Kling: Desafiando a Sora de OpenAI y a los nuevos rivales chinos La introducción de Kling en el mercado se produce en un momento en el que se intensifica la carrera por los modelos avanzados de generación de vídeo, tanto a nivel mundial como en China. Aunque Sora, de OpenAI, ha suscitado una gran expectación y atención, la aparición de Kling como formidable contrincante ha abierto un nuevo capítulo en esta rivalidad tecnológica. Curiosamente, Kling no es el único modelo chino de conversión de texto en vídeo que está causando sensación en el sector. Dreamina, respaldada por ByteDance, y Vidu, desarrollada por la startup Shengshu Technology, con sede en Pekín, también han presentado sus propias versiones de modelos similares a Sora, demostrando la creciente destreza del país en este campo. Impacto potencial de Kling: Transformar la creación de contenidos y más allá La llegada de Kling promete transformar el panorama de la creación de contenidos en diversos sectores. Al permitir a los usuarios generar vídeos largos de alta calidad con facilidad, Kling podría revolucionar la forma en que abordamos tareas como la realización de películas, la producción de vídeos e incluso las experiencias de realidad virtual. Además, la capacidad de Kling para simular interacciones físicas y combinar realismo e imaginación abre nuevas posibilidades de aplicación en campos como los juegos, la educación e incluso la visualización científica. A medida que el modelo siga evolucionando y perfeccionándose, su impacto podría extenderse mucho más allá del ámbito de la generación de vídeo, remodelando potencialmente la forma en que interactuamos con el mundo digital y lo percibimos. Accesibilidad y disponibilidad de Kling https://www.nowadais.com/wp-content/uploads/2024/06/Astronaut-running-on-the-moon-sample-Artificial-intelligence-video-by-Kling-video-generator.mp4 Kuaishou ha puesto Kling a disposición del público a través de su aplicación de edición de vídeo, Kuaiying, con número de teléfono chino, lo que permite a creadores y aficionados experimentar con

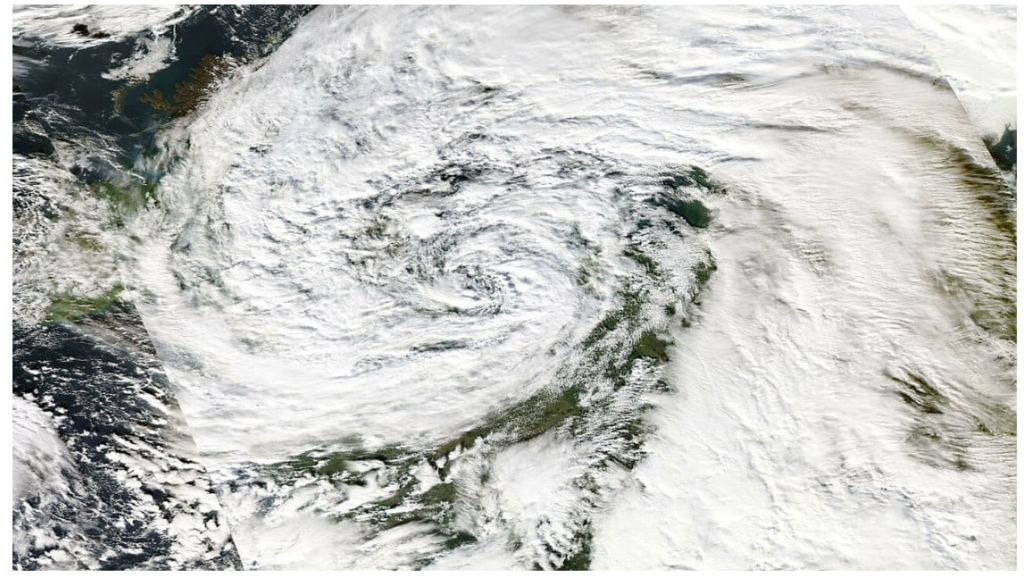

Previsión meteorológica Aurora AI de Microsoft: La IA te dirá qué tiempo hará

Last Updated on junio 6, 2024 11:59 am by Laszlo Szabo / NowadAIs | Published on junio 6, 2024 by Laszlo Szabo / NowadAIs Previsión meteorológica Aurora AI de Microsoft: La IA te dirá qué tiempo hará – Notas clave Previsión meteorológica Aurora AI de Microsoft: Nuevo modelo de IA para predicciones meteorológicas precisas y fiables. Alta resolución espacial: Captura los detalles atmosféricos con una precisión de 0,1°. Capacidades versátiles: Predice la temperatura, la velocidad del viento, la contaminación atmosférica, etc. Adaptabilidad: maneja diversas entradas de datos y elabora predicciones con distintas resoluciones. Predicción de la contaminación atmosférica: Supera a los modelos existentes utilizando datos de CAMS. Eficiencia computacional: Multiplica por 5.000 la velocidad de los sistemas tradicionales. Impacto global: Democratiza el acceso a previsiones precisas, especialmente en regiones con escasez de datos. Mitigación del cambio climático: Mejora la toma de decisiones en agricultura, transporte y preparación ante catástrofes. Introducción Ante unos fenómenos meteorológicos cada vez más impredecibles y extremos, la necesidad de contar con previsiones meteorológicas precisas y fiables nunca ha sido tan crucial. A medida que el cambio climático sigue remodelando los patrones meteorológicos mundiales, los modelos tradicionales de predicción meteorológica han tenido dificultades para seguir el ritmo, quedándose a menudo cortos a la hora de anticipar la rápida intensificación y los devastadores efectos de tormentas como la que azotó el noroeste de Europa en 2023. Sin embargo, un nuevo modelo de IA desarrollado por investigadores de Microsoft puede ser la clave para transformar el campo de la predicción meteorológica. Bautizado como“Aurora“, este modelo fundacional está llamado a cambiar nuestra capacidad para predecir y mitigar los efectos de fenómenos meteorológicos extremos, ofreciendo una precisión, eficacia y versatilidad sin precedentes. Aprovechar el poder de los datos atmosféricos La clave del éxito de Aurora radica en su conocimiento exhaustivo de la dinámica atmosférica, forjado a través de un amplio entrenamiento con más de un millón de horas de simulaciones meteorológicas y climáticas diversas. Este amplio corpus de datos ha permitido al modelo desarrollar una comprensión matizada de los intrincados patrones y estructuras que rigen el comportamiento de la atmósfera terrestre, dotándole de la capacidad de sobresalir en una amplia gama de tareas de predicción, incluso en regiones con datos escasos o durante fenómenos meteorológicos extremos. Resolución espacial sin precedentes Una de las características más destacadas de Aurora es su alta resolución espacial de 0,1° (aproximadamente 11 km en el ecuador), que le permite captar los intrincados detalles de los procesos atmosféricos con notable precisión. Este nivel de granularidad no sólo proporciona previsiones operativas más precisas que nunca, sino que además lo consigue por una fracción del coste computacional de los sistemas numéricos de predicción meteorológica tradicionales. Capacidades de predicción versátiles Más allá de su impresionante precisión y eficacia, la versatilidad de Aurora lo diferencia de los modelos meteorológicos convencionales. La arquitectura flexible del modelo, diseñado con un transformador Swin 3D y codificadores y decodificadores basados en Perceiver, le permite predecir una amplia gama de variables atmosféricas, desde la temperatura y la velocidad del viento hasta los niveles de contaminación atmosférica y las concentraciones de gases de efecto invernadero. Adaptabilidad y escalabilidad La adaptabilidad de Aurora se ve reforzada por su capacidad para manejar datos heterogéneos y generar predicciones con distintas resoluciones y niveles de fidelidad. Aprovechando el preentrenamiento en un vasto corpus de datos diversos y el ajuste fino en tareas específicas, el modelo puede captar eficazmente patrones y estructuras intrincados en la atmósfera, incluso con datos de entrenamiento limitados. Predicción excepcional de la contaminación atmosférica Análisis del dióxido de nitrógeno por el sistema de previsión meteorológica Aurora AI de Microsoft Fuente Una de las aplicaciones más destacadas de las capacidades de Aurora es su capacidad para predecir con precisión los niveles de contaminación atmosférica global, una tarea notoriamente compleja debido a la intrincada interacción de la química atmosférica, los patrones climáticos y las actividades humanas. Al procesar y aprender de los datos altamente heterogéneos del Servicio de Vigilancia Atmosférica de Copernicus (CAMS), Aurora ha demostrado su notable capacidad de adaptación, produciendo previsiones precisas de la contaminación atmosférica mundial a cinco días que superan a las simulaciones de química atmosférica más avanzadas en el 74% de todos los objetivos. Afrontar los retos de la dispersión de datos Las implicaciones del éxito de Aurora en la predicción de la contaminación atmosférica van mucho más allá de los beneficios inmediatos para el control de la calidad del aire y la salud pública. La capacidad del modelo para sobresalir incluso en regiones con escasez de datos ofrece la posibilidad de democratizar el acceso a una información meteorológica y climática precisa, sobre todo en los países en desarrollo y las regiones polares, donde los sistemas tradicionales de predicción han tenido a menudo dificultades. Nuevas oportunidades Este avance en la predicción medioambiental basada en IA allana el camino para el desarrollo de modelos completos del sistema terrestre que puedan abarcar todo el espectro de procesos atmosféricos, oceánicos y terrestres. A medida que el campo de la predicción meteorológica y climática basada en la IA siga evolucionando, Aurora puede servir de modelo para futuras investigaciones y desarrollos, inspirando la creación de modelos de base aún más potentes que puedan hacer frente a los polifacéticos retos que plantea el cambio climático. Supera a los modelos especializados de aprendizaje profundo Una de las principales conclusiones de la investigación sobre Aurora es la gran ventaja de rendimiento que tiene sobre los modelos especializados de aprendizaje profundo, como GraphCast, que anteriormente se consideraba el modelo de IA más hábil para la predicción meteorológica con una resolución de 0,25 grados y plazos de hasta cinco días. Preentrenamiento y puesta a punto diversos El rendimiento superior de Aurora puede atribuirse a su sólido preentrenamiento en una amplia gama de conjuntos de datos, como simulaciones climáticas, productos de reanálisis y previsiones operativas. Este variado preentrenamiento ha permitido al modelo desarrollar una representación más completa y generalizable de la dinámica atmosférica, lo que le ha permitido superar incluso al modelo numérico de predicción

Inteligencia de Apple: El futuro de la IA en iPhones, iPads y Macs

Last Updated on junio 11, 2024 2:35 pm by Laszlo Szabo / NowadAIs | Published on junio 11, 2024 by Laszlo Szabo / NowadAIs Inteligencia de Apple: El futuro de la IA en iPhones, iPads y Macs – Notas clave Apple presenta “Apple Intelligence”, un completo sistema de IA integrado en todos sus dispositivos y servicios Aprovecha grandes modelos lingüísticos, incluida una asociación con ChatGPT de OpenAI, para mejorar las capacidades Se centra en la privacidad y la seguridad, con procesamiento en el dispositivo y “Private Cloud Compute” para tareas complejas Introduce nuevas funciones basadas en IA, como las herramientas de escritura, Image Playground, Genmoji y una Siri mejorada Su objetivo es generalizar la IA generativa, lo que podría dar forma al futuro de la interacción con nuestros dispositivos El auge de la inteligencia de Apple En un movimiento que ha conmocionado a la industria tecnológica, Apple se ha unido finalmente a la carrera por integrar la inteligencia artificial (IA) generativa en su ecosistema. Bautizada como“Apple Intelligence“, la estrategia integral de IA de la compañía promete cambiar para siempre la forma en que interactuamos con nuestros iPhones, iPads y Macs. Durante años, Apple ha sido conocida por su cautela ante las tecnologías emergentes, prefiriendo refinar y perfeccionar sus ofertas en lugar de apresurarse a ser la primera. Sin embargo, los rápidos avances en IA generativa, encabezados por aplicaciones como ChatGPT de OpenAI, han obligado al gigante tecnológico a dar un paso adelante. Aprovechar las asociaciones y el procesamiento en el dispositivo estamos muy contentos de colaborar con apple para integrar chatgpt en sus dispositivos a finales de este año creo que les gustará mucho. – Sam Altman (@sama) 10 de junio de 2024 En el corazón de Apple Intelligence se encuentra una asociación estratégica con OpenAI, los creadores del modelo de lenguaje ChatGPT. Esta colaboración permite a Siri, el asistente virtual de Apple, aprovechar los amplios conocimientos y capacidades de ChatGPT, lo que le permite gestionar consultas y tareas más complejas. Consciente de la importancia de la privacidad y la seguridad, Apple ha diseñado su sistema de IA para dar prioridad al procesamiento en el dispositivo siempre que sea posible. Este enfoque, conocido como “Private Cloud Compute”, garantiza que los datos del usuario nunca salgan del dispositivo, incluso para las solicitudes más complejas que requieren procesamiento en el servidor. La empresa también se ha comprometido a permitir que expertos independientes verifiquen la naturaleza de preservación de la privacidad de sus modelos de IA basados en la nube. Transformar la experiencia del usuario El impacto de Apple Intelligence se dejará sentir en una amplia gama de productos y servicios de Apple. Una de las mejoras más importantes es la renovación de Siri, que ahora cuenta con una interfaz más natural y conversacional, así como con la capacidad de entender el contexto y llevar a cabo acciones en múltiples aplicaciones. La función Herramientas de escritura, integrada en todo el ecosistema de Apple, permite a los usuarios mejorar sus comunicaciones escritas. Desde la corrección y el ajuste del tono hasta el resumen y la reescritura, estas herramientas basadas en IA prometen agilizar el proceso de escritura y elevar la calidad de nuestra correspondencia digital. Imágenes con IA Generativa https://www.nowadais.com/wp-content/uploads/2024/06/Introduction-of-Image-Playground-of-Apple-Intelligence.mp4 La incursión de Apple en la IA generativa va más allá de las funciones centradas en la productividad. La compañía ha presentado “Image Playground”, una herramienta que permite a los usuarios crear imágenes y animaciones únicas generadas por IA directamente en sus aplicaciones. Esta función, combinada con la nueva capacidad “Genmoji”, que genera reacciones personalizadas tipo emoji, abre un mundo de expresión creativa. La integración de ChatGPT en el ecosistema de Apple también abre nuevas posibilidades a los usuarios. Ya sea generando poesía, aportando ideas o abordando consultas complejas, se puede acceder sin problemas al potente modelo lingüístico a través de Siri y las herramientas de escritura de la compañía. Prioridad a la privacidad y la seguridad A medida que Apple se aventura en el ámbito de la IA generativa, ha puesto un gran énfasis en salvaguardar la privacidad y la seguridad de los datos de los usuarios. El enfoque “Private Cloud Compute” de la compañía garantiza que la información sensible nunca salga del dispositivo del usuario, incluso cuando se procesan peticiones más complejas. Además, Apple se ha comprometido a permitir que expertos independientes auditen el código que se ejecuta en sus servidores, reforzando aún más su compromiso con la transparencia y la rendición de cuentas. Este enfoque en la preservación de la privacidad de la IA se alinea con la larga reputación de la compañía de priorizar la confianza del usuario y la protección de datos. Salvando las distancias entre plataformas Una de las características más esperadas de Apple Intelligence es la integración de Rich Communication Services (RCS) en la aplicación Mensajes. Esta medida, largamente esperada, cerrará por fin la brecha entre los usuarios de iPhone y Android, permitiendo compartir imágenes y vídeos de mayor calidad, así como mejorar la experiencia de mensajería entre plataformas. Con la adopción de RCS, Apple resuelve un problema que ha frustrado durante mucho tiempo a los usuarios, fomentando una mejor comunicación y colaboración entre plataformas. Este paso no sólo mejora la experiencia del usuario, sino que también señala un cambio hacia una mayor interoperabilidad en la industria tecnológica. Nuevas posibilidades para los desarrolladores La introducción de Apple Intelligence por parte de Apple va más allá de la experiencia del usuario, ya que también presenta interesantes oportunidades para los desarrolladores. La compañía ha presentado un conjunto de nuevas App Intents, API y marcos que facilitan a los creadores de aplicaciones de terceros la integración de capacidades avanzadas de IA en sus ofertas. Este movimiento abre la puerta a una nueva ola de aplicaciones innovadoras que aprovechan el poder de la IA generativa, desde herramientas de productividad personalizadas a experiencias creativas inmersivas. Los desarrolladores pueden ahora aprovechar los mismos recursos de IA que potencian las propias prestaciones de Apple, mejorando aún más las capacidades del ecosistema Apple. La

Mejore su audio con la tecnología de conversión de texto en efectos de sonido de ElevenLabs

Last Updated on junio 4, 2024 10:35 am by Laszlo Szabo / NowadAIs | Published on junio 4, 2024 by Laszlo Szabo / NowadAIs Mejore su audio con la tecnología de conversión de texto en efectos de sonido de ElevenLabs – Notas clave Efectos de Texto a Sonido de ElevenLabs: Herramienta innovadora para generar efectos de sonido a partir de descripciones de texto. Generación de sonido AI: Utiliza IA para crear efectos de sonido realistas y personalizables. Aplicaciones: Valioso para medios sociales, marketing digital y creación de contenido de audio. Fácil de usar: Accesible tanto para profesionales como para aficionados para diversos proyectos de audio. Creatividad mejorada: Permite a los usuarios producir paisajes sonoros únicos y de alta calidad sin esfuerzo. Introducción En el panorama en constante evolución de la creación de contenidos, la capacidad de integrar a la perfección elementos de audio de alta calidad es cada vez más crucial. Desde experiencias de vídeo envolventes hasta mensajes cautivadores en las redes sociales, la demanda de herramientas de diseño de sonido versátiles y accesibles nunca ha sido mayor. ElevenLabs es una empresa pionera en la clonación de voz que ha dado un paso de gigante con su última innovación: la herramienta Text-to-Sound Effects. Cambiar la creación de audio Text to Sound Effects ya está aquí. Nuestro nuevo modelo de AI Audio genera efectos de sonido, pistas instrumentales cortas, paisajes sonoros y una amplia variedad de voces de personajes, todo a partir de un texto. Ya está disponible para todos los usuarios. Todo el mundo, desde creadores de contenidos y desarrolladores de videojuegos hasta cine… pic.twitter.com/yHrh3C3qk5 – ElevenLabs (@elevenlabsio) 31 de mayo de 2024 ElevenLabs, conocida por sus avances en la clonación realista de voces, se ha propuesto ahora transformar la forma en que los creadores abordan la producción de audio. La nueva herramienta Text-to-Sound Effects de la empresa permite a los usuarios generar efectos de sonido personalizados, fragmentos musicales y paisajes sonoros envolventes con sólo pulsar unas teclas. Generación de sonido sin fisuras En el corazón de esta herramienta se encuentra la capacidad de convertir indicaciones de texto en una amplia gama de contenidos de audio. Tanto si busca el efecto perfecto de una tormenta eléctrica, el rugido de un león majestuoso o las intrincadas melodías de un solo de saxofón de jazz, la herramienta Efectos de texto a sonido le ayudará. Con una simple descripción de texto, los usuarios pueden dar vida a sus visiones sonoras sin esfuerzo. Diversas funciones de audio La versatilidad de la oferta de ElevenLabs va mucho más allá de los efectos de sonido básicos. La herramienta también puede generar piezas instrumentales cortas, desde loops de guitarra hasta pistas de música tecno, lo que permite a los creadores mejorar sus proyectos con elementos musicales personalizados. Esta funcionalidad ampliada permite a los usuarios crear paisajes sonoros realmente envolventes y cohesivos para sus proyectos creativos. Accesible e intuitivo Reconociendo las diversas necesidades de su base de usuarios, ElevenLabs ha diseñado la herramienta Text-to-Sound Effects teniendo en cuenta la accesibilidad y la facilidad de uso. La sencilla interfaz guía a los usuarios a través del proceso de introducción de las instrucciones deseadas, generación de muestras de audio y descarga de los productos finales. Este enfoque simplificado hace que la creación de audio sea accesible tanto para profesionales como para aficionados, permitiéndoles incorporar sin problemas sonido de alta calidad a sus proyectos. Creadores de todos los sectores https://www.nowadais.com/wp-content/uploads/2024/06/Sample-of-Elevenlabs-text-to-sound-effects-Artificial-Intelligence-tool.mp4 Las aplicaciones potenciales de la herramienta Text to Sound Effects de ElevenLabs son enormes y abarcan una amplia gama de sectores y disciplinas creativas. Producción de cine, televisión y vídeo Para cineastas, productores de televisión y creadores de contenidos de vídeo, la herramienta ofrece una solución revolucionaria. Con la capacidad de generar efectos de sonido personalizados y acompañamiento musical, estos profesionales pueden elevar el valor de producción de sus proyectos, creando experiencias inmersivas y atractivas para sus audiencias. Desarrollo de videojuegos En el ámbito del desarrollo de videojuegos, la herramienta Text-to-Sound Effects es un activo valioso. Los desarrolladores de videojuegos pueden utilizar la herramienta para crear efectos de sonido únicos, paisajes sonoros ambientales y pistas musicales que se integran a la perfección en sus mundos virtuales, mejorando la experiencia general del jugador. Redes sociales y marketing El impacto de la herramienta Text-to-Sound Effects se extiende al dinámico mundo de las redes sociales y el marketing digital. Los creadores de contenidos, las personas influyentes y los profesionales del marketing pueden aprovechar la herramienta para añadir elementos de audio cautivadores a sus publicaciones en las redes sociales, vídeos promocionales y otras campañas digitales, captando eficazmente la atención de su público. Podcasting y producción de audio Para podcasters y productores de audio, la herramienta Text-to-Sound Effects ofrece una potente solución para mejorar sus contenidos. Desde añadir efectos de sonido impactantes hasta componer interludios musicales personalizados, esta herramienta permite a los creadores de audio elaborar producciones más atractivas y con un sonido más profesional. Consideraciones éticas y garantías Como ocurre con cualquier tecnología transformadora, ElevenLabs ha puesto un gran énfasis en el desarrollo y despliegue responsables de su herramienta Text-to-Sound Effects. La empresa ha implementado sólidas salvaguardas y directrices éticas para garantizar el uso responsable de esta innovadora tecnología. Moderación de contenidos y políticas ElevenLabs ha establecido una exhaustiva Política de Contenidos y Usos Prohibidos, que prohíbe estrictamente la generación de contenidos de audio relacionados con autolesiones, amenazas a la seguridad infantil y actividades fraudulentas. La empresa se compromete a supervisar de forma proactiva el uso de la herramienta y a tomar medidas rápidas ante cualquier infracción de sus directrices éticas. Asociaciones y fuentes de datos éticas En el desarrollo de la herramienta Text-to-Sound Effects, ElevenLabs ha forjado una asociación estratégica con Shutterstock, proveedor líder de contenidos de audio con fuentes éticas. Al aprovechar la biblioteca de audio con licencia de Shutterstock, ElevenLabs garantiza que las muestras de sonido generadas por su herramienta se crean con el máximo respeto por los derechos de propiedad intelectual y las directrices de contenido. Potenciar a los creadores,

IA para sordos: Presentamos SignLLM

Last Updated on mayo 28, 2024 3:11 pm by Laszlo Szabo / NowadAIs | Published on mayo 28, 2024 by Laszlo Szabo / NowadAIs IA para sordos: Presentación de SignLLM – Notas clave SignLLM: Un modelo pionero de producción de lengua de signos multilingüe. Conjunto de datos Prompt2Sign: Un conjunto de datos diverso para el entrenamiento de SignLLM. Capacidad multilingüe: Admite ocho lenguas de signos distintas. Aprendizaje por refuerzo: Mejora la eficacia del entrenamiento y la calidad del modelo. Integración de texto a brillo: Garantiza la precisión lingüística del lenguaje de signos. Mejoras cualitativas: Consigue gestos de lenguaje de signos realistas y visualmente atractivos. Estudios de ablación: Identifica los factores clave del éxito del modelo. Introducción La lengua de signos es un medio de comunicación vital para millones de personas en todo el mundo, pero el desarrollo de tecnologías para apoyar y mejorar la producción de la lengua de signos ha ido a la zaga de los avances en el procesamiento de la lengua hablada. Así ha sido hasta la aparición de SignLLM, el primer modelo completo de producción de lengua de signos multilingüe. Ahora nos adentramos en el innovador marco SignLLM, explorando sus fundamentos, características clave y el impacto transformador que promete tener en el campo de la tecnología de la lengua de signos. Desde la creación del conjunto de datos Prompt2Sign hasta el desarrollo de nuevas técnicas de generación de lengua de signos, esta exploración arrojará luz sobre cómo SignLLM está redefiniendo los límites de lo que es posible en la producción de lengua de signos. El conjunto de datos Prompt2Sign: Sentar las bases En el corazón del proyecto SignLLM se encuentra el conjunto de datos Prompt2Sign, un recurso pionero que reúne datos sobre el lenguaje de signos procedentes de diversas fuentes, como la lengua de signos americana (ASL) y otras siete lenguas de signos. Al transformar meticulosamente una vasta colección de vídeos en un formato simplificado y fácil de modelizar, el conjunto de datos Prompt2Sign ha sentado las bases para el desarrollo de tecnologías avanzadas de producción de lengua de signos. Uno de los principales retos a la hora de crear este conjunto de datos fue la necesidad de optimizarlos para el entrenamiento con modelos de traducción como seq2seq y text2text. Los investigadores se enfrentaron a este reto y desarrollaron técnicas innovadoras para garantizar que los datos no sólo fueran exhaustivos, sino también perfectamente adecuados para el entrenamiento de modelos punteros de generación de lengua de signos. Presentamos SignLLM: LLM para el bien Partiendo de la base del conjunto de datos Prompt2Sign, el equipo de SignLLM ha desarrollado un modelo de producción lingüística de newsign que establece un nuevo estándar en este campo. Este modelo multilingüe, el primero de su clase, cuenta con dos novedosos modos SLP (Sign Language Production) que permiten la generación de gestos de lengua de signos a partir de textos o instrucciones. La clave del éxito de SignLLM es su capacidad para aprovechar una nueva función de pérdida y un módulo basado en el aprendizaje por refuerzo. Estos componentes trabajan en tándem para acelerar el proceso de entrenamiento, lo que permite al modelo muestrear de forma autónoma datos de alta calidad y mejorar sus capacidades de generación de lenguaje de signos. Dominio multilingüe: capacidades de SignLLM Uno de los aspectos más notables de SignLLM es su capacidad para gestionar sin problemas la producción de lengua de signos en varios idiomas. Aprovechando la amplitud del conjunto de datos Prompt2Sign, el modelo ha demostrado un rendimiento puntero en tareas de SLP en ocho lenguas de signos distintas, lo que demuestra su versatilidad y adaptabilidad. A través de extensas pruebas comparativas, los investigadores han demostrado la destreza de SignLLM en áreas como la producción en lengua de signos americana (ASLP), la producción en lengua de signos alemana (GSLP) y otras. Estos estudios empíricos no sólo han validado la eficacia del modelo, sino que también han proporcionado información valiosa sobre los matices y complejidades de la generación de la lengua de signos. Aprendizaje por refuerzo: Acelerar el proceso de formación Una innovación clave en el corazón de SignLLM es la incorporación de técnicas de aprendizaje por refuerzo. Gracias a este enfoque, los investigadores han podido mejorar significativamente la capacidad del modelo para muestrear de forma autónoma datos de alta calidad, acelerando así el proceso de entrenamiento y mejorando la calidad general de los gestos de lengua de signos generados. A través de un proceso de actualización iterativo en el que participan el usuario, el agente, el entorno y un Canal de Aprendizaje Prioritario (PLC), el módulo de aprendizaje por refuerzo de SignLLM ha demostrado su capacidad para optimizar el rendimiento del modelo, lo que ha dado lugar a resultados impresionantes en toda una serie de tareas de producción de lengua de signos. Mejora de la producción de lengua de signos mediante la integración de texto a brillo Además de sus capacidades de aprendizaje por refuerzo, SignLLM también se ha beneficiado de la integración de un marco Texto a Brillo. Esto permite al modelo producir glosas de lengua de signos con los atributos lingüísticos necesarios, al tiempo que capta características profundas mediante el uso de variables dentro de la arquitectura de la red neuronal. Al combinar a la perfección estos elementos textuales y gestuales, SignLLM ha sido capaz de generar un lenguaje de signos que no sólo es visualmente atractivo, sino también lingüísticamente preciso y expresivo. Esta integración de las técnicas de conversión de texto en gestos ha sido un factor crucial en la capacidad del modelo para lograr un rendimiento puntero en la producción de lengua de signos. Mejoras cualitativas: Aumento del realismo de los gestos del lenguaje de signos Más allá de su impresionante rendimiento cuantitativo, SignLLM también ha realizado importantes avances en la mejora de los aspectos cualitativos de la generación del lenguaje de signos. Gracias a la incorporación de modelos de transferencia de estilo y a enfoques generativos perfeccionados, el equipo ha podido presentar el resultado del modelo de una manera más realista

Renault quería fabricar con Volkswagen el coche eléctrico barato y europeo. Ahora sabe que solo es posible con un socio chino

Los 20.000 euros. El coche eléctrico parece haber situado el suelo del precio del automóvil en un nuevo escalón. La mayor parte de las marcas utilizan los 20.000 euros para hablar de su coche eléctrico más barato. Renault anunció que lo conseguiría con su próximo Twingo, situando por encima al Renault 5 eléctrico que se venderá con una tarifa que roza los 25.000 euros. Lo mismo sucede con Volkswagen. En marzo de 2023, Volkswagen presentó el que, confían, será su coche eléctrico de masas. El nombre de ID.2 all (ID, familia de eléctricos de Volkswagen, para todos, en su traducción al español) no era casual. En aquel momento hablaban de un coche de 25.000 euros, lo que daba una idea de lo que entendía Volkswagen sobre el coche eléctrico popular. Más tarde abrieron la puerta a un coche eléctrico de 20.000 euros. Un producto que genera dudas. De momento, se nos ha vendido el coche eléctrico de 20.000 euros como el verdadero punto de inflexión del coche eléctrico. El problema es que, de momento, parece que serán vehículos destinados a un uso casi exclusivo para el entorno urbano. Por poner un ejemplo, el Renault 5 eléctrico de 25.000 euros ha llegado con batería de 40 kWh y sin carga rápida. Convencernos de comprarnos un coche eléctrico por 20.000 euros y autonomías de 200 kilómetros es mucho más complicado en países como España, donde la mayor parte de las ventas se las llevan vehículos asequibles que destacan por su polivalencia. Con solvencia y sin grandes captar grandes focos, el coche más vendido de España es el Dacia Sandero. Y entre los 10 más vendidos también se cuelan coches como el Seat Ibiza, el Seat Arona, el MG ZS, el Renault Clio o el Peugeot 2008. Todos ellos son coches que cuestan menos de 25.000 euros y, salvo el Peugeot 2008 y el Seat Arona, también tienen versiones por menos de 20.000 euros. Son coches sencillos pero que con más o menos incomodidades permiten al usuario utilizar un coche en el día a día y, al mismo tiempo, salir de viaje y realizar los kilómetros que deseen sin miedo a quedarse tirados por falta de autonomía o planear concienzudamente su viaje.

Microsoft Edge traducirá y doblará vídeos de YouTube mientras los miras

Microsoft Edge pronto ofrecerá traducción de videos en tiempo real en sitios como YouTube, LinkedIn, Coursera y más. Como parte del evento Build de este año, Microsoft anunció que la nueva función impulsada por IA podrá traducir contenido hablado mediante doblaje y subtítulos en vivo mientras lo miras. Hasta ahora, la función admite la traducción del español al inglés, así como la traducción del inglés al alemán, hindi, italiano, ruso y español. Además de ofrecer una forma sencilla de traducir vídeos a la lengua nativa de un usuario, la nueva función de inteligencia artificial de Edge también debería hacer que los vídeos sean más accesibles para las personas sordas o con problemas de audición. Edge también admitirá la traducción en tiempo real de vídeos en sitios de noticias como Reuters, CNBC y Bloomberg. Microsoft planea agregar más idiomas y sitios web compatibles en el futuro. Esto se suma a la variedad de funciones de inteligencia artificial que Microsoft ha agregado a Edge a través de una integración con Copilot. Edge ya ofrece la posibilidad de resumir vídeos de YouTube, pero no puede generar resúmenes de texto de cada vídeo, ya que depende de la transcripción del vídeo para crear el resumen.

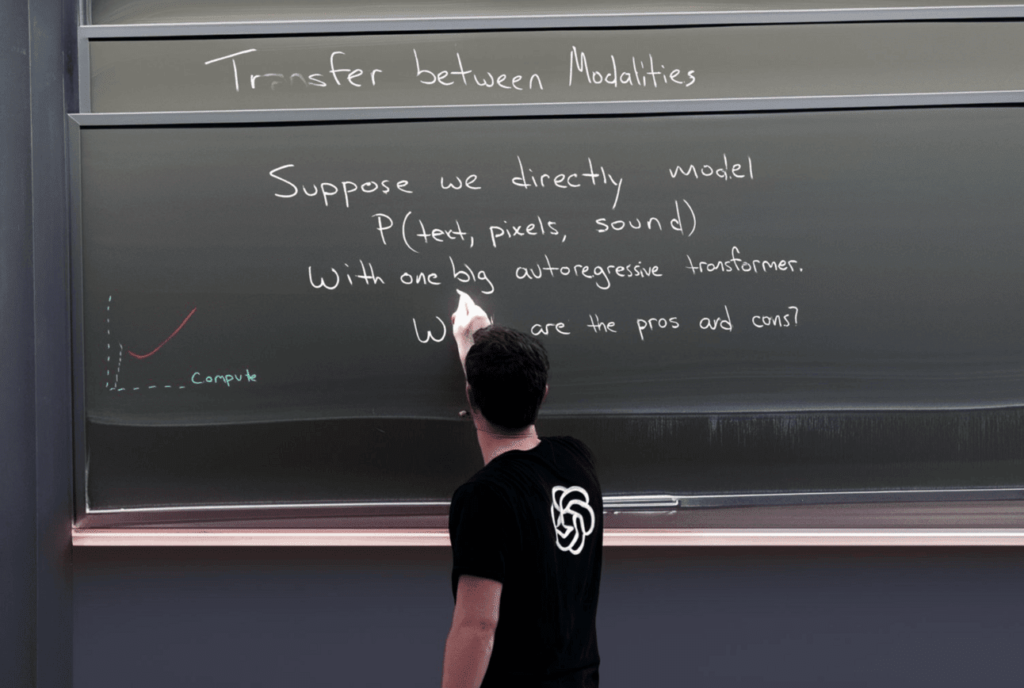

OpenAI comparte la primera imagen generada por GPT-4o.

El presidente de OpenAI, Greg Brockman, compartió recientemente la primera imagen generada por el nuevo modelo GPT-4o, que debutó el lunes. Esta imagen fotorrealista presenta a una persona con una camiseta con el logo de OpenAI, borrando una pizarra con texto de tiza que discute las capacidades del modelo. GPT-4o mejora los modelos anteriores al ser más rápido, más barato y mejor en retener información de entradas multimedia. A diferencia de sus predecesores, que convertían los medios a texto, GPT-4o fue entrenado con tokens multimedia, lo que le permite analizar e interpretar directamente la visión y el audio. Este nuevo enfoque da como resultado una mayor calidad y precisión en la generación de imágenes, como se evidencia en la comparación con DALL-E 3. Aunque el público aún no puede acceder a las funciones de generación de imágenes de GPT-4o, OpenAI está trabajando para hacerlas disponibles pronto. Leer más.

Elon Musk ha anunciado que Tesla revelará su Robotaxi el 8 de agosto de 2024.

Elon Musk ha anunciado que Tesla revelará su taxi robot el 8 de agosto de 2024, marcando un paso adelante en uno de los proyectos más ambiciosos de Tesla. Este anuncio llega en un momento en el que Tesla enfrenta desafíos, como una disminución en las ventas y preocupaciones de seguridad sobre los vehículos autónomos. Sin embargo, la tecnología de conducción autónoma es un componente central de la marca Tesla, y el concepto de Robotaxi depende completamente de ella. La idea es que los usuarios puedan solicitar un viaje a través de una aplicación y ser recogidos por un automóvil sin conductor para llevarlos a su destino. Además, se espera que los propietarios de Tesla puedan beneficiarse del programa, permitiendo que sus vehículos actúen como taxis autónomos cuando no los estén usando (CleanTechnica) (SlashGear) (TechXlore). Este anuncio también sigue a informes de que el proyecto del Modelo 2 de Tesla, un coche familiar ultra barato, ha sido cancelado. Sin embargo, parece que la plataforma que se habría utilizado para el Modelo 2 ahora podría servir de base para el Robotaxi autónomo de Tesla. A pesar de los desafíos y la competencia, especialmente de fabricantes de vehículos eléctricos chinos, este giro hacia los taxis autónomos podría ser una oportunidad para Tesla de capitalizar en su tecnología de conducción autónoma y abrir nuevos caminos en el sector de transporte (SlashGear).